Hauptlinks

Suchen

News des 20. Oktober 2010

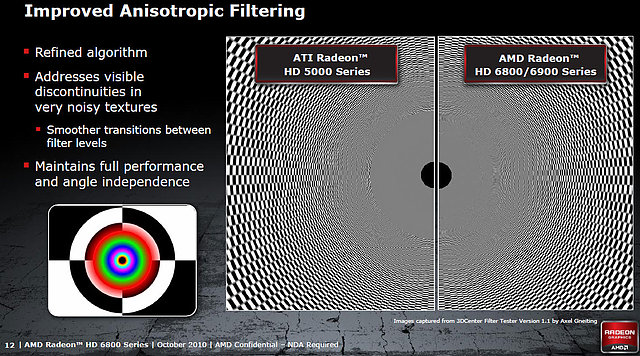

Zu unserem aktuellen Artikel über eine neu entdeckte Filterschwäche auf der Radeon HD 5000 Grafikkarten-Serie gibt es gleich ein wichtiges Update in dieser Form, als daß AMD anscheinend mit der Radeon HD 6000 Serie sich genau diesem Problem der zu abrupten Übergänge zwischen den einzelnen AF-Graden angenommen hat. Darauf deutet jedenfalls eine AMD Präsentations-Folien hin, welche – erstellt im übrigen mit unserem 3DCenter Filter Tester, welcher von AMD auch erwähnt wird – bei der Radeon HD 5000 Serie ziemlich exakt das in unserem Artikel beschriebene Problem darstellt, bei der Radeon HD 6000 Serie dann dagegen sanfte Übergänge zwischen den einzelnen AF-Graden anzeigt. Natürlich sind derzeit die von AMD für den 3DCenter Filter Tester benutzten Einstellungen nicht bekannt, so daß es nicht gänzlich sicher ist, ob hier wirklich dieselbe Problematik aufgegriffen wird (Anmerkung zu folgendem Screenshot: den Unterschied sieht man nur richtig gut im verlinkten Großbild).

Allerdings geht derzeit alles in diese Richtung hin, daß AMD mit der Radeon HD 6000 Serie tatsächlich das "AF-Banding-Problem" der Radeon HD 5000 Serie fixt. Dies ist gut für die Radeon HD 6000 Serie, weil diese dann ohne diesen Ballast der Radeon HD 5000 Serie antritt – trotzdem bleiben ein paar Fragen offen: Erstens einmal kann man dies (im Gegensatz zur AMD-Präsentation) kaum als "Verbesserung" gegenüber der Radeon HD 5000 Serie bezeichnen, das ist eher ein Bugfixing. Wenn AMD ein mathematisch korrektes AF anbieten würde (macht nVidia allerdings auch nicht), könnte ein solcher Fehler schließlich nie auftreten. Und zweitens bleibt jenes Bugfixing bei der Radeon HD 5000 Serie weiterhin offen – auch dort würden wir gern denselben Fortschritt sehen.

Schließlich ist die Radeon HD 5000 Serie sehr weit verbreitet und da die Radeon HD 6000 Serie jetzt nicht deutlich mehr Performance zu bringen scheint, werden viele Nutzer von Radeon HD 5000 Karten diese wohl noch eine ganze Weile weiterverwenden (einmal ganz abgesehen davon, daß sowieso nur ein Bruchteil der Nutzer seine Grafikkarte einmal im Jahr wechselt). Wenn AMD es hingegen nicht schafft, dieses Problem auf der Radeon HD 5000 Serie zu fixen, dann wäre dies ein Nachteil für diese Grafikkarten-Serie – meinetwegen ein erst sehr spät entdeckter, nichtsdestotrotz jedoch existenter und in der Spielepraxis wirkender Nachteil. Und mit Sicherheit kann man sagen, daß AMD dem Nutzer wenigstens eine Erklärung zu diesem Problem der Radeon HD 5000 Serie schuldig ist, selbst wenn das Problem durch Hardware-Limitierungen eventuell nicht fixbar sein sollte.

Die PC Games Hardware sowie der TechSpot haben sich mit der Grafikkarten-Performance unter Medal of Honor beschäftigt. Das Spiel auf Basis der Unreal Engine 3 unterstützt offiziell nur DirectX9 und keinerlei Anti-Aliasing, womit die erzielten Frameraten durchgehend hoch und damit die Anforderungen an die Leistungsfähigkeit der eigenen Grafikkarte in diesem Spiel eher mittelmäßig sind. Für die nachfolgende Aufstellung der für Medal of Honor benötigten Grafikpower haben wir uns jeweils an die Werte des TechSpots gehalten, da diese tendentiell niedriger sind und da der TechSpot zudem auch mehr Grafikkarten mitgetestet hat. Allerdings sind wir im Gegensatz zum TechSpot nicht der Ansicht, daß man wirklich 60 fps in diesem Spiel anstreben muß – im Singleplayer-Modus sollte man mit deutlich weniger auskommen, 30 fps für eine weitgehende Spielbarkeit und 45 fps für eine sorgenfreie Performance sind angesichts der (auch auf niedrigen Frameraten gut laufenden) Unreal Engine 3 vollkommen ausreichend.

| Medal of Honor (SP) | weitgehende Spielbarkeit | sorgenfreie Performance |

|---|---|---|

| 1680x1050 MediumQ noAA |

AMD RV7xx: ab Radeon HD 4670 DDR3 AMD RV8xx: ab Radeon HD 5550 GDDR5 nVidia G9x: ab GeForce 9600 GSO 512MB DDR3 nVidia GT2xx: ab GeForce GT 240 DDR3 nVidia GF1xx: ab GeForce GT 430 |

AMD RV7xx: ab Radeon HD 4770 AMD RV8xx: ab Radeon HD 5670 nVidia G9x: ab GeForce 9800 GT nVidia GT2xx: ab GeForce GTX 260 nVidia GF1xx: ab GeForce GTS 450 |

| 1680x1050 HighQ noAA |

AMD RV7xx: ab Radeon HD 4770 AMD RV8xx: ab Radeon HD 5570 GDDR5 nVidia G9x: ab GeForce 9600 GT nVidia GT2xx: ab GeForce GT 240 DDR3 nVidia GF1xx: ab GeForce GTS 450 |

AMD RV7xx: ab Radeon HD 4850 AMD RV8xx: ab Radeon HD 5750 nVidia G9x: ab GeForce 9800 GT nVidia GT2xx: ab GeForce GTX 260 nVidia GF1xx: ab GeForce GTS 450 |

| 1920x1200 HighQ noAA |

AMD RV7xx: ab Radeon HD 4770 AMD RV8xx: ab Radeon HD 5670 nVidia G9x: ab GeForce 9600 GT nVidia GT2xx: ab GeForce GT 240 GDDR5 nVidia GF1xx: ab GeForce GTS 450 |

AMD RV7xx: ab Radeon HD 4870 AMD RV8xx: ab Radeon HD 5750 nVidia G9x: ab GeForce GTS 250 nVidia GT2xx: ab GeForce GTX 260 nVidia GF1xx: ab GeForce GTS 450 |

| 2560x1600 HighQ noAA |

AMD RV7xx: ab Radeon HD 4870 AMD RV8xx: ab Radeon HD 5750 nVidia G9x: ab GeForce GTS 250 nVidia GT2xx: ab GeForce GTX 260 nVidia GF1xx: ab GeForce GTS 450 |

AMD RV8xx: ab Radeon HD 5830 nVidia GT2xx: ab GeForce GTX 275 nVidia GF1xx: ab GeForce GTX 460 768MB |

| Bemessungsgrundlage in diesem Spiel und Benchmark: weitgehende Spielbarkeit ab 30 fps, sorgenfreie Performance ab 45 fps | ||

Zwar ist für Medal of Honor eine gutklassige Mainstream-Grafikkarte vonnöten – aber mit der läßt sich das Spiel dann zumeist selbst bis auf 1920x1200 gut betreiben, selbst für 2560x1600 wird untypischerweise keine Über-Grafikkarte benötigt. Sehr stark auffallend ist allerdings die nVidia-Tendenz des HighQuality-Modus des Spiels (unter der MediumQuality ist diese Tendenz kaum noch zu sehen), wo nVidia regelmäßig die deutlich kleineren Karten benötigt, um auf dieselbe Performance wie die AMD-Beschleuniger zu kommen. Angesichts der allgemein hohen Frameraten hat dies aber keine praktischen Auswirkungen auf die HighEnd-Karten – ob man das Spiel unter 1920x1200 mit einer GeForce GTX 480 auf 106 fps oder einer Radeon HD 5870 auf 82 fps betreibt, dürfte gleich sein. Die hohen Performancereserven dürften allerdings den Einsatz von Supersampling Anti-Aliasing ermöglichen – bei AMD über das Control Panel erreichbar, bei nVidia übers Downsampling.

Der TechSpot hat weiterführend zudem noch ein paar CPU-Messungen unter Medal of Honor angestellt, welche allerdings eine nur sehr geringe CPU-Belastung durch das Spiel ergaben: Schon ein Athlon II X2 260 mit 55 fps oder ein Pentium G6950 mit 60 fps sind ausreichend und bremsen die Grafikkarte somit nicht wirklich aus (das Spiel hat regulär einen Frameraten-Lock von 62 fps). Daß das Spiel von QuadCore-Prozessoren ganz gut profitiert, interessiert somit nur am Rande, weil selbst ein altes Modell wie der Core 2 Quad Q6600 gleich 84 fps erreicht. Bewaffnet mit einer ganz neuen CPU in Form eines Core i7-920 Prozessors zeigt sich gar, daß das Spiel für diese Prozessoren noch klar unterdimensioniert ist: Zwischen 2.0 und 4.0 Takt dieser CPU liegen gerade einmal 9 Prozent Performancegewinn. CPU-Leistung ist für Medal of Honor also wirklich nicht erforderlich, wahrscheinlich dürften auch viele ältere Prozessoren noch gut mit dem Spiel zurechtkommen. Anmerkungen: Alle diese Aussagen gelten nur für den Singleplayer-Modus von Medal of Honor. Das Spiel benutzt im Multiplayer-Modus eine gänzlich andere Engine mit anderer Performance-Charakteristik.

Der Heise Newsticker berichtet ein paar interessante Details zur Leistungsfähigkeit der Llano-Grafikeinheit. Zwar ist schon bekannt, daß AMD hierbei eine DirectX11-Lösung auf Evergreen-Basis mit 400 bis 480 Shader-Einheiten verbauen wird (ähnlich dem RV840/Redwood-Chip der Radeon HD 5500/5600 Serien), allerdings ist bis dato die Taktrate dieser Grafikeinheit nicht bekannt – und da ergeben sich besonders im CPU-Bereich natürlich große Spielräume zwischen besonders hohen Taktraten durch die 32nm-Fertigung von Llano und besonders niedrigen Taktraten zugunsten einer niedrigeren Leistungsaufnahme. Laut der Rechnung des Heises Newstickers soll die integrierte Llano-Grafikeinheit jedenfalls in etwa soviel Rechnepower wie eine Radeon HD 5550 (320 Shader-Einheiten auf 550 MHz Takt) des Desktop-Segments haben. Zwar ist weiterhin nicht bekannt, wie sich dies in Richtung Anzahl der Shader-Einheiten und Taktrate der Grafikeinheit aufteilt, aber dies ist immerhin schon einmal eine Hausmarke.

Allerdings wird der Llano-Grafikeinheit weniger Speicherbandbreite zur Verfügung stehen – eine Radeon HD 5550 DDR3 kommt auf 25,6 GB/sec, der Llano-Prozessor unter Verwendung von DDR3/1866 insgesamt auf 29,9 GB/sec, was allerdings zwischen CPU und GPU aufgeteilt werden muß und damit in der Praxis weniger Speicherbandbreite als bei regulären Grafikkarten bedeutet. Allerdings kann AMD dies unter Umständen mit Turbo-Funktionen wieder etwas retten: Wenn beispielsweise in einem Spiel nur zwei CPU-Rechenkerne erforderlich sind, könnten die restlichen beiden CPU-Kerne abgeschaltet und dafür der Takt der integrierten Grafik nach oben gesetzt werden, ohne die TDP-Grenze zu sprengen. Die letztliche Grafikperformance von Llano wird gemäß dieser Überlegungen sicherlich irgendwo im Rahmen einer Radeon HD 5550 DDR3 liegen – tendentiell eher etwas weniger und sicherlich kaum stärker als diese.