- Startseite

- News

- 7-Tage-News

- Linklisten der News

- Newsindex-Übersicht

- AMD RDNA3

- AMD RDNA4

- AMD RDNA5

- Intel Xe

- Intel Battlemage

- Intel Celestial

- nVidia Ada Lovelace

- nVidia Blackwell

- nVidia Rubin

- AMD Zen 4

- AMD Zen 5

- AMD Zen 6

- Intel Raptor Lake

- Intel Meteor Lake

- Intel Arrow Lake

- Intel Lunar Lake

- Intel Panther Lake

- Intel Nova Lake

- Artikel

- Downloads

Hauptlinks

Suchen

RayTracing

13

AMD wird definitiv auf RayTracing reagieren

AMD wird definitiv auf RayTracing reagieren

Das japanische 4Gamer (via TechPowerUp) konnte in einem Artikel zu Vega 20 aus AMDs David Wang auch eine Aussage zu RayTracing auf AMD-Hardware herauslocken: Danach wird es (logischerweise) eine Antwort bzw. vergleichbare Technologie auch von AMD geben – wobei AMD ja letztlich nichts anderes als DXR in DirectX 12 unterstützen muß, dafür muß das Rad nicht neu erfunden werden. Die Frage ist eher, wann entsprechende AMD-Grafikchips mit RayTracing-Funktionalität (in Hardware) erscheinen – Software-Lösungen sind zwar denkbar (laufend über die Shader-Einheiten), reichen aber maximal zu Demonstrationszwecken und kaum für die Spielepraxis. Hierzu gab AMD die indirekte Angabe ab, das man eine größere Verbreitung von RayTracing-Spielen erst zu einem Zeitpunkt erwartet, wo RayTracing in Hardware von Grafikkarten aller Preisbereiche beherrscht wird – sprich von LowCost-Lösungen bis zu Enthusiasten-Boliden.

AMD wird definitiv auf DirectX RayTracing reagieren.

Es wird keine große Verbreitung von RayTracing-Spielen stattfinden, bevor nicht RayTracing-GPUs für alle Segmente vorhanden sind – vom LowEnd zum HighEnd.

Quelle: AMDs David Wang gegenüber 4Gamers vom 6. November 2018 (freie Übersetzung anhand der automatisierten Übersetzungen ins Englische und ins Deutsche)

20

nVidia stellt GeForce RTX 2070, 2080 & 2080 Ti für eine Auslieferung ab dem 20. September vor

nVidia stellt GeForce RTX 2070, 2080 & 2080 Ti für eine Auslieferung ab dem 20. September vor

Mit einem Live-Event auf der beginnenden Gamescom (Replay) hat nVidia seine lange erwarteten ersten Turing-basierten Gaming-Grafikkarten in Form von GeForce RTX 2070, GeForce RTX 2080 und GeForce RTX 2080 Ti offiziell vorgestellt. Die beiden letztgenannten Grafikkarten gehen dabei (in exakt einem Monat) am 20. September 2018 in den Handel, wobei die Herstellerdesigns am selben Tag verfügbar sein werden – die kleinere GeForce RTX 2070 folgt dann zu einem noch nicht genauer genannten Termin im Oktober 2018 nach. Dabei basieren GeForce RTX 2070 & 2080 zusammen auf dem kleineren Turing-Chip TU104, zu welchem es nach wie vor nur inoffizielle Angaben gibt, die GeForce RTX 2080 Ti dagegen auf dem größeren Turing-Chip TU102, welchen nVidia bei der Vorstellung der Quadro-RTX-Karten bereits eingehend beleuchtet hatte. Die Hardware-Daten der beiden größeren RTX-Karten entsprechen dabei den zuletzt gerüchteweise verbreiteten Daten: 4352 Shader-Einheiten an einem 352 Bit GDDR6-Interface bei der GeForce RTX 2080 Ti sowie 2944 Shader-Einheiten an einem 256 Bit GDDR6-Interface bei der GeForce RTX 2080, die kleinere GeForce RTX 2070 wird dann 2304 Shader-Einheiten an einem 256 Bit GDDR6-Interface erhalten.

| GeForce RTX 2070 | GeForce RTX 2080 | GeForce RTX 2080 Ti | |

|---|---|---|---|

| Chipbasis | nVidia TU104, in 12nm bei TSMC (?) | nVidia TU104, in 12nm bei TSMC | nVidia TU102, 18,6 Mrd. Transistoren auf 754mm² Chipfläche in 12nm bei TSMC |

| Technik | 2304 Shader-Einheiten @ 256 Bit GDDR6-Interface | 2944 Shader-Einheiten @ 256 Bit GDDR6-Interface | 4352 Shader-Einheiten @ 352 Bit GDDR6-Interface |

| Takt (Referenz) | 1410/1620/3500 MHz | 1515/1710/3500 MHz | 1350/1545/3500 MHz |

| Takt (Founders Edition) | 1410/1710/3500 MHz | 1515/1800/3500 MHz | 1350/1635/3500 MHz |

| Speicherausbau | 8 GB GDDR6 | 8 GB GDDR6 | 11 GB GDDR6 |

| Stromstecker | 1x 8pol. | 1x 6pol. + 1x 8pol. | 2x 8pol. |

| GCP | 175W (Ref.) / 185W (FE) | 215W (Ref.) / 225W (FE) | 250W (Ref.) / 260W (FE) |

| Ausgänge | DisplayPort 1.4, HDMI 2.0b, USB Type-C | DisplayPort 1.4, HDMI 2.0b, USB Type-C | DisplayPort 1.4, HDMI 2.0b, USB Type-C |

| Listenpreis (Referenz) | 499$ | 699$ | 999$ |

| Preis (Founders Edition) | 599$ bzw. 639€ | 799$ bzw. 849€ | 1199$ bzw. 1259€ |

| Release | Oktober 2018 | 20. September 2018 | 20. September 2018 |

| Die Angaben dieser Tabelle basieren ausschließlich auf offiziellen Hersteller-Aussagen (Ausnahme: Chipbasis der GeForce RTX 2070). | |||

14

nVidia teasert die Turing-basierte "GeForce RTX 2080" für eine Vorstellung zur Gamescom an

nVidia teasert die Turing-basierte "GeForce RTX 2080" für eine Vorstellung zur Gamescom an

Mittels eines Videos hinterläßt nVidia reihenweise Anspielungen auf die kommenden Turing-basierten Gaming-Lösungen. Videocardz haben alle zu sehenden Teaser zusammengetragen, wonach sich klar der Verkaufsname der nächsten Gaming-Grafikkarte als "GeForce RTX 2080" ergibt – und zudem ein Datum wie eine Location, welches auf die Gamescom in Köln am 20. August 2018 hinausläuft. Zu diesem Zeitpunkt dürfte nVidia die Turing-basierten Gaming-Lösungen also vorstellen oder wenigstens offiziell ankündigen, ab 18 Uhr an diesem Tag wird nVidia den Livestream zu einer "GeForce Gaming Celebration" senden. Ob es zu diesem Zeitpunkt bereits Launchreviews und nachfolgend eine Marktverfügbarkeit gibt, bleibt noch abzuwarten, ist aber nicht unbedingt wahrscheinlich – üblicherweise teilt man dies heutzutage etwas auf, auf eine Ankündigung folgt wenig später der echte Launch, und auch der eigentliche Markteintritt könnte dann noch um ein paar Tage zeitversetzt erfolgen. Das ganze dürfte somit eine Angelegenheit von Ende August bis Anfang September werden.

| Chip | Hardware | 4K Perf. | Release | |

|---|---|---|---|---|

| Titan XT | Turing GV102 | vermtl. 4608 Shader-Einheiten @ 384 Bit Interface | geschätzt ~230-260% | Herbst 2018 |

| GeForce RTX 2080 Ti | Turing GV102 | vermtl. 4352-4480 Shader-Einheiten @ 352-384 Bit Interface | geschätzt ~210-240% | Herbst 2018 (?) |

| GeForce RTX 2080 | Turing GV104 | vermtl. 3072 Shader-Einheiten @ 256 Bit Interface | geschätzt ~160-180% | August/Sept. 2018 |

| GeForce RTX 2070 | Turing GV104 | vermtl. 2432-2560 Shader-Einheiten @ 256 Bit Interface | geschätzt ~130-150% | Herbst 2018 |

| Die Angaben dieser Tabelle stellen primär ungesicherte Annahmen dar, Performance-Werte gemäß des 4K Performance-Index. | ||||

10

Gerüchteküche: Eine komplette GeForce-20-Serie tritt angeblich zwischen August und November 2018 an

Gerüchteküche: Eine komplette GeForce-20-Serie tritt angeblich zwischen August und November 2018 an

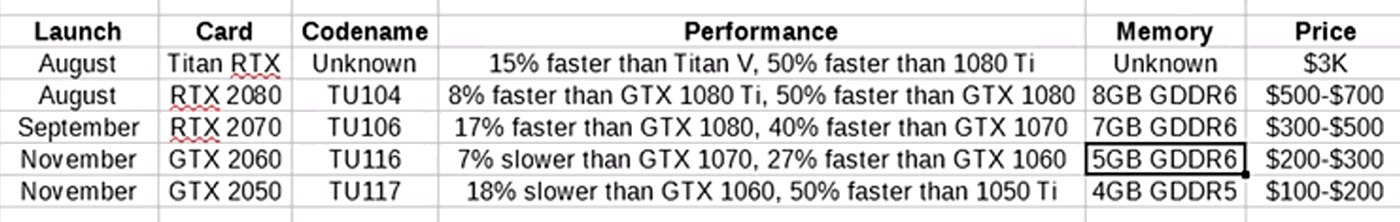

Vielbeachtet werden derzeit die Aussagen von AdoredTV auf YouTube (via Videocardz), welche (angeblich) ziemlich viel Turing-Informationsmaterial haben wollen, dies sogar (angeblich) von einer Quelle direkt bei nVidia. Danach kommt es wohl tatsächlich zu einer "GeForce 20" Serie auf Basis von "Turing", ein Teil der Grafikkarten soll sich dann "GeForce RTX" anstatt "GeForce GTX" (als Hinweis auf deren RayTracing-Eignung) nennen. Die vorgelegten Codenamen der einzelnen Grafikchips klingen mit "TU104", "TU106", "TU116" und "TU117" allerdings schon etwas seltsam – noch dazu, wo GeForce RTX 2070 & 2080 auf (angeblich) unterschiedlichen Grafikchip basieren sollen. Dies ist bei nVidia in den letzten Jahren jedoch niemals derart passiert und ergibt auch ziemlich wenig Sinn. Als weitgehend unrealistisch sehen aus unserer Warte dann vor allem die (angeblichen) Speicherbestückungen aus, denn 5 GB und 7 GB sind vergleichsweise schwer zu realisieren, wenn man nur 1GByte-Speicherchips zur Verfügung hat.

2

nVidia stellt "Adaptive Temporal Antialiasing" als erste RayTracing-Anwendung vor

nVidia stellt "Adaptive Temporal Antialiasing" als erste RayTracing-Anwendung vor

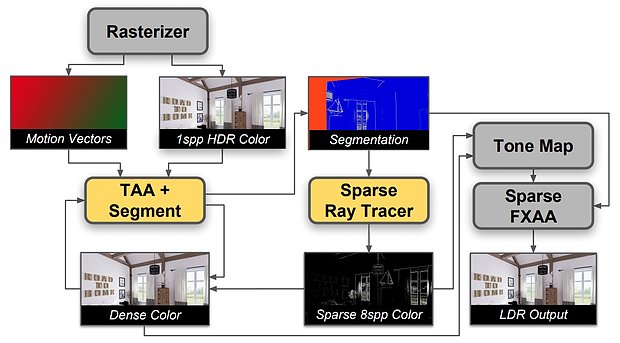

Grafikchip-Entwickler nVidia hat mittels "Adaptive Temporal Antialiasing" (ATAA) eine neue Art von Kantenglättung vorgestellt, welche für ihr Wirken unter anderem Hardware-basiertes RayTracing benutzt. Grundsätzlich handelt es sich bei "Adaptive Temporal Antialiasing" um eine Erweiterung des bekannten "Temporal Antialiasing" (TAA, nicht zu verwechseln mit "Temporal Approximate Anti Aliasing" aka TXAA), welches den Postprocessing-Weichzeichner FXAA mit einer zeitlichen (temporalen) Komponente vermischt, um besonders in Bewegung gute Ergebnisse erzielen zu können. Nichtsdestotrotz ist bei TAA weiterhin aufgrund der FXAA-Basis ein nicht unerheblicher Weichzeichner-Effekt zu sehen, welcher zudem besonders feine Details dann auch gleich ganz verschwinden lassen kann. Mittels ATAA will man nunmehr basierend auf TAA gewisse Bildteile durch ein adaptives RayTracing-Verfahren besonders exakt glätten, um gerade dieser Problematik der Vernichtung besonders feiner Details entgegenzuwirken.

13

Gerüchteküche: nVidias Turing-Generation mit HDMI 2.1 und Hotclocks?

Gerüchteküche: nVidias Turing-Generation mit HDMI 2.1 und Hotclocks?

Zuzüglich zu den kürzlichen terminlichen Aussagen zu nVidias Turing-Generation hat Igor Wallossek von Toms's Hardware in unserem Forum auch noch erste Aussagen zu technischen Details von Turing getroffen. So soll es zuerst einmal eine "neue Art eines ganz bestimmten Videoausgangs" geben – vermutlich dürfte hiermit HDMI 2.1 gemeint sein, da im Feld von DisplayPort die aktuelle Norm 1.4 schon von aktuellen nVidia-Beschleunigern unterstützt wird. HDMI 2.1 ist ein massiver Sprung gegenüber HDMI 2.0: So gibt es eine enorme Bandbreiten-Steigerung von 18 auf 48 GBit/sec, was nachfolgend Auflösungen bis zu 10K oder auch solche netten Dinge wie 4K samt HDR auf 120 Hz Bildwiederholrate ermöglicht. Allerdings sind die Monitor- und TV-Hersteller noch nicht wirklich dieser Norm gefolgt, bislang gibt es keine kaufbaren Geräte gemäß dieses Standards.

Man darf sich schon einmal auf einen neue Art eines ganz bestimmten Videoausgangs freuen und auch beim Takt und dessen Handhabung hat NV grundlegend etwas geändert.

Quelle: Igor Wallossek von Toms's Hardware @ 3DCenter-Forum am 12. Juni 2018

2

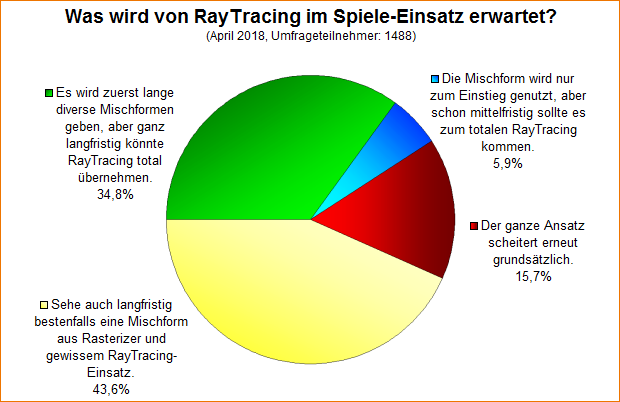

Umfrage-Auswertung: Was wird von RayTracing im Spiele-Einsatz erwartet?

Umfrage-Auswertung: Was wird von RayTracing im Spiele-Einsatz erwartet?

Bei einer Umfrage von Anfang April ging es um die Frage, was man von RayTracing im Spiele-Einsatz erwartet – ein Scheitern, einen Durchmarsch oder aber Mischformen aus Rasterizer- und RayTracing-Grafik. Das herausgekommende Umfrageergebnis ist dabei vergleichsweise eindeutig: Die Mischformen erreichten mit 78,4% Stimmenanteil die klare Mehrheit, während ein Scheitern nur von 15,7% der Umfrageteilnehmer gesehen wird, ein Durchmarsch hin zu totaler RayTracing-Dominanz schon in mittelfristiger Zukunft dagegen sogar nur von 5,9% der Umfrageteilnehmer. Keine dieser Antwort-Optionen ist natürlich in irgendeiner Form "falsch" – es ging bei der Umfrage einfach nur darum, die aktuelle Gefühlslage zu diesem Thema abzubilden.

20

RayTracing wird zukünftig Teil von DirectX 12

RayTracing wird zukünftig Teil von DirectX 12

Golem, Heise und PC Games Hardware berichten über die neuen Microsoft-Schnittstelle "DirectX Raytracing" (DXR), welche Microsoft auf der GDC 2018 in San Francisco angekündigt hat und demnächst in DirectX 12 integrieren will. Hierbei handelt es sich um eine Möglichkeit, einzelne Grafikelemente wie Beleuchtung, Schatten und Umgebungsverdeckung mittels RayTracing zu lösen, am allgemeinen Rasterizer-Ansatz heutiger 3D-Grafik wird also (vorerst) noch nicht gerüttelt. Allerdings erfordern wohl auch nur einzelne RayTracing-Elemente schon eine diesbezügliche Beachtung bzw. Vorsichtnahme bei der zugrundeliegenden Rasterizer-Grafik, kann selbiges also nicht einfach so bei bestehenden Spieletitel übergestülpt werden. Erreicht werden soll letztendlich eine realistischer Beleuchtung, welche dann eben nicht mehr auf einzelnen Lichtquellen, sondern "echten" Lichtstrahlen basiert – mit allerdings dementsprechendem Rechenaufwand.

RayTracing-Demo mittels der Northlight-Engine von Remedy |

RayTracing-Demo "Pica Pica" mittels der Halcyon-Engine von EA |

28

ComputeShader Raytracing Benchmarks verschiedener Grafikkarten

ComputeShader Raytracing Benchmarks verschiedener Grafikkarten

In unserem Forum startet gerade ein neuer Benchmark, welcher sich mit der Leistungsfähigkeit der mit DirectX 11 eingeführten ComputeShadern befasst. Der Benchmark selber besteht aus einer schlichten Raytracing-Animation, bedient sich aber eben nicht der üblichen DirectX-Renderingmechanismen, sondern greift allein auf die CompuShader-Funktionalität zu und bildet somit allein die GPGPU-Rechenleistung eines Grafikchips ab. Der Benchmark selber ist noch nicht perfekt, da verschiedene Seiteneffekte wie ein aktiver MSI Afterburner oder ein Framelimiter einen erheblichen Einfluß auf die Ergebnisse haben können und manches im Forum gepostetes Ergebnis daher (noch) etwas aus dem Rahmen fällt.

30

Neuer Artikel: Echtzeit-Raytracing der Universität des Saarlandes

Die Ankündigung der Universität des Saarlandes, einen Quantensprung in Bezug auf die Realisierbarkeit von Raytracing auf normaler Computer-Hardware hingelegt zu haben, löste vor einiger Zeit ein gewisses Medienecho und ein allgemein größeres Interesse dem Thema gegenüber aus. Wir hatten auf der CeBIT die Gelegenheit, mit Vertretern der Universität zu sprechen und können deshalb nun ein genaueres Bild des bei der Universität des Saarlandes derzeit erreichten Fortschritts auf dem Gebiet des Raytracings zeichnen ... zum Artikel