Hauptlinks

Suchen

PC-Sound über HDMI/DVI am Fernseher ausgeben

Verkabelte man früher zu analogen Zeiten den Computer mit dem Fernseher, um einen auf dem Computer liegenden Film auf dem Fernseher zu schauen oder ein PC-Spiel eben auf dem größeren Fernseher zu spielen, war der Weg klar: Das Bildsignal ging am TV-Out der Grafikkarte hinaus und für das Audiosignal mussten extra Kabel zu den extra hierfür vorhandenen Anschlüssen beim Fernseher verlegt werden. Je nach Computer und Fernseher waren hierzu sogar noch Weichen (wenn nur ein Audioausgang am PC vorhanden ist) oder verschiedene Adapter (um beispielsweise von zwei Audio-Steckern für Links/Rechts auf nur einen Audio-Stecker zu kommen) notwendig. Davon ganz abgesehen senkte die jeweils nur analoge Datenübertragung natürlich die Bild- und Tonqualität insbesondere bei längeren Verbindungen, besonders stark bei der Bildqualität zu sehen.

Heutzutage benutzt man eben aus diesen Qualitätserwägungen heraus digitale Verbindungen. Beim Bildsignal ist dies noch spielend einfach: Der Fernseher wird einfach an den zweiten DVI- oder HDMI-Port der Grafikkarte angeschlossen, was in dem Sinne immer funktioniert. Das Audio-Signal ist von dieser Maßnahme erst einmal ausgenommen, man kann dieses problemlos auch weiterhin auf dem regulären Weg verlegen – sprich also extra Audio-Kabel zum Fernseher führen, die meisten TV-Geräte haben nach wie vor entsprechende analoge Audio-Anschlüsse trotz vorhandener HDMI-Ports. Allerdings sind auch schon TV-Geräte gesichtet wurden, welche analoge Tonsignale nicht mehr mit einem per HDMI ankommenden Bildsignal verschalten, welche also hierfür einen ebenfalls per HDMI übertragenen Sound regelrecht voraussetzen.

Aber natürlich ist HDMI eigentlich explizit dafür vorgesehen, auch das Audiosignal mit zu übertragen (DVI-I und DVI-D können dies bei neueren Grafikkarten auch, wenngleich dies eigentlich nicht in der DVI-Spezifikation vorgesehen ist und man hierfür immer den passenden DVI/HDMI-Adapter des jeweiligen Grafikkartenherstellers benötigt). Dies hat nicht nur den Vorteil der verlustfreien digitalen Übertragung, sondern man spart sich auch die Verlegung des extra Audio-Kabels – man kommt also mit nur einem Kabel für Bild & Ton aus. Interessant ist diese gemeinsame Übertragung von Bild & Ton über HDMI zudem auch für die jetzt auf den Markt kommenden HDMI-Funklösungen, was dann gänzlich kabellose Verbindungen zum Fernseher ermöglicht.

Doch um mit nur dem HDMI-Signal aus einzigem Übertragungsweg für Bild- und Tondaten auszukommen, muß der Ton natürlich erst einmal dort hin, wo das HDMI-Kabel anfängt – in die Grafikkarte, denn nur diese verfügt über den HDMI-Ausgang. Dafür gibt es nun je nach der von den Grafikkarten-Herstellern eingesetzten Technik verschiedene Möglichkeiten:

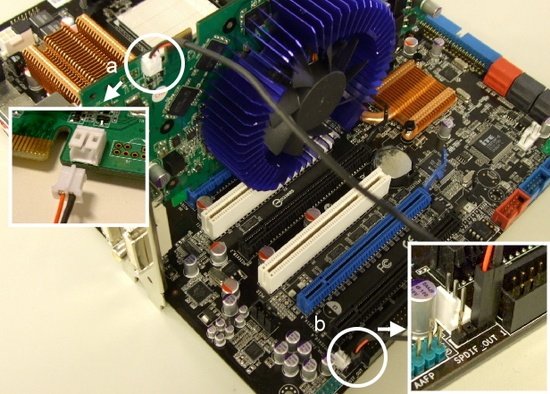

Für alle nVidia-Grafikkarten vor der GeForce 205/210/310/GT220/GT240 und die ATI-Grafikkarten vor der Radeon HD 2000 Serie wird hierfür eine extra Verbindung zwischen Soundquelle und Grafikkarte notwendig, gelöst zumeist über ein sogenanntes S/PDIF-Kabel. Aller modernen Grafikkarten haben normalerweise einen S/PDIF-Anschluß für dieses Kabel (mit der Ausnahme der Karten mit eigenem Soundcodec, dazu später mehr), während der entsprechende S/PDIF-Anschluß auf dem Mainboard zu finden sein sollte. Im einfachsten Fall werden einfach diese beiden Anschlüsse mit dem S/PDIF-Kabel verbunden und man hat dann den Sound auch im HDMI-Signal mit enthalten.

Leider trifft dieser einfachste Fall nicht wirklich oft zu, es gibt reichlich Stolpersteine: So können die S/PDIF-Anschlüsse unterschiedlich ausgeführt werden, einmal zweipolig (reines Signal) und einmal dreipolig (Signal und extra 5V-Leitung). Abhilfe schafft üblicherweise, das ganze nur 2polig zu verbinden, die extra 5V-Leitung also nicht zu nutzen. Gar nicht so selten ist es, daß das Mainboard über keinen internen S/PDIF-Anschluß verfügt, sondern daß am Slotblech nur ein externer S/PDIF-Soundausgang zur Verfügung steht. Hierfür muß man sich dann im Fachhandel je nach vorhandenem Anschluß ein extra Kabel besorgen, welches diese Soundquelle wieder in den PC und an die Grafikkarte hereinleitet (wobei manche Grafikkarten sogar über externe S/PDIF-Anschlüsse verfügen – alles ist möglich).

Gut erklärt sind diese zwei grundsätzlichen Wege im übrigen in einer FAQ des Grafikkarten-Herstellers Palit, dort kann man sich das ganze auch gut verbildlichen:

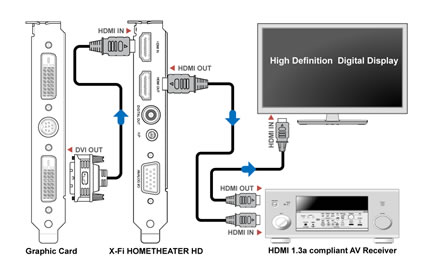

Wenn man eine extra Soundkarte nutzt, muß man sehen, ob diese überhaupt über einen internen S/PDIF-Anschluß verfügt oder ob man über den Sound nur über einen der Backpanel-Anschlüsse mit einem entsprechenden Spezialkabel abgreifen kann. Leider ist hier die Vielfalt an möglichen Anschlüssen und Kabeln noch viel größer, allerdings sollte eine gute Soundkarte eigentlich immer mit dem dafür passenden Kabeln ausgeliefert werden. Eine Gewähr dafür, daß eine gute Soundkarte die passenden Kabel beiliegen hat, ist dies aber nicht, denn bei vielen X-Fi-Karten fehlt erstaunlicherweise dieses Kabel.

Ein grundsätzlich mit S/PDIF verbundenes Problem ist, dass dieses nur für die Übertragung von Stereo oder verlustbehafteten komprimierten Surroundsound bis 5.1 vorgesehen ist. Als Standards der Kompression werden Dolby Digital und DTS unterstützt. Dieses ist solange kein Problem, wie entsprechende Audioquellen (z.B. eine DVD) genutzt werden, welche einen solch komprimierten Ton mitliefern. Möchte der Nutzer allerdings eine Surround-Audioquelle nutzen, welche nicht einen entsprechenden komprimierten Ton mitliefert (z.B. PC-Spiele), funktioniert dieses nur, wenn seine PC-Soundlösung über einen sogenannten Dolby Digital Live, oder DTS Interactive Encoder verfügt – ansonsten wird nur Stereo über S/PDIF übertragen.

Höherwertigere Soundkarten bieten dagegen deutlich bessere Möglichkeiten an, das Soundsignal weiterzuleiten und dabei sogar noch die Soundqualität hochzuhalten. Die beste Lösung sind hierbei Soundkarten, welche über einen HDMI-Input und einen HDMI-Output verfügen. Bei diesen wird nicht das Soundsignal der Soundkarte der Grafikkarte zugeführt, sondern vielmehr das Videosignal der Grafikkarte der Soundkarte zugeführt. Diese mixt dann das Soundsignal hinzu und gibt das dann vollständige Signal über den HDMI-Output aus.

Uns bekannte Soundkarte mit diesem Feature sind die Auzen X-Fi HomeTheater HD und die Asus Xonar HDAV 1.3 Deluxe. Von der Qualität her dürfte dies die wohl beste hochwertigste Sound-Verbindung über HDMI sein, da mit dieser Methode die volle Leistung und Features der Soundkarten genutzt werden. Kleiner Haken: Nicht jede Blu-Ray-Wiedergabesoftware unterstützt diese Lösung, was die Auswahl der passenden Blu-Ray-Wiedergabesoftware erheblich einschränkt, sofern man die bestmögliche Audioqualität nutzten will.

Wie man dennoch sieht, gibt es bei dieser Lösung mittels Einspeisung des Soundsignals in das Videosignal derzeit weiterhin jede Menge Stolpersteine und möglicherweise auftauchende Probleme. Hinzu kommt, daß die entsprechende Literatur selbst im Internet eher ungenügend ist – sobald man vor einem Problem steht, hilft meist nur noch das Ausprobieren aller vorhandenen Möglichkeiten, es gibt leider keinen Königsweg zum Erfolg.

Eben wohl aus diesem Grund hatte sich ATI entschloßen, schon ab der Radeon HD 2000 Grafikkarten-Serie einen komplett anderen Weg zu gehen und integrierte in diese Grafikkarten einen extra Audiocodec (aber keinen Soundchip, die Rechenlast übernimmt in diesem Fall also die CPU – wie aber auch bei den in Mainboards integrierten Audio-Codecs). nVidia hat in diesem Punkt erst kürzlich mit den Grafikkarten GeForce 205/210/310 sowie GeForce GT 220 und 240 nachgezogen. Damit ist die Grafikkarte in der Lage, ihre eigene Sounderzeugung vorzunehmen und es entfällt jegliche Verkabelung zwischen dem eigentlichen Soundchip des Systems und der Grafikkarte, weil die eigentliche Soundlösung nicht mehr benötigt wird.

Hierbei handelt es sich natürlich nicht um einen vollwertigen Ersatz eines Soundchips – es wird also weiterhin ein regulärer Soundchip im System benötigt, da der Soundchip der Grafikkarte nur dann zum Einsatz kommt, wenn der Sound über HDMI ausgegeben wird. Ein kleiner Stolperstein ergibt sich aber natürlich auch bei diesem System: Woher soll das System wissen, wann welcher der nunmehr zwei Soundchips im System arbeiten soll? Schließlich besteht der Grundgedanke weiterhin darin, daß beispielsweise die eigene Musiksammlung über die PC-Lautsprecher laufen soll, während für das auf dem Fernseher gespielte Computerspiel natürlich auch der Sound über den Fernseher ausgegeben werden soll.

Da das Betriebssystem nunmehr zwei Soundquellen besitzt, kann man dies manuell durch das Auswählen der jeweils zu bevorzugenden Soundquelle im Menü "Sound" der Windows-Systemsteuerung lösen. Der Nachteil dieser Lösung ist natürlich, daß man dies vor jedem Wechsel der Soundquelle immer wieder erneut tun muß. Alternativ dazu bieten Windows Vista und 7 die Möglichkeit an, bestimmten Anwendungen die jeweils passende Soundquelle dauerhaft zuzuweisen – dies ist schon einmal etwas besser, aber sicherlich noch bei weitem nicht perfekt, denn natürlich kann man ein und dasselbe Computerspiel heute vor dem PC-Monitor und morgen vor dem TV-gerät zocken.

Richtig rund wird es erst dann, wenn Windows die Soundquelle automatisch umschaltet, je nachdem welches Bildausgabegerät benutzt wird: Wird nur der reguläre PC-Monitor benutzt, soll der Sound natürlich vom regulären Soundchip erzeugt und über die üblichen analogen Ausgänge ausgegeben werden, so daß sich reguläre PC-Lautsprecher benutzt lassen. Wird dagegen der TV-Monitor als Ausgabegerät benutzt, sollen die PC-Lautsprecher natürlich stumm bleiben und der Sound nur noch über den Fernseher ausgegeben werden – in diesem Fall ist die Grafikkarte die Soundquelle.

Gelöst werden kann diese Vorstellung mittels eines einfachen, unscheinbaren Treibers von der Realtek-Webseite (der auf den ATI-Grafikkarten verbaute Audio-Codec scheint von Realtek zu kommen, wie es bei nVidia aussieht, ist unklar). Ist dieser – zusätzlich zu allen anderen benötigten Soundtreibern – installiert, so existiert für das Betriebssystem immer nur eine Soundquelle, der Treiber schaltet dann automatisch je nach Bild-Ausgabegerät auf die jeweils passende Soundquelle um. Erstaunlicherweise wird dieser Treiber weder von ATI noch Realtek besonders beworben oder aber finden sich bei den Herstellern irgendwelche Hinweise auf diesen Treiber – wir sind selber auch nur durch Ausprobieren auf diesen Treiber gestoßen.

Es handelt sich hierbei um den Treiber "ATI HDMI Audio Device", welcher wie gesagt bei Realtek zu beziehen ist. Mittels diesem Treiber gelingt die automatische Umschaltung des Sounds, je nachdem wohin die Bildausgabe geht. Dies funktionierte bei uns auf zwei verschiedenen Geräten – wobei beide mit ATI-Grafikchips und in das Mainboard integrierter Realtek-Soundlösung ausgerüstet sind. Wie dies gerade in Fällen mit integrierten Soundchips anderer Hersteller oder mit extra Soundkarten aussieht, können wir leider nicht sagen – hier hilft wohl nur ausprobieren.

Und wenn es ein Fazit dieses kurzen Techlets zum Thema "PC-Sound über HDMI/DVI am Fernseher ausgeben" gibt, dann die Aussage, daß sich die Chip- und Gerätehersteller hierzu enorm mit den dafür notwendigen Erklärungen zurückhalten und der für alles bezahlende Endkunde oftmals darauf angewiesen ist, unzählige Möglichkeiten im Selbstversuch auszuprobieren. Selbst scheinbar einfache Fälle wie der extra Soundcodec in den ATI- und den neueren nVidia-Grafikkarten sind unserer Meinung nach bei weitem nicht ausreichend dokumentiert. Gerade wenn die Grafikchip-Entwickler mit diesen Soundcodecs werben, sollte sie sicherstellen, daß diese auch problemlos vom technisch nicht versierten Endkunden genutzt werden können. Dies kann zweifellos besser geregelt sein, insbesondere da dieses Thema in Zukunft noch viel mehr Computernutzer betreffen und interessieren dürfte.