Hauptlinks

Suchen

News des 22. September 2010

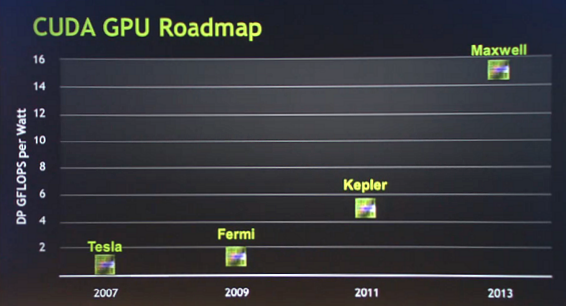

Auf nVidias hauseigener GPU Technology Conference (GTC) hat der Grafikchip-Entwickler einen (unerwarteten) Einblick in seine GPU-Roadmap bis zum Jahr 2013 geboten. Danach soll im Jahr 2011 die neue Architektur "Kepler" antreten, im Jahr 2013 dann die Architektur "Maxwell". Die Vorstellungstermine sind derzeit natürlich nur eher grob, aber ähnlich wie bei der Fermi-Architektur (die nVidia im Jahr 2009 einordnet, obwohl der GF100 als erster Fermi-Chip erst 2010 erschien) dürfte es bei Kepler und Maxwell wohl auf eine Vorstellung zum jeweiligen Jahresende hinauslaufen. Somit dürfte Kepler dann nVidias erste 28nm-Architektur darstellen und die Fermi-Architektur nicht mehr auf 28nm umgesetzt werden – dafür ist schlicht zu wenig zeitlicher Abstand vorhanden, die 28nm-Fertigung von Grafikchips wird zum Jahresende 2011 gerade mal so bereitstehen.

Die von nVidia angesetzten Performance-Werte für Kepler und Maxwell sind natürlich ebenfalls nur Projektionen und beziehen sich zudem auf die GPGPU-Performance, konkret die erreichbare Rechenleistung unter DoublePrecision (DP). In dieser Disziplin kann nVidia bei zukünftigen Grafikchip-Generationen die projektierte Mehrleistung natürlich nicht nur mittels mehr Hardware-Einheiten und/oder mehr Takt steigern, sondern auch mittels Veränderungen an den DoublePrecision-Einheiten selber. Anders sind die hohen von nVidia prognostizierten Performance-Steigerungen sowieso nicht zu erreichen – vermutlich wird nVidia bei Kepler und Maxwell maßgeblich daran gehen, die DoublePrecision-Performance schrittweise auf das Niveau der SinglePrecision-Performance zu heben.

Die GPGPU-Gemeinde dürfte dies freuen, für die Spieler ist dies aber völlig ohne Belang und potentiell handelt es sich hierbei sogar um nutzlose, weil stromfressende Transistoren. Wahrscheinlich wird nVidia aber wie schon bei Fermi einen Hauptchip (GF100) bauen, welcher die ganzen für professionelle Bedürfnisse interessanten Funktione enthält und die kleineren Chips (GF104, GF106 & GF108) dann um diese Funktionen und die dafür benötigten Transistoren erleichtern. Ob das ganze eines Tages zu einer komplett getrennten Entwicklung für beide Anwendungsbereiche führt, ist noch nicht abzusehen – dies dürfte aber nur dann passieren, wenn die Stückzahlen des professionellen Segments eine entsprechende Eigenentwicklung finanziell zulassen. Andererseits geht die langfristige nVidia-Strategie klar in Richtung einer Marktdurchdringung von GPGPU im Massenmarkt – wofür es sinnvoller ist, gewisse GPGPU-Fähigkeiten auch bei den kleineren Grafikchips einer Serie mit an Bord zu haben.

Bemerkenswert ist daneben, daß nVidia die prognostizierte Performance der kommenden Grafikchip-Architekturen in GFlops pro Watt angegeben hat – ein klarer Hinweis darauf, daß man die Wattage der Grafikchips nicht weiter steigern will (ansonsten hätte man das "pro Watt" weggelassen, weil die Zahlen dann noch besser aussehen würden). Möglicherweise sinkt zukünftig sogar die Wattage der nVidia-Grafikchips wieder etwas, auch das wäre angesichts dieser Konstellation denkbar. Einen noch höheren Stromverbrauch als bisher kann nVidia sowieso nicht bieten: Zum einen ist mit der Kühltechnik nicht viel mehr herauszuholen und zum anderen dürfte man mittels Fermi festgestellt haben, daß man im Spiele-Markt mit Beschleunigern von mehr als 200 Watt TDP gegen eine deutliche psychologische Wand läuft.

Wie Fudzilla berichten, beschäftigt sich nVidia daneben mit einer eigenen Lösung für externe Grafikkarten. Daß man allerdings für AMDs faktisch gescheiterten Lasso-Ansatz Lob übrig hat, läßt nicht gerade hoffen, daß man selber das größte Problem dieses Ansatzes – die Bindung an bestimmte Notebooks, anstatt einen freien Standard zu schaffen – besser lösen will. Ganz allgemein betrachtet dürfte AMD und nVidia schon klar sein, daß ein freier Standard aus Konsumentensicht vorteilhaft wäre – aus Sicht der Grafikchip-Entwickler ist dem aber nicht zwingend so. Denn letztlich könnte ein freier Standard dazu führen, daß in den Notebooks selber nur noch integrierte Beschleuniger verbaut werden und die 3D-Performance dann komplett aus externen Lösungen geholt wird, welche aber auf günstigen Desktop-Beschleunigern aufbauen.

Das ganze aus finanzieller Sicht sehr interessante Geschäft mit den vergleichsweise teuren Mobile-Beschleunigern könnte so aber in sich zusammenfallen – und ob man damit dann wesentlich mehr Desktop-Beschleuniger absetzt, um dies wieder ausgleichen zu können, ist eher fraglich. Insofern sind die Chancen auf eine endlich einmal vollständig überzeugende Lösung bei externer Grafik eher gering – nicht, weil es nicht machbar wäre, sondern weil es letztlich gar nicht im finanziellen Interesse der Grafikchip-Entwickler liegt, die guten Pfründe im Segment der Mobile-Beschleuniger aufzugeben. Denkbar in diesem Rahmen ist allerdings die Auslagerung eines Mobile-Beschleunigers aus dem Notebook in ein extra Gehäuse sowie die generelle Aufrüstbarkeit mittels der Durchsetzung eines entsprechenden Anschlußports – gerade mittels letzterem wäre ja auch schon viel gewonnen.