Hauptlinks

Suchen

News des 17. Februar 2011

Die VR-Zone hat genauere Daten zur GeForce GTX 550 Ti, einer neuen Mainstream-Lösung von nVidia, welche auf dem GF116-Chip basieren wird. Dieser Chip scheint schlicht ein überarbeiter GF106-Chip (GeForce GTS 450) zu sein – ähnlich schon wie im Fall der Chips GF104 (GeForce GTX 460) zu GF114 (GeForce GTX 560 Ti) wurden anscheinend keine neuen Hardware-Einheiten oder Funktionen hinzugefügt, sondern schlicht nur der Chip dahingehend überarbeitet, mehr Performance bei einer nahzu unveränderten Verlustleistung herauszubekommen. Dementsprechend sollte der GF116-Chip wie schon der GF106-Chip über 192 Shader-Einheiten, 32 Textureneinheiten und 24 ROPs samt einem 192 Bit DDR Speicherinterface verfügen – und wiederum wird nVidia davon im Desktop-Segment nicht das volle Speicherinterface ausfahren, sondern jenes auf 128 Bit DDR limitieren (womit gleichzeitig die Anzahl der aktiven ROPs auf 16 sinkt). Bisher gibt es das volle Speicherinterface des GF106-Chips nur im Mobile-Segment, beim GF116 könnte es ähnlich werden.

| AMD RV840/Juniper | nVidia GF106 | nVidia GF116 | |

|---|---|---|---|

| Chipbasis | AMD RV840/Juniper, 1040 Mill. Transistoren in 40nm auf 166mm² Chip-Fläche | nVidia GF106, 1170 Mill. Transistoren in 40nm auf 228mm² Die-Fläche | nVidia GF116, 40nm |

| Technik | DirectX 11, 1 Raster Engine, 800 (5-D) Shader-Einheiten, 40 TMUs, 16 ROPs, 128 Bit DDR Speicherinterface (bis GDDR5) | DirectX 11, 1 Raster Engine, 192 (1-D) Shader-Einheiten, 32 TMUs, 24 ROPs, 192 Bit DDR Interface (bis GDDR5) | vermutlich DirectX 11, 1 Raster Engine, 192 (1-D) Shader-Einheiten, 32 TMUs, 24 ROPs, 192 Bit DDR Interface (bis GDDR5) |

| Grafikkarten | Radeon HD 5770/6770 (800/40/16/128, 850/2400 MHz) Radeon HD 5750/6750 (720/36/16/128, 700/2300 MHz) |

GeForce GTS 450 (192/32/16/128, 783/1566/1800 MHz) |

GeForce GTX 550 Ti (192/32/16/128, Taktraten unbekannt) |

| Verbrauch | 5770: 81W Spieleverbrauch, 108W TDP 5750: 64W Spieleverbrauch, 86W TDP |

84W Spieleverbrauch, 106W TDP | 110W TDP |

| Preisbereich | 85-110 Euro | 90-105 Euro | geschätzt 120 Euro |

Das Speicherinterface des GF116-Chips ist dabei schon bestätigt, die Anzahl der Hardware-Einheiten noch nicht – allerdings ist es arg unwahrscheinlich, daß nVidia in die nahezu gleiche Verlustleistung jetzt noch mehr Hardware-Einheiten hereinpresst, den Performancevorteil der GeForce GTX 550 Ti kann man auch über Taktraten-Steigerungen erreichen. Für mehr Takt eignete sich schließlich schon der GF106-Chip glänzend, beim optimierten GF116-Chip sollte dies noch besser gehen und somit kann man die GeForce GTX 550 Ti grob als GeForce GTS 450 mit deutlich mehr Takt erwarten. Damit sollen laut der VR-Zone bis zu 20 Prozent Mehrperformance gegenüber der Radeon HD 5770 unter DirectX10 und bis zu 35 Prozent unter DirectX11 erzielt werden. Im Vergleich zur GeForce GTS 450 kann man auf diese Zahlen jeweils noch einmal ca. 10 Prozent oben drauf legen, sprich bis zu 30 Prozent unter DirectX10 und bis zu 45 Prozent unter DirectX11.

Diese Zahlen erscheinen dann allerdings ein wenig unglaubwürdig angesichts der Karten-TDP von 110 Watt, was nur sehr geringfügig über der Karten-TDP der GeForce GTS 450 mit 106 Watt liegt. Egal ob mittels mehr Taktrate oder doch mittels mehr Hardware-Einheiten – in diese TDP-Angabe passen trotz des optimierten GF116-Chips vielleicht 15 bis maximal 20 Prozent Mehrperformance zur GeForce GTS 450, aber keineswegs mehr. Selbst wenn nVidia die Reserve zwischen realem Verbrauch und TDP-Limit bei der GeForce GTX 550 Ti mehr ausreizt als bei der GeForce GTS 450 (84W Spieleverbrauch bei 106W TDP), sind im allerbesten Fall 30 Prozent Mehrperformance zur GeForce GTS 450 zu erwarten. Dies wäre dann knapp das Niveau der GeForce GTX 460 768MB – dies muß die GeForce GTX 550 Ti aber auch erst einmal erreichen, wir sind da vorerst skeptisch. Mit einer solchen Performance würde sich dann auch die Namenswahl in Bezug auf das "GTX" erklären lassen – nachdem die direkte Vorgängerlösung schließlich noch mit "GTS" auflief.

Allerdings werden Verkaufsnamen nun einmal von Marketing gewählt und die GTX-Namenswahl muß somit keineswegs bedeuten, daß die GeForce GTX 550 Ti wirklich die Performance einer GeForce GTX 460 768MB erreicht – sondern nur, daß dies dem Grafikkartenkäufer so suggiert werden soll. In jedem Fall scheint die GeForce GTX 550 Ti eine neue Lösung für das obere Mainstream-Segment zu sein, angesichts des Performance-Feldes von irgendwo zwischen Radeon HD 5770 und GeForce GTX 460 768MB ist eine Preislage von um die 120 Euro zu erwarten (die VR-Zone berichtet etwas anderes, aber dies ist auch derenseits nur eine Vermutung). Offiziell vorgestellt werden soll die GeForce GTX 550 Ti dann am 15. März. Interessant wird sein, ob AMD entsprechend kontern kann, weil die Radeon HD 5770 offenbar von der neuen GeForce GTX 550 Ti geschlagen werden wird und die Radeon HD 6850 vom Preis und der Performance her klar zu hoch angesetzt ist. Denkbar wäre hierfür eine "Radeon HD 6830" als weiter abgespeckte Lösung auf Basis des RV940/Barts-Chips – aber dies ist natürlich rein spekulativ.

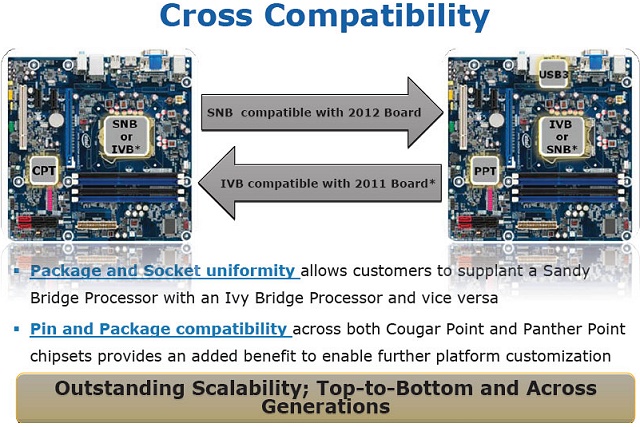

Nochmals die VR-Zone haben in Form eines anscheinend von Intel stammenden Präsentations-Screenshots eine klare Bestätigung für die Aufwärtskompatibiliät der aktuellen 6er Chipsatz-Serie in Bezug auf den Support von Ivy-Bridge-Prozessoren im Jahr 2012 ausgegraben. Diese werden von den aktuellen Mainboards anscheinend durchgehend unterstützt, höchstwahrscheinlich wird hierfür natürlich trotzdem ein BIOS-Update vonnöten sein. Allerdings muß Intel (wie in dieser Präsentation) nun nicht wirklich auf dieser Kompatibilität herumreiten, schließlich handelt es sich es dabei gerade einmal um einen Kompatibilitäts-Zeitraum von maximal zwei Jahren (im Jahr 2013 müsste regulär schon wieder die nächste Intel-Architektur anstehen, auch wenn zu dieser derzeit noch arg wenig bekannt ist). Die Vergangenheit hat selbst bei Intel viel längere Kompatibilitäts-Zeiträume gesehen und Konkurrent AMD bietet auch in der jüngeren Vergangenheit diesbezüglich regelmäßig längere bis deutlich längere Kompatibilitäts-Zeiträume an.

Gemäß Fudzilla verfügt der kommende 28nm Mobile-Chip Tegra 3 von nVidia bereits über 12 Shader-Einheiten, nachdem der aktuelle Tegra 2 noch acht Shader-Einheiten hat (interessanterweise unterteilt in vier Vertexshader und vier Pixelshader-Einheiten, Tegra 3 wird dann wahrscheinlich die moderneren unified Shader-Einheiten benutzen). Damit robbt sich nVidia in diesem Marktsegment langsam aber sicher an Bereiche heran, welche bis vor kurzer Zeit noch im LowEnd-Segment auf dem PC normal waren – zu erinnern wäre hierbei an die GeForce G210, welche die LowEnd-Lösung der auch nicht gerade weit zurückliegenden GeForce-200-Generation mit nur 16 Shader-Einheiten darstellte. Ein Tegra-Chip benötigt aufgrund seiner Ausrichtung auf Kleingeräte mit üblicherweise geringen Displayauflösungen natürlich nicht die Performance von PC-Lösungen, insofern sind diese 12 Shader-Einheiten in diesem Bereich schon hochwertig – und im übrigen genauso viel, wie die integrierte Sandy-Bridge-Grafikeinheit zu bieten hat, selbst wenn dieser Hersteller-übergreifende Vergleich aufgrund unterschiedlicher Architekturen natürlich nur höchst ungenau sein kann.