Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 14. August 2020

WCCF Tech bieten eine eigene Interpretation des GeForce-30-Portfolios an und garnieren das ganze mit aus dem chinesischen Baidu-Forum stammenden (angeblichen) Benchmark-Werten zu diesen Ampere-Grafikkarten. Wirklich belegt wird dies leider nicht – und selbst jene Benchmark-Werte sollte man nicht zu ernst nehmen, da in fernöstlichen Foren gern einmal wild spekuliert wird ("wie etwas aussehen könnte"), während diese reinen Gedankenspielen dann für Westler zu schnell wie vermeintliche Fakten aussehen. So erscheint es als wenig wahrscheinlich, dass jetzt schon feststehen sollte, dass Custom-Designs dieser Ampere-Grafikkarten unter dem TimeSpy-Extreme-Test des 3DMark13 gleich 7-15% schneller als die entsprechenden Founders Editions herauskommen. So etwas kann bei den späteren Custom-Designs passieren, aber am Anfang dürften die besten Custom-Designs maximal knapp vor der Founders Edition herauskommen – gerade da nVidia zuletzt viel Wert auf deren Schlagkraft gelegt hat, jene also gerade anfänglich eine der schnellsten verfügbaren Kartenvarianten darstellen sollten. Dass nVidia hingegen so viel Platz läßt, dass man ausgerechnet aus einer GeForce RTX 3090 noch +15% (!) herausholen könnte, erscheint dann als arg unwahrscheinlich, gerade zum Zeitpunkt des initialen Launches.

| Chip | Interface & Speicher | TSE – FE | TSE – Custom | |

|---|---|---|---|---|

| Ampere-Titan | augenschl. GA102 | 48 GB @ 384 Bit | ? | ? |

| GeForce RTX 3090 | augenschl. GA102 | 24 GB @ 384 Bit | ~10'000 | ~11'500 |

| GeForce RTX 3080 | augenschl. GA102 | 20 GB @ 320 Bit | ~9'000 | ~9'700 |

| GeForce RTX 3070 | augenschl. GA104 | 16 GB @ 256 Bit | ~7'300 | ~7'800 |

| GeForce RTX 3060 | augenschl. GA106 | 12 GB @ 192 Bit | ? | ? |

| gemäß den Ausführungen von WCCF Tech, basierend auf Angaben aus dem Baidu-Forum | ||||

Die Chance, dass es sich hierbei um rein ausgedachte Werte handelt, liegt also doch ziemlich hoch. Das aufgezeigte Portfolio selber kommt im übrigen ohne Speicher-Wahlmöglichkeit aus, sprich ohne GeForce RTX 3070 mit 8 GB und GeForce RTX 3080 mit 10 GB – es gibt nur die größeren Kartenausführungen mit 16/20 GB Speicher. Dies wäre gemäß des Prinzips "besser mehr als weniger" nicht ganz so wild, würde nVidia aber der Möglichkeit berauben, AMD preislich in die Zange zu nehmen: Die Karte mit weniger Speicher als günstigeres Angebot, die Karte mit mehr Speicher dagegen mit Mehrpreis – was aus Verkaufs-technischer Sicht durchaus wie eine zielführende Strategie klingt. Ganz ohne die Speicher-Wahlmöglichkeit müsste sich nVidia hingegen allein mit diesen Karten (mit viel Speicher) AMDs Angeboten stellen und wäre u.U. zu preislichen Abspeckungen gezwungen – etwas, was nVidia gar nicht liegt und was man normalerweise bereits im Planungsstadium zu umgehen versucht. Daneben fehlen im WCCF-Portfolio auch noch weitere GA104- und GA106-Varianten, denn mit nur einer einzelnen Grafikkarte pro Grafikchip dürfte nVidia ziemlich sicher nicht antreten. Somit darf mit guter Chance noch mit entsprechenden Ti-Varianten und/oder Modellen mit mehr/weniger Speicher gerechnet werden.

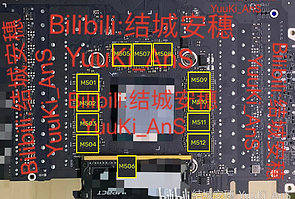

Neu aufgetauchte Bilder einer Ampere-Grafikkarte, welche später als "GeForce RTX 3090" klassifiziert wurde, haben für ein klein wenig Irrung & Verwirrung bezüglich deren Speichermenge gesorgt. Denn es waren gewisse Teile der Platine verblurrt oder verdeckt, womit nur das gesehen werden konnte, was gesehen werden sollte – darunter 11 Speicherchips, was auf 11 oder 22 GB Speichermenge an einem 352bittigen Speicherinterface hinweist und demzufolge in dieser Art von Videocardz berichtet wurde. Allerdings gab es umgehend Hinweise darauf, dass ein zusätzlicher Speicherchip jener Verdeckungs-Aktion zum Opfer gefallen ist – was sich wenig später bei Videocardz mittels der erneuten Betrachtung jenes Platinen-Fotos wiederfand. Selbiges Grafikboard trägt augenscheinlich tatsächlich unterhalb des Grafikchips noch einen einzelnen weiteren Speicherchip – womit sich im übrigen das frühere Schemabild von Igor's Lab eindrucksvoll bestätigt. Die GeForce RTX 3090 wird somit gemäß dieses Platinen-Fotos über 12 oder 24 GB Speicher an einem 384bittigen Speicherinterface verfügen.

nVidia GeForce RTX 3090 Speicher-Layout © Videocardz (vom 14. August 2020)

nVidia GeForce RTX 3090 Platinen-Layout © Igor's Lab (vom 31. Juli 2020!)

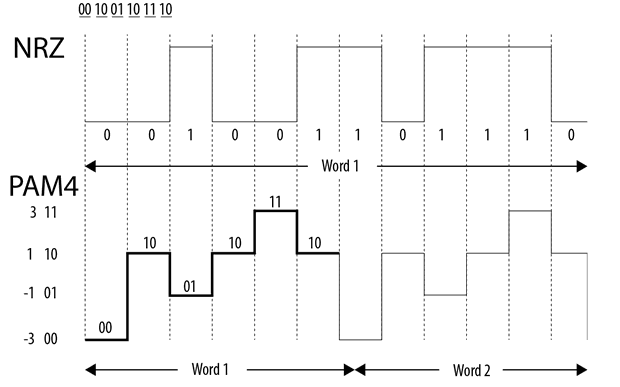

Zum Fall des Micron GDDR6X-Speichers für nVidias Ampere-Grafikkarten kommt aus unserem Forum der Hinweis auf einen AnandTech-Artikel, welcher dann doch einen gewichtigen technologischen Unterschied zu GDDR6-Speicher nennt: Und zwar setzt man bei GDDR6X auf ein neues Datenübertragungs-Verfahren namens "PAM4", welches im Gegensatz zum üblichen binären Verfahren ("NRZ") nicht zwei, sondern vier verschiedene Zustände kennt und damit nominell die doppelte Speicherbandbreite auf gleicher Taktrate erreichen kann. Das ganze geht mit höheren Kosten im Speicherinterface, bei der Platine und bezüglich des Stromverbrauchs einher, ist aber logischerweise viel effizienter, als die Taktrate entsprechend erhöhen zu müssen. Prinzipiell könnte man hierbei von einer Octa-Rate-Datenübertragung ("ODR") bei GDDR6X sprechen, da schließlich pro Takt die achtfache Datenmenge übertragen wird: Reguläres QDR samt der Verdopplung durch PAM4. Damit dürfte es sicherlich doch noch zu einer JEDEC-Zertifizierung von GDDR6X kommen, ein gänzlicher Alleingang von Micron ist eher unwahrscheinlich.

Zu beachten wäre, dass aufgrund des "ODR"-Verfahrens logischerweise die Taktrate von GDDR6X sinkt – anstatt höherer Taktraten als bei GDDR6 geht es wieder deutlich herunter, der Datentakt dürfte sich nur noch zwischen 2375-2625 MHz belaufen (bei 19-21 Gbps). Dies macht augenscheinlich zwar nichts einfacher (der Aufwand für GDDR6X auf den entsprechenden Platinen soll letztlich sogar höher liegen), aber dies ergibt erhebliche Reserven für die Zukunft – man denke an GDDR6X mit Taktraten von bis zu 3000 MHz. Dies würde eine Datenrate von 24 Gbps ergeben, damit wären an einem 384bittigen Speicherinterface schon 1,15 TB/sec Speicherbandbreite drin (an einem 512bittigen Interface sogar 1,54 TB/sec). GDDR6X erhöht somit den Spielraum für GDDR-Speicher in der Zukunft, womit auch weiterhin eine hochbandbreitige Konkurrenz zu HBM gesichert ist. Denkbar im übrigen, dass GDDR6X von Seiten des Grafikchips sogar etwas energieeffizienter sein könnte: Die Datenrate steigt zwar, aber die Taktrate des ankommenden Signals ist beachtbar niedriger – und die ganz hohen Taktraten waren noch nie gut für den Stromverbrauch von GDDR-Interfaces.