Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 20. Juni 2018

Zu den Performance-Aussagen rund um nVidias Turing-Generation (No.1 & No.2) wäre noch zu erwähnen, das dies alles natürlich nur Sinn ergibt, sofern nVidia tatsächlich (wie bisher) zuerst mit einer HighEnd-Lösung antritt – und die Enthusiasten-Lösung später nachfolgen läßt. Dies war seit der Auftrennung dieser Marktsegmente mit der Kepler-Generation immer die Release-Abfolge bei nVidia – aber natürlich gibt es hierfür keine Ewigkeitsgarantie. Jene Release-Abfolge ist primär technologisch sinnvoll, da man somit immer zuerst den einfacher zu produzierenden (da kleineren) HighEnd-Chip bringen kann – und erst später den größeren und somit schwerer (mit guter Ausbeute) herzustellenden Enthusiasten-Chip. Genau dieses Argument könnte bei der Turing-Generation aber eher weniger ziehen, sofern jene in der 12nm-Fertigung daherkommt. Denn in dieser Fertigung hat nVidia schon letztes Jahr den GV100-Chip mit satten 815mm² Chipfläche aufgelegt – und unabhängig von der für diesen Chip nicht maßgeblichen Fertigungsausbeute sollte damit dieses Jahr eigentlich alles in der 12nm-Fertigung mit erstklassiger Ausbeute herstellbar sein.

| Datum | neue Top-Lösung | Chip-Basis | FHD/4K-Perf. | Vergleich zur vorherigen Top-Lösung |

|---|---|---|---|---|

| 22. März 2012 | GeForce GTX 680 | GK104 (HighEnd) | 360% / - | +29% zur GeForce GTX 580 |

| 21. Februar 2013 | GeForce GTX Titan | GK110 (Enthusiast) | 480% / ~62% | +33% zur GeForce GTX 680 |

| 7. November 2013 | GeForce GTX 780 Ti | GK110 (Enthusiast) | 530% / 68% | +10% zur GeForce GTX Titan |

| 19. September 2014 | GeForce GTX 980 | GM204 (HighEnd) | 600% / 77% | +13% zur GeForce GTX 780 Ti |

| 31. Mai 2015 | GeForce GTX 980 Ti | GM200 (Enthusiast) | 750% / 100% | +30% zur GeForce GTX 980 |

| 17. Mai 2016 | GeForce GTX 1080 | GP104 (HighEnd) | 960% / 132% | +32% zur GeForce GTX 980 Ti |

| 10. März 2017 | GeForce GTX 1080 Ti | GP102 (Enthusiast) | 1150% / 175% | +33% zur GeForce GTX 1080 |

Allerdings es gibt noch ein zweites Argument pro der typischen nVidia-Releaseabfolge: Bringt man zuerst die HighEnd-Lösung, kann man faktisch zweimal innerhalb derselben Grafikkarten-Generation ein neues Top-Modell aufbieten – und damit sind dann keine geringen Differenzen wie bei einer neuen Karten-Variante auf Basis desselben Grafikchips gemeint. Die Vergangenheit bietet hierzu gute Beispiele: Mit dem Start der Pascal-Generation bot die GeForce GTX 1080 sofort mehr Performance als die vorhergehenden Enthusiasten-Lösungen aus der Maxwell-Generation. Dennoch war die GeForce GTX 1080 nur eine HighEnd-Lösung, die eigentlichen Enthusiasten-Lösungen der Pascal-Generation folgten später und setzten bei der Performance nochmals maßgeblich was oben drauf. Hätte nVidia das ganze umgedreht herausgebracht, hätte die GeForce GTX 1080 niemals den (zeitweiligen) Status der schnellsten Grafikkarte innegehabt – und hätte sich damit auch niemals ihren Launchpreis von 699 Dollar leisten können. Jener produktpolitische Punkt deutet insofern jederzeit stark darauf hin, das nVidia bei Turing das gewohnte Release-Schema beibehält – aber wie gesagt, wenn nicht, dann passen die bisherigen Performance-Aussagen bzw. die sich daraus ergebenden Schlußfolgerungen nicht mehr.

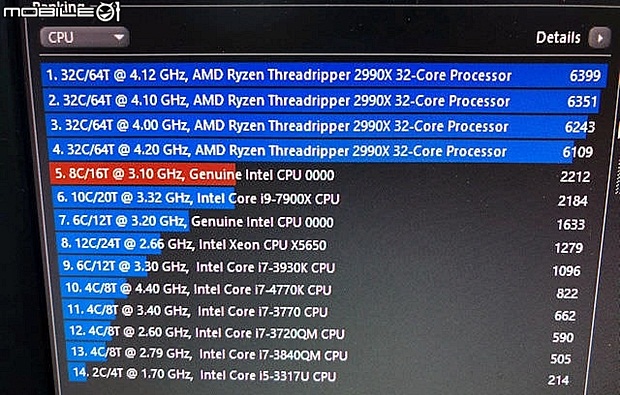

Zu den Daten und dem Benchmark-Wert zum Ryzen Threadripper 2990X ist noch zu erwähnen, das die Echtheit dieser Angaben teilweise in Zweifel gezogen wird. Grundsätzlich gesehen gibt es natürlich keine Garantie auf die Korrektheit einer solchen auf Gerüchten und inoffiziellen Informationen basierenden Berichterstattung – im konkreten Fall werden zudem Probleme mit einigen der Screenshots von HKEPC angemeldet, die ComputerBase hat sich hiermit genauer beschäftigt. Richtig eindeutig ist das ganze derzeit aber nicht – und zudem gilt, das HKEPC mit seinem Standort in Hongkong wirklich nahe einiger der großen Mainboard-Hersteller sitzt und damit in der Vergangenheit immer mal wieder mit ähnlichen (und dann auch korrekten) Vorab-Informationen glänzen konnte. Dabei sind die kredenzten Daten zum Ryzen Threadripper 2990X auch nicht wirklich unglaubwürdig in der Höhe der Taktraten oder des Benchmark-Ergebnisses – sprich, selbst wenn die gesamte Berichtersttatung seitens HEKPC doch Fake sein sollte, ist der 32-Kerner von Threadripper II (dann ironischerweise) in ziemlich ähnlicher Form zu erwarten.

Beim chinesischen mobile01 gibt es (in den Kommentaren) den bewußten Benchmark-Screenshot zum Ryzen Threadripper 2990X auch noch einmal ohne Verpixelungen beim rot markierten Ergebnis zu sehen – und darunter soll sich nun ein Intel-Achtkerner mit einem Basetakt von 3.1 GHz verbergen. Dies kann man als Hinweis auf den kommenden Core i7-8800K sehen, sprich den Coffee-Lake-basierten Consumer-Achtkerner – welcher aufgrund seiner höheren Boosttaktraten dann auch leicht schneller als der Zehnkerner Core i9-7900X unter dem Multithread-Test des Cinebench R15 herauskommt. Logischerweise ist das Ergebnis auch beachtbar besser als beim Ryzen 7 2700X, welcher bei ca. 1792 Punkten herauskommt. Auf gleicher Kernanzahl hat Intel dann immer noch seinen üblichen Mehrtakt und ein paar Prozentpunkte höherer IPC für sich. Noch verlangt Intel dafür allerdings auch die höheren Preise – und auch der Core i7-8800K dürfte sich preislich klar oberhalb des Ryzen 7 2700X einordnen. Die Zeiten, wo sich AMD an Intel allein auf Basis von sehr viel mehr CPU-Kernen gütlich tun konnte, gehen nun aber recht schnell zu Ende – Intel zieht (vergleichsweise schnell) nach, so das AMD sich mehr eher auf erreichbare Taktraten sowie eine höhere IPC konzentrieren muß.

Wie Heise ausführen, geht den OpenBSD-Entwicklern das mittels der Spectre-NG-Sicherheitslücken entstandende Risiko inzwischen so weit, das jene in OpenBSD lieber gleich Intels HyperThreading-Feature per default deaktivieren (ist natürlich durch den Anwender wieder aktivierbar). Hintergrund hierfür ist, das HyperThreading Datenabgriffe per Seitenkanal-Angriff sehr viel einfacher macht, da sich bei HyperThreading mehrere Threads bestimmte Hardware-Ressourcen (wie Caches) teilen. Die Deaktivierung von HyperThreading ist dagegen ein zwar radikaler Schritt, bringt dafür auch radikale Vorteile – viele der Angriffswege der neuen Spectre-Varianten inklusive eventuell noch nicht entdeckter Varianten sind somit nicht mehr oder nur noch viel schwieriger durchzuführen. Die OpenBSD-Macher sind generell dafür bekannt, in solchen Frage eine sehr harte Linie zu fahren – und dennoch ist das ganze ein ziemlicher Offenbarungseid für Intel, wird hiermit doch ein Feature deaktiviert, welches auf dem Desktop typischerweise 20-40% Performance bringen kann und in einzelnen Benchmarks durchaus auch einmal die Performance zu verdoppeln mag.

Es ist sicher nicht zu erwarten, das andere Betriebssystem-Hersteller ähnlich vorgehen werden – je größer die entsprechenden Unternehmen sind, um so weniger wird man es sich mit Intel verscherzen wollen. Aber das ganze zeigt an, wie tiefgehend die durch Meltdown & Spectre sowie Spectre "Next Generation" hervorgerufenen Probleme sind – wenn am Ende so wichtige Performance-Features wie HyperThreading nur noch deaktiviert werden können. Einzurechnen ist hierbei auch der Punkt, das ab einer gewissen (verlustig gehenden) Performancehöhe die CPU-Hersteller nicht mehr mitspielen können und ihre Produkte auf Gedeih und Verderb verteidigen müssen. Im konkreten wird man dann versuchen, das ganze möglichst auszusitzen und zwischenzeitlich durch größtmögliche Nichtbeachtung medial nicht zu groß werden zu lassen – wie ja jetzt schon teilweise zu beobachten. Wenn beispielsweise jemand von Intel fordern würde, in aktuellen Prozessoren einfach mal die spekulative Befehlsausführung komplett abzuschalten, dann würden jene bis zu 90% (!) an Performance einbüßen. Es sieht somit immer mehr danach aus, als müsste die Hardware-Welt für die nächste Zeit mit diesem gewissen Restrisiko leben lernen – während die CPU-Entwickler wohl erst mit echten CPU-Neuentwicklungen diese Problematik wirklich grundsätzlich angehen können.