Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 21. November 2019

Seitens Twitterer Kopite7Kimi kommt eine derzeit vielbeachtete Meldung zur Hardware der GeForce RTX 2080 Ti "SUPER" – wobei jener Twitter-User erst kürzlich genau diese weitere "SUPER"-Karte vermutet hatte anläßlich der angeblichen Streichung des GA101-Chips der Ampere-Generation. Laut Kopite7Kimi soll die GeForce RTX 2080 Ti "SUPER" mit den vollen 4608 Shader-Einheiten des zugrundeliegenden TU102-Chips samt auf 4000 MHz QDR laufendem GDDR6-Speicher antreten – was natürlich trotzdem noch einige Fragen offenläßt. So könnte nVidia beim Speicherinterface bei den bisherigen 352 Bit bleiben oder auch die vollen 384 Bit des TU102-Chips benutzen, was dann auch eine kleine Differenz bei der Speichermenge ergibt (11 oder 12 GB). Die Verwendung von schnellerem GDDR6-Speicher deutet allerdings eher darauf hin, das es beim bisherigen Speicherinterface bleibt – was von Vorteil wäre für bestehende Platinen-Designs mit nur 11 Speicherplätzen (obwohl die meisten 2080Ti-Platinen wohl 12 Speicherplätz aufweisen, von denen einer schlicht unbestückt ist). Anhand der konkreten Taktraten läßt sich dann auch noch ein gewisser Performance-Unterschied erzeugen, gerade mit der inzwischen ausgreiften Fertigung des TU102-Chips. Viel wichtiger dürfte allerdings das Power-Limit sein, hieran kann nVidia die der GeForce RTX 2080 Ti "SUPER" mitgegebene Performance sehr exakt regeln.

2080TI SUPER 4608 16Gbps

Quelle: Kopite7Kimi @ Twitter am 19. November 2019

Wegen der fehlenden Angaben zum Speicherinterface, Chiptakt und Power-Limit kann die Performance dieser GeForce RTX 2080 Ti "SUPER" derzeit nur grob auf ~250-270% im UltraHD Performance-Index geschätzt werden – was aber dennoch zumindest dazu ausreichen dürfte, um auch noch die Titan RTX bei der reinen Performance zu erreichen bzw. eventuell sogar leicht zu überflügeln. Wie weit es darüber hinausgeht, hängt dann primär am Power-Limit – denn sofern nVidia an dieser Stelle aufdrehen sollte, wäre auch ein beachtbarer Performance-Sprung drin. Besonders wahrscheinlich ist dies allerdings nicht, denn für nVidia geht es bei einer solchen GeForce RTX 2080 Ti "SUPER" eigentlich um nichts: Es gibt in diesem Marktsegment keinen Wettbewerb, ergo muß nVidia eigentlich auch nicht nachlegen. Selbst die neue GeForce GTX 2080 Super kann diese TU102-basierten Karten nicht wirklich unter Druck setzen, dafür fehlt der kleineren Karte die ausreichene Menge an Grafikkartenspeicher. Insofern ist weiterhin das Erscheinen einer GeForce RTX 2080 Ti "SUPER" grundsätzlich in Frage zu stellen. Selbst in Bezug auf die nachfolgende Ampere-Generation macht jene keinen großen Sinn: Je höher nVidia derzeit die Performance-Latte bei der Turing-Generation setzt, um so kleiner sieht nachfolgend der Performance-Gewinn von Ampere aus.

| GeForce RTX 2080 Super | GeForce RTX 2080 Ti | GeForce RTX 2080 Ti Super | Titan RTX | |

|---|---|---|---|---|

| Chipbasis | nVidia TU104 | nVidia TU102 | nVidia TU102 | nVidia TU102 |

| Technik | 6 Raster-Engines, 48 Shader-Cluster, 3072 Shader-Einheiten, 192 TMUs, 48 RT-Cores, 384 Tensor-Cores, 64 ROPs, 4 MB Level2-Cache, 256 Bit GDDR6-Interface (Vollausbau) | 6 Raster-Engines, 68 Shader-Cluster, 4352 Shader-Einheiten, 272 TMUs, 68 RT-Cores, 544 Tensor-Cores, 88 ROPs, 5.5 MB Level2-Cache, 352 Bit GDDR6-Interface (Salvage) | 6 Raster-Engines, 72 Shader-Cluster, 4608 Shader-Einheiten, 288 TMUs, 72 RT-Cores, 576 Tensor-Cores .... ROPs, Level2-Cache & Speicherinterface noch unbekannt | 6 Raster-Engines, 72 Shader-Cluster, 4608 Shader-Einheiten, 288 TMUs, 72 RT-Cores, 576 Tensor-Cores, 96 ROPs, 6 MB Level2-Cache, 384 Bit GDDR6-Interface (Vollausbau) |

| Taktraten | 1650/1815/3875 MHz (QDR) | Ref: 1350/1545/3500 MHz (QDR) FE: 1350/1635/3500 MHz (QDR) |

?/?/4000 MHz (QDR) | 1350/1770/3500 MHz (QDR) |

| Speicherausbau | 8 GB GDDR6 | 11 GB GDDR6 | ? | 24 GB GDDR6 |

| TDP (GCP) | 250W | Ref: 250W FE: 260W | ? | 280W |

| 4K Perf.Index | 198% | Ref: 228% FE: 236% | geschätzt ~250-270% | ~257% |

| Listenpreis | 699$ | Ref: 999$ FE: 1199$ | ? | 2499$ |

| Release | 23. Juli 2019 | 19. September 2018 | angeblich Anfang 2020 | 3. Dezember 2018 |

Twitterer Apisak macht hingegen auf ein erstes Geekbench-5-Ergebnis von Tiger Lake Y aufmerksam – sprich, der LowPower-Ausführung von Tiger Lake für den Einsatz in Tablets & Mini-Notebooks mit TDPs von gewöhnlich nur 5-7 Watt. Jenes Ergebnis ist in der Höhe (angesichts eines CPU-Takts von angeblich nur 400/1200 MHz) nicht zu werten, die derzeitigen Y-Chips aus der Coffee-Lake-basierten "Amber Lake" Generation schaffen schon bedeutsam mehr. Interessant sind hierbei eher die ausgewiesenen Cache-Mengen, welche unser Forum notiert: Satte 1,25 MB Level2-Cache pro CPU-Kern samt 12 MB Level3-Cache (für vier CPU-Kerne) bei diesem Tiger-Lake-Sample. Letzteres entspricht einer früheren Meldung von 3 MB Level3-Cache pro CPU-Kern bei Tiger Lake – insofern scheinen diese Angaben sogar korrekt zu sein. Dies würde dann allerdings einen drastischen Anwachs von Level2-Cache bei Tiger Lake ergeben – und zwar nicht bei irgendwelchen Server-Modellen, sondern generell bzw. hier augenscheinlich selbst bei den allerkleinsten CPU-Modellen (in der Y-Ausführung).

| L1 Daten | L1 Instr. | L2-Cache | L3-Cache | |

|---|---|---|---|---|

| Skylake bis Comet Lake | 32 kByte | 32 kByte | 256 kByte (inkl.) | 2 MByte (inkl.) |

| Skylake-SP/X (inkl. Cascade Lake) | 32 kByte | 32 kByte | 1024 kByte (inkl.) | 1408 kByte (exkl.) |

| Ice Lake | 32 kByte | 48 kByte | 512 kByte (inkl.) | 2 MByte |

| Tiger Lake | 48 kByte | 32 kByte | 1280 kByte | 3 MByte |

| AMD Zen/Zen+ | 32 kByte | 64 kByte | 512 kByte (inkl.) | 2 MByte (exkl.) |

| AMD Zen 2 | 32 kByte | 32 kByte | 512 kByte (inkl.) | 4 MByte (exkl.) |

| Alle Angaben immer pro CPU-Kern. | ||||

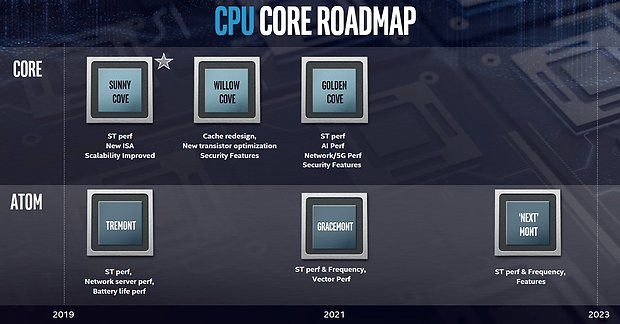

Zudem werden der Level1-Datencache mit 48 kByte sowie der Level2-Instruktionencache mit 32 kByte genannt – eine glatte Umkehrung der Verhältnisse von Ice Lake. Ob dies vielleicht einen Auslesefehler darstellt, wird sich noch klären – in der Summe entsprechen diese vielen Änderungen an den CPU-Caches von Tiger Lake aber vor allem dem, was Intel mittels früherer Roadmaps für die "Willow Cove" CPU-Kerne versprochen hatte ("Cache redesign"). Damit läßt sich somit bestätigen, das "Willow Cove" demzufolge "Tiger Lake" zuzuordnen ist – und die in der Intel-Roadmap angezeigten nachfolgenden "Golden Cove" CPU-Kerne zu einer späteren CPU-Generation gehören werden (wahrscheinlich "Alder Lake"). Damit klärt sich auch, zu wem der für die "Golden Cove" CPU-Kerne anzunehmende größere Performance-Sprung zuzuordnen ist – eben nicht mehr für Tiger Lake, sondern für dessen Nachfolger. Tiger Lake wird demzufolge eher so etwas wie einen Refresh zu Ice Lake darstellen, sicherlich mit Verbesserungen, aber grundsätzlich nicht als großer Wurf geplant. Diese Bezeichnung kann man zu "Ice Lake" durchaus (angesichts hoher IPC-Gewinne) verwenden – und ähnliches will Intel dann augenscheinlich wiederum beim Tiger-Lake-Nachfolger unter Verwendung der "Golden Cove" CPU-Kerne erreichen.

Die gestrige Meldung zur Programmierbibliothek "Math Kernel Library" bzw. den AMD-Nachteilen in selbiger wurde teilweise als "AMD-Bashing" falsch verstanden (bzw. demzufolge ungenügend klar dargelegt). Natürlich ist es richtig, das Intel hierbei der eigentlich Schuldige ist – aber dies hätte AMD eigenaktiv herausarbeiten können sollen, anstatt auf ein User-Posting bei Reddit zu warten, was jetzt in der Enthusiasten-Szene für ein wenig Aufregung sorgt, ansonsten aber doch eher untergeht. Die Kritik von AMD an dieser Stelle war also konstruktiv gemeint – und soll AMD zum Nachdenken darüber anregen, sich mehr dieser Thematik zu widmen. Es ist schließlich unwahrscheinlich, das nicht noch weitere solche faulen Eier in den Tiefen der Hardware- und Software-Landschaft lauern – wo man mit vergleichsweise wenig Aufwand zum einen ein Problem lösen und zum anderen medial so richtig auf die Pauke hauen kann. Das ganze war eine faktische Aufforderung an AMD, hierbei aggressiv voranzugehen – weil doch spätestens jetzt im dritten Ryzen-Jahr klar ist, das gute Hardware allein nicht den Markt bestimmen kann, sondern selbiger sich nur extrem zäh bewegt. Und gerade deswegen, weil Hardware-Entwicklung wie -Herstellung eine extrem kapitalintensive Angelegenheit ist, darf man sich dabei solcherart kostengünstigen Gelegenheiten nicht entgehen lassen. Denn die eigentliche Kritik muß natürlich über Intel ausgeschüttet werden – aber jene kommt um so besser, wenn sie von AMD selber, in konzentrierter Form und auch gleich zusammen mit ersten Lösungen vorgetragen wird.