Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 23./24. November 2020

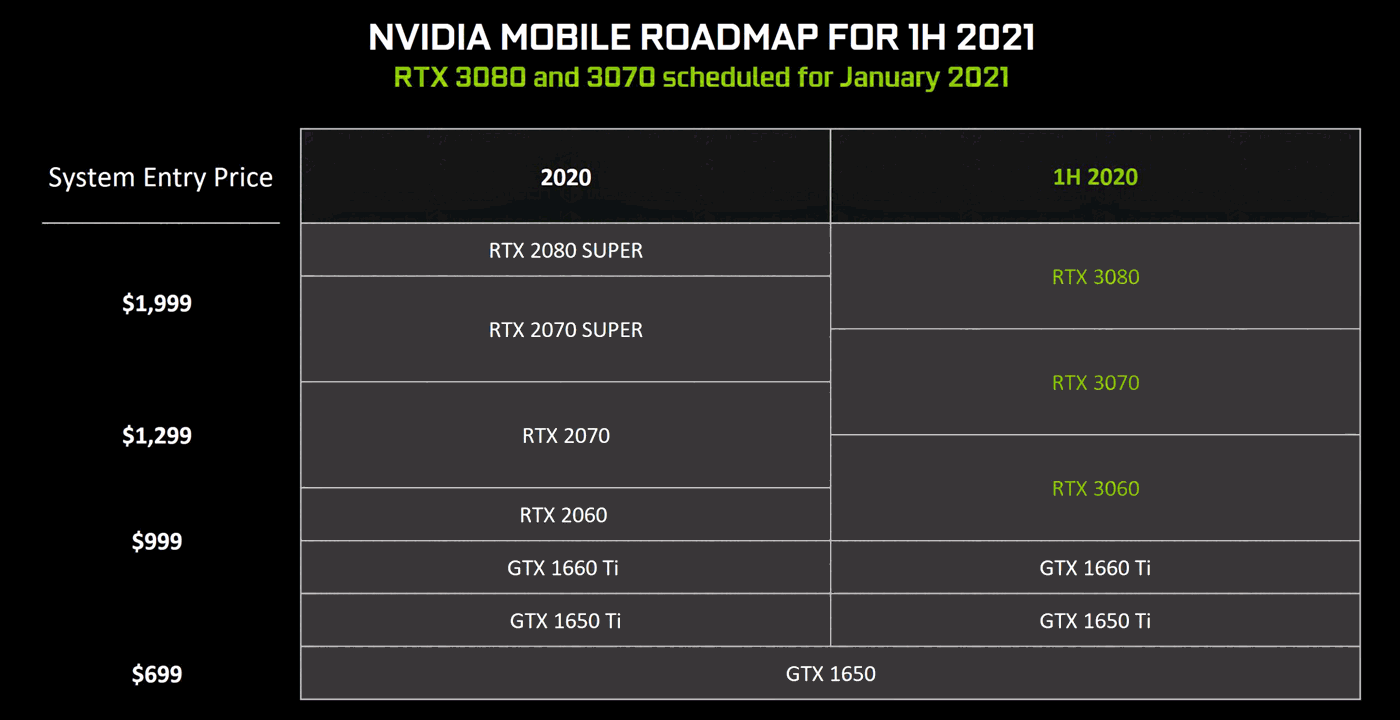

WCCF Tech zeigen nVidia-Unterlagen zu den Mobile-GPU-Plänen für 2021, sprich die Umsetzung der GeForce RTX 30 Serie für Notebooks. Selbige wird im ersten Halbjahr 2021 erst einmal mit GeForce RTX 3060, 3070 & 3080 Mobile starten, die kleineren 30er Mobile-Lösungen treten somit erst im zweiten Halbjahr an. Zu GeForce RTX 3070 & 3080 Mobile hat nVidia sogar schon den Starttermin "Januar 2021" genannt – was wohl den Vorstellungstermin meinen dürfte, kaufbare Notebooks mit diesen Grafiklösungen wären dann im folgenden Frühjahr zu erwarten. Zur Technik dieser Mobile-Lösungen gibt es noch keine Informationen – was auch bedeutet, dass nach wie vor unklar ist, inwiefern diese Mobile-Grafiklösungen zumindest grundsätzlich ihren Desktop-Pendants entsprechen. Im Fall der "GeForce RTX 3080 Mobile" würde dies schließlich die Verwendung des dicken GA102-Chips im Mobile-Bereich bedeuten, was nVidia vergleichsweise innerhalb der vorherigenden Turing-Generation zumindest für GeForce-Lösungen noch vermieden hatte.

Dass nVidia für jene "GeForce RTX 3080 Mobile" gemäß einer weiteren Folie nur GDDR6-Speicher (und nicht den GDDR6X-Speicher der Desktop-Ausführung) ansetzt, zeigt zumindest gewisse Differenzen an – läßt aber dennoch noch alle Möglichkeiten offen, selbiger Speicher wird sicherlich auch an einem GP102-Chip funktionieren. GDDR6X-Speicher dürfte aufgrund seiner Temperatur-Entwicklung sowieso nichts für Notebook-Designs sein, an dieser Stelle dürfte man sowieso zu einer gewissen Veränderung gegenüber dem Desktop-Standard gezwungen sein. Da der Energieeffizienz-Gewinn der Ampere-Generation auf gleicher Anzahl an Shader-Clustern bei ca. +32% liegt (Vergleich von GeForce RTX 3070 und GeForce RTX 2080), könnte nVidia aus reiner Stromverbrauchs-Sicht heraus durchaus dickere Hardware ins Mobile-Feld schicken als innerhalb der Turing-Generation, wo im GeForce-Feld mit dem TU104-Chip (maximal 48 Shader-Cluster) Schluß war. Da innerhalb der Ampere-Generation aber auch der GA104-Chip wiederum bei 48 Shader-Clustern endet, würde ein echtes "Mehr" an Hardware dann tatsächlich zum GA102-Chip zwingen (oder alternativ zum GA103-Chip, sofern jener rechtzeitig hierfür fertig wird).

Heise und ExtremeTech beschäftigen sich mit einer Intel-Präsentation (in kompletter Form bei WCCF Tech zu sehen), welche letzten Freitag an diverse Journalisten und Analysten herausgegeben wurde. Mittels jener Präsentation versucht Intel auf eine erhebliche Performance-Differenz zugunsten der eigenen Notebook-Prozessoren im Batterie-Betrieb hinzuweisen: Konkret sollen die AMD-Prozessoren im Batterie-Betrieb bis zu −38% Performance gegenüber dem Steckdose-Betrieb verlieren, die Intel-Prozessoren hingegen nur im Rahmen weniger Prozentpunkte. Ob der PCMark10 dafür überhaupt ein geeigneter Test ist, sei allerdings dahinzustellen – denn im gewöhnlichen ist es schwierig, hiermit überhaupt größere Performance-Differenzen unter Verwendung anderer Prozessoren zu erreichen, der Effekt anderer Systemkomponenten ist in diesem Benchmark viel zu stark.

Allerdings geht die Kritik von Heise & ExtremeTech sowieso in eine ganz andere Richtung: Letztlich ist hierbei nur das Wirken anderer Stromsparsettings zu sehen, welche auf den getesteten AMD-Notebooks den Boost im Batteriebetrieb eher zurückgestellt haben, damit nicht jede kurzfristige Last zu einem Hochboosten (und demzufolge Anziehen der Lüfter) führt. Auf den benutzten Intel-Geräten war dies anders geregelt, jene zogen umgehend bei Last den Boost nach oben, womit insbesondere kurzfristig laufende Benchmarks erhebliche Performance-Differenzen zeigten. Im Endeffekt hat Intel hierbei verschiedene Stromsparsettings getestet und sich den (vermeintlich) positiven Effekt eines sehr boostfreudigen Settings dann selber zugeschrieben. Ein AMD-Notebook unter demselben Setting würde allerdings ähnliche Ergebnisse bringen, die von ExtremeTech hierzu angestellten Benchmarks zeigen für beide Prozessoren einen erheblichen Performance-Verlust im Batterie-Betrieb (AMD sogar mit tendentiell geringem Performance-Verlust).

Mit der konkreten Ausführung dieser Benchmarks hat sich Intel (mal wieder) in ein Fettnäpfchen gestürzt, allerdings ist ein Teilaspekt dennoch diskussionswürdig: Für die allermeisten Notebook-Nutzer dürfte die Performance in kurzen Spitzen wichtiger sein als jene unter länger laufenden Benchmarks – gerade im Batterie-Betrieb. Um zu dieser Frage interessante Ergebnisse zu liefern, müsste man zuerst eruieren, wie sich beide Systeme unter gleichen Stromsparsettings unter kurzfristig laufenden Benchmarks verhalten – sprich ob Intel unter gleichen Stromsparsettings immer noch einen Vorteil hat. Gleichfalls müsste dann aber die Frage thematisiert werden, wie gut Office-Benchmarks hierfür als Performance-Vergleich geeignet sind – denn meistens arbeiten die dann umfangreiche Makroscript-Aufgaben ab, welche dennoch im Sekunden-Bereich erledigt sind. Für den Normalnutzer eher interessant wären an dieser Stelle Benchmarks mit echten Alltagsaufgaben: Starten von Office, Starten eines Browsers, Laden einer umfangreichen Webseite. Hierzu müsste Intel Vorteile derart sichtbar machen, auf dass es auch jeder Anwender ohne größere Erklärungen versteht – und natürlich ohne dass es die Fachpresse umgehend zerpflückt.