Hauptlinks

Suchen

News des 26. September 2022

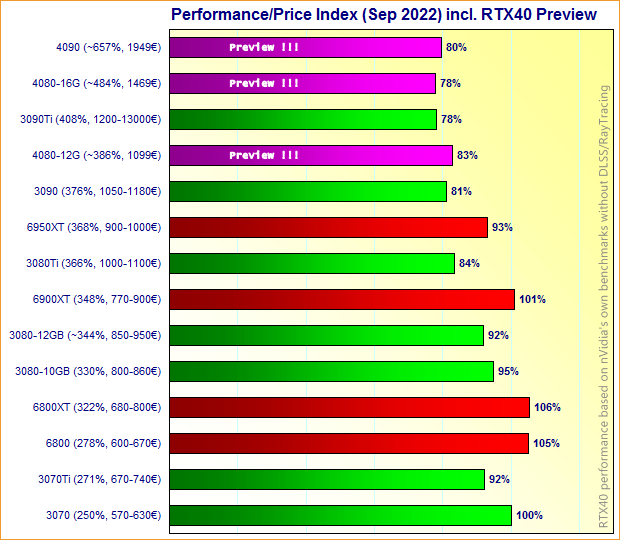

Der aktuelle Grafikkarten-Marktüberblick enthält auch schon einen Preis/Leistungs-Ausblick auf GeForce RTX 4080 & 4090, basierend auf nVidias (wenigen) eigenen Benchmarks ohne DLSS und RayTracing, ausgewertet seitens Twitterer SkyJuice. Die Datenlage ist natürlich dünn, aber dennoch ist das herauskommende Ergebnis bemerkenswert: Denn nVidia müsste mit den Launchreviews schon deutlich oberhalb seiner eigenen Benchmark-Resultate herauskommen, um mittels der Ada-Lovelace-Generation (zumindest für die drei vorgestellten Modelle) ein besseres Preis/Leistungs-Verhältnis als die vorhandenen Karten im Markt bieten zu können. Dass die GeForce RTX 4090 kein Preis/Leistungs-Sieger werden würde, ist angesichts deren Preislage erwartbar – aber dass nVidia bis hinunter zur getarnten GeForce RTX 4070 (der offiziellen "GeForce RTX 4080 12GB") kein besseres Preis/Leistungs-Verhältnis anbieten kann, wäre für eine neue Grafikkarten-Generation unerhört schlecht.

| AMD RDNA2 | nVidia Ampere | nVidia Ada | |

|---|---|---|---|

| ~2000€ | GeForce RTX 4090 1949€ — Perf/Preis: (geschätzt) ~80% |

||

| ~1500€ | GeForce RTX 4080 16GB 1469€ — Perf/Preis: (geschätzt) ~78% |

||

| ~1200€ | GeForce RTX 3090 Ti 1200-1300€ — Perf/Preis: 78% |

||

| ~1100€ | GeForce RTX 3090 1050-1180€ — Perf/Preis: 81% |

GeForce RTX 4080 12GB 1099€ — Perf/Preis: (geschätzt) ~83% |

|

| ~1000€ | GeForce RTX 3080 Ti 1000-1100€ — Perf/Preis: 84% |

||

| ~900€ | Radeon RX 6950 XT 900-1000€ — Perf/Preis: 93% |

GeForce RTX 3080 12GB 850-950€ — Perf/Preis: 92% |

|

| ~800€ | Radeon RX 6900 XT 770-900€ — Perf/Preis: 101% |

GeForce RTX 3080 10GB 800-860€ — Perf/Preis: 95% |

|

| ~700€ | Radeon RX 6800 XT 680-700€ — Perf/Preis: 106% |

GeForce RTX 3070 Ti 670-740€ — Perf/Preis: 92% |

|

| ~600€ | Radeon RX 6800 600-670€ — Perf/Preis: 105% |

GeForce RTX 3070 570-630€ — Perf/Preis: 100% |

|

| Performance/Preis-Kalkulation von GeForce RTX 40 gemäß den von SkyJuice aus der offiziellen nVidia-Präsentation gezogenen Performance-Werten | |||

Und dies ist dann auch keine Frage des hohen Preispunkts, denn neue Grafikkarten-Generationen sollten (normalerweise) immer ein besseres Preis/Leistungs-Verhältnis bieten. Nur die Turing-Generation war diesbezüglich "auffällig". erreichte ein wirklich besseres Preis/Leistungs-Verhältnis faktisch erst mit dem späteren "SUPER"-Refresh. Dabei zeigt der Vergleich bis hinunter zur GeForce RTX 3070 (als Index-Anker auf 100% festgesetzt) an, dass dies auch keine Frage der aktuellen Abverkaufspreise zu GeForce RTX 3080 Ti und größer ist: Die RTX40-Karten dürften auch gegenüber den Ampere-Modelle ohne aktuelle Abverkaufspreise das sogar schlechtere Preis/Leistungs-Verhältnis aufweisen. Sollten sich diese nVidia-eigenen Benchmarks nicht noch als komplett Nonsens erweisen oder andere Effekte den insgesamten Wert der Ada-Lovelace-Generation steigern, wird es schwer werden für nVidias neue Grafikkarten.

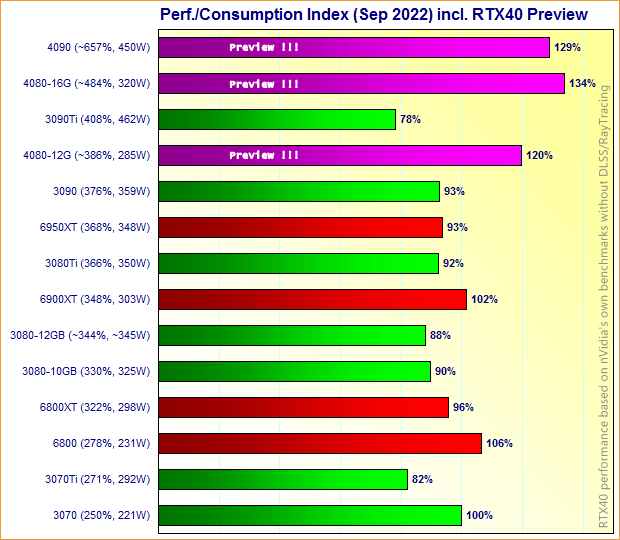

Dies läßt sich genauso schon in diesbezüglich erweiterten Marktüberblicks-Diagrammen ausdrücken – was für GeForce RTX 4080 & 4090 natürlich auch nur auf denselben unvollkommene Zahlen basiert und daher keineswegs belastbare Aussagen (sondern halt nur eine fehlbare Vorschau) darstellt. Denn logischerweise gilt es zwingend die entsprechenden Launchreviews abzuwarten, denn die GeForce RTX 40 Serie hat durchaus noch einige Pfeile im Köcher: DLSS3 sieht vielversprechend aus, zudem könnte die RayTracing-Performance eine deutlich höhere Steigerung als die Rasterizer-Performance erfahren haben. Daneben zeigt die Hochrechnung wenigstens beim Verhältnis Performance zu Stromverbrauch an, dass hier tatsächlich eine neue Generation arbeitet: Die GeForce RTX 4080 12GB bringt die Performance von grob der GeForce RTX 3090 zu 285W TDP daher, die GeForce RTX 4080 16GB eine bessere Performance als die GeForce RTX 3090 Ti zu 320W TDP.

Jene Preis/Leistungs-Vorschau auf GeForce RTX 4080 & 4090 bedeutet natürlich mitnichten, dass die komplette Ada/RDNA3-Generation derart "ungünstig" daherkommen muß. nVidia könnte bei den kleineren Ada-Modellen dann bessere Preis/Leistungs-Verhältnisse bieten, wie es bei kleineren Modellen derselben Produkt-Generation absolut üblich ist. AMD könnte generell mit den besseren Preis/Leistungs-Verhältnissen anrücken bzw. könnte angesichts der nVidia-Vorgabe die Chance auf klar höhere Marktanteile sehen: Man kann diese Preis/Leistungs-Verhältnisse bei GeForce RTX 4080 & 4090 schließlich recht einfach unterbieten, da bleibt viel Spielraum für AMD sowohl zugunsten von Marktanteil als auch Gewinnmarge. Allerdings dürfte der preisliche AMD-Ansatz immer durch den Punkt limitiert sein, dass AMD nicht unbegrenzt liefern kann. Preis/Leistungs-Verhältnisse bei RDNA3, welche "Ada Lovelace" regelrecht aus dem Spiel nehmen würden, sind somit ebenfalls kaum zu erwarten.

Schon Anfang des Monats hatte Twitterer Kitty YYuko einen Hinweis darauf gegeben, dass nVidias AD103-Chip nicht mit allen Shader-Clustern operieren kann, welche eigentlich geplant waren. Seinerzeit konnte jener Hinweis natürlich noch nicht verstanden werden, aber nunmehr mit den offiziell nur 80 Shader-Clustern beim AD103-Chip ergibt dies durchaus seinen Sinn: Sicherlich war der AD103-Chip mit 84 Shader-Clustern geplant, weil nur dies zu den bekannt 7 Raster-Engines passt (7x12=84). Dass nVidia nun selbst im eigenen Whitepaper auf 80 Shader-Cluster besteht, klingt erst einmal nach einem Fehler, könnte sich nun aber schlicht als technisches Problem mit dem AD103-Chip herausstellen. Demzufolge ist nVidia gezwungen, grundsätzlich mit weniger Shader-Clustern anzutreten als jenen 84 physikalisch sicherlich vorhandenen.

I heard that AD103 encountered some issues before, which cause cannot enable all SM units.

Quelle: Kitty YYuko @ Twitter am 2. September 2022

Somit kann selbst ein Vollausbau des AD103-Chips nur 80 Shader-Cluster benutzen, die restlichen 4 müssen wegen dem (nicht genauer benannten) technischen Problem abgeschaltet bleiben. Dies ist eine denkbare Auflösung der Situation, dass nVidia den AD103-Chip mit nur 80 Shader-Clustern beschreibt, obwohl jener sicherlich mit 84 Shader-Clustern designt wurde und auch so zum Tape-Out gegangen sein dürfte. Zugleich eröffnet dies sicherlich die Seitenchance, dass nVidia mit einer zukünftigen Chip-Revision den Fehler in der Hardware fixen kann und somit mittels eines beispielsweise "AD103B" genannten Chips doch wieder auf 84 Shader-Cluster kommt. Dies erfordert jedoch wenigstens ein neues Chip-Stepping, eventuell sogar einen neuen Tape-Out – sprich, würde im Fall des Falles erst tief im Jahr 2023 wirksam werden können.