Hauptlinks

Suchen

News des 27. Oktober 2025

Tom's Hardware weisen mit einem Goodbye-Artikel zur GeForce GTX 1080 Ti auf das im November anstehende Supportende für Maxwell- und Pascal-basierte nVidia-Grafikkarten hin. Hierzu hat man jenes 2017er Spitzenmodell in den aktuellen Benchmark-Parcours gegen entsprechend aktuelle Grafikkarten geschickt – mit dem Resultat, dass die GeForce GTX 1080 Ti inzwischen ganz schön nach unten durchgereicht wurde, wirklich konstant eigentlich nur vor der GeForce GTX 3050 herauskommt. Aber selbst Mainstream-Modelle wie Arc B570, Radeon RX 7600 und GeForce RTX 4060 setzen der GeForce GTX 1080 Ti schon einigermaßen zu, liegen unter der FullHD-Auflösung (leicht) in Front. Unter der 4K-Auflösung drehen sich die Verhältnisse dann um, dies dürfte aber primär an den nur 8 GB Grafikkartenspeicher der Vergleichslösungen hängen, wohingegen die GeForce GTX 1080 Ti immerhin ihre 11 GB VRAM ins Feld führen kann. Dennoch scheint auch dieses Pascal-Spitzenmodell unter der 4K-Auflösung ihre ursprüngliche Performance nicht ganz ausfahren zu können, liegt eine GeForce RTX 4060 Ti 16GB unter aktuellen Benchmarks (+70%) klar besser als im 3DC 4K Performance-Index (+39%).

| FullHD/1080p | 4K/2160p | 3DC FHD-Index | 3DC 4K-Index | |

|---|---|---|---|---|

| GeForce RTX 4060 Ti 16GB (2023) | 157,6% | 169,5% | 1750% (+48%) | ~240% (+39%) |

| GeForce RTX 4060 (2023) | 122,8% | - | 1390% (+18%) | - |

| Radeon RX 7600 (2023) | 110,4% | - | 1330% (+13%) | - |

| Arc B570 (2025) | 108,2% | - | 1250% (+6%) | - |

| GeForce GTX 1080 Ti (2017) | 100% | 100% | 1180% | 173% |

| gemäß der Benchmarks von Tom's Hardware unter 11 Spiele-Titeln | ||||

Eine andere mögliche Erklärung für diese Diskrepanz könnte in neueren Spieletiteln liegen, welche eher nur für neuere Grafik-Architekturen optimiert werden. Diese Tendenz ist bei vielen neuen Spielen zu sehen, wenn da teilweise nur noch die allerneuesten Grafik-Architekturen wirklich gut laufen und ältere Architekturen manchmal erstaunlich weit zurückhängen. Teilweise mag dies an fehlender Optimierung hängen, teilweise aber auch an neueren Features, welche die Spieleentwickler dann erst mit der Zeit ausgenutzt haben und somit erst bei diesen sehr übergreifenden Benchmarks offensichtlich werden. Hier offenbart sich eine gewisse Schwäche des 3DCenter Performance-Index: Jener kann wegen seiner fliegenden Erstellung die tatsächliche Skalierung der Grafikkarten-Generationen nur zum Teil wiedergeben, was dann in der Summe mehrerer Grafikkarten-Generationen durchaus mal zu einem klar niedrigeren Skalierungsergebnis führt als eigentlich real ist. Dies läßt sich aber natürlich für den Index auch nicht anders realisieren, denn Tests von neuer zu ganz alter Hardware passieren viel zu selten, um solcherart Ergebnisse noch mit in den Index einfließen lassen zu können.

Bei dieser Gelegenheit kann gleich einmal die Treiber-Situation bei Windows 10 thematisiert werden, denn mittels der Einstellung des Treiber-Supports zu Maxwell- und Pascal-Hardware hatte nVidia gleiches auch zu Windows 10 bekanntgegeben. Selbiges findet dann zwar allerdings erst in Jahresfrist statt, ist aber dennoch eine sehr kurze wie unnötig limitierende Zeitspanne, immerhin wird Windows 10 über seine LTSC-Versionen bis Anfang 2032 mit Sicherheitsupdates versorgt und sind die Treiber-Dateien für Windows 10 & 11 eigentlich bei allen Herstellern immer gleich. nVidias schnelles Ende von Game-Ready-Treibern für Windows 10 ist somit eine unnatürliche Beschränkung, welche der Grafikchip-Entwickler besser noch einmal überdenken sollte. Es wäre sowieso zu prüfen, wieso man an dieser Stelle unbedingt einen Schnellschuß machen musste, immerhin gibt es auch noch das 3jährige ESU-Programm für Unternehmen und lehrt die Erfahrung von Windows 7, dass jenes Betriebssystem noch lange mit beachtbarem Nutzeranteil mitlief bzw. dass dessen ESU-Programm von ursprünglich geplant 3 Jahren dann auf fast 5 Jahre ausgedehnt wurde.

| Windows 10 | Spiele-bezogene Treiber | reine Sicherheitsupdates |

|---|---|---|

| Microsoft | – | mit LTSC-Versionen bis Januar 2032 |

| AMD (Grafik) | noch keine Pläne bekannt | |

| nVidia | bis Oktober 2026 | voraussichtlich bis Oktober 2029 |

| Intel (Grafik) | noch keine Pläne bekannt | |

VideoCardz berichten über den Shunt-Mod einer GeForce RTX 4090 Laptop durch Redditor Thatavidreadertrue, in deren Folge jene Mobile-Grafiklösung die Performance einer GeForce RTX 5090 Laptop sogar leicht überbot. Gemittelt lag der Performance-Gewinn durch diese Hardware-Modifizierung bei +19,2%, die GeForce RTX 5090 Laptop wurde damit um +3,5% geschlagen. Der Mod bestand dabei schlicht in einem zusätzlich eingelötetem Widerstand, was die GPU-Steuerung eine 6fach niedrigere Stromaufnahme annehmen ließ und somit die GeForce RTX 4090 Laptop augenscheinlich voll ausfuhr. An der Grafik-Kühlung wurde bis auf ein Repasting der GPU-Wärmeleitpaste nichts verändert, auch das Laptop-Netzteil konnte die deutlich höhere Anforderung (bis zu 240W GPU-Power) augenscheinlich verdauen. Denkbarerweise läuft diese Mobile-Grafiklösung dann sowieso in thermische oder Taktraten-Limits hinein, kommt dadurch nicht in die Nähe einer Absturzgefahr – wie es bei unzureichender Kühlung oder/und Stromzufuhr passieren könnte. Generell ist jener Mod eher unter dem Gesichtspunkt einer Machbarkeits-Studie interessant, für den Praxisgebrauch aber nicht zu empfehlen: Denn +19% Mehrperformance sind sicherlich nicht ausreichend, um auf die Garantie eines mehrere tausend Dollar/Euro kostenden Notebooks zu verzichten.

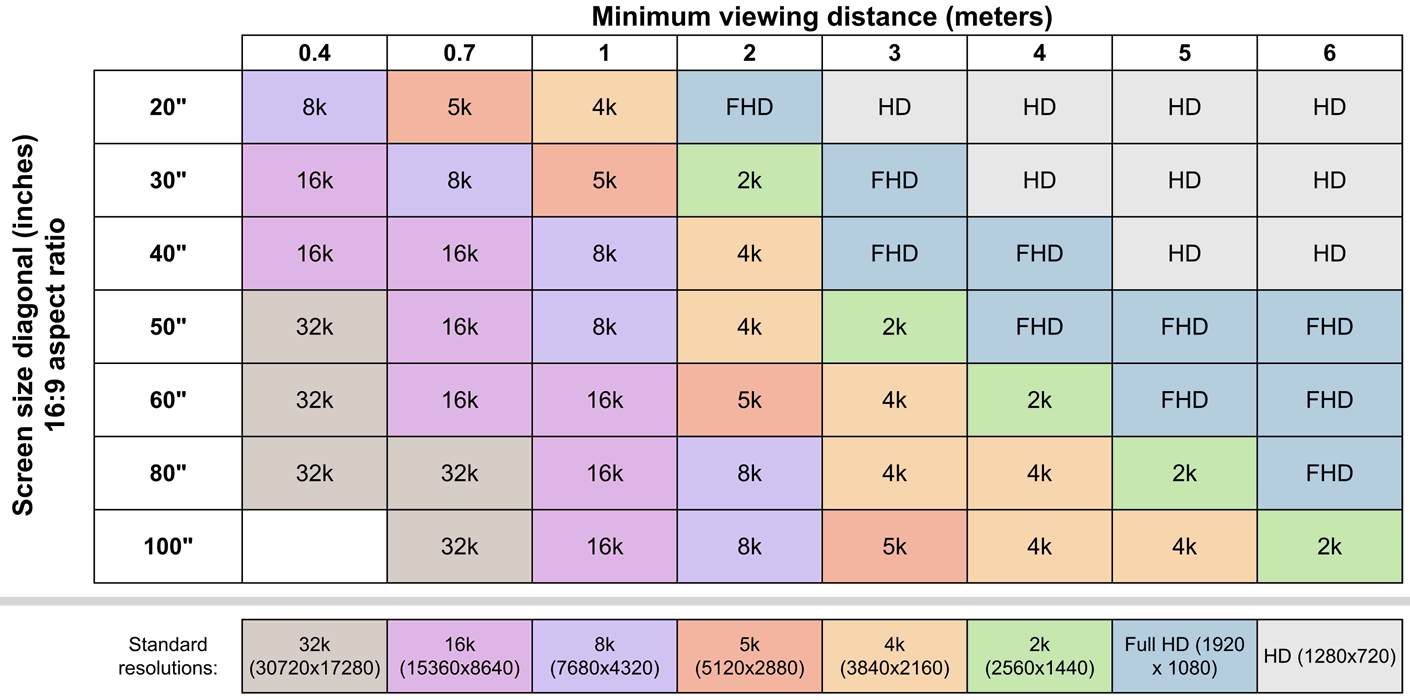

Sciness berichten über eine Studie der 'University of Cambridge', wonach der menschliche Sehsinn insbesondere bei Farben weitaus schwächer als bei schwarz/weiss-Bildern ist und demzufolge sich 8K-Fernseher zumeist nicht lohnen sollen. Dies ist natürlich immer auch eine Frage des jeweiligen Gerätetyps und damit des Betrachterabstand: Bei sehr großen Computer-Displays (ab 30 Zoll) auf einem Schreibtisch-üblichen Betrachterabstand ergibt sich in der Tat noch ein Zweck für die 8K-Auflösung. Bei einem 80 Zoll großen TV-Gerät müsste man den Betrachterabstand hingegen auf unter 3 Meter reduzieren, um überhaupt einen (gewissen) Unterschied zu einem 4K-Gerät zu erlangen. Hierzu bietet die Universität auch einen Online-Kalkulator an, allerdings ist das in diesem Rahmen veröffentlichte Beispiel-Diagramm schon aussagekräftig genug. 8K-Fernseher werden sich wahrscheinlich doch eines Tages durchsetzen – allerdings ist danach dann wirklich Schicht im Schacht, noch feinere Displays haben zumindest im Massenmarkt einfach keine Anwendungsmöglichkeiten.