Hauptlinks

Suchen

Performancereport

Performancereport Windows XP gegen Vista, Teil 2

Performancereport Windows XP gegen Vista, Teil 2

Windows XP oder Windows Vista? – Wer stand nicht selbst schon vor dieser Frage. Nach mehrmonatiger Reifezeit steht Vista nun auch bei uns auf dem Prüfstand. Für viele User ist die Entscheidungsfrage eher darauf gestützt, wie gut man sich mit dem „Look and Feel“ von Vista anfreunden kann. Für einen gar nicht so kleinen Anwenderkreis ist aber auch die Performance ausschlaggebend. Verschiedene Tests widersprechen sich und stiften Verwirrung. Nun sind wir an der Reihe, Verwirrung zu stiften oder sogar ein paar neue Klarheiten zu finden.

Performancereport Windows XP gegen Vista, Teil 1

Performancereport Windows XP gegen Vista

Ein ewiger Streit – XP vs. Vista! Läuft Windows Vista nun langsamer oder nicht? – Ist Windows XP noch immer das bessere System für Spiele? Die Einen sind felsenfest davon überzeugt, dass Vista spürbare Performanceeinbußen mit sich bringt. Die Anderen halten mit Benchmarks dagegen. Tatsächlich gibt es relativ viele Print- und Onlinemagazine, sowie haufenweise Spieler, die sich genau mit diesem Thema beschäftigt haben.

Performancereport Test Drive Unlimited

Nachdem sich bereits Spiele wie Gothic 3, Anno 1701 oder Need for Speed: Carbon über ihre Qualitäten, Mainstream-Hardware zu quälen, outen mussten, darf im aktuellen Spiele-Performancereport das eben erst erschienene Test Drive Unlimited zeigen, mit welcher Hardware der Spieler die Nase auch im Rennen vorn hat.

In der Tradition der Test-Drive-Spielserie lässt der Spieler mit einer Vielfalt von exotischen und bekannten Autos und Sportwagen reichlich Gummi auf dem Asphalt zurück. Der Schwerpunkt liegt dabei beim Rasen über die Straßen einer der Inseln von Hawaii. Schnelle Reaktionen sind daher ebenso wichtig wie ein flüssiger Spielfluss. Die visuelle Komponente spielt dabei eine entscheidende Rolle – mehr als jedes andere Rennspiel versucht Test Drive Unlimited durch die Aussicht auf Landschaft und Architektur zu begeistern.

Wie gutmütig die Engine dabei mit der Hardware umgeht, ist also entscheidend für das Spielerlebnis des Users. Uns soll es aber dennoch wiederum nicht primär darum gehen, einen absoluten Sieger zwischen AMD, Intel oder nVidia zu erwählen. Vielmehr geht in diesem Test darum, welche Einstellungen und Hardware-Kombinationen spielbare Ergebnisse liefern. Auf das letzte Prozent kommt es daher weniger an, als auf einen möglichst hohen Wert der minimalen Framerate.

Vorab sei an dieser Stelle den Firmen Intel, nVidia und Sapphire für die unkomplizierte Stellung von Testsamples für unsere neuen Teststationen gedankt, womit auch dieser Artikel ermöglicht wurde.

Vielen Dank noch an dargo, der uns mit Rat und Tat zu Seite stand sowie uns jenes Profil zur Verfügung stellte, mit welchem die einzelnen Rennstarts angewählt wurde.

Wie bereits unsere vorherigen Spiele-Performancereports basieren auch die Messungen dieses Artikels auf tatsächlichen Savegames und nicht Timedemos. Dies erlaubt es uns, den Nachteilen von Timedemos aus dem Weg zu gehen. Zum einen kann nicht sichergestellt werden, dass ein Timedemo Physik, KI und Eingabegeräte berücksichtigt, zum anderen befinden sich in einem Timedemo auch Szenen mit stark unterschiedlichen Performance-Charakteristika. Der resultierende Mittelwert sagt dann nur noch sehr wenig über die gefühlte Performance aus.

Unsere Messungen nutzen dagegen vier ausgewählte Savegames, die mit dem Start eines Rennens beginnen und von dort an aufgezeichnet werden. Die resultierenden Ergebnisse stehen dann jeweils für ein WorstCase-Szenario. Was hier flüssig läuft, sollte dem Spieler auch über den Rest des Spiels ein einwandfreies Erlebnis beschweren.

Bei allen Savegames wurden mit Hilfe von Fraps gemessen, bis sich die KI-gesteuerten Wagen entfernt haben und die Performance sprungartig anzusteigen droht. Dabei wurde jedes Savegame generell fünfmal vermessen, und der Durchschnitt der Messungen als Ergebnis angegeben. Folgende Savegames kamen dabei zum Einsatz (Klick öffnet jeweils einen Screenshot des Savegames im Großformat als extra Fenster):

"Eine kleine Herausforderung" |

"Inseltour" |

"Gefahr in der Kehre" |

"Zurück an Absender" |

Das für diesen Artikel benutzte Testsystem wollen wir an dieser Stelle nur grob nennen, da es bereits hier umfassend ausgeführt wurde. Generell wurden die Grafikkarten-Tests auf einem auf 3200 MHz übertakteten Core 2 Duo E6400 durchgeführt, als Grafikkarten kamen dabei Radeon X1900 XT (auf Catalyst 7.2, A.I. default mit Area-AF) und GeForce 7950 GT (auf ForceWare 93.71, "High Quality") zum Einsatz. Für die CPU-Tests wurde zudem noch ein Athlon 64 X2 4600+ auf verschiedenen Taktungen herangezogen. Generell standen beiden Testsystemen jeweils zwei Gigabyte Speicher zur Verfügung.

Das Spiel selber wurde mit der originalen Spielversion ausgemessen. Zudem sei vorab absolut klargestellt, dass wir im Spiel selber immer die bestmögliche Grafikqualität und 5.1 Sound ausgewählt haben und sich dieser Artikel auch allein auf diese Settings bezieht. Senkt man die spieleigenen Grafiksettings hingegen ab, kann man natürlich unter Umständen auch mit etwas kleinerer Hardware als hier angegeben auskommen – aber dazu später mehr. Nicht berücksichtig haben wir in diesem Fall jedoch die Option für HDR-Rendering, um nVidia die Messungen unter Anti-Aliasing nicht zu verwehren. Anhand der Ergebnisse kann jeder selbst entscheiden, ob noch 15 bis 20 Prozent Spielraum sind, um HDR-Rendering auf der Radeon X1900 XT zu aktivieren.

Performancereport Armed Assault

In unseren vorhergehenden Performancereport-Artikeln interessierte uns die Leistungscharakteristik von schnellen Flitzern (TDU & NFS Carbon), strategischem Städtebau (Anno 1701) oder gar den Abenteuern des namenlosen Helden (Gothic 3). Will man ein etwas realistischeres Szenario testen, landet man wohl zwangsweise bei Kriegs-Simulationen. Vor einigen Jahren erschien mit Operation Flashpoint ein Hit in eben jener Kategorie. Dabei zeichnete sich das Spiel nicht nur durch viele Freiheiten, einen Editor und einem "Mitten drin" Gefühl aus, sondern beeindruckte mit hoher Sichtweite und relativ ansprechender Grafik.

Vor kurzem ist der quasi-Nachfolger Armed Assault erschienen und versucht eben jene Traditionen zu ehren. Schon den Vorgänger konnte man nach belieben CPU- oder GPU-lastig spielen – es gab genügend Einstellungen und Szenen, um sein PC-System bis an die Grenzen zu führen. Daher sind wir gespannt, wie Armed Assault dieses Erbe antreten wird. Kernpunkt der visuellen Darstellung in Armed Assault ist die bereits erwähnte hohe Sichtweite, eine ansprechende Vegetation, Dörfer unterschiedlicher Größe mit begehbaren Häusern und natürlich den Soldaten und deren Gefährt. Die Grafik-Engine baut zwar sichtlich auf dem Vorgänger auf, bietet allerdings neumodisches "Postprocessing" sowie stark verbesserte Schatten.

Während im Artikel zwar laufend AMD-, ATI-, Intel- und nVidia-Hardware verglichen wird, geht es uns wie immer nicht darum, den absoluten Sieger zu küren. Vielmehr wollen wir eine Praxisempfehlung aussprechen, welche Einstellungen sich für momentane Mainstream-Hardware anbietet, wie viel Performance der Käufer erwarten kann, und natürlich den ein oder anderen interessanten Ausreißer aufzeigen. Dabei kommt es uns am Ende auf einen möglichst hohen Wert der minimal erreichten Frames per Sekunde an. Das letzte Prozent am Ende des Balkens ist uns hier weniger von Bedeutung, da es dem Spieler in aller Regel nicht auffallen würde.

Vorab sei an dieser Stelle den Firmen Intel, nVidia und Sapphire für die unkomplizierte Stellung von Testsamples für unsere neuen Teststationen gedankt, womit auch dieser Artikel ermöglicht wurde.

Zudem sei hiermit noch "Melbourne, FL" gedankt, der uns viele Tips für dieses Spiel gegeben hat.

Wie bereits unsere vorherigen Spiele-Performancereports basieren auch die Messungen dieses Artikels auf tatsächlichen Savegames und nicht Timedemos. Dies erlaubt es uns, den Nachteilen von Timedemos aus dem Weg zu gehen. Zum einen kann nicht sichergestellt werden, dass ein Timedemo Physik, KI und Eingabegeräte berücksichtigt, zum anderen befinden sich in einem Timedemo auch Szenen mit stark unterschiedlichen Performance-Charakteristika. Der resultierende Mittelwert sagt dann nur noch sehr wenig über die gefühlte Performance aus.

Unsere Messungen nutzen dagegen vier ausgewählte Startszenen mit möglichst hohem Stress für das System. Die resultierenden Ergebnisse stehen dann jeweils für ein WorstCase-Szenario. Was hier flüssig läuft, sollte dem Spieler eigentlich auch über den Rest des Spiels ein einwandfreies Erlebnis bescheren.

Bei allen Savegames wurden mit Hilfe von Fraps gemessen. Dabei wurde jedes Savegame generell fünfmal vermessen, und der Durchschnitt der Messungen als Ergebnis angegeben. Folgende Savegames kamen dabei zum Einsatz (Klick öffnet jeweils einen Screenshot des Savegames im Großformat als extra Fenster):

Savegame "Lieferjunge" |

Savegame "Geprügelter Hund" |

Savegame "Feindgebiet" |

Savegame "Die große Schlacht" |

Das für diesen Artikel benutzte Testsystem wollen wir an dieser Stelle nur grob nennen, da es bereits hier umfassend ausgeführt wurde. Generell wurden die Grafikkarten-Tests auf einem auf 3200 MHz übertakteten Core 2 Duo E6400 durchgeführt, als Grafikkarten kamen dabei Radeon X1900 XT (auf Catalyst 7.2, A.I. default mit Area-AF) und GeForce 7950 GT (auf ForceWare 93.71, "High Quality") zum Einsatz. Für die CPU-Tests wurde zudem noch ein Athlon 64 X2 4600+ auf verschiedenen Taktungen herangezogen. Generell standen beiden Testsystemen jeweils zwei Gigabyte Speicher zur Verfügung.

Das Spiel selber wurde mit der Spielversion 1.5 ausgemessen. Im Vorfeld zeigte sich dabei, dass sich die Performance mit dem ersten Patch (1.2) an manchen Stellen mehr als verdoppelt hat. Inwiefern hierfür Optimierungen am Spiel oder eine Reduzierung einiger Details verantwortlich gemacht werden können, ist unbekannt. Der Patch 1.5 brachte dann jedoch Performance-technisch keine spürbaren Änderungen mehr mit sich.

Im Spiel selbst haben wir alle Optionen auf Maximal gestellt und danach die Sichtweite auf 1000 gesetzt, die Objektdetails auf "normal", sowie "Post-processing" und Schatten auf niedrig gesetzt. Das dürfte in den meisten Fällen dem entsprechen, was die Käufer des Spiels nutzen werden. Insbesondere die beiden zuletzt genannten Optionen kosten doch einiges an Leistung.

Performancereport Supreme Commander

Nachdem sich bereits Spiele wie Gothic 3, Anno 1701, Need for Speed: Carbon, Test Drive Unlimited und Armed Assault über ihre Qualitäten, Mainstream-Hardware zu quälen, outen mussten, darf nunmehr im aktuellen Spiele-Performancereport der Strategiekracher Supreme Commander zeigen, mit welcher Hardware der Spieler am besten die supergroßen Karten und die sich daraus ergebenden Massenschlachten dieses Titels antritt.

Als inoffizieller Nachfolger von Total Annihilation kann sich Supreme Commander von anderen Echtzeit-Strategiespielen vor allem mit enormen Kartengrößen (bis zu 81 Kilometer Kantenlänge!) und einer gigantischen Anzahl an maximalen Einheiten (1000 inklusive Gebäude) von anderen Spielen des Genres absetzen (Tests zum Spiele siehe GameCaptain, GameZone, GBase und Golem). All dies fordert natürlich seinen Tribut auch bei der dafür benötigten Hardware, welche bei großen Karten und vielen Einheiten dann doch deutlich über den seitens des Herstellers angegebenen und recht gemächlichen Mindestanforderungen liegt.

Doch wiederum soll das Ziel der heutigen Performance-Messungen nicht unbedingt sein, konkrete Sieger zwischen den jeweiligen Rivalen auf CPU- und GPU-Seite zu ermitteln. Vielmehr geht es eher darum, generelle Tendenzen zu erkennen, mit welcher Hardware das Spiel anständig spielbar ist. Wenn sich dabei auch ein Hinweis ergibt, ob das Spiel eine bestimmte Hardware klar bevorzugt, ist das natürlich in Ordnung – aber sicherlich soll mit diesem Artikel nicht herausgefunden werden, ob die eine von uns eingesetzte CPU oder Grafikkarte die andere um drei Prozent o.ä. "schlägt".

Vorab sei an dieser Stelle den Firmen Intel, nVidia und Sapphire für die unkomplizierte Stellung von Testsamples für unsere neuen Teststationen gedankt, womit auch dieser Artikel ermöglicht wurde.

Natürlich basiert auch dieser Artikel wieder auf Messungen mit Savegames anstatt Timedemos. Dies ermöglichte uns, auch aufgrund der Kürze der Savegames, speziell nur jene Szenen herauszusuchen, welche wir auch wirklich vermessen wollten – während bei einem Timedemo meistens mehrere Szenen (und viel Leerlauf) auf einmal vermessen werden, welche aber jeweils unterschiedliche Performance-Charakteristiken aufweisen können. Ein Timedemo-Durchlauf verwischt diese unterschiedlichen Szenen und deren unterschiedliche Performance-Charakteristik aber immer zu einer einzelnen Performance-Aussage, was die Aussagekraft einer solchen Messung dann doch erheblich einschränkt.

Anstatt Messungen des eher durchschnittlichen Gameflusses mittels Timedemos stellen unsere Messungen ausgewählter kurzer Szenen über den Weg der Savegames somit eher Worstcase-Benchmarks dar: Wir messen dann, wenn die Hardware wirklich unter Stress gerät – und eben auch nur die jeweilige Stress-Szene und nicht noch jede Menge Leerlauf oder gleich eine andere Szene mit hinzu.

Bei allen Savegames wurden jeweils immer die ersten fünf Sekunden zur Messung benutzt, welche dabei immer mittels Fraps durchgeführt wurden. Dabei wurde jedes Savegame generell mehrfach ausgeführt wie gemessen und dann der Durchschnitt dieser Messungen als Ergebnis genommen. Folgende Savegames kamen dabei für Supreme Commander (Klick öffnet jeweils einen Screenshot des Savegames im Großformat als extra Fenster):

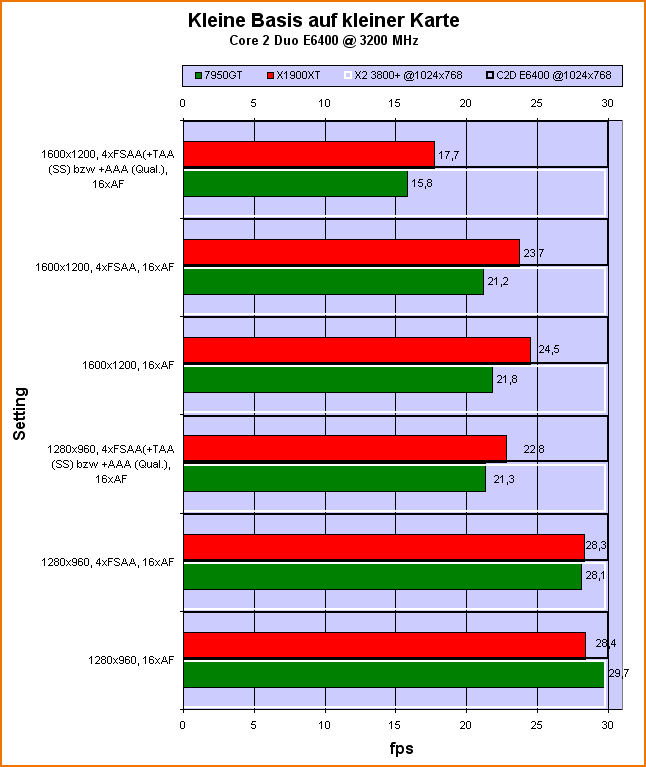

Savegame "Kleine Basis auf kleiner Karte" |

Savegame "Leichter Kampf auf kleiner Karte" |

Savegame "Größere Basis auf mittlerer Karte" |

Savegame "Stärkere Schlacht auf mittlerer Karte" |

Speziell zu den für Supreme Commander angesetzten Savegames läßt sich noch sagen, daß diese eher mit Vorsicht aufgenommen wurden und es in diesem Spiel noch weitaus stressendere Szenen gibt. Dies hängt allerdings damit zusammen, daß in absoluten Massenschlachten auf den großen Karten selbst unser auf 3.2 GHz übertakteter Core 2 Duo nie über 10 fps kommt – was dann aber auch keinen großen Sinn mehr macht. Überhalb von 10 fps ist das Spiel allerdings trotz der nominell niedrigen Framerate vernünftig spielbar, erst unterhalb der 10-fps-Grenze wird es zähflüssig. Generell muß man an so ein Spiel wohl eine andere Frameraten-Erwartung richten als an einen schnellen Shooter, für den selbst 30 fps manchen Spielern noch als zu gering erscheinen mögen.

Das für diesen Artikel benutzte Testsystem wollen wir an dieser Stelle nur absolut grob nennen, da es bereits hier umfassend ausgeführt wurde. Generell wurden die Grafikkarten-Tests auf einem auf 3200 MHz übertakteten Core 2 Duo E6400 durchgeführt, als Grafikkarten kamen dabei Radeon X1900 XT (auf Catalyst 7.2, A.I. default mit Area-AF) und GeForce 7950 GT (auf ForceWare 93.71, "High Quality") zum Einsatz. Für die CPU-Tests wurde zudem noch ein Athlon 64 X2 4600+ auf verschiedenen Taktungen herangezogen. Generell standen beiden Testsystemen jeweils zwei GigaByte Speicher zur Verfügung.

Das Spiel selber wurde in der Spielversion 1.0.3189 ausgemessen. Zudem sei vorab absolut klargestellt, daß wir im Spiel selber immer die bestmögliche Grafikqualität und 5.1 Surround-Sound ausgewählt haben und sich dieser Artikel auch hauptsächlich nur auf diese bestmöglichen Settings bezieht. Senkt man die Spiel-eigenen Grafiksettings hingegen ab, kann man natürlich auch mit kleinerer Hardware als hier angegeben auskommen. Für diesen Zweck haben wir zusätzlich auch extra Tests mit mittleren und niedrigen Details durchgeführt.

Und letztlich zum besseren Verständnis der CPU-Balken: Die weiß und schwarz umrandeten Messungen stellen bewusst CPU-limitiert angesetzte Messungen mit einem Athlon 64 X2 3800+ (weiß) und einem Core 2 Duo E6400 (schwarz) dar. Diese Messungen ergeben somit, welche Performance unter Ausschaltung des Effekts der Grafikkarten erreicht wird, was uns wiederum im Quervergleich mit den Grafikkarten-Messungen die Möglichkeit an die Hand gibt, mögliche CPU-Limitierungen mit schwächeren CPUs als dem bei den Grafikkartentests eingesetzten auf 3.2 GHz übertaketeten Core 2 Duo zu erkennen. Die fps-Skala aller Diagramme geht übrigens immer so weit, wie der fps-Wert, den der Core 2 Duo @ 3200 MHz auf 640x480 erreichen konnte.

Als erstes haben wir dann die Messungen zum ersten Savegame, welches eine kleine Basis auf einer kleineren Karte darstellt:

Prinzipiell liegt hierbei bezüglich der Grafikkarten-Performance alles recht nah beieinander, nur mit höheren Anforderungen erkämpft sich die ATI-Lösung ein paar kleine, jedoch bei weitem noch nicht wesentliche Vorteile. Beachtenswert ist allerdings, daß selbst bei diesem eigentlich nicht besonders forderndem Savagame die Frameraten unter den höheren Anforderungen schon unter die 20-fps-Grenze gehen. Interessanterweise liegt das CPU-Limit der doch recht unterschiedlichen Prozessoren von AMD und Intel unter diesem Savegame auf fast identischen Niveau.

Performancereport Command & Conquer: Tiberium Wars

Nachdem sich bereits Spiele wie Gothic 3, Anno 1701, Need for Speed: Carbon, Test Drive Unlimited, Armed Assault und Supreme Commander über ihre Qualitäten, Mainstream-Hardware zu quälen, outen mussten, darf nunmehr im aktuellen Spiele-Performancereport das jüngste Spiel im C&C-Universion, Command & Conquer 3: Tiberium Wars, seine diesbezüglichen Qualitäten zeigen.

Im selben Genre wie das erst kürzlich getestete Supreme Commander gelegen, zeigt sich der offiziell dritte Teil der C&C-Reihe (nicht gerechnet die vielen AddOns und anderen Ableger) spielerisch allerdings vollkommen andern als das vorgenannte Spiel: Während Supreme Commander deutlich strategie-lastiger ist, stellt Command & Conquer 3: Tiberium Wars vergleichsweise eher ein "Arcade-RTS" dar. Was natürlich nichts schlechtes bedeuten muß, schließlich hat jeder einen anderen Geschmack bezüglich des Schwierigkeitsgrades und der Strategie-Lastigkeit von solcherart Spielen. Genaueres zum Spiel selber ist unter anderem den Reviews bei GameCaptain, GameZone, GBase und Orthy zu entnehmen.

Wir werden uns an dieser Stelle natürlich ausschließlich mit der Performance des Spiels beschäftigen. Dabei soll das Ziel der heutigen Messungen nicht unbedingt sein, konkrete Sieger zwischen den jeweiligen Rivalen auf CPU- und GPU-Seite zu ermitteln. Vielmehr geht es eher darum, generelle Tendenzen zu erkennen, mit welcher Hardware das Spiel anständig spielbar ist. Wenn sich dabei auch ein Hinweis ergibt, ob das Spiel eine bestimmte Hardware klar bevorzugt, ist das natürlich in Ordnung – aber sicherlich soll mit diesem Artikel nicht herausgefunden werden, ob die eine von uns eingesetzte CPU oder Grafikkarte die andere um drei Prozent o.ä. "schlägt".

Vorab sei an dieser Stelle den Firmen Intel, nVidia und Sapphire für die unkomplizierte Stellung von Testsamples für unsere neuen Teststationen gedankt, womit auch dieser Artikel ermöglicht wurde.

Zudem noch vielen Dank an Tony Gradius, der uns ein paar Savegames für Command & Conquer 3: Tiberium Wars zur Verfügung stellte.

Natürlich basiert auch dieser Artikel wieder auf Messungen mit Savegames anstatt Timedemos. Dies ermöglichte uns, auch aufgrund der Kürze der Savegames, speziell nur jene Szenen herauszusuchen, welche wir auch wirklich vermessen wollten – während bei einem Timedemo meistens mehrere Szenen (und viel Leerlauf) auf einmal vermessen werden, welche aber jeweils unterschiedliche Performance-Charakteristiken aufweisen können. Ein Timedemo-Durchlauf verwischt diese unterschiedlichen Szenen und deren unterschiedliche Performance-Charakteristik aber immer zu einer einzelnen Performance-Aussage, was die Aussagekraft einer solchen Messung dann doch erheblich einschränkt.

Anstatt Messungen des eher durchschnittlichen Gameflusses mittels Timedemos stellen unsere Messungen ausgewählter kurzer Szenen über den Weg der Savegames somit eher Worstcase-Benchmarks dar: Wir messen dann, wenn die Hardware wirklich unter Stress gerät – und eben auch nur die jeweilige Stress-Szene und nicht noch jede Menge Leerlauf oder gleich eine andere Szene mit hinzu. Die von uns benutzten Savegames stellen dann verschiedene Anorderungsvarianten dar – von geringen Anforderungen bis zu extrem fordernden.

Bei allen Savegames wurden jeweils immer die ersten fünf Sekunden zur Messung benutzt, welche dabei immer mittels Fraps durchgeführt wurden. Dabei wurde jedes Savegame generell fünfach ausgeführt wie gemessen und dann der Durchschnitt dieser Messungen als Ergebnis genommen. Folgende Savegames kamen dabei für Command & Conquer: Tiberium Wars (Klick öffnet jeweils einen Screenshot des Savegames im Großformat als extra Fenster):

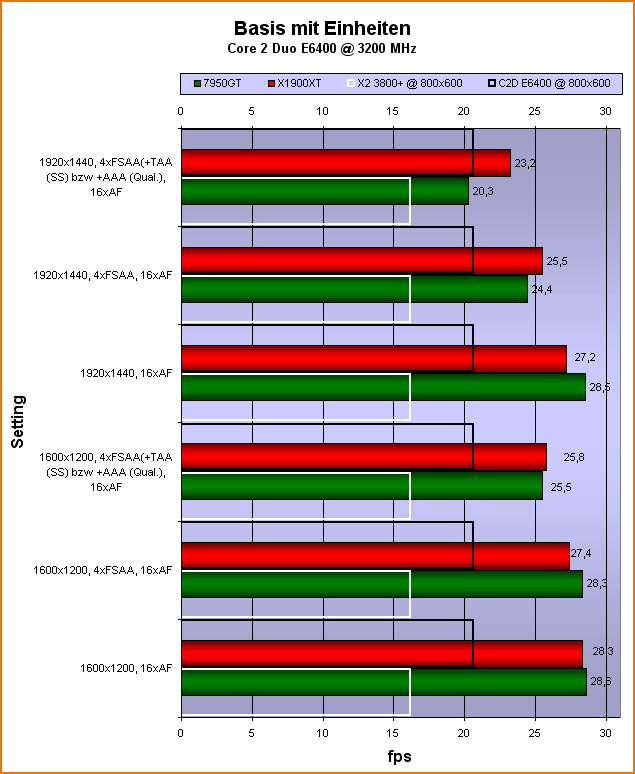

Savegame "Basis mit Einheiten" |

Savegame "Leichte Schlacht" |

Savegame "Schwere Schlacht" |

Savegame "Extreme Schlacht" |

Das für diesen Artikel benutzte Testsystem wollen wir an dieser Stelle nur absolut grob nennen, da es bereits hier umfassend ausgeführt wurde. Generell wurden die Grafikkarten-Tests auf einem auf 3200 MHz übertakteten Core 2 Duo E6400 durchgeführt, als Grafikkarten kamen dabei Radeon X1900 XT (auf Catalyst 7.2, A.I. default mit Area-AF) und GeForce 7950 GT (auf ForceWare 93.71, "High Quality") zum Einsatz. Für die CPU-Tests wurde zudem noch ein Athlon 64 X2 4600+ auf verschiedenen Taktungen herangezogen. Generell standen beiden Testsystemen jeweils zwei GigaByte Speicher zur Verfügung.

Das Spiel selber wurde in der Spielversion 1.03 und zusätzlich in einem extra Test in der Spielversion 1.04 ausgemessen. Zudem sei vorab absolut klargestellt, daß wir im Spiel selber immer die bestmögliche Grafikqualität und 5.1 Surround-Sound ausgewählt haben und sich dieser Artikel auch hauptsächlich nur auf diese bestmöglichen Settings bezieht. Senkt man die Spiel-eigenen Grafiksettings hingegen ab, kann man natürlich auch mit kleinerer Hardware als hier angegeben auskommen. Für diesen Zweck haben wir zusätzlich auch extra Tests mit mittleren und niedrigen Details durchgeführt.

Und letztlich zum besseren Verständnis der CPU-Balken: Die weiß und schwarz umrandeten Messungen stellen bewusst CPU-limitiert angesetzte Messungen mit einem Athlon 64 X2 3800+ (weiß) und einem Core 2 Duo E6400 (schwarz) dar. Diese Messungen ergeben somit, welche Performance unter Ausschaltung des Effekts der Grafikkarten erreicht wird, was uns wiederum im Quervergleich mit den Grafikkarten-Messungen die Möglichkeit an die Hand gibt, mögliche CPU-Limitierungen mit schwächeren CPUs als dem bei den Grafikkartentests eingesetzten auf 3.2 GHz übertaketeten Core 2 Duo zu erkennen. Die fps-Skala aller Diagramme geht übrigens immer so weit, wie der fps-Wert, den der Core 2 Duo @ 3200 MHz auf 640x480 erreichen konnte.

"Basis mit Einheiten"

Als erstes haben wir dann die Messungen zum ersten Savegame, welches schlicht eine Basis mit ein paar Einheiten und damit in dem Sinne die einfachst mögliche Anforderung darstellt:

Hier sind erst einmal keine wirklich großartigen Unterschiede zu bemerken. Allenfalls unter den beiden höchsten Bildqualitätssettings scheint die Radeon X1900 XT sich etwas besser behaupten zu können als die GeForce 7950 GT. Sehr beachtenswert sind zudem jedoch die CPU-Limits von Athlon 64 X2 3800+ (weißer Balken) und Core 2 Duo E6400 (schwarzer Balken): Diese beiden Prozessoren würden die benutzten Grafikkarten überall heftigst limitieren – was insbesondere deswegen erstaunt, weil ja schließlich in diesem Savegame noch gar nicht so viel los ist.

Performancereport Stalker: Shadow of Chernobyl

Nachdem sich bereits Spiele wie Gothic 3, Anno 1701, Need for Speed: Carbon, Test Drive Unlimited, Armed Assault, Supreme Commander und zuletzt Command & Conquer: Tiberium Wars über ihre Qualitäten, Mainstream-Hardware zu quälen, outen mussten, darf nunmehr im aktuellen Spiele-Performancereport der Actionkracher Stalker: Shadow of Chernobyl seine diesbezüglichen Qualitäten unter Beweis stellen. Mit einer jahrelangen Entwicklungszeit ausgestattet, konnte der russische Genre-Mix am Anfang des Jahres sowohl mittels der Story, den spielerischen Elementen als auch der Grafikqualität überzeugen. Genaueres zum Spiel ist unter anderem den Reviews bei GameCaptain, GBase, Golem und Eurogamer zu entnehmen.

Wir werden uns an dieser Stelle natürlich ausschließlich mit der Performance des Spiels beschäftigen. Dabei soll das Ziel der heutigen Messungen nicht unbedingt sein, konkrete Sieger zwischen den jeweiligen Rivalen auf CPU- und GPU-Seite zu ermitteln. Vielmehr geht es eher darum, generelle Tendenzen zu erkennen, mit welcher Hardware das Spiel anständig spielbar ist. Wenn sich dabei auch ein Hinweis ergibt, ob das Spiel eine bestimmte Hardware klar bevorzugt, ist das natürlich in Ordnung – aber sicherlich soll mit diesem Artikel nicht herausgefunden werden, ob die eine von uns eingesetzte CPU oder Grafikkarte die andere um drei Prozent o.ä. "schlägt".

Vorab sei an dieser Stelle den Firmen Intel, nVidia und Sapphire für die unkomplizierte Stellung von Testsamples für unsere neuen Teststationen gedankt, womit auch dieser Artikel wieder ermöglicht wurde.

Zudem noch vielen Dank an Banshee18, der mit Rat und Tat zu Seite stand, und speziell an Saw, der uns noch einige Savegames zur Verfügung stellte.

Natürlich basiert auch dieser Artikel wieder auf Messungen mit Savegames anstatt Timedemos. Dies ermöglichte uns, auch aufgrund der Kürze der Savegames, speziell nur jene Szenen herauszusuchen, welche wir auch wirklich vermessen wollten – während bei einem Timedemo meistens mehrere Szenen (und viel Leerlauf) auf einmal vermessen werden, welche aber jeweils unterschiedliche Performance-Charakteristiken aufweisen können. Ein Timedemo-Durchlauf verwischt diese unterschiedlichen Szenen und deren unterschiedliche Performance-Charakteristik aber immer zu einer einzelnen Performance-Aussage, was die Aussagekraft einer solchen Messung dann doch erheblich einschränkt.

Anstatt Messungen des eher durchschnittlichen Gameflusses mittels Timedemos stellen unsere Messungen ausgewählter kurzer Szenen über den Weg der Savegames somit eher Worstcase-Benchmarks dar: Wir messen dann, wenn die Hardware wirklich unter Stress gerät – und eben auch nur die jeweilige Stress-Szene und nicht noch jede Menge Leerlauf oder gleich eine andere Szene mit hinzu. Die von uns benutzten Savegames stellen dann verschiedene Anorderungsvarianten dar – von geringen Anforderungen bis zu extrem fordernden.

Bei allen Savegames wurden jeweils immer die ersten fünf Sekunden zur Messung benutzt, welche dabei immer mittels Fraps durchgeführt wurden. Dabei wurde jedes Savegame generell fünfach ausgeführt wie gemessen und dann der Durchschnitt dieser Messungen als Ergebnis genommen. Folgende Savegames kamen dabei für Stalker: Shadow of Chernobyl (Klick öffnet jeweils einen Screenshot des Savegames im Großformat als extra Fenster):

Savegame "Startszene" |

Savegame "Gewitter" |

Savegame "Leichtes Gefecht" |

Savegame "Schweres Gefecht" |

Das für diesen Artikel benutzte Testsystem wollen wir an dieser Stelle nur absolut grob nennen, da es bereits hier umfassend ausgeführt wurde. Generell wurden die Grafikkarten-Tests auf einem auf 3200 MHz übertakteten Core 2 Duo E6400 durchgeführt, als Grafikkarten kamen dabei Radeon X1900 XT (auf Catalyst 7.3, A.I. default mit Area-AF) und GeForce 7950 GT (auf ForceWare 93.71, "High Quality") zum Einsatz. Für die CPU-Tests wurde zudem noch ein Athlon 64 X2 4600+ auf verschiedenen Taktungen herangezogen. Generell standen beiden Testsystemen jeweils zwei GigaByte Speicher zur Verfügung.

Das Spiel selber wurde in der Spielversion 1.001 ausgemessen. Zudem sei vorab absolut klargestellt, daß wir im Spiel selber immer die bestmögliche Grafikqualität und 5.1 Surround-Sound ausgewählt haben und sich dieser Artikel auch hauptsächlich nur auf diese bestmöglichen Settings bezieht. Senkt man die Spiel-eigenen Grafiksettings hingegen ab, kann man natürlich auch mit kleinerer Hardware als hier angegeben auskommen. Für diesen Zweck haben wir zusätzlich auch extra Tests mit mittleren und niedrigen Details durchgeführt.

Und letztlich zum besseren Verständnis der CPU-Balken: Die weiß und schwarz umrandeten Messungen stellen bewusst CPU-limitiert angesetzte Messungen mit einem Athlon 64 X2 3800+ (weiß) und einem Core 2 Duo E6400 (schwarz) dar. Diese Messungen ergeben somit, welche Performance unter Ausschaltung des Effekts der Grafikkarten erreicht wird, was uns wiederum im Quervergleich mit den Grafikkarten-Messungen die Möglichkeit an die Hand gibt, mögliche CPU-Limitierungen mit schwächeren CPUs als dem bei den Grafikkartentests eingesetzten auf 3.2 GHz übertaketeten Core 2 Duo zu erkennen. Da die CPU-Limits durchgehend mit "Full Dynamic Lighting" ermittelt wurden, wurden diese CPU-Balken natürlich nur für die Durchläufe mit eben diesen Settings angegeben, da sich das CPU-Limit sonst ändern würde. Die fps-Skala aller Diagramme geht übrigens immer so weit, wie der fps-Wert, den der Core 2 Duo @ 3200 MHz auf 640x480 erreichen konnte.

Vorab soll für die nachfolgenden Benchmarks noch der Bildqualitätsunterschied bei den ausgewählten Benchmark-Settings aufzeigt werden. Da Stalker: Shadow of Chernobyl aufgrund des verwendeten Deferred Shading kein Anti-Aliasing unterstützt (die im Spiel vorhandene gleichlautenden Option beinhaltet schlicht einen Blurfilter, wenngleich dieser wohl über eine gewisse Edge Detection verfügt) und die Zuschaltung des anisotropen Filters in dem Sinne keine Performance kostet, haben wir uns dafür entschieden, daß Spiel mit den verschiedenen verfügbaren Beleuchtungsmodellen zu testen:

High Details & Full Dynamic Lighting |

|

High Details & Object Lighting |

High Details & Static Lighting |

Performancereport BioShock

Nachdem sich bereits Spiele wie Gothic 3, Anno 1701, Need for Speed: Carbon, Test Drive Unlimited, Armed Assault, Supreme Commander, Command & Conquer: Tiberium Wars und Stalker: Shadow of Chernobyl über ihre Qualitäten, Mainstream-Hardware zu quälen, outen mussten, darf nunmehr im aktuellen Spiele-Performancereport der NextGen-Shooter BioShock seine diesbezüglichen Qualitäten unter Beweis stellen. Bioshock ist einer der aktuelleren Blockbuster auf dem Spielemarkt, man kann beinahe schon behaupten, dass im Vorfeld des Releases ein kleiner Hype stattgefunden hat, zumindest hat es sich der Publisher auch diesmal nicht nehmen lassen, ein Spiel mit "bahnbrechenden Neuerungen" anzukündigen. Ob die Neuerungen so bahnbrechend waren oder nicht sei dahingestellt, genaueres zum Spiel selber ist dann sowieso den Reviews von GameZone, Golem, GBase und der Spieleflut zu entnehmen.

Wir werden uns an dieser Stelle natürlich ausschließlich mit der Performance des Spiels beschäftigen. Dabei soll das Ziel der heutigen Messungen nicht unbedingt sein, konkrete Sieger zwischen den jeweiligen Rivalen auf CPU- und GPU-Seite zu ermitteln. Vielmehr geht es eher darum, generelle Tendenzen zu erkennen, mit welcher Hardware das Spiel anständig spielbar ist. Wenn sich dabei auch ein Hinweis ergibt, ob das Spiel eine bestimmte Hardware klar bevorzugt, ist das natürlich in Ordnung – aber sicherlich soll mit diesem Artikel nicht herausgefunden werden, ob die eine von uns eingesetzte CPU oder Grafikkarte die andere um drei Prozent o.ä. "schlägt".

Vorab sei an dieser Stelle den Firmen Club3D, AMD Intel, nVidia und Sapphire für die unkomplizierte Stellung von Testsamples für unsere Teststationen gedankt, womit auch dieser Artikel wieder ermöglicht wurde.

Natürlich basiert auch dieser Artikel wieder auf Messungen mit Savegames anstatt Timedemos. Dies ermöglichte uns, auch aufgrund der Kürze der Savegames, speziell nur jene Szenen herauszusuchen, welche wir auch wirklich vermessen wollten – während bei einem Timedemo meistens mehrere Szenen (und viel Leerlauf) auf einmal vermessen werden, welche aber jeweils unterschiedliche Performance-Charakteristiken aufweisen können. Ein Timedemo-Durchlauf verwischt diese unterschiedlichen Szenen und deren unterschiedliche Performance-Charakteristik aber immer zu einer einzelnen Performance-Aussage, was die Aussagekraft einer solchen Messung dann doch erheblich einschränkt.

Anstatt Messungen des eher durchschnittlichen Gameflusses mittels Timedemos stellen unsere Messungen ausgewählter kurzer Szenen über den Weg der Savegames somit eher Worstcase-Benchmarks dar: Wir messen dann, wenn die Hardware wirklich unter Stress gerät – und eben auch nur die jeweilige Stress-Szene und nicht noch jede Menge Leerlauf oder gleich eine andere Szene mit hinzu. Die von uns benutzten Savegames stellen dann verschiedene Anorderungsvarianten dar – von geringen Anforderungen bis zu extrem fordernden.

Bei allen Savegames wurden jeweils immer die ersten fünf Sekunden zur Messung benutzt, welche dabei immer mittels Fraps durchgeführt wurden. Dabei wurde jedes Savegame generell fünfach ausgeführt wie gemessen und dann der Durchschnitt dieser Messungen als Ergebnis genommen. Folgende Savegames kamen dabei für Stalker: Shadow of Chernobyl (Klick öffnet jeweils einen Screenshot des Savegames im Großformat als extra Fenster):

Das für diesen Artikel benutzte Testsystem wollen wir an dieser Stelle nur absolut grob nennen, da es bereits hier umfassend ausgeführt wurde. Allerdings stehen beiden Testsystemen inzwischen jeweils 2 GB Speicher zur Verfügung. Generell wurden die Grafikkarten-Tests auf einem auf 3200 MHz übertakteten Core 2 Duo E6750 (2.66 GHz) durchgeführt, als weitere CPUs für diverse andere Prozessoren-Tests kamen zudem noch Core 2 Duo E6420 (2.13 GHz)), Athlon 64 X2 5600+ (2.8 GHz) und Athlon 64 X2 6400+ (3.2 GHz) zum Einsatz. Als Grafikkarten wurden auf ATI-Seite die Radeon X1900 XT 512MB und Radeon HD 2900 XT 512MB sowie auf nVidia-Seite die GeForce 7950 GT 512MB und die GeForce 8800 GTS 640MB unter den nachfolgenden Settings und Treiber-Versionen benutzt:

| Treiber Windows XP 32-Bit | Treiber Windows Vista 64-Bit | Bildqualitäts-Settings | |

|---|---|---|---|

| Radeon X1900 XT 512MB | Catalyst 7.9 | Catalyst 7.9 | A.I. default mit Area-AF |

| Radeon HD 2900 XT 512MB | Catalyst 7.9 | Catalyst 7.9 | A.I. default mit Area-AF |

| GeForce 7950 GT 512MB | ForceWare 163.71 | ForceWare 163.69 | High Quality |

| GeForce 8800 GTS 640MB | ForceWare 163.71 | ForceWare 163.69 | Quality |

Das Spiel selber wurde in der Spielversion 1.0 ausgemessen. Zudem sei vorab absolut klargestellt, daß wir im Spiel selber immer die bestmögliche Grafikqualität und 5.1 Surround-Sound ausgewählt haben und sich dieser Artikel auch hauptsächlich nur auf diese bestmöglichen Settings bezieht. Senkt man die Spiel-eigenen Grafiksettings hingegen ab, kann man natürlich auch mit kleinerer Hardware als hier angegeben auskommen. Für diesen Zweck haben wir zusätzlich auch extra Tests mit mittleren und niedrigen Details durchgeführt.

Dem aufmerksamen Leser wird auffallen, dass wir nachfolgend keinen einzigen Test mit Kantenglättung (Anti-Aliasing) angetreten haben. Zum Testzeitpunkt gab es mit einigen Karten, hier sei vor allem die R600-basierenden genannt, massive Schwierigkeiten, Anti-Aliasing unter BioShock überhaupt zu aktivieren. Bei den G8x-basierenden Karten klappt dies, jedoch kommt es dort zu unreproduzierbaren Fehlern – sprich, auf manchen Rechnern wird Anti-Aliasing auch dargestellt, auf manchen nicht. Daher haben wir auf AA-Tests in diesem Fall vollkommen verzichtet. Ob die Schwierigkeiten, beim den R600-basierenden Grafikkarten in Bioshock Anti-Aliasing zu aktivieren, auf die verbuggten ROPs zurückzuführen ist, lässt sich derzeit leider nicht nachvollziehen.

Und letztlich zum besseren Verständnis der CPU-Balken: Die weiß und schwarz umrandeten Messungen stellen bewusst CPU-limitiert angesetzte Messungen mit einem Core 2 Duo E6750 (weiß) und einem Athlon 64 X2 5600+ (schwarz) dar. Diese Messungen ergeben somit, welche Performance unter Ausschaltung des Effekts der Grafikkarten erreicht wird, was uns wiederum im Quervergleich mit den Grafikkarten-Messungen die Möglichkeit an die Hand gibt, mögliche CPU-Limitierungen mit schwächeren CPUs als dem bei den Grafikkartentests eingesetzten auf 3.2 GHz übertaketeten Core 2 Duo zu erkennen. Da die CPU-Limits durchgehend mit "Full Dynamic Lighting" ermittelt wurden, wurden diese CPU-Balken natürlich nur für die Durchläufe mit eben diesen Settings angegeben, da sich das CPU-Limit sonst ändern würde. Die fps-Skala aller Diagramme geht übrigens immer so weit, wie der fps-Wert, den der Core 2 Duo @ 3200 MHz auf 640x480 erreichen konnte.