Hauptlinks

Suchen

News des 4./5. September 2010

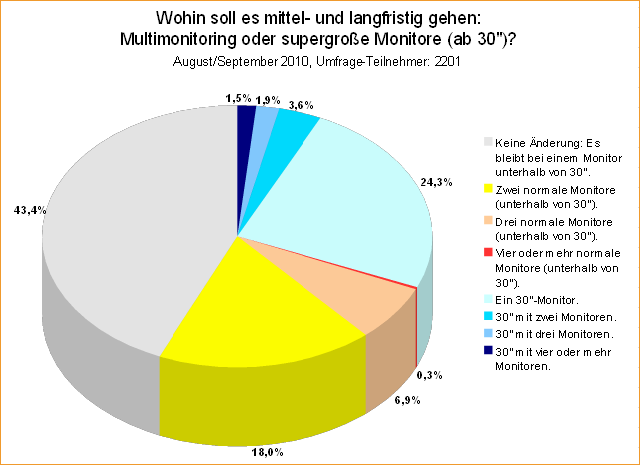

Unsere wöchentliche Umfrage widmete sich diesesmal der Frage, wohin es nach den aktuellen Monitorgrößen in Zukunft gehen wird: Weiter zu supergroßen Monitoren ab 30 Zoll Bilddiagonale – oder aber in Richtung Multimonitoring? Hierbei sind erneut interessante Zahlen aufgelaufen, welche grob zusammengefaßt in diese Richtung deuten, als daß das bislang eher elitäre Thema des Multimonitorings in Zukunft für einen größeren Teil der Umfrage-Teilnehmer interessant werden könnte. Weiterhin die größte Gruppe wird allerdings mit 43 Prozent von diesen Nutzer gebildet, welche weder in Richtung 30-Zoll-Monitor noch Multimonitoring gehen wollen – was ja auch verständlich ist, so ein 23- bis 27-Zöller mit 1920x1080 bzw. 1920x1200 bietet für die meisten Anwendungsfälle mehr als genügend Nutzfläche.

Andererseits soll es immer weiter nach vorn gehen und in Frage höherer Auflösungen ist seit einigen Jahren nichts wesentliches mehr passiert – der 2560x1600 Standard existiert nunmehr auch schon seine Zeit, wird aber selbst im Enthusiasten-Bereich nur eher selten genutzt. Langfristig wird sich hier ein Investitionsstau aufbauen, der sich irgendwann entladen wird – geht es nach unseren Nutzern, dann zu kummuliert 31 Prozent mit einem oder mehreren supergroßen Monitoren ab 30 Zoll Bilddiagonale oder aber (wieder kummuliert) zu 32 Prozent mit einem Multimonitoring-System (die Zahl ist unabhängig der Monitorgröße, beide Teilmengen überschneiden sich also). Dies sieht erst einmal nach einem gewissen Gleichstand aus, aber dennoch dürften die normal großen Monitore weiterhin beliebter sein – beispielsweise stimmten unter den perspektivischen Multimonitor-Nutzern immer 78 Prozent zugunsten der normalgroßen Monitore und nur 22 Prozent zugunsten der 30-Zoll-Riesen.

Und dies ist sicherlich ein gewisser Stimmungsumschwung weg von immer größeren Monitoren hin zu mehr als einem Monitor. Sicherlich spielt hier auch die preisliche Komponente mit hinein, daß derzeit drei 23-Zöller schon günstiger als ein einzelner 30-Zöller zu haben sind. Es bliebe natürlich abzuwarten, ob die zukünftige Entwicklung wirklich in diese Richtung geht – oder ob nicht eventuell das 3D-Thema hier alles durcheinander bringt (wobei sich 3D natürlich nicht mit supergroßen Monitoren oder Multimonitoring ausschließt – es wird halt nur viel teurer). Wir danken für die Teilnahme an dieser Umfrage und verweisen auf unsere neue Umfrage in der rechten Seitenleiste, welche nach den Anforderungen fragt, welche an die Performance von Notebook-Grafik gestellt wird.

Wie schon einmal erwähnt, ist die Gerüchteküche zu den kommenden Southern-Islands-Grafikchips von AMD aktuell am überbrodeln – und dies manchmal so heftig, daß dann auch wirklich absurde Meldungen herauskommen, deren nicht vorhandene Plausibilität im allgemeinen Wahn um immer neue Nachrichten und fetzigere Schlagzeilen gar nicht mehr beachtet wird. Die zwei jüngsten Beispiele sind hier und hier zu begutachten: Dabei mixt erstgenannte Meldung schon bekannte Daten mit der neuen Behauptung, AMD würde die Radeon HD 6000 Serie in der zeitlichen Reihenfolge zuerst LowCost, dann Mainstream und zuletzt erst HighEnd vorstellen. Dies widerspricht allerdings jeden Gepflogenheiten im Grafikkarten-Business, wo immer die großen Chips zuerst in den Markt entlassen werden – nicht nur, weil die Arbeit an diesen in aller Regel früher angefangen und damit auch früher fertig wird, sondern vor allem auch, weil eine umgekehrte Reihenfolge den Markt für die später kommenden größeren Lösungen kaputtmacht.

Sprich: Wenn AMD zuerst mit einem vernünftigen Mainstream-Chip kommt, wird auch ein Gutteil der üblichen Performance-Käufer diesen nehmen – und wenn dann erst der Performance-Chip kommt, fehlt diesem ein gewisser Teil der potentiellen Käuferschaft (gleiches gilt dann verschärft beim HighEnd-Chip). Daher muß rein verkaufspsychologisch die Vorstellungsreihenfolge immer von oben nach unten lauten, ansonsten zieht man sich ungewollt die durchschnittlichen Verkaufspreise nach unten. Hinzu kommt noch der Punkt, daß AMD derzeit ja überhaupt nicht in Eile ist, da nVidia sich nur auf Basis der aktuellen Fermi-Chips wehren kann und keine neue nVidia-Generation in direkter Reichweite liegt. Selbst im schlimmsten Fall, wenn AMD die Radeon HD 6000 Serie also erst im Jahr 2011 ausliefern kann, wäre dies kein Beinbruch und es würde kein Zwang auf AMD liegen, so schnell wie möglich die neuen Chips herauszuwerfen.

Die zweitgenannte Meldung ist dann noch absurder: Danach soll AMD aufgrund der (angeblichen) Chipknappheit eine gewisse Umbenennung anstreben: Aus der bisherigen Radeon HD 5770 wird eine Radeon HD 6770, der Performance-Chip Barts stellt die Radeon HD 6870 und der eigentliche HighEnd-Chip Cayman die Radeon HD 6970. Einmal abgesehen davon, daß die Presse und die interessierten Beobachter AMD für so etwas in der Luft zerreißen würden (und AMD sich dies vorher ausrechnen kann) – wem sollen diese Umbenennungen etwas vormachen? Es handelt sich vollständig um Karten, die kaum ins OEM-Segment gehen, wo man mit Umbenennungen vielleicht wirklich etwas erreichen kann. Im Retail-Segment zählt dagegen nicht der Name, sondern harte Fakten – und wenn AMD eine RV8xx-basierte Radeon HD 5770 unter "Radeon HD 6770" laufen läßt, würde das nicht wesentlich weiterhelfen, weil eine solche Karte auch keine besseren Wertungen als die aktuelle Radeon HD 5770 kassiert.

Der Performance-Chips Barts als "Radeon HD 6870" und der eigentliche HighEnd-Chip Cayman unter dem eigentlich für DualChip-Lösungen reservierten Namen "Radeon HD 6970" fallen in die gleiche Kategorie: Wem beim Zielpublikum dieser Lösungen wollte man mit der Namenswahl etwas vormachen? Wenn AMD einen Performance-Chip unter einem HighEnd-Namen laufen läßt, wird dieser dadurch nicht besser bewertet werden – potentiell eher schlechter, weil es eher unwahrscheinlich ist, daß der Performance-Chip Barts unter dem Namen "Radeon HD 6870" die Performance einer Radeon HD 5870 erreichen kann. Und weil es sich AMD selber denken kann, daß eine solche Aktion nur in einer großen PR-Katastrophe mündet, wird es eine solche auch nicht geben. Wie gesagt ist AMD derzeit absolut nicht in Eile ob der Southern-Islands-Generation, womit selbst eine etwaige Verzögerung keinerlei solcherart Harakiri-Aktionen auslösen muß.

Die PC Games Hardware hat sich auf der IFA von AMD einen lauffähigen Fusion-Prozessor demonstrieren lassen. Dabei zeigte ein Ontario-Prozessor der Bobcat-Architektur in einem Notebook das MMO "City of Heroes" mit reduzierten Details, aber dennoch flüssig. Viel mehr dürfte sowieso nicht möglich sein, schließlich wird der integrierte Grafikchip der Bobcat-Architektur bei weitem nicht so stark sein wie der integrierte Grafikchip der Llano-Architektur, welcher gestern noch mit bis zu 480 Shader-Einheiten genannt wurde. In die Bobcat-Architektur passt rein aus Platz- und natürlich auch aus Verlustleistungsgründen maximal eine LowCost-Grafik hinein, im Rahmen von 40 bis 80 Shader-Einheiten (mehr wäre immer schwerer mit den angepeilten TDP-Größen zu vereinbaren).

Gegenüber dem Konkurrenzfeld in Form von Intels Atom-Prozessor ist dies natürlich trotzdem beachtlich, da die integrierte Atom-Grafik (bei Atom im Mainboard-Chipsatz befindlich) nicht mehr zeitgemäß, oftmals inkompatibel zu Spielen und natürlich auch viel zu langsam für diese ist. Daneben bietet die Meldung noch eine Klarstellung bei Namenswahl der einzelnen Bobcat-Prozessoren: Ontario kommt mit 9 Watt TDP für Netbooks und den Embedded-Bereich, während Zaccate mit 18 Watt TDP für Notebooks und Nettop-PCs gedacht ist. Gleichzeitig stellte AMD aber auch die These auf, zukünfig das Fusion-Konzept so weit zu treiben, daß CPU und GPU "jede Einheit sämtliche Funktionseinheiten nutzen" können. Was sich auf den ersten Blick gut und im Sinne des Fusion-Konzepts schlüssig anhört, passt allerdings nicht in die heutige Programmierwelt, wo CPUs nun einmal x86-Code und GPUs völlig anders angelegten DirectX-Code abarbeiten müssen und jeweils auch nur darauf ausgelegt sind. Selbst wenn man den Grafikchip als Co-Prozessor der CPU benutzt, wird das (wie es bisher schon hier und da getan wird) über Grafikchip-Code gehen und nicht über über x86-Code.

Und daß der Grafikchip in irgendeiner Form CPU-Einheiten nutzen kann (außer den Caches, aber die sind ja nur passive Datenspeicher), wird aktuell geradezu unmöglich funktionieren – die Ansätze und die jeweils benötigten Programmiercodes sind einfach zu verschieden. Natürlich macht sich so eine Aussage gut gegenüber der Presse, hat aber nichts mit der realen Funktionsweise von CPUs und GPUs zu tun, welche derzeit einfach viel zu unterschiedlich sind. Allein Intels Larrabee-Ansatz ist zu so etwas in der Lage, schließlich wurde dieser Grafikchip aus einem x86-Design heraus entwickelt. Prinzipiell möglich ist so etwas natürlich auch bei AMD, allerdings nicht mit dem aktuellen Fusion-Design und auch nicht mit Weiterentwicklungen dessen – dafür würde ein revolutionär neuer Grafikchip-Ansatz benötigt, der eben auch (performant) mit x86-Code umgehen kann. So etwas kann man in einer langfristigen Zukunft sehen, aber sicherlich nicht in absehbarer Zeit.