Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 9. Juni 2021

nVidia hat sich den (am Donnerstag folgenden) Marktstart der GeForce RTX 3070 Ti durch mehrheitlich schwache Testberichte zu dieser neuen Ampere-Karte bereits kräftig verdorben. Dies passierte zum einen wegen einer klar unterhalb der Erwartungen liegenden Mehrperformance zur regulären GeForce RTX 3070: Hierbei kommt die GeForce RTX 3070 Ti grob auf dem Zuwachs ihrer Rechenleistung (+7,1%) heraus, die enormen Zuwächse an Speicherbandbreite (+36%) und TDP (+32%) haben nur einen marginalen Effekt. Dafür dann die Hälfte der Listenpreis-Differenz zwischen GeForce RTX 3070 & 3080 zu verlangen, keinen Mehrspeicher zu bieten und auch noch den Stromverbrauch kräftig (aber zwecklos) hochzureißen, wurde in unserem Forum mehrheitlich mit großem Erstaunen (plus einem buntem Strauß anderer, weniger druckreifer Emotionen) wahrgenommen. Zum anderen führen die ganzen fruchtlosen Grafikkarten-Launches der letzten Zeit nunmehr zu einem Ermüdungs-Effekt bei Test-Lesern und Test-Erstellern – besonders plastisch bei den YouTubern zu sehen:

Auch wenn es etwas gedauert hat, wird hiermit nun endlich die aktuelle Gefühlslage der Grafikkarten-Käufer direkt auch zu den Herstellern transportiert – und zwar in einer Form, dass man seitens der Hersteller nicht mehr den Kopf in den Sand stecken und glauben kann, dies wären alles nur "Einzelmeinungen". Die Hersteller nehmen aus diesem Launch hoffentlich den Punkt mit, dass es nahezu zwecklos ist, immer weitere Grafikkarten-Modelle in den Markt zu schicken, wenn man sowieso nichts oder dies nur zu überzogenen Preisen kaufen kann (was bei der GeForce RTX 3070 Ti genauso zu erwarten ist). Eine höhere Verfügbarkeit ergibt sich auch nicht allein durch die Existenz eines breiteren Produktprogramms – was zählt, sind augenscheinlich allein die Chip-Nachlieferungen. Das Thema einer möglicherweise schlechten Verfügbarkeit von GDDR6X-Speicher entkräftet die GeForce RTX 3070 Ti nun höchst selbst, denn bei dieser wurde wie bekannt selbiger GDDR6X-Speicher verbaut (Meme hierzu).

Unabhängig davon, wo genau der Schuh in der Lieferkette drückt, sollte das vornehmlichste Ziel der Hersteller (ob Grafikchip oder Grafikkarte) nun die Erlangung einer überzeugenden Lieferbarkeit sein – in diesem Sinne, dass volle Läger die Straßenpreise wieder in Richtung der Listenpreise herunterdrücken können. Noch mehr (letztlich nicht verfügbare) Grafikkarten vorzustellen, kommt derzeit immer weniger gut an – dieses Lied haben die Grafikkarten-Käufer in den letzten Monaten einfach zu häufig gehört. Inbesondere bei den nachfolgend eigentlich anstehenden Launches von Mainstream-Modellen nach RDNA2-Architektur (Radeon RX 6500/6600 Serien) sowie Ampere-Architektur (GeForce RTX 3050 Serie) wäre es um so entbößender, Grafikkarten für das 200-Euro-Segment anzukündigen, welche der preissensitiven Kundschaft im Einzelhandel dann für 500 Euro aufwärts verkauft werden sollen.

VideoCardz berichten über Linux-Kernel-Patches, welche explizit von einem "primary" and "secondary" Die für AMDs "Aldebaran" CDNA2-Beschleuniger sprechen. Damit ist erst einmal gesichert, dass AMDs zukünftige HPC-Projekte ebenfalls den MultiChip-Ansatz benutzen werden. Zudem kann man eventuell hieraus auf die Verwendung zweier unterschiedlicher Chips spekulieren – was aber unsicher ist und bleibt, denn wirtschaftlicher ist die Fertigung von nur einem Chip, welcher dann doppelt verwendet wird. Die Hardware-Aussage von Kepler @ Twitter deutet zudem auch eher auf zwei gleiche Chips hin, denn jedes Aldebaran-Die soll über 8 Raster-Einheiten samt 128 Shader-Cluster verfügen. Der gesamte CDNA2-Chip hätte somit 16 Raster-Einheiten und 256 Shader-Cluster – wovon AMD allerdings (wohl aus Salvage-Gründen) möglicherweise nur 224 Shader-Cluster für die HPC-Lösung "Radeon Instinct MI200" aktivieren wird.

The full config of Aldebaran is 2 dies x 8 Shader Engines x 16 Compute Units, but MI200 might be only 224 CUs enabled

Quelle: Kepler @ Twitter am 10. Juni 2021

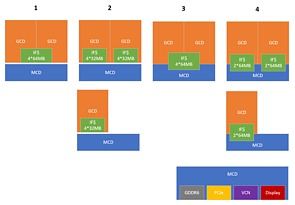

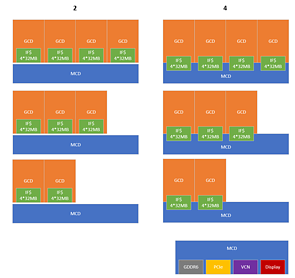

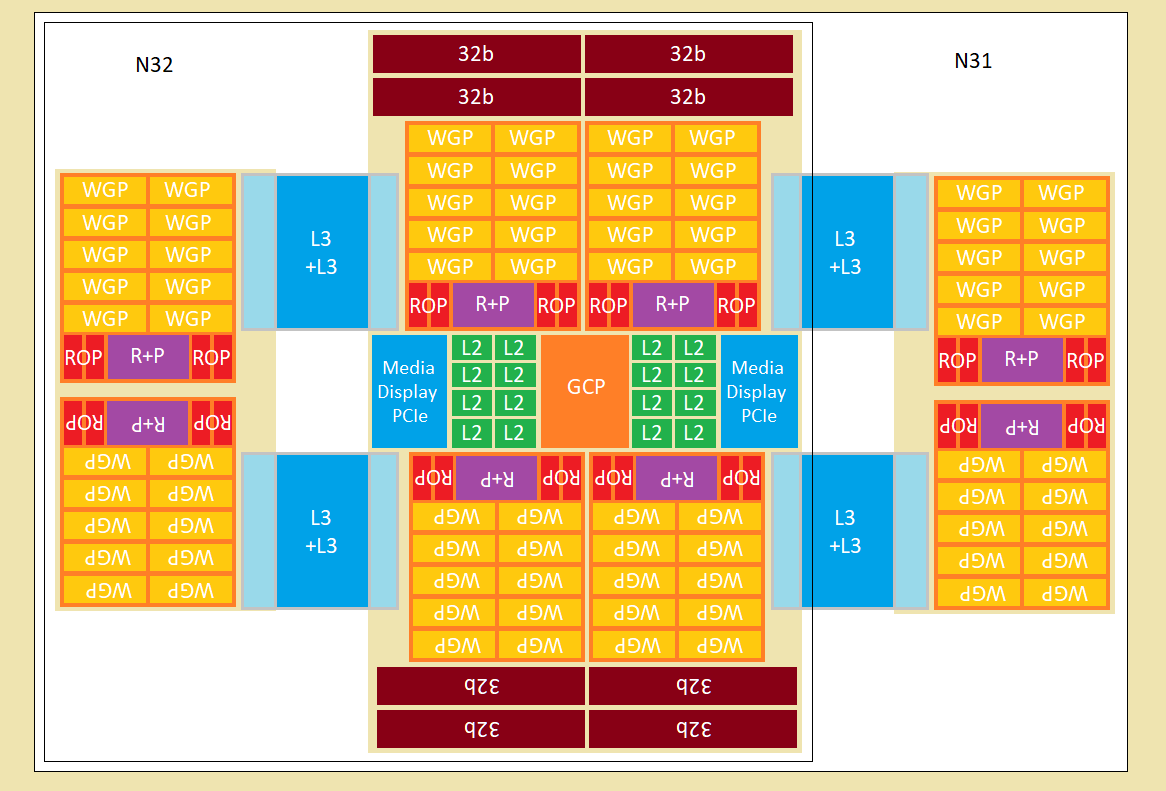

Interessanterweise ging diesem Tweet auch wieder ein Hardware-Rätsel seitens Kepler @ Twitter voraus, bei welchem allein der Wortlaut "2 * 8 * 16?" in die Welt gesetzt wurde. Dies liest sich nunmehr augenscheinlich als "2 Dies x 8 Raster-Engines x 16 Shader-Cluster" – und deutet somit indirekt darauf hin, dass auch das in der kürzlichen Navi-33-Meldung angesprochene Hardware-Rätsel zu den RDNA3-Chips korrekt aufgelöst wurde. Passend hierzu soll an dieser Stelle auf interessante Bild-Darstellungen zur möglichen Gestaltung von MultiChip/Chiplet-Konstrukten bei RDNA3 bzw. Navi 3X aus unserem Forum verwiesen werden – Posting #1 von 'basix' und Posting #2 von 'Cyberfries'. Jene Darstellungen geben keinerlei Aussagen darüber ab, wie AMD seine RDNA3-Chips wirklich konstruiert – sondern stellen nur verschiedenen Möglichkeiten in den Raum, wie dies passieren könnte. Besonders gewagt wie hochtechnologisch ist dabei der letzte Ansatz, welcher zwei regelrecht unterschiedliche Chips beschreibt, aus welchen sich sowohl Navi 32 als auch Navi 31 zusammensetzen könnten.

Tom's Hardware notieren eine Aussage von Speicherchip-Fertiger SK Hynix, wonach HBM3-Speicher bis zu 665 GBit/sec Speicherbandbreite erreichen soll. Jene Bit-Angabe ist natürlich kaum zweckmäßig, ohne dass jeweils benutzte Interface einzurechnen – aber über die glücklicherweise angegebene Datenrate erhält man dann die passende Information: 5,2 Gbps erreicht dieser Speicher, was nach dem DDR-Verfahren ergo 2600 MHz Taktraten sind. Dies ist für HBM-Speicher reichlich viel, HBM1 startet mal mit 500 MHz (DDR), selbst HBM2 lief lange Zeit nur auf 1000 MHz (DDR) und konnte sich erst in jüngerer Zeit steigern. Im HPC-Bereich dürfte man dies dankend annehmen, dort spielen die nach wie vor augenscheinlich klar höheren Kosten von HBM-Speicher keine wirkliche Rolle. Im Bereich von Gaming-Grafikkarten ist es dagegen nicht besonders wahrscheinlich, dass HBM-Speicher alsbald nochmals eine neue Chance bekommt: nVidia schaut wie bekannt insbesondere auf die Kosten (zugunsten der eigenen Marge), AMD hingegen reduziert derzeit eher den Effekt des Speicherinterfaces durch die Hinzunahme seines "Infinity Cache".

Überraschungen sind dennoch nie gänzlich auszuschließen, gerade da beide Grafikchip-Entwickler inzwischen HBM-Speicher regelmäßig (für HPC-Chips) einsetzen und somit mit der Technik inzwischen vollkommen vertraut sind. Zudem hat sich HBM-Speicher im HPC-Bereich generell derart etabliert, dass auch die Hochschraubung der Produktionsmenge zugunsten mit HBM bestückter Gaming-Grafikkarten nicht mehr so schwierig sein sollte wie früher. Das eigentliche Entscheidungsmerkmal ist dabei für Endverbraucher wie auch die Fachpresse schwer zu fassen: Jenes liegt weniger denn allein in den technischen Vorteilen, sondern viel eher im Mehrpreis gemessen an den technischen Vorteilen. Und natürlich lassen sich die Hersteller bei Kalkulations-Details kaum jemals in die Karten schauen – man kann immer nur mutmaßen, dass HBM letztlich wirtschaftlich nicht aufgeht, wirklich beweissen läßt sich dies leider nicht.