Hauptlinks

Suchen

News des 20./21. November 2010

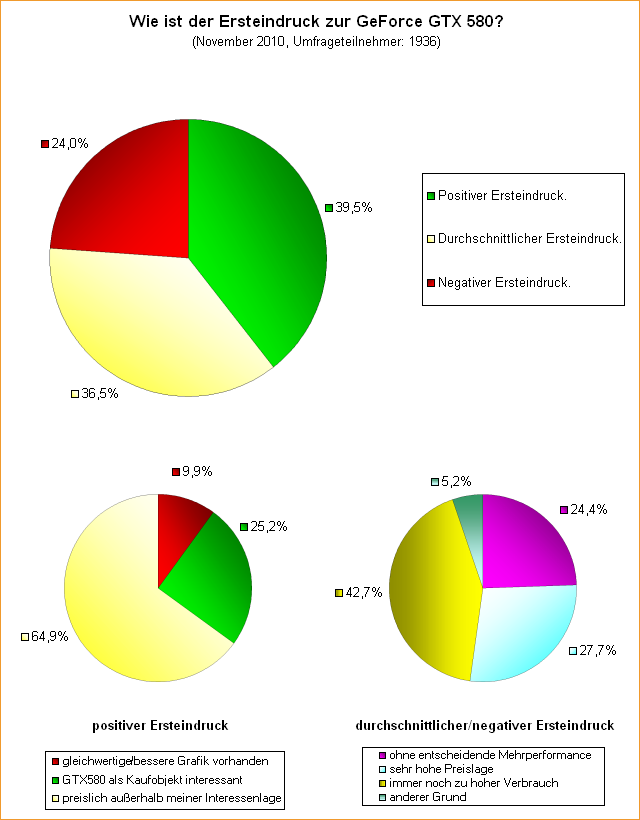

Unsere letzte Umfrage drehte sich um den Ersteindruck zur GeForce GTX 580. Die dabei aufgelaufenen Zahlen sind natürlich immer unter dem Punkt zu betrachten, daß eine 450-Euro-Grafikkarte ganz gewiß niemals jedermanns Geschmack treffen kann – und so gesehen sind die 39,5 Prozent positiver Ersteindruck für die GeForce GTX 580 ein ganz vernünftiger Wert. Allerdings ergibt sich ein sehr deutlicher Unterschied zur gleichlautenden Umfrage zur Radeon HD 6800 Serie bezüglich der Kaufneigung – für gleich zwei Drittel der positiv gegenüber der GeForce GTX 580 eingestellten Umfrageteilnehmer ist die neue nVidia-Karte außerhalb des eigenen Preisfeldes. Nur eine klare Minderheit sieht die GeForce GTX 580 somit als potentielles Kaufobjekt an: Dies sind 25 Prozent unter den gegenüber der Karte generell positiv eingestellten Umfrageteilnehmern bzw. nur 10 Prozent der insgesamten Umfrageteilnehmer. Andererseits ist es nichts ungewöhnliches, wenn eine derart teure Karte nur für einen Bruchteil des Marktes eine interessante Option darstellt.

Bei den durchschnittlich bzw. negativ gegenüber der GeForce GTX 580 eingestellten Umfrageteilnehmern interessiert natürlich vor allem deren Begründung: Daß die neue nVidia-Karte keine entscheidende Mehrperformance bietet bzw. daß die Preislage zu hoch ist, melden jeweils rund ein Viertel dieser Umfrageteilnehmer an – während mit 43 Prozent die Mehrheit den immer noch zu hohen Verbrauch als Hauptproblem der GeForce GTX 580 bemängelt. Hieran wird nVidia arbeiten müssen, wenn man mit zukünftigen HighEnd-Grafikkarten wieder ein größeres Publikum ansprechen will – zwar interessiert der Verbrauch viele (nicht alle) HighEnd-User nur sekundär, aber in der Breite des Marktes ist der Verbrauch ein inzwischen elementares Thema. Und wenn dann Grafikkarten wie die GeForce GTX 580 unter Last gleich mal doppelt so viel wie die schnellsten derzeit verfügbaren Prozessoren verbrauchen, ist das für große Teile der Grafikkarten-Käuferschaft einfach jenseits von gut und böse.

Die PC Games Hardware berichten zur kommenden DualChip-Grafikkarte von nVidia, daß diese nicht auf dem GF104-Chip, sondern dem GF110-Chip basieren soll. Daß dazu gezeigte Bild einer DualChip-Lösung mit zwei GF110-Chips und 3 GB Speicher auf einer Platine scheint dies zu bestätigen. Unklar ist allerdings, wie nVidia dies mit der Verlustleistung regeln will: Eine einzelne GeForce GTX 580 verbraucht unter Spielen schon ihre 247 Watt – da bleibt nur arg wenig Platz, will man nicht die (bisher übliche) 375-Watt-Grenze sprengen (ergibt sich durch den PCI Express Steckplatz mit 75 Watt und zwei 8poligen Stromsteckern mit jeweils 150 Watt). Im genauen macht eine GF110-basierte DualChip-Grafikkarte bis maximal 375 Watt nämlich erst einmal wenig Sinn: Viel mehr als 340 Watt Spieleverbrauch darf man nicht erreichen, wenn man die 375-Watt-Grenze unterbieten will (die Differenz muß einfach als Reserve verbleiben) – was dann gerade einmal 38 Prozent mehr als bei der GeForce GTX 580 wären.

Im Idealfall – und diesen erreicht man bei DualChip-Lösungen eigentlich nie – könnte eine GF110-basierte DualChip-Karte dann gerade einmal diese 38 Prozent schneller sein als die GeForce GTX 580. Dies mag möglicherweise dazu ausreichen, um nVidias Primärziel im Zweikampf gegen AMDs kommende DualChip-Lösung Radeon HD 6990 zu erreichen, aber für den Grafikkartenkäufer wäre dieser Sprung gegenüber der GeForce GTX 580 doch deutlich zu wenig. Die einzige Möglichkeit, die Verlustleistung stärker als erwartet abzusenken, wären besonders niedrige Taktraten der DualChip-Lösung, welche dann in klar niedrigeren Spannungen resultieren – da sich Spannungen immer im Quadrat auf die Leistungsaufnahme auswirken, kann man hiermit viel bewirken. Denkbar wäre eine Konstellation, wo die GF110-basierte DualChip-Lösung mit 480 oder 512 Shader-Einheiten (und damit nahezu im Vollausbau) antritt, aber die Taktraten ganz deutlich auf sagen wir 600 MHz Chiptakt abgesenkt sind.

Mit den dafür machbaren niedrigeren Spannungen könnte man den Stromhunger des GF110-Chips wahrscheinlich ausreichend stark zügeln, um im Spieleverbrauch die vorgenannten 340 Watt nicht zu überschreiten. Von der Performance her sind zwei GF110-Chips auf 600 MHz Chiptakt aber auch niemals in der Nähe der doppelten Performance der GeForce GTX 580 einzuordnen – es wird schon knapp, überhaupt 50 Prozent mehr als die GeForce GTX 580 auf die Waage zu bringen, was sicherlich das Mindestziel zur Gesichtswahrung gegenüber den Grafikkartenkäufern sein muß. Irgendwie ist die ganze Sache noch sehr zweifelhaft und es erscheint uns als wirklich einfacher, eine DualChip-Karte mit 30-40 Prozent Mehrperformance gegenüber der GeForce GTX 580 auf Basis des GF104-Chips (im Vollausbau und mit klar höheren Taktraten) auf die Beine zu stellen als mit dem GF110-Chip. Letzterer würde sich für den DualChip-Betrieb nur wirklich eigenen, wenn man sich über die 375-Watt-Grenze hinwegsetzt – wobei abzuwarten bleibt, ob sich nVidia auf dieses bis dato unerforschte Gebiet vorwagt.

AMD scheint es mit der Radeon HD 6990 DualChip-Lösung auf Basis des RV970/Cayman-Chips da deutlich einfacher zu haben, da dieser Chip – wenn die Informationen über die 1536 Shader-Einheiten zutreffen sind – dann doch nicht so viel verbrauchen wird, wie einst noch angenommen. Sicherlich wird AMD bei der SingleChip-Lösung Radeon HD 6970 erstmals einen 6poligen und einen 8poligen Stromanschluß verbauen, was eine TDP im Bereich von 225 bis 300 Watt ermöglicht. Allerdings denken wir auf Basis der vorliegenden Hardware-Daten, daß dies eher eine Vorsichtsmaßnahme ist und die Radeon HD 6970 gar nicht so viel mehr als die Radeon HD 6870 verbrauchen wird. Aufgrund der Hardware-Daten gehen wir von einer Mehrperformance der Radeon HD 6970 gegenüber der Radeon HD 6870 von ca. 20 Prozent aus, was bei einer weiteren Verbesserung der Fertigung (wie zwischen GF100- und GF110-Chip) vielleicht nur 10 Prozent Mehrverbrauch gegenüber der Radeon HD 6870 ergibt – die Radeon HD 6970 läge dann bei ca. 205 Watt Spieleverbrauch.

Hiervon ausgehend eine DualChip-Lösung in Form der Radeon HD 6990 zu realisieren, deren Spieleverbrauch nicht höher als 340 Watt kommt, ist eine deutlich einfachere Aufgabe – dafür dürften schlicht ein paar niedrigere Taktraten (wie schon bei der Radeon HD 5970) ausreichend sein (hinzu kommt der Effekt, daß eine DualChip-Lösung auf einer einzigen Platine immer etwas weniger verbraucht als wenn man einfach zwei Platinen aneinanderschraubt). Eine solche Radeon HD 6990 sollte sich von der Performance her dann auch deutlich von der Radeon HD 6970 absetzen können – auch wenn es niemals gleich das Doppelte sein wird. Wie Fudzilla berichten, wird es beide DualChip-Lösungen allerdings erst im neuen Jahr geben: AMD hat die Radeon HD 6990 sowieso schon auf den Januar verschoben – und nVidia kann angeblich, will aber noch nicht, sondern wartet erst AMDs Radeon HD 6990 ab. Hier liegt natürlich wieder der Gedanke dahinter, daß wenn sich die Konkurrenz final offenbart hat, man umso besser reagieren kann – eventuell mit noch etwas höheren Taktraten – um das Ziel der absoluten Performance-Krone auch sicher zu erreichen.