- Startseite

- News

- 7-Tage-News

- Linklisten der News

- Newsindex-Übersicht

- AMD RDNA3

- AMD RDNA4

- AMD RDNA5

- Intel Xe

- Intel Battlemage

- Intel Celestial

- nVidia Ada Lovelace

- nVidia Blackwell

- nVidia Rubin

- AMD Zen 4

- AMD Zen 5

- AMD Zen 6

- Intel Raptor Lake

- Intel Meteor Lake

- Intel Lunar Lake

- Intel Arrow Lake

- Intel Panther Lake

- Intel Nova Lake

- Artikel

- Downloads

Hauptlinks

Suchen

Aktuelle Treiber

- 576.88

- 25.6.3

- 32.0.101.6913

4

News des 4. Juli 2025

News des 4. Juli 2025

Laut YouTuber Moore's Law Is Dead steht für "Zen 6 X3D" eine Vergrößerung des 3D V-Caches an – von bisher 64 auf dann 96 MB pro Cache-Slice. Zudem wird es mittels Zen 6 technisch möglich sein, jene Cache-Slices zu stappeln, theoretisch könnte somit auch ein Consumer-Modell mit 12 CPU-Kernen und 240 MB Level3-Cache erscheinen (2x 96 MB per 3D V-Cache und 48 MB auf dem Prozessoren-Die selber). Ob diese Möglichkeit tatsächlich für Consumer-Modelle genutzt werden wird, dürfte derzeit offen sein bzw. sollte man generell besser davon ausgehen, dass diese Möglichkeit eher für die Server-Prozessoren von AMD gedacht ist. AMD hat damit natürlich immer noch die Option in der Hinterhand, dass sollte Intel in irgendeiner Form AMD zu nahe kommen bei der Spiele-Performance, man mit diesem 240-MB-Cache-Ungetüm als extra Halo-Modell anrückt. Für die normalen Zen 6 X3D-Modelle dürfte hingegen gelten: Bis zum 12-Kerner gibt es (bei X3D) 144 MB Level3-Cache, bis zum 24-Kerner dann 192 MB. Dies ist auch so eine kräftige Steigerung gegenüber dem Ist-Zustand (bis 8C gibt es 96 MB L3, bis 16C dann 128 MB L3).

I can confirm 96MB of Cache per V-Cache layer, and that your prior leaks stating Zen 6 can stack multiple layers is correct. Like your other sources, I have no proof AMD will give 2-Hi X3D to consumers, but I can say its possible for a 12-Core 240MB L3 Zen 6 gaming chip to exist!

Quelle: Aussage einer Industriequelle gegenüber Moore's Law Is Dead @ YouTube, veröffentlicht am 3. Juli 2025

3

News des 3. Juli 2025

News des 3. Juli 2025

Breit berichtet wird derzeit über die Abneigung der DIY-Käufer gegenüber 8-GB-Grafikkarten, ausgehend von einer (zuletzt schon verlinkten) Berichterstattung seitens TechPowerUp. Dies läßt sich derzeit gut ermessen anhand der Mindfactory-Verkaufszahlen von Radeon RX 9060 XT und GeForce RTX 5060 Ti, deren 8-GB- und 16-GB-Ausführungen jeweils am gleichen Tag in den Markt gekommen sind. Bei der oftmals zu lesenden Verkaufsverhältnis-Bildung wird allerdings zumeist übersehen, dass die Mindfactory ihre Verkaufszahlen immer nur als "über xx Stück" angibt. Dort notierte 20 Stück Verkaufsmenge entsprechen real einem Wert zwischen 21 und 30 Stück, gemittelt somit 26 Stück. Dies ergibt jeweils leicht andere Rechnungen und hat insbesondere beachtbare Auswirkungen auf Grafikkarten mit eher geringen Verkaufszahlen – dort ist der Anteil der "vergessenen" Verkäufe automatisch höher. Dies macht beispielsweise aus einem nominellen Verkaufsverhältnis bei der Radeon RX 9060 XT 8GB vs 16 GB von derzeit 1:33 ein reales Verkaufsverhältnis von 1:21.

| Mindfactory-Verkäufe | Radeon RX 9060 XT | GeForce RTX 5060 Ti |

|---|---|---|

| nominelle MF-Verkaufsmenge 8GB vs 16GB | 30 vs 990 Stück | 115 vs 1625 Stück |

| nominelles Verhältnis 8GB vs 16GB | 1:33 | 1:14 |

| reale MF-Verkaufsmenge 8GB vs 16GB | ~50 vs ~1070 Stück | ~160 vs ~1690 Stück |

| reales Verhältnis 8GB vs 16GB | 1:21 | 1:11 |

| Verkaufsstart | 5. Juni 2025 (vor 28 Tagen) | 16. April 2025 (vor 78 Tagen) |

| MF-Verkäufe pro Tag | ~38 Stück pro Tag | ~23 Stück pro Tag |

| gemäß der öffentlich einsehbaren Verkaufsstatistik der Mindfactory zum 3. Juli 2025 | ||

2

News des 2. Juli 2025

News des 2. Juli 2025

Laut einem breit beachteten YouTube-Video von Hardware Unboxed hat die Radeon RX 9070 XT mit den neuesten Treibern ihren kleinen Performance-Rückstand unter Raster-Rendering gegenüber der GeForce RTX 5070 Ti inzwischen aufgeholt und liegt unter WQHD sogar leicht um +3,3% vorn, unter der 4K-Auflösung ergibt sich hingegen ein Gleichstand (das nVidia-Modell wurde natürlich auch mit aktualisierten Treibern getestet). Zum Stand des gemeinsamen Launch belief sich die Differenz hingegen auf +2,6% (WQHD) bzw. +1,4% (4K), jeweils allerdings zugunsten der nVidia-Karte. Dabei haben beide Karten mit aktualisierten Treibern inzwischen an Performance hinzugewonnen, gerade unter der WQHD-Auflösung allerdings mit sehr abweichender Differenz zum Launch-Treiber: Die GeForce RTX 5070 Ti gewann gegenüber dem Stand vom Launch um +2,5% hinzu, die Radeon RX 9070 XT hingegen um gleich +9% – deswegen dann auch das nunmehr glatt umgekehrte Performance-Bild unter diesem Setting.

| Radeon RX 9070 XT vs GeForce RTX 5070 Ti | WQHD Raster | 4K Raster | WQHD RayTr. | 4K RayTr. |

|---|---|---|---|---|

| Hardware Unboxed: Launchreview (März) | +2,6% | +1,4% | +26,5% | +34,2% |

| Hardware Unboxed: aktuelle Treiber (Juli) | +3,3% | ±0 | ||

| Durchschnitt 14 Launchreviews (März) | +2,6% | +3,4% | +19,4% | +20,2% |

| Quellen: Hardware Unboxed @ YouTube sowie Launch-Analyse GeForce RTX 5070 vs Radeon RX 9070 (XT) | ||||

1

News des 1. Juli 2025

News des 1. Juli 2025

Mittels des neuen GeForce-Treibers 576.88 hat nVidia die GeForce RTX 5050 faktisch bereits am 1. Juli veröffentlicht – denn der neue Treiber bringt den Support für dieses Einsteiger-Modell mit sich und selbiges bietet nVidia (in öffentlicher Form) gewöhnlich erst am Launchtag. In China kann die Karte wohl auch schon vorbestellt werden, wenngleich für die westliche Welt wohl weiterhin ein unbestimmter Termin in der zweiten Juli-Hälfte gelten dürfte. nVidia wird es dabei durchaus in den Kram passen, dass dies alles ein wenig unbestimmt ist, denn sicherlich wünscht man sich zu dieser Karte eher weniger mediale Begleitung – zu gewinnen gibt es hiermit schließlich nichts. Dennoch gab es seitens Inno3D @ Weibo einen ersten Testbericht, aus welchem VideoCardz die interessanten Details abgepinselt haben. Unter Spielen liegt nVidias neues Einsteiger-Modell gemäß dieser Inno3D-Bbenchmarks um ca. –5% gegenüber der GeForce RTX 4060 zurück, unter den 3DMarks sieht es etwas besser aus und es kommt grob ein Gleichstand heraus.

| GeForce RTX 4060 | GeForce RTX 5050 | |

|---|---|---|

| Chipbasis | nVidia AD107 | nVidia GB207 |

| Fertigung | 18,9 Mrd. Transistoren auf 159mm² in der 5nm-Fertigung von TSMC | 16,9 Mrd. Transistoren auf (geschätzt) ~140-150mm² in der 4nm-Fertigung von TSMC |

| Hardware | 3 RE, 24 SM @ 128-bit, 24MB L2 | 2 RE, 20 SM @ 128-bit, ?MB L2 |

| Speicher | 8 GB GDDR6 | 8 GB GDDR6 |

| Taktraten | 1830/2460 MHz & 17 Gbps | 2317/2572 MHz & 20 Gbps |

| TDP | 115W | 130W |

| FHD-Perf lt. Inno3D | 100% | ~95% |

| FHD Perf-Index | 1390% | geschätzt ~1250-1320% |

| Listenpreis | $299 / 329€ | $249 / 259€ |

| Release | 29. Juni 2023 | Juli 2025 |

30

News des 30. Juni 2025

News des 30. Juni 2025

Aus dem Entwicklerforum für nVidias Linux-Treiber kommt der brandfrische Hinweis darauf, dass (unter Linux) in absehbarer Zeit das Support-Ende für Maxwell & Pascal droht. Dies soll nach dem 580er Treiber-Zweig von nVidia passieren, welcher nicht mehr all zu weit entfernt liegen dürfte, denn auch unter Linux ist nVidia derzeit bereits schon im 570er Nummernkreis angekommen. Nominell ergibt sich hieraus natürlich noch keine definitive Aussage bezüglich der entsprechenden Windows-Treiber, aber da die Entwicklung von Windows- und Linux-Treibern bei nVidia inzwischen halbwegs gleichförmig abläuft, läßt sich zumindest der starke Verdacht äußern, dass mit dieser Ankündigung dann auch das Treiber-Ende von Maxwell- und Pascal-basierten Grafikkarten unter Windows droht – und dies in absehbarer Zeit, möglicherweise noch in diesem Jahr. Damit würde nVidia dann die bislang immer noch mit neuen Treibern unterstützten Grafikkarten-Serien GeForce GTX 900 und GeForce GTX 10 dem alten Eisen zuschieben.

The first post has been updated to note that the release 580 series will be the last to support GPUs based on the Maxwell, Pascal, and Volta architectures.

Quelle: aplattner im NVIDIA Developer Forums am 1. Juli 2025

29

News des 28./29. Juni 2025

News des 28./29. Juni 2025

Als Nachtrag zu den kürzlichen Spezifikationen des RTX50-Refreshs läßt sich noch eine erste, allerdings unsichere Preisinformation zum RTX50-Refresh seitens RedGamingTech anfügen. Selbst bei der Quelle wird jene als "nur mit einer Wagenladung Salz zu nehmen" bezeichnet, generell sind zudem die dort genannten weiteren Grafikkarten-Modelle arg unwahrscheinlich: Eine "GeForce RTX 5030" (als GB207-Salvage) wäre ja vielleicht noch denkbar, aber mit nur 6 GB Grafikkartenspeicher wird sich nVidia kaum vorwagen können. Und eine "GeForce RTX 5060 Super" mit 12 GB VRAM kannabalisiert die GeForce RTX 5060 Ti einfach zu stark, im Mainstream-Bereich ist der "SUPER"-Refresh bei der aktuellen Portfolio-Konstruktion nur schwerlich fortzusetzen. Insofern ist gleichfalls vakant, ob die genannten Preisinformationen belastbar sind. Jene sehen im übrigen sogar eine Preiserhöhung beim "SUPER"-Refresh vor: +50$ bei der 5070S, +100$ bei der 5070TiS und +150$ bei der 5080S auf die Listenpreise der non-SUPER-Modelle oben drauf.

RTX 5080 Super 84 sm 24 gb $1149

RTX 5070 Ti Super 70 sm 24 gb $849

RTX 5070 Super 50 sm 18 gb $599

RTX 5060 Super 32 sm 12 gb $349

RTX 5030 16 sm 6 gb $179

Quelle: RedGamingTech am 29. Juni 2025

29

Gerüchteküche: Die Grund-Spezifikationen zu GeForce RTX 5070 Super, 5070 Ti Super & 5080 Super

Gerüchteküche: Die Grund-Spezifikationen zu GeForce RTX 5070 Super, 5070 Ti Super & 5080 Super

Der bekannte Leaker 'Kopite7kimi' hat auf X/Twitter nunmehr auch noch die Grund-Spezifikationen von GeForce RTX 5070 Super und GeForce RTX 5070 Ti Super genannt – letztere wurde bereits als weiteres Refresh-Modell vermutet, was sich hiermit bestätigt. Hinzu gab es zur GeForce RTX 5080 Super eine Ergänzung des bereits geleakten, womit die GeForce RTX 50 "SUPER" Refresh-Serie nunmehr in ihren Grundzügen steht. Wie ebenfalls erwartet, ist die Erweiterung des Grafikkartenspeicher deren großes Thema, den Mehrspeicher wird es auch für die GeForce RTX 5070 Ti Super (und damit für alle drei Modelle) geben. Bei allen anderen Dingen hat sich nVidia jedoch auffallend zurückgehalten: So wird durchgehend derselbe Grafikchip angesetzt, gibt es auch nur im Fall der GeForce RTX 5070 Super den Mager-Sprung von 48 auf 50 Shader-Cluster und ansonsten eigentlich nirgendwo mehr Hardware. Augenscheinlich versucht nVidia dies dann über höhere TDPs ein wenig auszugleichen, welche höhere reale Chiptaktraten ermöglichen sollten – sofern es die Grafikchips mitmachen.

|

|

|

29

Gerüchteküche: "Nova Lake" laut Intel mit +10% Singlethread- und +60% Multithread-Performancegewinn

Gerüchteküche: "Nova Lake" laut Intel mit +10% Singlethread- und +60% Multithread-Performancegewinn

Von Game.Keeps.Loading @ X kommt der Leak des Ausschnitts einer augenscheinlichen Intel-Folie, welche die Performance der kommenden Intel-Architektur "Nova Lake" beschreiben soll. Die Folie selber erscheint als im typischen Intel-Stil gestaltet, allerdings ist der Ausschnitt natürlich auch wieder so klein, dass man dies locker & leicht auch fälschen könnte – Gewißheiten können sich hieraus also leider noch nicht ergeben. Ist die Folie echt, dann verspricht Intel hiermit einen Singlethread-Performancegewinn von größer als +10% sowie einen MultiThread-Performancegewinn von +60%, dies höchstwahrscheinlich auf den Nova-Lake-Vorgänger "Arrow Lake" bezogen. All dies ist natürlich ein wenig Auslegungssache, da nicht die komplette Folie vorliegt und man demzufolge in einigen Punkten & Relationen einfach nur gut raten muß. Allerdings passt der 60%ige Multithread-Performancegewinn sehr wohl zur viel höheren Kern-Anzahl von "Nova Lake", wo Intel in der Spitze bis zu 52 CPU-Kerne liefern will (leicht mehr als das Doppelte gegenüber Arrow Lake).

27

News des 27. Juni 2025

News des 27. Juni 2025

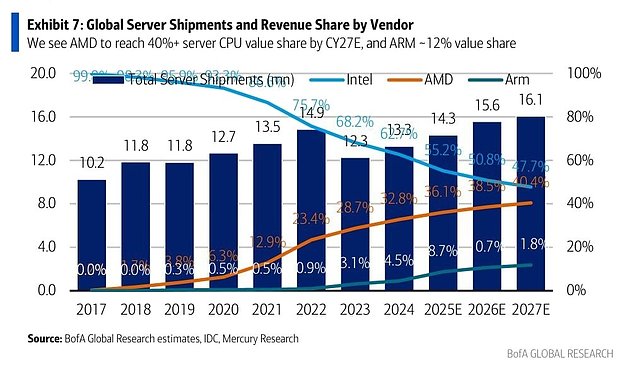

Weit beachtet wird derzeit eine von Jukan Choi @ X verbreitete Info-Grafik zu den Server-Marktanteilen 2017-2027, die letzteren Jahre dann natürlich als reine Prognose angegeben. Zu beachten wäre an der Grafik, dass die Balken den absoluten Stückzahlen-Absatz an Servern (in Mio. Stück) angeben, die Prozentwerte und Linien sich hingegen auf die Umsatz-Marktanteile (nicht Stückzahlen-Marktanteile) von AMD, ARM und Intel beziehen. Damit fällt dann auch ins Gewicht, dass die durchschnittlichen Absatzpreise von Server-Prozessoren bei AMD deutlich höher als bei Intel liegen (zuletzt um 74% höher als bei Intel), was beim Blick auf die reinen Stückzahlen-Marktanteile unterbuttert werden würde. Für Intel ist der harsche Rückgang der Marktanteile allerdings vor allem deswegen besonders schmerzhaft, weil der insgesamte Markt nur maßvoll gewachsen ist – von 2018 bis 2024 nur um +13%. Marktanteile im einem rasant wachsenden Markt abzugeben muß unter Umständen kein Problem sein (man könnte dennoch selber mehr absetzen), aber in einem nur schwach wachsenden Markt erhebliche Marktanteile zu verlieren bedeutet zwingend, dass man selber (in absoluten Zahlen) bedeutsam weniger umsetzt.

26

News des 26. Juni 2025

News des 26. Juni 2025

Die PC Games Hardware hat sich mit der Grafikkarten-Performance unter "Doom: The Dark Ages" auf PathTracing beschäftigt, nachdem das entsprechende Update letzte Woche erschienen ist. Hiermit läßt sich "überschüssige" Performance sehr gut in (hoffentlich) mehr Bildqualität umwandeln, wobei unpassende Hardware oder/und kleinere wie mittlere Hardware dabei schnell in Performance-Schwierigkeiten gerät. Das ganze ist somit eher eine Sache für absolute HighEnd-Boliden wie GeForce RTX 4090 & 5090, selbst bei diesen geht die Framerate unter PathTracing (trotz Einsatz von DLSS) allerdings nur noch auf ein gutklassiges Niveau zurück. Beachtenswert sind zudem die erheblichen Differenzen zwischen den Hardware-Ansätzen: Ältere nVidia-Beschleuniger (GeForce RTX 3090) sowie die AMD-Beschleuniger (Radeon RX 9070 XT) verlieren weit mehr unter PathTracing als die letzten beiden nVidia-Generationen (RTX40 & RTX50), dies macht dann sogar den Unterschied zwischen "spielbar" und "nicht spielbar" aus.

| Doom: The Dark Ages | WQHD RT | WQHD PT | Diff. | 4K RT | 4K PT | Diff. |

|---|---|---|---|---|---|---|

| MSI RTX 5090 Suprim Liquid SOC (max OC) | 150,5 fps | 86,4 fps | –43% | 108,7 fps | 54,5 fps | –50% |

| Gigabyte RTX 4090 Gaming OC | 129,5 fps | 61,3 fps | –53% | 87,3 fps | 36,5 fps | –58% |

| Gigabyte Aorus RTX 5070 Ti Master | 96,4 fps | 47,9 fps | –50% | 62,0 fps | 26,6 fps | –57% |

| Sapphire RX 9070 XT Nitro+ | 108,6 fps | 29,1 fps | –73% | 68,7 fps | 15,4 fps | –78% |

| EVGA RTX 3090 Ti FTW3 Ultra | 81,8 fps | 26,7 fps | –67% | 52,9 fps | 14,5 fps | –73% |

| gemäß der Benchmarks der PC Games Hardware unter Doom: The Dark Ages | ||||||