Hauptlinks

Suchen

nVidia-Grafik

Gerüchteküche: nVidia begegnet der Speicherkrise mit Lieferpriorisierungen im RTX50-Portfolio

Die jüngste Verwirrung über zukünftige Lieferungen zur GeForce RTX 5070 Ti läßt sich vielleicht generell klären, wenn man jene Informationen berücksichtigt, welche HKEPC @ Facebook (via VideoCardz) aus Herstellerkreisen erhalten haben. Danach priorisiert nVidia neuerdings innerhalb seines GeForce RTX 50 Grafikkarten-Portfolios gewisse Modelle – welche also dann, wenn der benötigte GDDR-Speicher knapp wird, vorzugsweise bedient und somit beliefert werden. Jene Priorisierung richtet sich nach der einfachen Formel: Bei gleichem Modell das mit weniger VRAM, bei gleicher Speichermenge das mit höherer Performance. Dies geht zum einen zugunsten der VRAM-armen Modelle, und zum anderen zugunsten der teuren Grafikkarten – wo es sich (wegen des höheren Verkaufspreises) natürlich am ehesten lohnt, die größeren Speichermengen anzubringen.

nVidia's current policy is:

Same SKU, Less RAM.

Same Memory, Higher SKU.

Quelle: HKEPC @ Facebook am 15. Januar 2026

Neuer Artikel: Das Hardware-Jahr 2026 in der Vorschau

Das Hardware-Jahr 2025 ist vorüber – und lieferte mit Abstrichen durchaus das, was vorab prognostiziert wurde. Fehlend war eigentlich nur der richtige Start des N1X/GB10-Projekts von nVidia & MediaTek, wo nVidia inzwischen zwar GB10-basierte Mini-PCs ausliefert, aber die eigentlich relevante Serie an N1-SoCs ins Jahr 2026 verschoben wurde. Ähnliches gilt für Intels Panther Lake und Qualcomms Snapdragon X2, welche zwar tatsächlich noch 2025 vorgestellt wurden, nun aber erst 2026 den Markt erreichen werden. Regelrecht neue Hardware-Projekte für 2026 sind hingegen vor allem AMDs Zen 6 und Intels Nova Lake, was einen schönen CPU-Showdown zum Jahresende ergeben dürfte. Auf Grafik-Seite scheint 2026 hingegen sehr mager zu werden, auf AMD-Seite steht wohl gar nichts an, bei nVidia hängt der GeForce RTX 50 "SUPER"-Refresh in der Schwebe und somit bleibt nur Intels Arc B700 Serie als (halbwegs) sichere Neuvorstellung für 2026 übrig ... zum Artikel.

| Jahresstart 2026 | Frühling 2026 | Sommer 2026 | Herbst 2026 | Jahresende 2026 | erst 2027 | |

|---|---|---|---|---|---|---|

| AMD Prozessoren | Gorgon Point, neue X3D-Modelle | Ryzen 9000G | Zen 6 (Desktop) | Zen 6 Mobile | ||

| AMD Grafikchips | RDNA5 | |||||

| nVidia Grafikchips | RTX50-Refresh (?) | Rubin (Consumer) | ||||

| Intel Grafikchips | Arc B700-Serie | Celestial | ||||

| Intel Prozessoren | Panther Lake, Arrow Lake Refresh | Nova Lake (Desktop) | Nova Lake Mobile | |||

| MediaTek Prozessoren | N1-Serie | |||||

| Qualcomm Prozessoren | Snapdragon X2 | |||||

| Hinweis: Angaben zu noch nicht offiziell vorgestellter Hardware basieren auf Gerüchten & Annahmen | ||||||

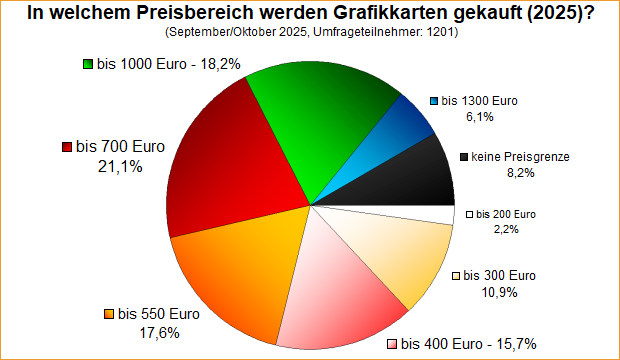

Umfrage-Auswertung: In welchem Preisbereich werden Grafikkarten gekauft (2025)?

Mit einer Umfrage von diesem September ging es um den üblichen Preisbereich beim Grafikkarten-Kauf, in Wiederholung ähnlicher Umfragen von 2019 und von 2016. Mittels des größeren zeitlichen Sprungs hat sich einiges verändert, denn hörten die Umfragen seinerzeit bei 700 Euro auf und ergaben sich durchschnittliche Preislagen von (interpoliert) ca. 410 bzw. ca. 340 Euro, ist nunmehr wie zu sehen und auch allgemein bekannt alles sehr viel teurer geworden. Somit fängt die Umfrage auch nicht mehr bei nur (bis zu) 100 Euro an, sondern erst bei (bis zu) 200 Euro – und trotzdem liegen in dieser Gruppe heuer nur 2,2% der Umfrageteilnehmer. Oberhalb dessen ist die Antwortverteilung dann allerdings ziemlich breit, alle Preiskategorien von 300 bis 1000 Euro laufen mit einer zweistelligen Prozentzahl an Nutzerzuspruch durchs Ziel.

Sapphire wünscht sich wieder mehr Freiheit bei Grafikkarten-Designs

Im Interview mit Hardware Unboxed @ YouTube (via VideoCardz) hat Sapphires PR-Manager für Nordamerika, Edward Crisler, eine Lanze für mehr Designfreiheit der Grafikkarten-Hersteller gebrochen. Zumindest Sapphire will wieder mehr abweichende Grafikkarten entwickeln, so auch dem Namen würdige "Toxic"-Modelle. Der Hintergrund dessen ist, dass AMD und nVidia den Grafikkarten-Hersteller inzwischen sehr enge Vorgaben zum Aufbau einer Grafikkarte an die Hand geben – und über das Mittel der vom Grafikchip-Entwickler gelieferten (zertifizierten) BIOS-Versionen ein direktes Druckmittel haben, sollten die Vorgaben von AMD & nVidia nicht erfüllt werden. Somit basieren viele Grafikkarten inzwischen auf engen Vorgaben, wie die Grafikchips (maximal) getaktet werden dürfen, welches maximale Powerlimit es geben darf, gibt es oft verwendete Referenzplatinen und fest gelieferten Speicher. Wie der Sapphire-Manager notiert, sind die Grafikkarten-Hersteller somit in der Praxis primär zu Kühlerentwicklern geworden. Hinzu kommt teilweise noch eine andere Platine, aber auch für diese gibt es wohl einige bindende Vorgaben seitens AMD & nVidia.

Sometimes I really wish the chip makers would get out of the way and let us partners just make our cards. Give us the chip. Give us the RAM. Tell us what we have to provide to make it work with the board. And then let us make the cards. Let us have our fun. Let us go nuts. Let there be real differentiation. Sometimes it feels like this market becomes too too much the same.

Quelle: Edward Crisler, Sapphires PR-Manager für Nordamerika, gegenüber Hardware Unboxed @ YouTube am 12. Dezember 2025, niedergeschrieben von VideoCardz

Die Grafikchip- und Grafikkarten-Marktanteile im dritten Quartal 2025

Jon Peddie Research vermelden die neuesten Zahlen zum Markt an Desktop-Grafikkarten (AiB = Add-in Boards) für das dritte Quartal 2025. In diesem Zeitraum sollen sich 12,02 Mio. Desktop-Grafikkarten des PC-Bereichs verkauft haben, was Consumer- und Profi-Modelle einschließt, jedoch nicht steckbare bzw. ausschließlich in Rack-Bauweise verfügbare KI-Beschleuniger ausschließt. Diskrete Mobile-Beschleuniger werden hiermit auch nicht erfasst bzw. fallen in den (kostenpflichtigen) Reports von JPR in eine eigene Kategorie ("mobile dGPU"). Die Marktverteilung veränderte sich gegenüber dem letzten Quartal nur marginal, AMD wird somit weiterhin (mit 7%) sehr niedrig gezählt, gleichfalls sieht die nVidia-Zahl mit derzeit 92% weiterhin nach totaler Marktdominanz aus. Auch für dieses Quartal kommt Intel nicht wirklich vom Fleck, auch wenn es mal für (gerundet) 1% Marktanteil reicht.

| Desktop dGPU | Q3/2024 | Q4/2024 | Q1/2025 | Q2/2025 | Q3/2025 |

|---|---|---|---|---|---|

| Auslieferungsmenge | 8,1 Mio. Stück | 8,4 Mio. Stück | 9,2 Mio. Stück | 11,6 Mio. Stück | 12,02 Mio. Stück |

| AMD | 10% (~0,8M) | 15% (~1,3M) | 8% (~0,7M) | 6% (~0,7M) | 7% (~0,8M) |

| nVidia | 90% (~7,3M) | 84% (~7,0M) | 92% (~8,5M) | 94% (~10,9M) | 92% (~11,1M) |

| Intel | 0% (<0,05M) | 1% (~0,1M) | 0% (<0,05M) | 0% (<0,06M) | 1% (~0,1M) |

| Marktanteile basierend auf ausgelieferten Stückzahlen, Quelle: Jon Peddie Research | |||||

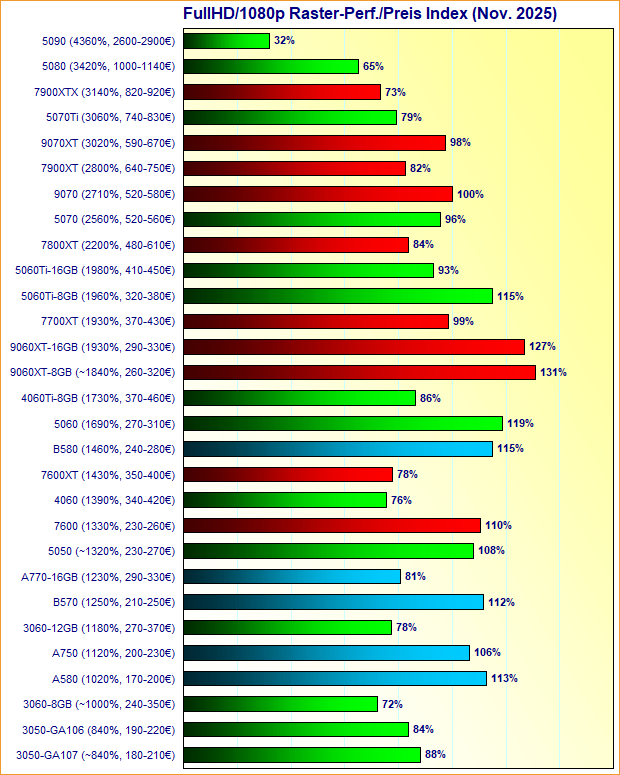

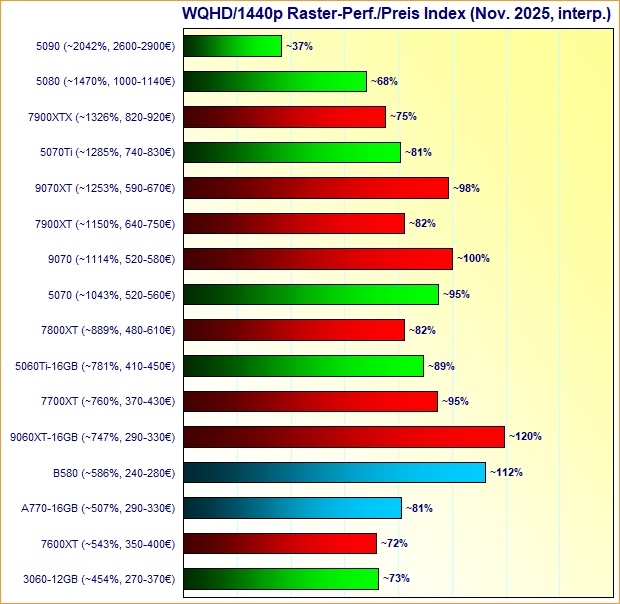

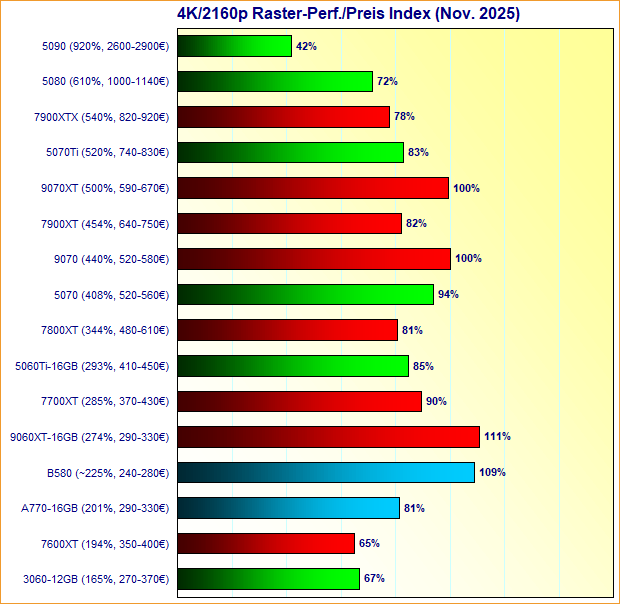

Neuer Artikel: Grafikkarten-Marktüberblick November 2025

Leider etwas eingeschlafen ist die Tradition der Grafikkarten-Marktüberblicke – zu welchem sich während des ersten Halbjahrs 2025 wegen ständiger Neuerscheinungen und zum Teil auch mangelhafter Lieferbarkeit kein Anlaß bot, was jedoch spätestens seit dem Sommer vermisst wurde und hiermit nachgeholt wird. Der aktuelle Preisüberblick ist demzufolge heftig gewandelt gegenüber dem vorherigen vom Oktober 2024: Seinerzeit waren Radeon RX 9000 und GeForce RTX 50 noch nicht auf dem Markt, dafür gab es sogar noch beachtbare Posten der Radeon RX 6000 und GeForce RTX 30 Serien im Einzelhandel, neben den seinerzeit dominierenden Radeon RX 7000 und GeForce RTX 40 Serien. Davon ist derzeit nur wenig erhalten geblieben, inzwischen ist der Markt komplett in der Hand der neuen Grafikkarten-Serie von AMD & nVidia, sind die verfügbaren Angebote zu älteren Grafikkarten in den meisten Fällen auch nicht mehr gut genug, um noch beachtet zu werden ... zum Artikel.

Gerüchteküche: Streichung oder Verschiebung des GeForce RTX 50 "SUPER" Refreshs?

Laut Uniko's Hardware @ X gibt es das Gerücht einer Streichung des RTX50-Refreshs, basierend auf einer Knappheit an den dafür notwendigen 3-GByte-Speicherchips von GDDR7. Jene werden für alle drei Refresh-Modelle benötigt und kommen bislang nur bei der GeForce RTX 5090 Laptop sowie der Profi-Lösung "RTX Pro 6000" zum Einsatz. Selbige sind keine echten Volumen-Produkte, womit nVidia für den RTX50-Refresh sicherlich eine gänzlich andere Menge dieser 3-GByte-Speicherchips benötigen wird. Allerdings dürfte nVidia dies normalerweise ausreichend vorgeplant haben und als fast einziger Abnehmer dieser (speziellen) Speicherchips auch das beste Wissen haben, was da an Fertigungsmengen geht bzw. was dafür in Zukunft aufgelegt wird. Dass man da also plötzlich von einer Mitteilung des Speicherherstellers überrascht würde, es gäbe keine zusätzlichen 3-GByte-Speicherchips von GDDR7, ist doch eher unwahrscheinlich. Sicherlich hat man sich deren Fertigung rechtzeitig vorher vertraglich zusichern lassen, anders geht es kaum bei dieser geringen Hersteller-Wahlmöglichkeit und als faktisch einziger Abnehmer.

[rumor]

due to the crazy shortage recently, 3gb gddr7 cant make it to the consumer market for desktop, thus the super series is cancelled.

Quelle: Uniko's Hardware @ X am 7. November 2025

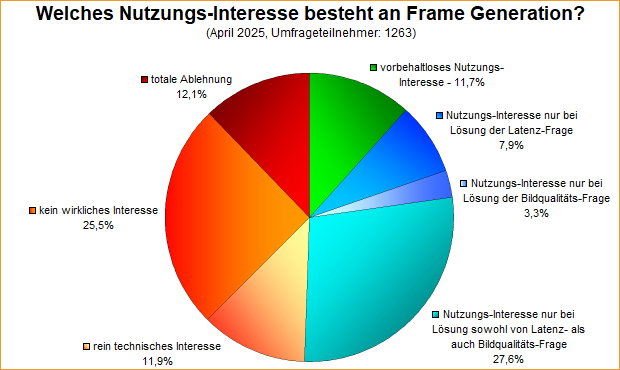

Umfrage-Auswertung: Welches Nutzungs-Interesse besteht an Frame Generation?

Mittels einer Umfrage von diesem April wurde nach dem Nutzungs-Interesse an Frame Generation gefragt, im Zuge der zunehmenden Bedeutung bzw. Anpreisung dieses Features. Die Meinung der Umfrageteilnehmer ist in dieser Frage ziemlich gespalten, gilt es sowohl einige klare Beführworter als auch viele Ablehner – und vor allem wiederum viele, die in der Mitte zwischen diesen beiden Polen stehen. Grundsätzlich kann man hierzu drei Antwortgruppen bilden: Die nicht interessierten Nutzer liegen hierbei mit 49,5% klar in Front. Dahinter kommen diejenigen, welche ein Nutzungsinteresse haben, dies aber an diverse Problemlösungen binden, mit immerhin schon 38,8%. Und letztlich gibt es mit 11,7% noch eine kleinere Gruppe an Umfrageteilnehmer, welche jetzt schon ihr vorbehaltloses Nutzungsinteresse äußern. Für eine vergleichsweise neue Technologie (mit Bindung an neuere Hardware), welche auch jetzt erst vermehrt seitens neuer Spiele unterstützt wird, sind diese Werte nicht einmal übel – da hatte manch andere neue Technologie in der Vergangenheit einen viel schwierigeren Weg zu gehen.

Die Grafikchip- und Grafikkarten-Marktanteile im zweiten Quartal 2025

Die Marktbeobachter von Jon Peddie Research liefern die Marktzahlen zu den verkauften Grafikchips für Desktop-Grafikkarten für das abgelaufene zweite Quartal – in welchem einmal mehr alles zugunsten von nVidia lief. So ergab sich erst einmal mit 11,6 Mio. abgesetzten Desktop-Grafikchips ein lange Zeit nicht mehr gesehener zweistelliger Absatzwert – das letzte Mal gab es zweistellige Zahlen im zweiten Quartal 2022 beim Abflauen des Cryptomining-Hypes. Die gegenüber dem direkten Vorquartal abgesetzten ~2,4 Mio. mehr Desktop-Grafikchips gingen zum anderen komplett auf das Konto von nVidia – welche somit ebenfalls einen zweistelligen Absatzwert erreichten und zugleich ihren Marktanteil auf nunmehr 94% im Segment der extra Desktop-Grafikchips steigern konnten. Dabei steht Intel bei weiterhin nur 0% (gerundet auf einstellige Werte) und AMD bei nur noch 6% – der niedrigste jemals zu AMD ermittelte Wert.

| Desktop dGPU | Q2/2024 | Q3/2024 | Q4/2024 | Q1/2025 | Q2/2025 |

|---|---|---|---|---|---|

| Auslieferungsmenge | 9,5 Mio. Stück | 8,1 Mio. Stück | 8,4 Mio. Stück | 9,2 Mio. Stück | 11,6 Mio. Stück |

| AMD | 12% (~1,1M) | 10% (~0,8M) | 15% (~1,3M) | 8% (~0,7M) | 6% (~0,7M) |

| nVidia | 88% (~8,4M) | 90% (~7,3M) | 84% (~7,0M) | 92% (~8,5M) | 94% (~10,9M) |

| Intel | 0% (<0,05M) | 0% (<0,05M) | 1% (~0,1M) | 0% (<0,05M) | 0% (<0,06M) |

| Marktanteile basierend auf ausgelieferten Stückzahlen, Quelle: Jon Peddie Research | |||||

Gerüchteküche: Die Grund-Spezifikationen zu GeForce RTX 5070 Super, 5070 Ti Super & 5080 Super

Der bekannte Leaker 'Kopite7kimi' hat auf X/Twitter nunmehr auch noch die Grund-Spezifikationen von GeForce RTX 5070 Super und GeForce RTX 5070 Ti Super genannt – letztere wurde bereits als weiteres Refresh-Modell vermutet, was sich hiermit bestätigt. Hinzu gab es zur GeForce RTX 5080 Super eine Ergänzung des bereits geleakten, womit die GeForce RTX 50 "SUPER" Refresh-Serie nunmehr in ihren Grundzügen steht. Wie ebenfalls erwartet, ist die Erweiterung des Grafikkartenspeicher deren großes Thema, den Mehrspeicher wird es auch für die GeForce RTX 5070 Ti Super (und damit für alle drei Modelle) geben. Bei allen anderen Dingen hat sich nVidia jedoch auffallend zurückgehalten: So wird durchgehend derselbe Grafikchip angesetzt, gibt es auch nur im Fall der GeForce RTX 5070 Super den Mager-Sprung von 48 auf 50 Shader-Cluster und ansonsten eigentlich nirgendwo mehr Hardware. Augenscheinlich versucht nVidia dies dann über höhere TDPs ein wenig auszugleichen, welche höhere reale Chiptaktraten ermöglichen sollten – sofern es die Grafikchips mitmachen.

|

|

|