Hauptlinks

Suchen

nVidia-Grafik

Die Grafikchip- und Grafikkarten-Marktanteile im vierten Quartal 2024

Gemäß den Marktforschern von Jon Peddie Research haben die Grafikchip-Entwickler im vierten Quartal des letzten Jahres 8,4 Millionen Grafikchips für Desktop-Grafikkarten abgesetzt, gezählt unabhängig des Segments (Consumer oder Profi), aber rein für PC-Bedürfnisse, ergo ohne jegliche Spezial-Beschleuniger für HPC/KI-Zwecke. Dies war leicht mehr als im Quartal zuvor, welches allerdings selber auffallend schwach war – die stärkeren Zahlen des ersten Halbjahrs 2024 wurden hingegen noch nicht wieder erreicht. Bei der Marktverteilung machte sich nVidias Rückgang der RTX40-Nachlieferungen bereits bemerkbar, denn nVidia verlor von 90% auf 82% Marktanteil, respektive gewann AMD von 10% auf 17% Marktanteil. Bei Intel fiel die Rundung diesesmal günstig aus und es wurden aus 0% nunmehr 1% Marktanteil, wirklich beachtbar bleibt dies natürlich auch weiterhin nicht.

| Desktop dGPU | Q4/2023 | Q1/2024 | Q2/2024 | Q3/2024 | Q4/2024 |

|---|---|---|---|---|---|

| Auslieferungsmenge | 9,5 Mio. Stück | 8,7 Mio. Stück | 9,5 Mio. Stück | 8,1 Mio. Stück | 8,4 Mio. Stück |

| AMD | 19% (~1,8M) | 12% (~1,0M) | 12% (~1,1M) | 10% (~0,8M) | 17% (~1,4M) |

| nVidia | 80% (~7,6M) | 88% (~7,7M) | 88% (~8,4M) | 90% (~7,3M) | 82% (~6,9M) |

| Intel | 1% (~0,1M) | 0% (<0,05M) | 0% (<0,05M) | 0% (<0,05M) | 1% (~0,1M) |

| Marktanteile basierend auf ausgelieferten Stückzahlen, Quelle: Jon Peddie Research | |||||

nVidia GeForce RTX 5070: Die Launch-Reviews gehen online

Mit der GeForce RTX 5070 tritt nun schon das vierte Blackwell-basierte Modell an – und damit jene Karte, welche nVidia zur RTX50-Vorstellung mit der Performance der GeForce RTX 4090 beworben hatte (natürlich nur unter MFG-Einsatz erreichbar). Für die neue nVidia-Karte kommt erstmals der kleinere GB205-Chip zum Einsatz, womit auch weniger VRAM (nur 12 GB) geboten wird, gleichzeitig die Preislage mit 549 Dollar Listenpreis nun endlich im Midrange-Segment angekommen ist. Hiermit tritt die GeForce RTX 5070 zuerst einmal gegen GeForce RTX 4070 Super und Radeon RX 7900 GRE an, der eigentliche Kontrahent lauert allerdings morgen in Form der Radeon RX 9070 non-XT. Die heutigen Launch-Reviews zur GeForce RTX 5070 bieten somit wohl nur einen Teil des benötigten Gesamtbilds zur Karte, was dann erst morgen vervollständigt wird. Nichtsdestotrotz kann der Launch samt ebenfalls morgigen Marktstart in unserem Forum diskutiert werden, die (zum Wochende erwartbare) Launch-Analyse wird dann aller Voraussicht nach die drei neuen Grafikkarten dieser Woche in einem gemeinsamen Aufguß behandeln.

| Chip | Hardware | Takt | VRAM | TDP | Listenpreis | Release | |

|---|---|---|---|---|---|---|---|

| GeForce RTX 5090 | GB202 | 170 SM @ 512-bit | 2.01/2.41 GHz | 32 GB GDDR7 | 575W | $1999 / 2329€ | 30. Januar 2025 |

| GeForce RTX 5080 | GB203 | 84 SM @ 256-bit | 2.30/2.62 GHz | 16 GB GDDR7 | 360W | $999 / 1169€ | 30. Januar 2025 |

| GeForce RTX 5070 Ti | GB203 | 70 SM @ 256-bit | 2.30/2.45 GHz | 16 GB GDDR7 | 300W | $749 / 879€ | 20. Februar 2025 |

| GeForce RTX 5070 | GB205 | 48 SM @ 192-bit | 2.16/2.51 GHz | 12 GB GDDR7 | 250W | $549 / 649€ | 5. März 2025 |

Neue Performance-Index-Werte für Blackwell, Battlemage, Ada Lovelace, RDNA3 & Ampere

Noch ausstehend ist die Einordnung der in diesem Jahr neu herausgekommenen Grafikkarten in den 3DCenter Performance-Index, was hiermit erledigt werden soll – ehe in den kommenden Tagen schon wieder drei neue Grafikkarten antreten. Ausgangspunkt für diese Einordnungen sind die jeweiligen Launch-Reviews, wobei die neuen Index-Werte in diesem Fall zumeist sogar im Schnitt der drei letzten Launch-Reviews errechnet wurden, um auftretende kleinere Schwankungen in der Performance-Bewertung zu minimieren. Allerdings liegen die Index-Werte der drei Blackwell-basierten Grafikkarten nun doch etwas höher als zuletzt (in den Launch-Reviews und den News danach) notiert, was aber nicht auf einer plötzlich gefundenen Mehrperformance basiert, sondern einer nachfolgend ausgeführten generellen Neueinordnung vieler nVidia-Grafikkarten der Serien "Ampere" und "Ada Lovelace" geschuldet ist.

| Neueintragungen | FullHD-Index | 4K-Index |

|---|---|---|

| GeForce RTX 5090 | 4360% | 920% |

| GeForce RTX 5080 | 3420% | 610% |

| GeForce RTX 5070 Ti | 3060% | 520% |

| Arc B570 | 1250% | ~189% |

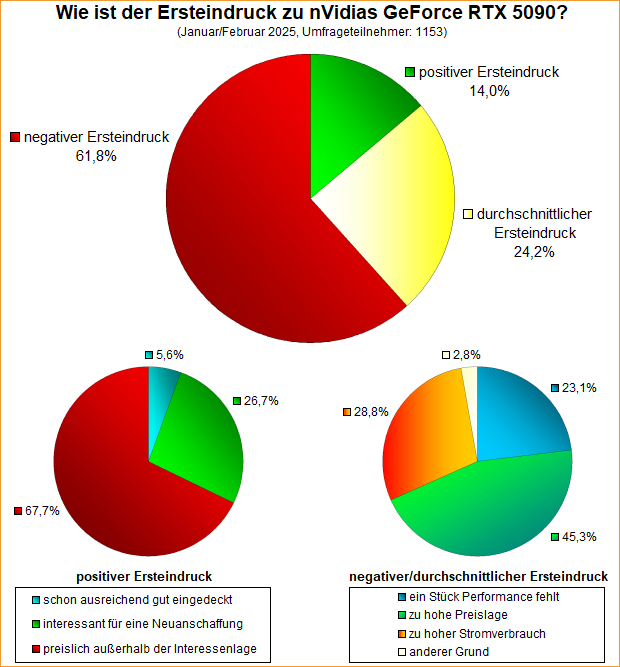

Umfrage-Auswertung: Wie ist der Ersteindruck zu nVidias GeForce RTX 5090?

Mittels einer Umfrage von Ende Januar ging es um den Ersteindruck zur GeForce RTX 5090, nVidias neuem Spitzenmodell. Jene Umfrage startete bereits am 28. Januar, somit sogar noch leicht vor dem Marktstart jener Karte, die meisten Stimmen wurden somit auch schon vor diesem 30. Januar abgegeben. Dies bedeutet, dass mehr oder weniger alle im letzten Monat neu für die GeForce RTX 5090 hinzugekommene Probleme von diesem Umfrage-Ergebnis (weitgehend) noch nicht reflektiert werden konnten. Ob dies einen besonderen Effekt auf das Umfrage-Ergebnis gehabt hätte, bleibt offen, denn das aktuell primäre Problem von erheblichen Preisübertreibungen aufgrund faktischer Nichtlieferbarkeit sollte üblicherweise mit dieserart Umfragen gar nicht abgebildet werden – denn Marktprobleme betreffen weder Technik noch vom Hersteller gesetzte Preislagen.

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 5070 Ti

Nach GeForce RTX 5090 und GeForce RTX 5080 bringt nVidia mit der "GeForce RTX 5070 Ti" nunmehr schon die dritte "Blackwell"-basierende Grafikkarte an den Start, wie bekannt alles zu schwer mangelhafter Lieferbarkeit und demzufolge völlig überzogenen Straßenpreisen. Dies stört maßgeblich die Betrachtung der Karte, denn deren geplante Marktposition als nVidias erstes Blackwell-Angebot unterhalb des vierstelligen Preisbereichs passt derzeit somit überhaupt nicht. Nichtsdestotrotz läßt sich die GeForce RTX 5070 Ti natürlich auch rein bezüglich des Produkts und der gebotenen Performance betrachten, was mittels dieser Launch-Analyse auf Basis der Auswertung von 13 Launch-Reviews und ca. 7220 Benchmarks getan werden soll ... zum Artikel.

| Gen. & Speicher | WQHD Raster | WQHD RayTr. | Real-Verbr. | Listenpreis | Straßenpreis | |

|---|---|---|---|---|---|---|

| GeForce RTX 5090 | Blackwell, 32GB | 156,7% | 164,9% | 509W | $1999 / 2329€ | (derzeit) ~3800 Euro |

| GeForce RTX 5080 | Blackwell, 16GB | 114,3% | 115,3% | 311W | $999 / 1169€ | (derzeit) ~1600 Euro |

| Radeon RX 7900 XTX | RDNA3, 24GB | 103,9% | 76,6% | 351W | $999 / 1149€ | 899-1000 Euro |

| GeForce RTX 5070 Ti | Blackwell, 16GB | 100% | 100% | 287W | $749 / 879€ | (derzeit) ~1300 Euro |

| Radeon RX 7900 XT | RDNA3, 20GB | 90,4% | 66,8% | 309W | $899 / 1049€ | 689-760 Euro |

| GeForce RTX 4070 Ti Super | Ada Lovelace, 16GB | 90,3% | 91,2% | 277W | $799 / 889€ | 956-1100 Euro (EOL) |

nVidia GeForce RTX 5070 Ti: Die Launch-Reviews gehen online

Mit der GeForce RTX 5070 Ti erfolgt nunmehr bereits der Launch der dritten Karte der neuen "Blackwell"-Generation von nVidia – und langsam kommt man damit in diese Performance- und Preisregionen, in welchen es dann auch Gegenangebote von AMD geben wird. Die GeForce RTX 5070 Ti basiert wie die GeForce RTX 5080 auf dem GB203-Chip, allerdings in einer beachtbaren Abspeckung – glücklicherweise jedoch nicht beim Speicherinterface sowie der Speichermenge. Die Karte bringt als Besonderheit mit, dass es von jener keine Founders Edition gibt, die heutigen Launch-Reviews somit durchgehend von Hersteller-Modellen (zum nVidia-Listenpreis) bestritten werden. Dabei sind jene bei den Grafikkarten-Herstellern derzeit eher weniger beliebt und so ist es wahrscheinlich, dass der morgen anstehende Marktstart primär mit den oberhalb des nVidia-Listenpreises angesetzten Hersteller-Modellen bestritten wird. Die Performance der Listenpreis-Modelle ist aber natürlich dennoch wichtig, um eine Performance-Baseline für die GeForce RTX 5070 Ti aufstellen zu können. Dies ist die Aufgabe der heute erscheinenden Launch-Reviews, kann in unserem Forum diskutiert werden und wird nachfolgend noch in einer Launch-Analyse zur GeForce RTX 5070 Ti an dieser Stelle zusammengefasst und aufbereitet werden.

| Chip | Hardware | Takt | VRAM | TDP | Listenpreis | Release | |

|---|---|---|---|---|---|---|---|

| GeForce RTX 5090 | GB202 | 170 SM @ 512-bit | 2.01/2.41 GHz | 32 GB GDDR7 | 575W | $1999 / 2329€ | 30. Januar 2025 |

| GeForce RTX 5080 | GB203 | 84 SM @ 256-bit | 2.30/2.62 GHz | 16 GB GDDR7 | 360W | $999 / 1169€ | 30. Januar 2025 |

| GeForce RTX 5070 Ti | GB203 | 70 SM @ 256-bit | 2.30/2.45 GHz | 16 GB GDDR7 | 300W | $749 / 879€ | 20. Februar 2025 |

| GeForce RTX 5070 | GB205 | 48 SM @ 192-bit | 2.16/2.51 GHz | 12 GB GDDR7 | 250W | $549 / 649€ | 5. März 2025 |

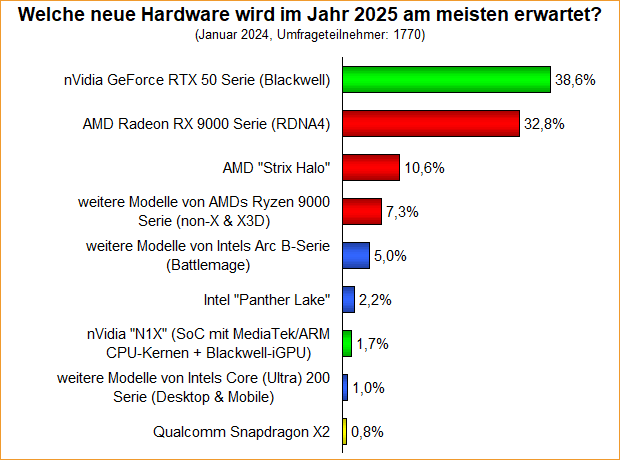

Umfrage-Auswertung: Welche neue Hardware wird im Jahr 2025 am meisten erwartet?

Die Jahresstart-Umfrage zu der für das Jahr 2025 am meisten erwarteten Hardware sah mit nVidias GeForce RTX 50 Serie sowie AMDs Radeon RX 9000 Serie zwei überaus klare Favoriten – welche zudem mit Prozentanteilen von 38,6% (nVidia) zu 32,8% (AMD) gar nicht einmal so weit auseinander liegen. Da könnte man durchaus das Gedankenspiel anstellen, ob sich diese Prozentverteilung von Anfang/Mitte Januar nicht vielleicht inzwischen schon wieder leicht verschoben hat. Zwar hat AMD bislang bei seinen neuen Grafikkarten noch gar nichts vorzeigbares, dafür aber nVidia hat sich seine ganz eigenen Problem geschaffen mittels unterdurchschnittlichen Performance-Gewinnen gepaart mit neuen Stecker/Kabel-Problemen, schwacher Verfügbarkeit und in Folge dessen hochgaloppierenden Straßenpreisen.

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 5080

Kurz nach der GeForce RTX 5090 folgt mit der "GeForce RTX 5080" der zweite Streich von nVidias neuer "Blackwell"-Generation. Die zweitbeste Karte des neuen Grafikkarten-Portfolios kommt deutlich weniger überkandidelt daher, sowohl bezüglich der TDP-Größe als auch des Preispunkts. Dafür wird allerdings auch nur grob die Hälfte der Hardware des größeren Modells geboten, was für einen ungewöhnlich hohen Performance-Unterschied sorgt bzw. nur einen maßvollen Performance-Gewinn gegenüber GeForce RTX 4080 und 4080 Super ergibt. Wo sich genau die GeForce RTX 5080 bezüglich Performance unter Raster & RayTracing, Stromverbrauch, Energieeffizienz und Performance/Preis-Verhältnis einordnen läßt, soll mittels dieser Launch-Analyse auf der Basis der Auswertung von 18 Launch-Reviews und ~8520 Einzel-Benchmarks herausgefunden werden ... zum Artikel.

| Gen. & Speicher | Raster-Perf. | RayTr.-Perf. | Real-Verbr. | Listenpreis | Straßenpreis | |

|---|---|---|---|---|---|---|

| GeForce RTX 5090 | Blackwell, 32GB | 169,8% | 172,7% | 509W | $1999 / 2329€ | (derzeit) ~4000 Euro |

| GeForce RTX 5080 | Blackwell, 16GB | 112,9% | 111,1% | 311W | $999 / 1169€ | (derzeit) ~1700 Euro |

| GeForce RTX 4090 | Ada Lovelace, 24GB | 132,4% | 134,5% | 418W | $1599 / 1799€ | 2990-3500 Euro (EOL) |

| Radeon RX 7900 XTX | RDNA3, 24GB | 100,5% | 70,0% | 351W | $999 / 1149€ | 889-950 Euro |

| GeForce RTX 4080 Super | Ada Lovelace, 16GB | 100% | 100% | 302W | $999 / 1109€ | 1149-1350 Euro (EOL) |

nVidia GeForce RTX 5080: Die Launch-Reviews gehen online

Nur kurz nach der GeForce RTX 5090 folgt mit der GeForce RTX 5080 nunmehr das zweite Modell von nVidias "Blackwell"-Generation nach. Sehr bemerkenswert ist der enorme preisliche wie technische Abstand zwischen diesen zwei neuen Grafikkarten: Die GeForce RTX 5080 ist faktisch eine halbierte GeForce RTX 5090 – und dies exakt zur Hälfte des Preispunkts. In der Praxis wird die Performance-Differenz beachtbar geringer ausfallen, dennoch wahrscheinlich für den größten Unterschied zwischen einem erst- und zweitbesten Modell von nVidia seit langer Zeit sorgen. Für ein besseres Performance/Preis-Verhältnis der GeForce RTX 5080 (zur 5090) dürfte damit schon recht automatisch gesorgt sein. Dennoch muß die GeForce RTX 5080 zusehen, sich beachtbar von GeForce RTX 4080 & 4080 Super abzusetzen, um nicht als müder de-Facto-Refresh zu diesen wahrgenommen zu werden. Ob nVidia dies gelungen ist, ermitteln derzeit die Launch-Reviews in reichhaltiger Anzahl, kann in unserem Forum diskutiert werden und wird nachfolgend noch in einer Launch-Analyse zur GeForce RTX 5080 an dieser Stelle zusammengefasst und aufbereitet werden.

| Chip | Hardware | Takt | VRAM | TDP | Listenpreis | Release | |

|---|---|---|---|---|---|---|---|

| GeForce RTX 5090 | GB202 | 170 SM @ 512-bit | 2.01/2.41 GHz | 32 GB GDDR7 | 575W | $1999 / 2329€ | 30. Januar 2025 |

| GeForce RTX 5080 | GB203 | 84 SM @ 256-bit | 2.30/2.62 GHz | 16 GB GDDR7 | 360W | $999 / 1169€ | 30. Januar 2025 |

| GeForce RTX 5070 Ti | GB203 | 70 SM @ 256-bit | 2.30/2.45 GHz | 16 GB GDDR7 | 300W | $749 / 879€ | Februar 2025 |

| GeForce RTX 5070 | GB205 | 48 SM @ 192-bit | 2.16/2.51 GHz | 12 GB GDDR7 | 250W | $549 / 649€ | Februar 2025 |

Neuer Artikel: Launch-Analyse nVidia GeForce RTX 5090

Nach mehr als zwei Jahren Wartezeit (die GeForce RTX 4090 kam bereits im Oktober 2022) tritt nunmehr mittels "Blackwell", dem GB202-Chip und der darauf basierenden GeForce RTX 5090 wieder eine neue nVidia-Architektur und -Generation an. Hierfür hatte nVidia nur den eher geringen Sprung von der 5nm- auf die 4nm-Fertigung zur Verfügung, dennoch ist zumindest der GB202-Chip gegenüber dem vorhergehenden AD102-Chip deutlich größer und mit einigermaßen mehr Hardware-Einheiten ausgerüstet ausgefallen. Wie natürlich schon bekannt, hat es dennoch nur zu einem mittelmäßigen Performance-Sprung gereicht, den Effekt des neuen "Multi Frame Generation" nicht (bzw. gesondert) betrachtend. Mittels der nachfolgenden Launch-Analyse sollen die vielen Zahlen und Daten zur GeForce RTX 5090 zusammengefasst sowie die Performance-Werte von 17 Launch-Reviews und 6260 Einzel-Benchmarks ausgewertet werden, auf dass sich ein solider Wert zum gemittelten Performance-Zuwachs des neuen Spitzenmodells ergibt ... zum Artikel.

| Gen. & Speicher | Raster-Perf. | RayTr.-Perf. | Real-Verbr. | Listenpreis | Straßenpreis | |

|---|---|---|---|---|---|---|

| GeForce RTX 5090 | Blackwell, 32GB | 128,6% | 128,6% | 509W | $1999 / 2329€ | zu erwarten für ~2500-2900€ |

| GeForce RTX 4090 | Ada Lovelace, 24GB | 100% | 100% | 418W | $1599 / 1799€ | 2599-2880 Euro (EOL) |

| Radeon RX 7900 XTX | RDNA3, 24GB | 76,3% | 52,5% | 351W | $999 / 1149€ | 899-960 Euro |

| GeForce RTX 4080 Super | Ada Lovelace, 16GB | 75,7% | 74,3% | 302W | $999 / 1109€ | 1074-1180 Euro |