Hauptlinks

Suchen

nVidia-Grafik

Gerüchteküche: Die Hardware-Daten der Consumer-Chips von nVidias "Blackwell"

Leaker Kopite7kimi @ X hat nun endlich die grundsätzlichen Hardware-Daten der Consumer-Chips von nVidias "Blackwell"-Generation bekanntgegeben, denkbarerweise basierend auf finalen Informationen beispielsweise nach den ersten abgeschlossenen Tape-Outs. Die Gerüchteküche hatte sich vorab zwar schon im Fall der beiden größeren Chips an den aktuellen Stand herangerobbt, musste dafür aber dennoch den einen oder anderen Irrweg nehmen – was nunmehr hoffentlich vorbei ist. Gegenüber dem letzten Stand ändert sich nur etwas dort, wo noch keine Gerüchtedaten vorlagen und man sich daher mit Annahmen weiterhelfen musste. Jene Annahmen lagen beim GB206-Chip richtig, bei den GB205- und GB207-Chip hingegen falsch: Insbesondere die GB205-Hardware ist nochmals etwas kleiner als bislang angenommen, womit sich nunmehr zumindest eine solide Erklärung der Namenswahl ergibt.

GB202 12*8 512-bit GDDR7

GB203 7*6 256-bit GDDR7

GB205 5*5 192-bit GDDR7

GB206 3*6 128-bit GDDR7

GB207 2*5 128-bit GDDR6

Quelle: Kopite7kimi @ X am 11. Juni 2024

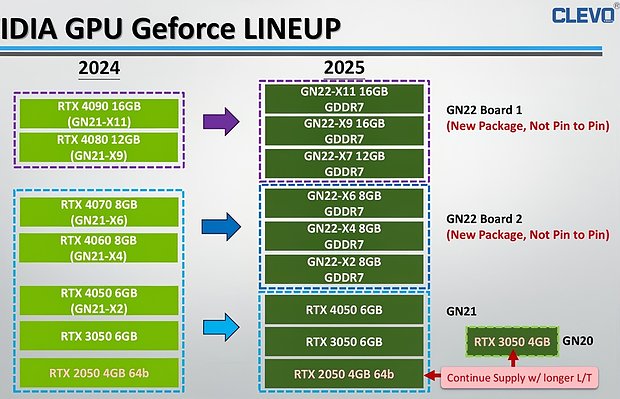

Clevo-Roadmap bestätigt die (unveränderte) Speicherinterface-Breite der kleineren Blackwell-Chips

Sicherheits-Forscher Dominic Alvieri @ X zeigt einige bei ODM-Hersteller 'Clevo' herausgetragene Roadmaps für die kommenden Mobile-Gerätschaften von AMD, Intel und nVidia ("ODM-Hersteller" = stellt für andere unter deren Namen her). Am interessantesten ist hier sicherlich die Roadmap der Mobile-Grafiklösungen von nVidia für das nächste Jahr, welches "Mobile-Blackwell" in den Markt eintreten sehen wird. Genaue technische Daten zu dieser kommenden GeForce RTX 50 Laptop-Serie gibt es zwar noch nicht, allerdings zeigen die verbauten Speichermengen zwei Dinge sicher an: Zum einen verwendet "Gaming-Blackwell" auch bis hinunter zu den kleinsten Grafikchips GDDR7-Speicher. Und zum anderen sind die Interface-Breiten gleich zur vorherigen GeForce RTX 40 Generation, bestätigen und ergänzen somit die Aussagen der Gerüchteküche.

Micron gibt einen Ausblick auf die mögliche Performance der GeForce RTX 5090

TechPowerUp zeigen eine Präsentationsfolie von Speicherhersteller Micron, welche zum Hochjubeln des kommenden GDDR7-Standards gedacht ist – und möglicherweise erste Benchmarks zur GeForce RTX 5090 offeriert. Denn Micron stellt hier – ohne Grafikkarten-Nennung – jeweils eine Lösung mit GDDR6-, GDDR6X- und GDDR7-Speicher in den Vergleich unter (ungenannten) Benchmarks in drei Auflösungen sowie unter Raster- wie RayTracing-Rendering. Dabei entsprechen die gezeigten Performance-Abstände (die Beschriftung stimmt nur sehr grob zum tatsächlichen Performance-Abstand) der GDDR6- und GDDR6X-Lösung zumindest unter Raster-Rendering ziemlich gut zum bekannten Performance-Abstand zwischen Radeon RX 7900 XTX und GeForce RTX 4090. Andere Grafikkarten-Kombinationen fallen damit als Erklärung aus, jene haben andere Skalierungen als diese Paarung.

Die Grafikchip- und Grafikkarten-Marktanteile im ersten Quartal 2024

Die Marktforscher von 'Jon Peddie Research' berichten in zwei Artikeln – No.1 & No.2 – zu den weltweiten Marktanteilen für Grafikchips im abgelaufenen ersten Quartal 2024. Der interessantere Teil ist hierbei immer der AiB-Report (AiB = Add-in-Board = Desktop-Grafikkarte), da es bei diesem um Grafikchips für Desktop-Grafikkarten geht, was dem Geschehen bei Gaming-Grafikkarten noch am nächsten kommt. In diesem Teilmarkt gab es für das erste Quartal einen Absatzrückgang von 9,5 Mio. AiB-Grafikchips im letzten Quartal auf nunmehr 8,7 Mio. AiB-Grafikchips, was allerdings über saisonale Effekte gut erklärbar ist. Eher beachtenswert ist an dieser Stelle die Rückkehr jener saisonalen Effekte – weil jene in den vorangegangenen Jahren über IT-Boom zu Corona, Cryptomining-Hype sowie Kater nach selbigem weitgehend aufgehoben waren.

| Desktop dGPU | Q1/2023 | Q2/2023 | Q3/2023 | Q4/2023 | Q1/2024 |

|---|---|---|---|---|---|

| Auslieferungsmenge | 6,26 Mio. Stück | 6,44 Mio. Stück | 8,9 Mio. Stück | 9,5 Mio. Stück | 8,7 Mio. Stück |

| AMD | 12% (~0,7M) | 17,5% (1,13M) | 17% (~1,5M) | 19% (~1,8M) | 12% (~1,0M) |

| nVidia | 83,7% (~5,3M) | 80,3% (5,17M) | 81,5% (~7,3M) | 80% (~7,6M) | 88% (~7,7M) |

| Intel | 4% (~0,3M) | 2,3% (0,15M) | 1% (~0,1M) | 1% (~0,1M) | 0% (<0,05M) |

| Marktanteile basierend auf ausgelieferten Stückzahlen, Quelle: Jon Peddie Research | |||||

Gerüchteküche: nVidias GB205 & GB203 wohl nicht mit stärkerer Hardware als AD103 & AD104

Nachdem nVidias inoffizielle Computex-Keynote aus Sicht von Gaming-Hardware eher denn einschläfernd war, hat sich Twitterer & Leaker 'Kopite7kimi' mit einer Änderung an den bisher bekannten Spezifikationen von "Gaming-Blackwell" zu Wort gemeldet. So sollen die Blackwell-Chips außerhalb von GB207 dieselbe Anzahl an Raster-Engines wie bei den vergleichbaren Chips von "Ada Lovelace" tragen. Bei GB203 und GB205 würde dies auf eine Raster-Engine mehr gegenüber dem bisherigen Gerüchtestand hinauslaufen, was erst einmal dankbar entgegengenommen wird. Allerdings soll der GB203-Chip dennoch weniger Shader-Cluster tragen, diesbezüglich nunmehr wie der AD103-Chip aussehen: 7 Raster-Engines (GPC) mit jeweils 6 TPCs, welche immer 2 Shader-Cluster (SM) beinhalten – und somit 84 Shader-Cluster insgesamt.

I found some friends getting bored with Jensen's presentation today.

I will say GB20x will have the same GPC count than AD10x except GB207 and AD107.

Quelle: Kopite7kimi @ X am 2. Juni 2024

GB202 is still 12*8.

Quelle: Kopite7kimi @ X am 2. Juni 2024

Due to the order of product development, we will not see finished products other than GB202 and GB203 in the short term, we will not discuss GB205, GB206, and GB207 at this time.

I feel sorry to everyone, GB203 is not 6*8, but 7*6, similar to AD103.

Quelle: Kopite7kimi @ X am 2. Juni 2024

Gerüchteküche: nVidias GB203 könnte auch mittels Durchsägen des GB202-Chips gewonnen werden

Aussagen von Twitterer & Leaker 'Kopite7kimi' haben die Diskussion neu angestoßen, wie die beiden Top-Chips von "Gaming-Blackwell" GB202 & GB203 zu verstehen sind. Wie bekannt, trägt der GB202-Chip die glatt doppelte Hardware des GB203-Chips – was immer schon die Vermutung ins Kraut hat schießen lassen, nVidia würde beim GB202 auf ein MultiChip-Konstrukt setzen. Dem gegenüber hatte der Leaker kürzlich aber noch einmal die monolithische Fertigung des GB202-Chips betont. In einem Nachtrag bezeichnete der Leaker den GB202-Chip allerdings auch als "logischerweise" zweimal GB203 entsprechend. Und dies dürfte ganz wörtlich zu verstehen sein: GB202 muß somit wie zwei zusammengepappte GB203 aufgebaut sein – nur wird dies alles zusammen als ein Chip gefertigt und nicht aus zwei Einzelchips kreiiert.

Do we know if GB202 is a MCM or monolithic design?

Quelle: Dalton Mariano @ X am 23. Mai 2024

physically monolithic

Quelle: Kopite7kimi @ X am 23. Mai 2024

Are they some kind of 2 x gb203?

Quelle: CRSC @ X am 27. Mai 2024

Logically.

Quelle: Kopite7kimi @ X am 27. Mai 2024

Performance-Skalierung von 3DMark TimeSpy und Steel Nomad im Vergleich

Unter der Woche hat der 3DMark-Macher "UL" dem 3DMark13 einen neuen Einzeltest spendiert, welcher den bisherigen Raster-Standardtest "TimeSpy" ablösen soll. Dafür bringt "Steel Nomad" eine deutlich bessere und damit leistungsfressender Grafik mit und wird gleich unter der 4K-Auflösung ausgeführt. Eine zusätzliche "Light"-Variante läuft unter der WQHD-Auflösung, arbeitet allerdings mit abgespeckten Grafik-Optionen und hat somit eher sein eigenes Performance-Profil. Die Systemanforderungen sind leicht gestiegen, inzwischen ist eine Grafikkarte mit DirectX 12 Feature_Level 12_0 für "Steel Nomad" vonnöten (für TimeSpy hatte noch FL11_0 gereicht). Alternativ läuft Steel Nomad auch unter Vulkan, was hier und da sogar für die (leicht) besseren Resultate sorgt. Zum neuen Benchmark haben sich auch bereits gehaltvolle Testberichte seitens ComputerBase und PC Games Hardware eingefunden, welche zudem Benchmarks für die wichtigsten aktuellen wie vergangenen Grafikkarten mitbringen.

| TimeSpy | Steel Nomad Light | Steel Nomad | |

|---|---|---|---|

| Render-Auflösung | WQHD bzw. 4K (Extreme) | WQHD | 4K |

| HW-Anforderungen | DualCore-CPU mit SSE3, 4 GB RAM (8 GB bei iGPU), 4 GB VRAM | DualCore-CPU mit SSE3, 8 GB RAM (16 GB bei iGPU), 4 GB VRAM | DualCore-CPU mit SSE3, 8 GB RAM (16 GB bei iGPU), 6 GB VRAM |

| DX-Anforderung | DX12 Feature-Level 11_0 | DX12 Feature-Level 12_0 | DX12 Feature-Level 12_0 |

| Anmerkung | - | nicht nur Unterschied in der Auflösung, auch die Grafik-Details sind in der Light-Version zurückgefahren | |

| Release | 2016 | 2024 | 2024 |

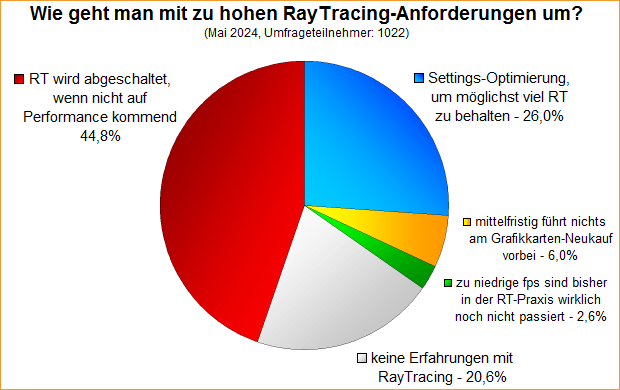

Umfrage-Auswertung: Wie geht man mit zu hohen RayTracing-Anforderungen um?

Mittels einer Umfrage von Anfang Mai wurde die Frage gestellt, was im Fall von zu hohen Leistungsanforderungen bei RayTracing getan wird: Schaltet man RayTracing ab, dreht zugunsten von RayTracing die Bildqualitäts-Settings zurück (bzw. setzt Upscaler ein) – oder geht es am Ende irgendwann in Richtung Grafikkarten-Neukauf. Erst einmal haben 20,6% der Umfrageteilnehmer (bislang) gar keine Erfahrungen mit RayTracing – was letztlich auch eine wertvolle Information darstellt, somit haben schließlich bereits 79,4% der Umfrageteilnehmer entsprechende Erfahrungen gemacht. Weitere 2,6% haben die Ausgangslage zur Fragestellung – zu hohe Leistungsanforderungen durch RayTracing – bislang in der Praxis noch nicht bemerken können, was wohl auf die Nutzer der GeForce RTX 4090 hinausläuft.

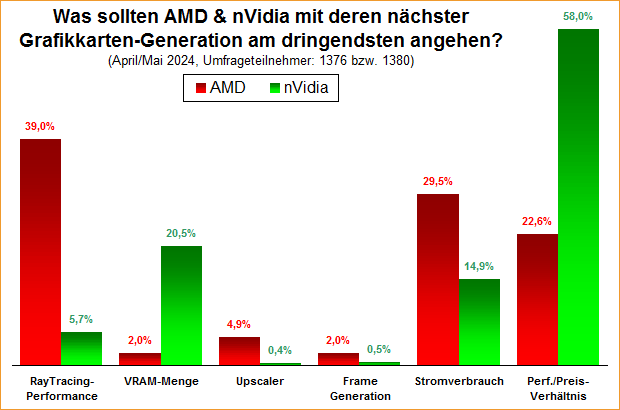

Umfrage-Auswertung: Was sollten AMD & nVidia mit deren nächster Grafikkarten-Generation am dringendsten angehen?

Ab Ende April liefen hintereinander zwei Umfrage mit derselben Fragestellung, einmal für AMD und einmal für nVidia: Welche Problematiken sollten die Grafikchip-Entwickler mit deren nächster Grafikkarten-Generation am dringendsten angehen? Die beiden Umfragen werden hiermit gemeinsam ausgewertet, da die herausgekommenen Ergebnisse um so interessanter sind, vergleicht man jene direkt zwischen AMD und nVidia. Denn es ergaben sich bei gleicher Fragestellung samt gleichen Antwortoptionen doch recht unterschiedliche Favoriten, je nach Grafikchip-Entwickler: So vereinnahmen bei AMD die Antwortoptionen "RayTracing-Performance", "Stromverbrauch" und "Performance/Preis-Verhältnis" (in dieser Reihenfolge) die große Mehrheit der Stimmen, die anderen Antwortoptionen kamen nicht auf bedeutende Stimmanteile.

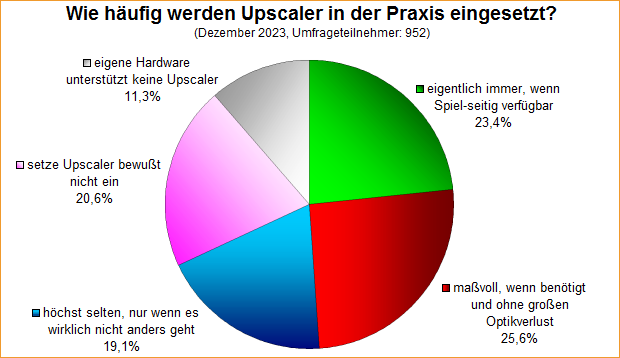

Umfrage-Auswertung: Wie häufig werden Upscaler in der Praxis eingesetzt?

Nach der kürzlichen Auswertung der RayTracing-Umfrage erfolgt hiermit noch die Auswertung der entsprechenden Upscaler-Umfrage von letztem Dezember – mittels welcher die Häufigkeit des Praxis-Einsatzes dieses Features erfasst werden sollte. In dieser Frage haben Upscaler logischerweise den natürlichen Vorteil, dass jene im klaren Gegensatz zu RayTracing normalerweise Performance erbringen – und nicht gerade erheblich an Performance kosten. Demzufolge ist es wenig verwunderlich, wenn Upscaler derzeit schon etwas häufiger als RayTracing genutzt werden, mit einem Nutzeranteil von 68,1% ist der Vorteil gegenüber RayTracing (Nutzeranteil 54,8%) nicht gerade unerheblich.