Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 16./17. August 2018

Zu den (vermeintlich authentischen) Spezifikationen der GeForce 20 Serie kommt aus unserem Forum der korrekte Hinweis, das die geleakte Spezifikations-Tabelle eher kaum von einem Grafikkarten-Hersteller stammen kann – da jene keine Titan-Grafikkarten mehr vertreiben, dies inzwischen ein Geschäft rein von nVidia selber ist. Dies zieht die Glaubwürdigkeit dieser Spezifikations-Tabelle natürlich nach unten – und vor einer Bestätigung durch nVidia kann man somit nicht sicher sagen, ob die Speichermengen der kommenden GeForce 20 Serie nun wirklich nur gleichbleiben, oder dann doch noch erhöht werden. Zumindest läßt sich aus der Existenz von Quadro-Karten mit sehr hohen Speichermengen nicht schlußfolgern, das selbiges auch im Gaming-Bereich passiert, dafür sind die Preislagen dieser Karten viel zu unterschiedlich bzw. kann nVidia es sich leisten, sich den Mehrspeicher im Quadro-Segment auch fürstlich bezahlen zu lassen (Quadro RTX 6000 24GB zu Quadro RTX 8000 48GB hat einen Mehrpreis von 3700 Dollar). Inzwischen gibt es allerdings reichlich Bilder entsprechender Grafikkarten-Kartonagen seitens der Grafikkarten-Hersteller MSI, Palit und Zotac, welche die Sache eindeutig bestätigen:

Die GeForce RTX 2080 kommt somit mit 8 GB GDDR6-Speicher daher – und die GeForce RTX 2080 Ti mit 11 GB GDDR6, ergo der exakt selben Speichermenge wie schon bei der vorhergehenden Pascal-Generation. Dies mag unbefriedigend sein und wenig zu dem großen Sprung in der Grafikchip-Technologie passen, welchen nVidia mit der Turing-Generation machen will, ist nunmehr jedoch Realität. Möglicherweise passen zu den gewählten Zielpreisen der kommenden Turing-Grafikkarten einfach keine größere Speicherbestückung, ist dies nur bei den wesentlich teureren Quadro-Modellen machbar. Im übrigen zeigen diese Kartonagen auch an, das nVidia in der Turing-Generation seinen gewohnten Release-Fahrplan maßgeblich verläßt und die Enthusiasten-Lösung GeForce RTX 2080 Ti mehr oder weniger zeitgleich mit der HighEnd-Lösung GeForce RTX 2080 bringen wird. Dies dürfte wohl den Punkten der Verschiebung der Turing-Generation um ein halbes Jahr (bedingt durch den Mining-Boom in diesem Frühjahr) sowie der vermutlich im Jahr 2019 nachfolgenden ersten 7nm-Generation geschuldet sein: Erstens sind diese Turing-Grafikchips nunmehr wirklich spruchreif und zweitens muß jetzt alles auch raus, da der Zeitrahmen bis zur Präsentation eines Nachfolgers wird sowieso vergleichsweise kurz ausfallen dürfte (ein Jahr bis maximal anderhalb Jahre).

Auf Reddit spricht man über Ausführungen aus China (von einem ehemaligen nVidia-Entwickler) zu nVidias RT-Core in den Turing-Chips: Hierunter verbirgt sich schlicht ein integrierter ASIC zur RayTracing-Beschleunigung. Selbiger hat einen direkten Zugriffpfad auf die Shader-Einheiten, wird von diesen auch mit Daten beliefert und schreibt in deren Register zurück. Dies sieht nach einem vorzugsweisen Einsatz als Hybrid-Renderer aus, bei welchem RayTracing für einzelne Rendering-Schritte benutzt wird, die Kontrolle aber weiterhin beim klassischen Rasterizer liegt. Zudem ist der RT-Core skalierbar zur Anzahl der verbauten Shader-Einheiten, ergo wird es kleinere und größere RT-Cores geben, wie schon zwischen den Turing-Chips TU102 (GeForce RTX 2070 & 2080) und TU104 (GeForce RTX 2080 Ti & Titan XT) zu sehen. In der Praxis dürfte es sich beim "RT-Core" wohl eher um viele einzelne Zusatz-Einheiten handeln, welche in oder neben den Shader-Einheiten liegen und keinen einheitlichen RT-Core mit abgetrenntem Platz auf dem Chip-Die ergeben. nVidias Schema-Bilder sind in dieser Frage wirklich nur rein schematisch und entsprechen sicherlich nicht dem eigentlichen Aufbau eines Turing-Chips.

Daneben gibt es ein paar interessante Notizen bezüglich des RayTracing-Features der Turing-Generation: So soll Battlefield V noch eine RayTracing-Funktion bekommen – welche laut der PC Games Hardware zwar derzeit im Spiel noch ausgeschaltet ist, sicherlich aber schon demnächst präsentiert werden wird. Damit bekommt nVidia natürlich ein dickes Vorzeige-Spiel für sein RayTracing-Feature an die Hand, was sich marketing-technisch sicherlich bestmöglich gegenüber der breiten Masse ausschlachten läßt. Auf YouTube zeigt man derweil die RayTracing-Nutzung unter der Render-Software "V-Ray", aufgenommen mit einer Quadro RTX 6000. Aus unserem Forum kommt zudem der Hinweis auf RayTracing-Aktivitäten seitens AMD – welche derzeit erst einmal nur die professionellen Beschleuniger von AMD betreffen, aber dennoch so verstanden werden dürfen, das AMD genauso an dem Thema dran ist. Dadurch, das RayTracing für PC-Spiele später über eine Erweiterung von DirectX 12 laufen soll, dürfte AMD so oder so mit an Bord sein – wobei nicht klar ist, wann dedizierte RayTracing-Hardware bei AMD auf den Chip-Roadmaps steht. Zwar kann man RayTracing notfalls auch über gewöhnliche Shader-Einheiten laufen lassen, aber dies funktioniert rein performance-mäßig nur bei der Content-Erstellung und nicht Realtime in Computerspielen.

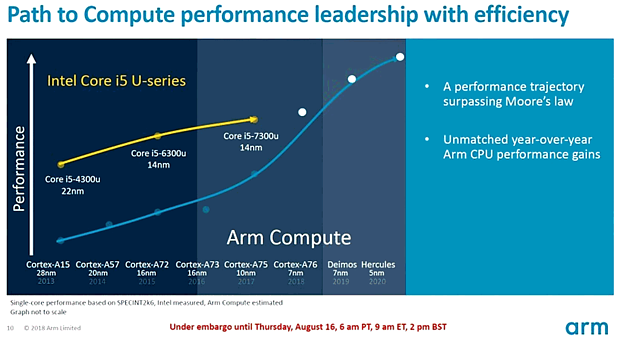

Golem und Heise zeigen eine neue ARM CPU-Kern Roadmap, nach welcher der britische IP-Entwickler über die nächsten Jahre mittels der 7nm- und der 5nm-Fertigung samt entsprechender neuer ARM-Kerne an Intel im Bereich von deren U-Prozessoren (bis 15W TDP) sogar vorbeiziehen will. Leider sind die von ARM hierzu angestellten Vergleiche ziemlich einseitig zugunsten von ARM ausgelegt – und können somit eher als Marketing-Präsentation als denn als seriöse Unterlage dienen. Gerade die ersten ARM-basierten Windows-Notebooks zeigen ja eher darauf hin, das die ARM-Prozessoren in der Windows-Welt noch ganze Dimensionen von der Leistungskraft von AMD- und Intel-Prozessoren entfernt liegen – die ARM-Prozessoren haben eher ihren Punkt im geringeren Energieverbrauch und damit einer längeren Akku-Laufzeit. Sicherlich will und wird ARM da zukünftig nachlegen, neben der jetzt kommenden ersten 7nm-Generation (Cortex-A76) sind eine zweite 7nm-Generation ("Deimos", 2019) und eine erste 5nm-Generation (Hercules, 2020) bereits angekündigt. Mittels der aktuellen Intel-Probleme mit neuen Fertigungsverfahren dürfte ARM sicherlich auch näher an übliche PC-Prozessoren heranrücken können – aber eine höhere Performance erscheint aus heutiger Sicht noch nicht so schnell erreichbar.