Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 16./17. Mai 2015

WCCF Tech spekulierten vor einiger Zeit über das Erscheinen von 8-GB-Varianten von GeForce GTX 970 & 980 noch im (abgelaufenen) ersten Quartal. Inzwischen hat sich dies rein terminlich natürlich schon als fehlgeschlagene Spekulation erwiesen – trotzdem laufen die Gerüchte über 8-GB-Versionen dieser beiden HighEnd-Grafikkarten weiter, da der Speicherhunger der Grafikkarten-Enthusiasten wächst, gerade angesichts einer GeForce GTX Titan X mit gleich 12 GB GDDR5-Speicher. Für die Frage, ob nVidia solcherart Grafikkarten bringt, ist allerdings weniger die Verfügbarkeit entsprechender Speicherchips entscheidend – sondern vielmehr, ob und wie nVidia jene in sein Portfolio integrieren kann. Hier hängt vieles von den konkreten Hardware-Daten und der Produktpositionierung der alsbald erwarteten GeForce GTX 980 Ti ab – eigentlich sollte diese mit 6 GB GDDR5 erwartete Karte die höheren Speicheranforderungen der User erfüllen können.

Extra Varianten von GeForce GTX 970 & 980 mit gleich 8 GB Grafikkartenspeicher sind trotzdem nicht abwegig, dürften wenn dann aber eher als Nischenprodukt nahe des Ende des Lebenszyklus dieser Grafikkarten-Generation erscheinen – sprich zum Jahresende 2015, vielleicht auch nur als Hersteller-Varianten zu eher überzogenen Preisen. Generell betrachtet darf nVidia derzeit nicht mit Grafikkartenspeicher um sich werfen, da die 2016er Grafikkarten eben wegen ihres (teuren) HBM2-Speichers nicht gerade günstig werden dürften, trotzdem aber einen Fortschritt auch bei der Speichermenge bieten müssen. nVidia dürfte also für dieses Jahr (bis auf das Enthusiasten-Segment) voraussichtlich weiterhin konservativ bei den Speichermengen bleiben. Voraussichtlich erst mit den 2016er Grafikkarten wird die Standardspeichermenge von HighEnd-Grafikkarten dann wieder steigen.

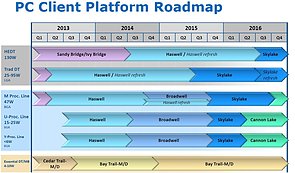

Die finnische Webseite Mustapekka (maschinelle Übersetzung ins Deutsche) zeigt eine geleakte Intel-Roadmap – welche aber augenscheinlich mehr als ein Jahr alt ist. So sind der spätere Start von Broadwell im Mobile-Segment und das kommende kurze Broadwell-Intermezzo im Desktop-Segment noch gar nicht eingezeichnet, dafür fehlt Broadwell-E im Enthusiasten-Segment gänzlich. Bemerkenswert ist allerdings der (einstmals geplante) recht frühe Start der 10nm-basierten Cannonlake-Architektur für das Mobile-Segment schon im zweiten Quartal 2016. Dies wird nun kaum noch passieren, wahrscheinlich gibt es Cannonlake erst Anfang 2017 – trotzdem interessant, daß Intel hiermit zum zweiten Mal eine neue Architektur zuerst einmal nur fürs Mobile-Segment vorsieht, während für das Desktop-Segment an dieser Stelle nur Refresh-Varianten der Vorgänger-Architektur vorgesehen sind (waren). Wie gesagt ist diese Roadmap unaktuell und Intels Pläne für die Jahre 2016/2017 dürften inzwischen maßgeblich anders aussehen – als Hinweisgeber dazu, wie Intels langfristige Produktplaner ticken, taugt diese Roadmap dann aber trotzdem.

Zum kürzlich genannten Broadwell-basierten Core i7-5775C auf 4.8 GHz wäre noch anzumerken, daß damit ein wPrime-Wert von 4,399sec für den 32M-Durchlauf erzielt werden konnte – um immerhin 10,9% besser als bei einem auf 4.8 GHz laufenden Haswell-Prozessor im Test von Overclockers (4.88sec). Dies ist etwas mehr als der seitens Intel für Broadwell prognostizierte IPC-Anstieg von 5,5% – und wahrscheinlich auf das Vorhandensein von eDRAM bei diesem Broadwell-Prozessor zurückzuführen. Da Intel bei Broadwell nur ein arg eingeschränktes Desktop-Portfolio anbietet, nimmt man faktisch Mobile-Prozessoren hierfür – und jene werden gern mit großen Grafikeinheiten samt eDRAM aufgelegt, während die für den Desktop eher interessanten Modelle mit kleiner Grafiklösung bei Broadwell wahrscheinlich gar nicht hergestellt werden. Der eDRAM dieses Broadwell-Prozessor fungiert dann unter CPU-Aufgaben als Level4-Cache und beschleunigt damit solch Cache-intensive Anwendungen wie wPrime durchaus stärker als es die normale IPC-Steigerung eigentlich zulassen würde. In den meisten anderen Benchmarks wird der Beschleunigungseffekt durch den eDRAM allerdings eher marginal sein, dessen eigentliche Aufgabe liegt nun einmal in der Beschleunigung der integrierten Grafik.

Heise berichten über die Bilanzziehung nach einem Jahr "Recht auf Vergessen" durch Google. Hierbei werden schöne exemplarische Fälle genannt, wo das "Recht auf Vergessen" zum einen seinen (gewissen) Sinn hat – oder wo es nicht angewandt werden kann, wenn es sich um für die Öffentlichkeit relevante Informationen handelt. Denn immerhin 58,7% aller Löschanfragen hat Google am Ende abschlägig bescheinigt – dies deutet nicht gerade darauf hin, daß da einfach alles durchgewunken wird. Zum anderen wird natürlich auch deutlich, daß das "Recht auf Vergessen" sogar schon in der Mehrzahl dazu mißbraucht wird, mißbeliebige Informationen aus dem Web zu tilgen (versuchen). Trotz daß sich Google diesem Mißbrauch augenscheinlich verwehrt, haben die Kritiker Recht: Die Auswertung darüber, wie dieses Recht in der Praxis angewandt wurde, sollte nicht von Google selber kommen, sondern von unabhängigen Stellen mit Zugriff auf das Google-Datenmaterial. Nachdem Google beim "Recht auf Vergessen" nunmehr Gericht und Strafvollzug in einem spielen muß, sollte wenigstens die Kontrollinstanz der ganzen Show unabhängig sein.