Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 1. September 2020

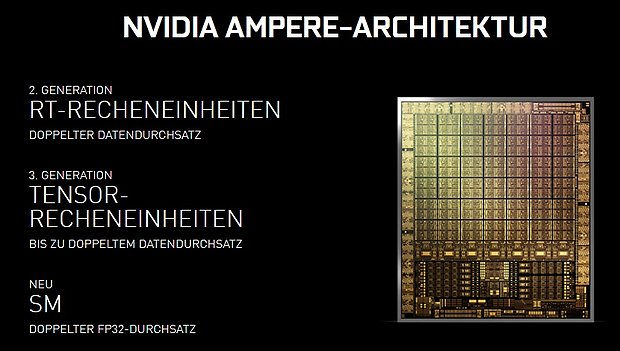

In der Frage, wie nVidia seine Einheiten-Verdopplung bei Gaming-Ampere erreicht hat, ist zumindest die These einer möglichen "kreativen" Zählweise ganz schnell wieder vom Tisch, denn die nVidia-Webseite notiert in dieser Frage glasklar einen verdoppelten FP32-Durchsatz innerhalb der Shader-Cluster, sprich also Einheiten- wie Takt-normiert und damit nicht mehr anzufechten. Ergo kann man sich auf andere Auflösungen konzentrieren, wobei derzeit eine reine Verdopplung der ALUs (möglicherweise sogar unter dem Verzicht auf die INT32-Einheiten von Ampere) in der Pole Position steht: Deren Platzbedarf ist handelbar, die zusätzliche Leistungsaufnahme durch die höhere Rechenkraft hält sich gerade bei Recheneinheiten unter kleineren Fertigungsverfahren in Grenzen. Derzeit verschiebt sich im Chipdesign die Frage der größten Stromverbraucher eher weg von den reinen Recheneinheiten hin zu Kontrolllogik und Interfaces, ergo dort, wo Daten innerhalb des Chips transportiert werden (müssen). Während sich frühere Grafikchip-Architekturen von nVidia eher der Ausweitung der Kontrolllogik gewidmet haben, um eine größtmögliche Auslastung der Recheneinheiten zu garantieren, geht nVidia diesesmal den umgedrehten Weg – mehr Recheneinheiten pro Shader-Cluster.

Die Anzahl der Shader-Cluster stimmt allerdings gegenüber den früheren Gerüchten, womit sich die Ampere-Vorsage von Mai 2019 seitens Twitter 'Kopite7kimi' nochmals bestätigt hat. Nur konnte sich seinerzeit einfach keiner eine andere Anzahl an Shader-Einheiten pro Shader-Cluster vorstellen – dies kam erst in diesem Jahr als Gerücht auf, wurde allerdings bis zuletzt nicht gänzlich ernst genommen. In der Summe der Dinge wusste die Gerüchteküche über fast jedes Detail vorab schon Bescheid – allerdings gab es auch reichlich danebenliegende Gerüchte, womit die Kunst darin bestand, die passenden von den unpassenden zu trennen. Sogar die 8nm-Fertigung von Samsung wurde seinerzeit letztlich schon korrekt vorhergesagt – während die erst am Wochenende geleakte Gainward-Unterlage mit einer Fertigungs-Angabe von "7nm" entweder einen Schreibfehler oder eine bewußt falsche Fährte darstellt. In jedem Fall kann man die seinerzeitigen Angaben von 'Kopite7kimi' nunmehr final ernst nehmen bzw. kann mit den Angaben zu den kleineren Ampere-Chips weiterarbeiten.

| Original-Aussage von Kopite7kimi | spätere Anmerkung | = Hardware-Konfiguration | |

|---|---|---|---|

| GA100 | TSMC 7EUV, 8GPC*8TPC*2SM 6144bit | - | 128 SM @ 6144 Bit HBM2 |

| GA101 | TSMC 7EUV, 4GPC*8TPC*2SM 3072bit | Chip gestrichen | 64 SM @ 3072 Bit HBM2 |

| GA102 | Samsung 8EUV, 7GPC*6TPC*2SM 384bit, NVLink | realisiert in Samsung 10nm | 84 SM @ 384 Bit GDDR6 |

| GA103 | Samsung 8EUV, 6GPC*5TPC*2SM 320bit | Chip gestrichen | 60 SM @ 320 Bit GDDR6 |

| GA104 | Samsung 8EUV, 6GPC*4TPC*2SM 256bit | - | 48 SM @ 256 Bit GDDR6 |

| GA106 | Samsung 8EUV, 3GPC*5TPC*2SM 192bit | - | 30 SM @ 192 Bit GDDR6 |

| GA107 | Samsung 8EUV, 2GPC*5TPC*2SM 128bit | - | 20 SM @ 128 Bit GDDR6 |

| GPC = Graphics Processing Clusters, TPC = Texture Processing Clusters, SM = Streaming Multiprocessors basierend auf den Ausführungen von Kopite7kimi @ Twitter vom 21. Mai 2019 (samt späteren Anmerkungen) |

|||

Keine Informationen hat nVidia hingegen zu den Möglichkeiten der Herstellerkarte zur GeForce RTX 30 Serie genannt – logisch, im "GeForce Special Event" hat man sich auf seine eigenen "Founders Edition" Lösungen konzentriert. Die Herstellermodelle wurden von den Grafikkarten-Hersteller nachfolgend in Hülle und Fülle angekündigt – beispielsweise von Asus, von MSI, von Gigabyte und weiteren Herstellern. Mit genaueren technischen Angaben waren dabei alle Hersteller (genauso wie nVidia) eher sparsam – aber zumindest ist klar, dass derzeit noch keinerlei GeForce RTX 3070 mit gleich 16 GB Speicher sowie eine GeForce RTX 3080 mit gleich 20 GB Speicher angekündigt wäre. Wie kürzlich offengelegt, hat sich Palit solcherart Karten-Ausführungen bereits bei der EEC registrieren lassen – was natürlich nicht zwingend bedeutet, dass jene realisiert werden bzw. wann dieses passiert. Dabei dürfte die potentielle Existenz von 16/20-GB-Lösungen von GeForce RTX 3070 & 3080 sicherlich viele Grafikkarten-Käufer interessieren – dies ist ein gewichtiger Punkt, welcher derzeit noch einer Klärung wartet.

| Chip | Hardware | Speicher | FE/AIB | Preis | Release | |

|---|---|---|---|---|---|---|

| GeForce RTX 3090 24GB | GA102 | 82 SM @ 384 Bit | 24 GB GDDR6X | ✓ / ✓ | $1499 | 24. September 2020 |

| GeForce RTX 3080 20GB | GA102 | 68 SM @ 320 Bit | 20 GB GDDR6X | ✗ / ✓ | ? | Existenz unbestätigt |

| GeForce RTX 3080 10GB | GA102 | 68 SM @ 320 Bit | 10 GB GDDR6X | ✓ / ✓ | $699 | 17. September 2020 |

| GeForce RTX 3070 16GB | GA104 | 46 SM @ 256 Bit | 16 GB GDDR6 | ✗ / ✓ | ? | Existenz unbestätigt |

| GeForce RTX 3070 8GB | GA104 | 46 SM @ 256 Bit | 8 GB GDDR6 | ✓ / ✓ | $499 | Oktober 2020 |

| GeForce RTX 3060 8GB | GA104 | ~40 SM @ 256 Bit | 8 GB GDDR6 | ? / ✓ | ? | vermutl. Q4/2020 |

Von ComputerBase, GameGPU und WCCF Tech kommen Betrachtungen zur Grafikkarten-Performance unter "Total War Saga: Troy". Der Strategie-Titel innerhalb der Total-War-Serie braucht üblicherweise nicht ganz so hohe Frameraten wie unter Shooter-Spielen, zieht aber dennoch ganz schon an der Grafikkarte: Mit der besten Bildqualität sind unter der UltraHD-Auflösung selbst mit einer GeForce RTX 2080 Ti nur ca. 40 fps drin. Dabei wurde hierfür schon die "Gras"-Option um eine Stufe zurückgesetzt, selbige löst ein heftiges CPU-Limit aus und kann daher selbst unter höheren Auflösungen die allgemeine Framerate um ca. ein Drittel herunterdrücken. Unter Beachtung dieses Punkts kommt dann eine ganze Reihe an Grafikkarten noch ganz gut mit, mit allerdings beachtbarem Vorteil für die nVidia-Modelle unter höheren Frameraten. Bei durchschnittlich 35 fps ordnen sich die AMD-Beschleuniger eher wie gewohnt ein, doch bei durchschnittlich 60 fps wird in aller Regel eine viel potentere AMD-Grafikkarte benötigt.

| Grafikkarten-Empfehlung für "Total War Saga: Troy" | ||

|---|---|---|

| Max-Qualität (ohne Gras=Extrem) mit Ø 35 fps | Max-Qualität (ohne Gras=Extrem) mit Ø 60 fps | |

| FullHD | ab GeForce GTX 970, GeForce GTX 1060 3GB, GeForce GTX 1650 Super oder Radeon RX 580 4GB, Radeon RX 5500 XT 4GB | ab GeForce GTX 1070, GeForce RTX 2060 oder Radeon VII, Radeon RX 5700 |

| WQHD | ab GeForce GTX 980 Ti, GeForce GTX 1070, GeForce GTX 1660 oder Radeon RX Vega 64, Radeon RX 5600 XT 12Gbps | ab GeForce GTX 1080 Ti, GeForce RTX 2080 |

| UltraHD | ab GeForce GTX 1080 Ti, GeForce RTX 2080 | - |

| interpoliert gemäß der Benchmarks von ComputerBase & GameGPU | ||

Der Hintergrund dessen dürfte wohl darin liegen, dass das Spiel erstaunlicherweise nur unter DirectX 11 daherkommt – und somit die CPU-Beschleunigung von DirectX 12 links liegen läßt (welche es beim eigenen Vorgänger innerhalb derselben Spiele-Serie noch gibt). Dafür skaliert "Total War Saga: Troy" dann aber auch wirklich gut mit schnelleren Prozessoren, vorzugsweise mit Prozessoren mit mehr CPU-Kernen. Bis zu 12 CPU-Kerne kann das Spiel einwandfrei in Mehrperformance umwandeln – und dies unter FullHD-Benchmarks, sprich ohne künstliche Konstruktion eines besonders CPU-schlauchenden Settings. Aber natürlich verwischt hierbei die vorgenannte "Gras"-Option sowie die Verwendung von nur DirectX 11 das Bild etwas: Ohne dem "Gras" auf höchster Stufe und (angenommen) unter DirectX 12 wären andere Ergebnisse denkbar, die von "Total War Saga: Troy" aufgezeigte CPU-Performance gilt somit zwar für diesen Strategie-Titel, läßt sich jedoch eben nicht verallgemeinern. Grafikkartenspeicher-technisch geht es hingegen geruhsam zu: Belegt werden unter FullHD etwas weniger als 3 GB VRAM, unter WQHD weniger als 4 GB und unter UltraHD dann weniger als 5 GB – so dass aus dieser Richtung heraus keine Überraschungen zu befürchten sind.