Launch-Analyse: nVidia GeForce GTX Titan

Hauptlinks

Suchen

Launch-Analyse: nVidia GeForce GTX Titan (Seite 2)

Diese durchaus beeindruckende Hardware-Daten der GeForce GTX Titan relativieren sich etwas, wenn man einrechnet, mit welchen Kontrahenten es die Karte aufgrund ihres Preispunkts von über 900 Euro auf dem aktuellen Grafikkarten-Markt zu tun haben wird: Sicherlich nicht den bisher schnellsten SingleChip-Grafikkarten Radeon HD 7970 "GHz Edition" (derzeit 370-400€ Straßenpreis) und GeForce GTX 680 (400-430€), sondern zuerst deren DualChip-Abwandlungen Radeon HD 7990 (830-860€) und GeForce GTX 690 (850-880€). Jene haben letztlich einen ungefähr der GeForce GTX Titan entsprechenden Preispunkt und sind damit die natürlichen Kontrahenten von nVidias SingleChip-Monster.

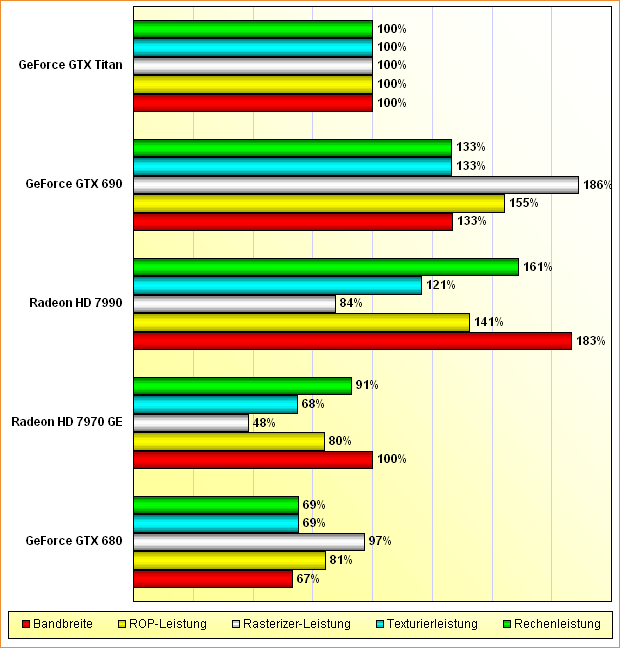

Obwohl auf deutlich kleineren Chips basierend, liegen Radeon HD 7990 und GeForce GTX 690 dabei bezüglich ihrer Rohleistungen teilweise deutlich vor der GeForce GTX Titan – begünstigt maßgeblich durch die bei diesen kleineren Chips möglichen höheren Taktraten. Hier zeigen sich die Limitationen immer größerer Chips: Bei jenem wird dann immer weniger Taktrate möglich – noch größere Chips könnten zwar noch mehr Hardware-Einheiten beherbergen, wären jedoch durch immer niedrigere Taktraten effektiv nicht schneller. Selbst eingerechnet der üblichen Effizienznachteile von MultiChip-Konstruktionen erscheint es aufgrund dieses Rohleistungs-Unterschieds als unwahrscheinlich, daß sich die GeForce GTX Titan wirklich mit Radeon HD 7990 und GeForce GTX 690 messen kann.

Rohleistungs-Vergleich Radeon HD 7970 GHz Edition, 7990 & GeForce GTX 680, 690, Titan (aktualisiert)

Andererseits ist der Rohleistungs-Vorteil gegenüber den anderen SingleChip-Grafikkarten auch nicht wirklich überragend: Eine Radeon HD 7970 "GHz Edition" kommt den Rohleistungen der GeForce GTX Titan schon ziemlich nahe, liegt allein bei der Rasterizer-Leistung deutlich zurück. Gegenüber der GeForce GTX 680 besteht wenigstens ein durchgehender Rohleistungs-Unterschied von 45 Prozent mehr Rechen- und Texturierleistung bei gleichzeitig 50 Prozent mehr Speicherbandbreite. Dies sollte – rein die Rohleistungen betrachtend – in einem ungefähren Performance-Unterschied von 35 bis 40 Prozent zwischen GeForce GTX 680 und Titan münden.

Eine der beiden Neuerungen von GeForce GTX Titan gegenüber den bisherigen Kepler-Grafikkarten liegt im Boost-Modus: nVidia setzt hier erstmals auf "GPU Boost 2.0", welches sich nicht nur an der Leistungsaufnahme des Grafikchips ausrichtet, sondern auch an dessen aktueller Temperatur. Dabei wird grundsätzlich versucht, die Grafikkarte bei bis zu 80 Grad Chiptemperatur zu halten – gleichzeitig darf natürlich auch das Power Target von 250 Watt TDP nicht überschritten werden. Mittels externer Tools kann hierauf wieder Einfluß genommen werden: Das Power Target (von 250W auf 265W), die Ziel-Temperatur (von 80°C auf maximal 95°C) und die maximale Chipspannung (von 1.162V auf 1.2V) können mittels EVGAs Precision X (schon Titan-tauglich) als auch MSIs Afterburner (aktuell noch nicht Titan-tauglich) verändern werden, alle drei Optionen können dann aus der GeForce GTX Titan noch entsprechend mehr an Performance herauskitzeln.

In der Praxis zeigte sich GPU Boost 2.0 jedoch als recht zweischneidiges Schwert, da die Temperatur-Schwelle insbesondere bei speziell "vorgeheizten" Systemen ziemlich fix erreicht wurde. Hierbei setzen mitdenkende Hardware-Tester auf Systeme, welche vor dem eigentlichen Benchmark-Durchlauf erst einmal ein Spiel für ein paar Minuten in Demo-Schleife abspielen, um die Hardware auf Temperatur zu bringen und damit besser die eigentliche Gaming-Praxis zu simulieren. In diesem Modus griff GPU Boost 2.0 nachweislich stärker in die erreichte Boost-Taktrate ein, als wenn man im "ausgekühlten" Zustand einen Benchmark versuchte – Hardware-Tester, welche nicht auf "vorgeheizte" Systeme setzen, messen also bei GeForce GTX Titan eine etwas zu hohe Performance (dazu später noch mehr). Gleichzeitig kann man durch das Hochsetzen der Temperatur- und Leistungsverbrauch-Schwellen von GPU Boost 2.0 den erreichten Boost-Takt sehr deutlich auf nahezu durchgehend 993 MHz steigern, wie die ComputerBase hervorragend nachgewiesen hat:

| Boost-Takt | prozentual | |

|---|---|---|

| default | 876 MHz | 100% |

| real erreicht in 16 Titeln | Ø 854 MHz | -2,5% |

| PowerTarget @ 265W + Chiptemperatur @ max. 95°C | Ø 984 MHz | +12,3% |

Die zweite Neuerung von GeForce GTX Titan ist erneut ein Software-Feature: Mittels "Display Overclocking" kann man die Refreshrate des eigenen Monitors übertakten und damit auch real mehr fps auf dem Display sehen. Dabei macht sich nVidia den Umstand zunutze, daß die Elektronik der meisten heutigen Displays mehr kann als die offiziellen 60 Hertz Bildwiederholrate – und steuert den Monitor dann einfach mit einer höheren Hertz-Zahl an. Da damit auch das Vsync-Limit steigt, können letztlich auch höhere Frameraten auf dem Monitor abgebildet werden – natürlich nur dann, wenn das jeweilige Spiel überhaupt Frameraten über 60 fps abwirft und GeForce GTX Titan diese dann auch zu berechnen in der Lage ist. Zum Monitor-Übertakten wird mittels der bekannten externen Tools (derzeit funktioniert wie gesagt nur EVGAs Precision X mit GeForce GTX Titan zusammen) sich schrittweise an das herangetastet, was der jeweilige Monitor maximal leisten kann.

Dies kann je nach Monitor zu gänzlich unterschiedlichen Ergebnissen führen – bei einem Modell geht es in der Praxis nicht über 60 Hz hinaus, andere Modelle schaffen sogar 75 Hz. nVidia will hierzu noch eine Kompatibilitätsliste mit getesteten Monitoren und deren maximal möglichen Hertz-Zahlen veröffentlichen. Laut nVidia soll dieses Monitor-Übertakten zu keinen Schäden am Monitor führen, da ja nur die Spezifikation der verbauten Elektronik ausgenutzt wird – die Monitorhersteller dürften dies jedoch anders sehen und bei etwaigen Schäden durch das Monitor-Übertakten eventuell die Garantie verweigern. Damit – und weil der Praxiseffekt auch ziemlich begrenzt ist – ist das Monitor-Übertakten nicht wirklich das Feature, welches jetzt die großen Käuferströme zur GeForce GTX Titan ziehen sollte, trotz daß es "Display Overclocking" exklusiv nur bei dieser Karte geben wird. Richtiggehend neu ist das Feature zudem auch nicht, man kann denselben Effekt über modifizierte Monitor-Treiber auch bei früheren und aktuellen Grafikkarten erzwingen – nVidia bringt es nunmehr nur halt offiziell.

Ihre TDP von 250 Watt hält die GeForce GTX Titan – welche es nach Willen von nVidia nur im Referenzdesign geben soll, maximal mit abgewandelten Kühlern – über alle Maßen gut ein: Die bisherigen Testberichte mit exakter Messungen nur der reinen Grafikkarte bescheinigen GeForce GTX Titan einen Idle-Verbrauch von nur 12 Watt und einen Spiele-Verbrauch von nur 206 Watt, was angesichts der gebotenen Hardware hervorragend ist. Die Karte verbraucht somit klar weniger als eine eine Radeon HD 7970 "GHz Edition" (235 Watt unter Spielen) und nur runde 40 Watt mehr als eine GeForce GTX 680 (169 Watt), aber immer noch deutlich weniger als die DualChip-Karten Radeon HD 7990 (ca. 320 Watt) und GeForce GTX 690 (270 Watt). Auch beim Idle-, beim BluRay- sowie beim MultiMonitoring-Verbrauch liegt die Karte sehr niedrig und stellt hierbei sogar einige Spitzenwerte für HighEnd-Grafikkarten auf. Leider fehlt uns hierbei noch der exakte Vergleich mit allen bisherigen Grafikkarten basierend auf den Messungen von HT4U – welche nVidia (unverständlicherweise) nicht mit einem Testsample belieferte.

| Hardware.fr | Heise | HT4U | PCGH | TechPowerUp | Ø | |

|---|---|---|---|---|---|---|

| Radeon HD 7970 "GHz Edition" | 13W 225W |

13W 206W |

13,0W 254,3W |

15W 247W |

14W 209W |

14W 235W |

| GeForce GTX 680 | 16W 169W |

14W 164W |

14,5W 170W |

15W 174W |

14W 166W |

15W 169W |

| GeForce GTX 690 | 25W 277W |

25,6W 277,5W |

25W 274W |

22W 229W |

24W 270W |

|

| GeForce GTX Titan | 13W 180W |

13W 214W |

10W 208W |

12W 206W |

Ebenfalls viel Anklang bei allen Testern fand das von GeForce GTX Titan abgegebene Geräusch-Niveau, welches für eine so klare HighEnd-Grafikkarte doch ziemlich gut ausfällt. Ein echter Leisetreter ist die Karte im Referenzdesign zwar auch nicht, aber man gewinnt gegenüber den Referenz-Lösungen zur GeForce GTX 680 & 690 jeweils mit gewissem Vorsprung sowie gegenüber den Referenz-Lösungen zur Radeon HD 7970 und deren "GHz Edition" dann mit fliegenden Fahnen. Auch in dieser Diziplin kann sich die GeForce GTX Titan mehr in Richtung der Grafikkarten des Performance-Segments statt des HighEnd-Segments einordnen – in einer Disziplin, wo weniger mehr ist, natürlich nur von Vorteil für GeForce GTX Titan.