Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 10./11. Juni 2020

Igor's Lab haben sich weiter mit nVidia GA102-Grafikkarten beschäftigt und dazu auch eine feine Auflistung aufgestellt, wie sich der maximale TDP-Wert von immerhin 350 Watt zusammensetzen könnte. Dabei schlägt der allgemein als 24 GB GDDR6X angenommene Speicher der GA102-Spitzenlösung (bei Igor eine "GeForce RTX 3090", bei anderen Quellen eine Ampere-Titan) mit allein 60 Watt durchaus kräftig herein, abzüglich des Stromverbrauchs von Lüftern und Spannungswandlerverlusten käme am Grafikchip selber dann "nur" noch 230 Watt an. Ob jene Rechnung gänzlich stimmt, wäre noch zu beweisen, da die hierfür angesetzten 2,5 Watt pro GDDR6X-Chip erstaunlich viel sind, GDDR5-Speicherchips bewegen sich nach realen Spiele-Stromverbrauchsmessungen bei unterhalb 1 Watt pro Chip (was natürlich noch keine exakte Aussage zu GDDR6X ergibt). Dies muß nVidias TDP-Rechnung allerdings keinen Abbruch tun, denn wenn die GDDR6X-Chips real wirklich weniger verbrauchen, bekommt der Grafikchip einfach mehr Strom unter dem alles regelnden Power-Limit zur Verfügung stellt. Daneben kommt dann noch eine neue Information zur Chipfläche des GA102-Chips, welche gemäß einer Zusammenmischung von Leaks und Hochrechnungen seitens Igor's Lab auf ca. 627mm² angegeben wird.

|

Damit würde nVidia wie gewünscht von den monströsen Chipflächen der Turing-Generation etwas herunterkommen, der TU102-Chip ist wie bekannt gleich 754mm² groß. Der ganz großen Flächeneffekt durch die (viel) bessere Fertigung ergibt sich damit aber auch noch nicht – möglicherweise ja auch ein Grund dafür, wieso nVidia nicht noch mehr Recheneinheiten aufbietet. Laut unserem Forum deutet jene Chipfläche im übrigen eher auf die Verwendung von TSMCs 7nm-Prozeß als denn Samsungs 8nm-Prozeß hin. Dies passt, sofern man die Packdichte von Navi 10 (41,0 Mio. xtors/mm²) ansetzt und gemäß des GA100-Chips davon ausgeht, das der GA102-Chip bei 65% von dessen Shader-Clustern ca. 25-30 Mrd. Transistoren wiegen dürfte. Die Packdichte des GA100-Chips von (66,6 Mio. xtors/mm²) darf man hierbei besser nicht beachten, da beim GA100-Chip zum einen der relative Anteil von Interfaces und anderen fixen Chipteilen geringer sein wird und es sich zum anderen um ein Chipdesign mit bewußt niedrigerem Takt und dafür dichter gepackten Transistoren handelt. Die Gaming-Chips sind hingegen üblicherweise explizite Hochtaktdesigns, wo man demzufolge die Transistoren nicht derart dicht packen kann. Als gänzlich sicher ist jene Flächenangabe allerdings noch nicht zu sehen, mit einem Teil der enormen GA100-Flächeneffizienz wären auch kleinere Chipflächen beim GA102-Chip im Bereich von 500-600mm² denkbar.

Die kürzlichen Meldungen zu nVidias Ampere-Grafikkarten mit TDPs bis zu 350 Watt sowie GeForce RTX 3060/3070 Karten mit "nur" 6/8 GB Speicher haben dann auch einige Diskussionen zu den Punkten Stromverbrauch wie Grafikkartenspeicher-Menge bei Gaming-Ampere aufkommen lassen. Dabei sei vorab daran erinnert, das in allen Fällen noch keine finalen Daten vorliegen bzw. in Details auch noch diverse Übermittlungsfehler vorliegen könnten. So erscheint es nach wie vor als unwahrscheinlich, das eine GeForce RTX 3080 mit 68 Shader-Clustern den gleichen TDP-Wert tragen soll wie eine GeForce RTX 3090 mit 82 Shader-Clustern – bei nur minimaler Differenz seitens der Speichermenge. Basierend auf dem gleichen GA102-Grafikchip sollte dieser Hardware-Unterschied eigentlich eine klar abweichende TDP ergeben, beispielsweise 250 zu 320 Watt. Durchaus nicht unmöglich, das in diesem Punkt die bisherigen Leaks/Gerüchte ungenau sind und somit durchaus eine TDP-Abstufung existiert – mit dann der Folge, das auch bei den kleineren Modellen des Ampere-Portfolios auch nicht ganz so hohe Stromverbrauchswerte zu befürchten sind.

Zur Frage der Grafikkartenspeicher-Menge wird dagegen die alte Diskussion geführt, wieviel Speicher nun wirklich gebraucht wird – mit guten Argumenten auf beiden Seiten, die von Beispielen mit hoher Speicher-Auslastung sowie Hinweisen auf die Breite der Spielelandschaft ohne derart exzessivem Speicherverbrauch getragen werden. Beide Argumentations-Linien haben da wohl Recht – wahrscheinlich liegt die Crux darin, das der Speicherverbrauch von PC-Spielen derzeit an einem Punkt ziemlich genau zwischen den beiden Polen steht, sich somit weder klar zur einen oder anderen Seite neigt. Zumindest aus reiner Käufer-Sicht erscheint es natürlich erst einmal nicht als plausibel, wieso nVidia nunmehr die gleich dritte Grafikchip-Generation (nach Pascal & Turing) mit grob denselben Speichermengen auflegen sollte. Aber vielleicht ist nVidia diesbezüglich einfach nur aufgrund der wirtschaftlichen Rahmendaten gezwungen: Eine Speicherverdoppplung bei gleichzeitig den kolportiert sehr hohen Speichertakten von GDDR6X käme wirklich teuer, zudem kann möglicherweise im Jahr des Launches beider NextGen-Konsolen der Zugriff auf ausreichend Speicher-Fertigungskontingente gar nicht garantiert werden (bzw. würde dann nochmals preistreibend wirken).

Zudem könnte für nVidia in dieser Frage schlicht der Gedanke entscheidend sein, möglichst keine ewig haltbaren Lösungen zu entwickeln – wie sie GeForce RTX 3070 & 3080 Grafikkarten mit gleich 16 GB Grafikkartenspeicher allerdings durchaus wären. nVidias (hoher) geschäftlicher Erfolg liegt zum Teil schließlich auch daran, das nVidia-Grafikkarten zumeist schneller altern und somit tendentiell eher ersetzt werden als AMD-Grafikkarten. Dies soll eine eventuelle Entscheidung gegen mehr Grafikkartenspeicher bei der Ampere-Generation natürlich nicht verteidigen – sondern nur eine Erklärung liefern, wieso es durchaus dazu kommen kann. Im übrigen hat es innerhalb der letzten Konsolen-Generation immerhin drei Jahre gedauert, eher die ersten xx70 & xx80 nVidia-Karten mit der Speichermenge jener Spielekonsolen (8 GB) antraten – dies waren GeForce GTX 1070 & 1080 im Jahr 2016 mit jeweils 8 GB Grafikkartenspeicher. Das der PC nicht gleich umgehend zur Speichermenge der jeweils neuen Konsolen-Generation aufschließt, ist gemäß dieses Beispiels aus der Vergangenheit also durchaus "normal".

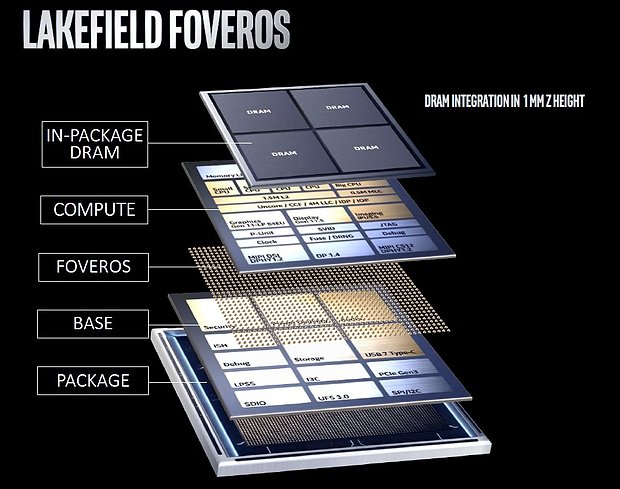

ComputerBase, Golem & Heise berichten über die offizielle Vorstellung der ersten Prozessoren-Modelle von Intels "Lakefield". Jener derzeit für den Tablet-Bereich gedachte SoC bringt das big.LITTLE-Konzept in die x86-Welt, indem Intel vier (langsame) CPU-Kerne der Tremont-Architektur (aus der Atom-Linie) mit einem (schnellen) CPU-Kern auf Basis von Sunny Cove (aka Ice Lake) in einen Prozessor gießt. Die Problematik der unterschiedlichen Feature-Sets (bezüglich HyperThreading & AVX) bringt man dabei schlicht darüber in Einklang, jene Features gänzlich zu streichen – sprich, es wird das niedrigere Feature-Set der Tremont-Kerne benutzt. Damit reduziert sich die Nutzbarkeit von Lakefield enorm, denn ganz ohne AVX-Fähigkeit ist ein breiter Einsatz im PC-Segment eher undenkbar – was hingegen bei der derzeit angedachten Nutzung rein im Tablet-Bereich wohl eher keine Rolle spielt. Viel interessanter an Lakefield ist jedoch der damit einhergehende Praxis-Test zweier Zukunftstechnologien bei Intel: Zum einen wird damit die MultiChip-Technologie "Foveros" erstmals eingesetzt, denn bei Lakefield liegen extra I/O-Die, Prozessoren-Die und DRAM-Package direkt übereinander.

Zum anderen will Intel das big.LITTLE-Konzept im Jahr 2022 dann bei einem seiner Haupt-Produkte nutzen – der "Alder Lake" Prozessoren-Generation. Hierzu wird schon seit geraumer Zeit von 8 kleinen und 8 großen CPU-Kernen berichtet, zudem soll Alder Lake erstmals seit der Auftrennung in extra Mobile- und Desktop-Serien auch wieder für beide Produktsegmente gemeinsam genutzt werden. Doch um ein big.LITTLE-Konzept im PC-Bereich wirklich sinnvoll hinzubekommen, muß der Windows-Scheduler ziemlich treffsicher dabei sein, welche Rechenkerne jeweils für welche Aufgabe zum Einsatz kommen. Intel kann hierbei mittels Lakefield sicherlich viel lernen, ohne dabei (im Gegensatz zu Alder Lake) in Gefahr zu sein, ein wirklich wichtiges Produkt in den Sand zu setzen. Erschwerend kommt hinzu, das AMD schon jetzt bei regulären Desktop-Prozessoren bis zu 16 CPU-Kerne aufbietet – und wenn Intel dies dann zwei Jahre später mittels eines big.LITTLE-Konzepts ebenfalls erreicht, man dafür dann natürlich auch irgendwelche Vorteile durch big.LITTLE aufzuzeigen muß. Einfach nur ähnlich gut zu sein, dürfte nicht ausreichen, gerade wo bei AMD im Jahr 2022 dann schon Zen 4 mit potentiell noch mehr CPU-Kernen auf dem Plan steht.

Wie der Computex-Veranstalter mitteilt, ist nun auch noch die Computex 2020 gestrichen – als letzte IT-Messe des Corona-Zeitalters, welche (nach Verschiebung auf September) tatsächlich noch hätte stattfinden sollen. Ursprünglich für 2. bis 6. Juni angesetzt und später auf den 28. bis 30. September verschoben, wird die Computex 2020 nunmehr ersatzlos ausfallen und dann einfach mit der Computex 2021 vom 1. bis 5. Juni 2021 weitergemacht. Grundlage dieser Absage dürfte wohl der Umstand gewesen sein, das vermutlich auch noch im Herbst existierende Reisebeschränkungen den üblichen Charakter der Messe als Industrie- und Business-Treffen zunichtegemacht hätten, ganz egal ob Taiwan in der Corona-Bekämpfung augenscheinlich erstklassige Arbeit abgeliefert hat. Derzeit schickt halt niemand seine wichtigen Mitarbeiter um den Globus, wenn damit nach Hin- und Rückreise eine verpflichtende 14tägige Quarantäne verbunden ist und Großveranstaltungen mit vielfältigen Personenkontakten sowieso das große NoGo des Corona-Zeitalters darstellen. Damit bleibt allein die IFA als letzte physisch stattfindende Messe übrig – unter starken Einschränkungen und sowieso nur für (geladene) Fachbesucher geöffnet.

| IT-Messen & -Konferenzen 2020 | Themen | Status | |

|---|---|---|---|

| 7.-10. Januar | Consumer Electronics Show (CES) in Las Vegas | AMD Renoir | hat stattgefunden |

| 24.-27. Februar | Mobile World Congress (MWC) in Barcelona | abgesagt | |

| 16.-20. März | Game Developers Conference (GDC) in San Francisco | Intel Xe | abgesagt |

| 23.-26. März | GPU Technology Conference (GTC) in San Jose | nVidia Ampere HPC | abgesagt |

| 2.-6. Juni | Computex in Taipei | AMD Zen 3 & Navi 2X (?) | abgesagt |

| 9.-11. Juni | Electronic Entertainment Expo (E3) in Los Angeles | Xbox Series X | abgesagt |

| 19.-23. Juli | SIGGRAPH in Washington | reine Online-Veranstaltung | |

| 16.-18. August | Hot Chips (HC32) | reine Online-Veranstaltung | |

| 25.-29. August | Gamescom in Köln | nVidia Ampere Gaming (?) | reine Online-Veranstaltung (27.-30. Aug.) |

| 4.-9. September | Internationale Funkausstellung (IFA) in Berlin | nur für Fachpublikum (3.-5. Sept.) | |

Translate

3DCenter unterstützen

Neueste Blogeinträge

Neue Forenbeiträge

Neue Beiträge im Forum Technologie

- nVidias Deep Learning Super Sampling - DLSS 2.x, DLSS 3.x, DLSS 4

- AMDs FidelityFX Super Resolution 2.0/3.0/4.0 (FSR 2.0, FSR 3.0, FSR 4.0)

- Optiscaler, das Multifunktionswerkzeug für Upscaling, Framegenerierung und mehr

- Real-time Raytracing

- DirectX 12 Ultimate und DirectStorage - NextGen-Gaming auf dem PC