Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 11. September 2019

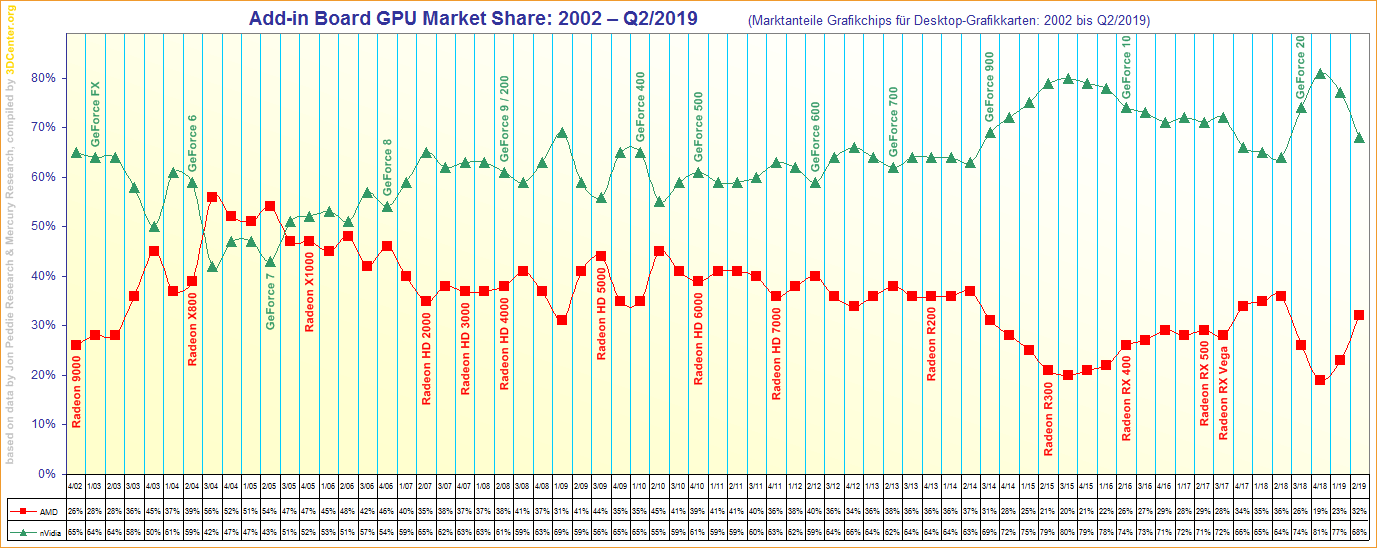

Auf Anregung unseres Forums wurden beim Übersichts-Diagramm zu den historischen Grafikchip-Marktanteilen ein grober Fehler zu den Werten des zweiten Quartals 2004 korrigiert – wobei (bislang) augenscheinlich die Werte zwischen AMD & nVidia vertauscht waren, wie zwei andere solcher Aufstellungen unabhängig voneinander auswiesen. Bei dieser Gelegenheit wurden auch die Werte eines alternativen Werte-Diagramms aus dem Beyond3D-Forum eingearbeitet, welches gerade in der weiter zurückliegenden Vergangenheit oftmals eine andere Wertequelle zugrunde liegen hatten – meistens Werte von Mercury Research anstatt von Jon Peddie Research. All dies ist nun in eine Neuauflage unseres Markanteil-Diagramms eingeflossen, womit sich auch abseits des genannten zweiten Quartal 2004 hier und da ein paar Wertekorrekturen ergeben haben – natürlich nichts, was jetzt besonders erwähnenswert wäre. Jenes Diagramm stützt sich auf die Werte der beiden genannten Marktbeobachter, wobei oftmals jeweils nur ein Wert vorhanden war, nur für eine vergleichsweise kurze Zeitspanne (Q3/2013 bis Q2/2017) durchgehend beide Werte vorlagen (welche bei Vorliegen dann gemittelt wurden). Das ganze erhebt somit natürlich keinerlei Anspruch auf echte Genauigkeit – es bildet einfach nur das ab, was öffentlich bezüglich dieser Marktanteils-Werte aus der Vergangenheit bekannt ist.

Igor's Lab berichten über das praktische Auftauchen der einheitliche Chip-Varianten bei GeForce RTX 2070 & 2080, sprich den Karten aus nVidias erster Turing-Generation. Im Vorfeld von nVidias "SUPER"-Refreshs gab es bereits eine entsprechende Meldung über die Abschaffung der bisherigen Auftrennung in zwei Chip-Versionen pro Grafikkarten-Modell, seinerzeit hatte man dies noch als nVidias Navi-Konter verstanden – aber vermutlich passiert dies einfach zusätzlich, auch weil die erste Turing-Generation nun inzwischen weitgehend vom Super-Refresh ersetzt wurde. Insofern sind jetzt auch die letzten GeForce RTX 2070 & 2080 Karten im Handel, wo man überhaupt noch diese einheitliche Chip-Variante vorfinden kann – deren BIOSe allerdings, wenn sie einmal in freier Wildbahn gelandet sind, natürlich auch für alle früheren GeForce RTX 2070/2080 Karten verwendet werden können. Primär gewinnt man durch diese Aktion ein höheres Power-Limit sowie einen größeren Power-Limit-Spielraum, was also eher nur für Übertakter interessant ist. Wie Igor's Lab hinweisen, sollte man aufpassen, ein BIOS mit einer halbwegs ähnlichen Lüfterkurve zu erwischen, um komischen Effekten wegen einer nicht zur Kartenkonstruktion passenden Lüftersteuerung aus dem Weg zu gehen. Aber natürlich ist das ganze sowieso nur etwas für erfahrene Übertakter, welche sich in diesen Fällen dann zu helfen wissen sollten.

| RTX 2070/2080 non-A | RTX 2070/2080 "A" | RTX 2070/2080 NEU | |

|---|---|---|---|

| Chip-Variante | TU106-400 bzw. TU104-400 | TU106-400A bzw. TU104-400A | TU106-410 bzw. TU104-410 |

| Taktraten | ausschließlich Referenztakt | frei nach Herstellergusto (üblicherweise um den FE-Takt herum) | frei nach Herstellergusto und Karten-Zielsetzung |

| Power-Limit | 175W (max. +16%) bzw. 215W (max. +24%) | frei nach Herstellergusto (üblicherweise wie bei der FE oder höher) | frei nach Herstellergusto und Karten-Zielsetzung |

| BIOS flashbar | nur auf non-A-Karten | nur auf "A"-Karten (außer FE) | auf alle Karten (außer FE) |

| Verwendung | ab Launch | ab Launch | ab Sommer 2019 |

Die PC Games Hardware hat sich eingehend mit der Grafikkarten-Performance von "World of WarCraft Classic" beschäftigt – wobei das Spiel trotz Classic-Look natürlich trotzdem eine bessere Bildqualität als das originale WoW bietet und damit auch höhere Hardware-Anforderungen mit sich bringt. Im trotzdem vorhandenen "Classic"-Bildqualitätspreset wird zudem tatsächlich die exakte Bildqualität des Originals geboten, was dann wirklich fast jede heutzutage noch real genutzte Hardware mitmacht. Maximiert man die Grafikqualität (unter wie gesagt weiterhin dem bekannten Classic-Look), gehen die Grafikkarten-Anforderungen ganz nett nach oben, für 60 fps fängt man unter der FullHD-Auflösung dann schon mit GeForce GTX 670 oder Radeon HD 7970 an – was im Umkehrschluß bedeutet, das noch ältere Grafikkarten-Generationen unter dieser Bildqualität keine 60 fps mehr erzeugen können. WoW-typisch ziehen die Grafikkarten-Anforderungen mit steigender Auflösung recht deutlich an, wobei die Speicherausstattung fast nie zum Problem wird: Selbst deren nur 2 GB Grafikkartenspeicher gereichen einer GeForce GTX 770 noch zu vernünftigen Ergebnissen bis hinauf zur UltraHD-Auflösung, nur die krumme Speicherbestückung der GeForce GTX 660 (schnelle 1,5 GB und langsame 0,5 GB) limitieren selbige Karte sehr deutlich schon ab der WQHD-Auflösung. Durchgehend und wiederum WoW-typisch ist ein gewisser nVidia-Vorteil, wobei jener trotz ca. 10-20% Umfang immer noch deutlich kleiner ausfällt als bei früheren WoW-Benchmarks.

| Grafikkarten-Empfehlung für "World of WarCraft Classic" (maximale Bildqualität @ 60 fps) | ||

|---|---|---|

| FullHD | GeForce GTX 670, GeForce GTX 760, GeForce GTX 960, GeForce GTX 1050, GeForce GTX 1650 oder Radeon HD 7970, Radeon R9 280X, Radeon R9 380, Radeon RX 470 | |

| WQHD | GeForce GTX Titan, GeForce GTX 780, GeForce GTX 970, GeForce GTX 1060 3GB, GeForce GTX 1650 oder Radeon R9 290X, Radeon R9 390, Radeon RX 480, Radeon RX 570 | |

| UltraHD | GeForce GTX 980 Ti, GeForce GTX 1070, GeForce GTX 1660 Ti oder Radeon RX Vega 56, Radeon RX 5700 | |

| interpoliert gemäß der Benchmarks bei der PC Games Hardware | ||

Bei Golem hat man sich mit dem Marktchancen von 8K beschäftigt, welches nun wie einstmals 4K einige Jahre brauchen dürfte, um sich zu etablieren. Als eine gewisse Chance für 8K sieht man dabei die kommenden NextGen-Spielekonsolen Xbox Scarlett & Playstation 5 an, welche bekannterweise beiderseits diese Auflösung beherrschen werden. Dies dürfte allerdings aufgrund der zu erwartenden Hardware-Daten wirklich nur für die Ausgabe-Auflösung gelten – sprich, es kommt ein 8K-Signal am Fernseher an, was jedoch nichts über die zugrundeliegende Auflösung bzw. die interne Rendering-Auflösung aussagt. Konkret dürften beide Spielekonsolen sowie nur im besten Fall die Rohleistung für 4K-Rendering mitbringen – welches dann auf 8K hochskaliert an den Fernseher geliefert wird. Ob dieser "Behelfsweg" ausreichend ist, um 8K-Fernseher zu promoten, wäre allerdings zu bezweifeln – was um so kritischer wird, je weiter sich diese NextGen-Konsolen in der Spielepraxis vom 4K-Rendering entfernen. Denn die vermutliche Rohleistung der NextGen-Konsolen dürfte unter heutigen Spielen mit Hängen und Würgen für ein 4K-Rendering reichen – was sich dann jedoch im Laufe des Konsolen-Lebenszyklus kaum aufrecht erhalten lassen wird, jedenfalls nicht für AAA-Titel mit hohem Grafik-Einsatz.

Die andere Variante eines 8K-Einsatz in Form von Spielestreaming-Diensten ist dann nochmals zweifelhafter: Denn Spielestreaming und höchstmögliche Bildqualität im Grenzbereich passen kaum zusammen – schon allein aus Sicht der immens steigenden Bandbreite-Anforderungen, wenn man diese Auflösung wirklich durchs Internet jagen wollte. In aller Regel dürfte man vom internen 8K-Rendering auf den Servern des Spielestreaming-Anbieters kaum etwas sehen, weil für die Internet-Übertragung zu viele Komprimierungs-Optimierungen zum Einsatz kommen. Selbst 4K-Spielestreaming ist aus dieser Sichtlage eher anzuzweifeln, je nach Komprimierungsgrad kann das herauskommende Bild sich kaum noch von einem soliden FullHD-Bild unterscheiden. Davon abgesehen passen (superteure) 8K-Fernseher und Spielestreaming Käufergruppen-technisch sowieso kaum zusammen – das eine ist absoluter Enthusiasten-Bereich, das andere soll zukünftig mal Massenmarkt werden. Zumindest über diese zwei Schienen erscheint 8K kaum als demnächst durchsetzbar – und somit der jahrelange Gang durch die Niederungen des Nischenmarkts kaum vermeidbar. Die einzige sichtbare Chance liegt wohl bei sehr großen TV-Geräten (ab 80 Zoll) – welche allerdings schon rein Kosten-mäßig ziemlich weit vom Massenmarkt entfernt sind.