Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 15. August 2018

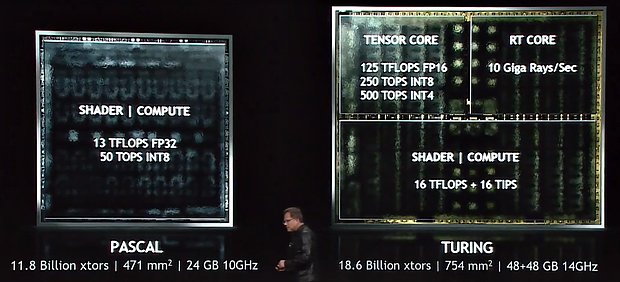

Da die Frage aufkam, woher die Angabe von "ein Drittel der Chipfläche für RayTracing-Funktionalität" bei den beiden Turing-Chips GV102 & GV106 herkommt, sei hiermit folgende Modellrechnung kredenzt: Sehr gut vergleichen lassen sich hierzu GP102 (Pascal, 471mm², 16nm) und GV102 (Turing, 754mm², 12nm), da zu diesen in der selben Enthusiasten-Klasse liegenden Grafikchips alle benötigten Daten vorliegen. nVidia hat Gaming-seitig dem GV102 schlicht 20% mehr Shader-Einheiten sowie ein GDDR6- anstatt eines GDDR5X-Speicherinterfaces gegenüber dem GP102 spendiert. Wollte man einen hypothetischen "GP101"-Chip auflegen, der wie der GV102-Chip dann 4608 anstatt 3840 Shader-Einheiten sowie ein GDDR6- anstatt eines GDDR5X-Speicherinterface trägt, aber eben ohne RayTracing-Funktionalität daherkommt, passiert folgendes: Rein die Shader-Einheiten machen üblicherweise ca. nur die Hälfte des Grafikchip-Dies aus, dies wäre also eine Chipflächen-Steigerung von nur +10%. Der Maximalfall liegt dagegen logischerweise bei +20%, das andere Speicherinterface und diverse Architektur-Verbesserungen eingerechnet. Der Realwert dürfte dann ziemlich in der Mitte dessen liegen, ergo bei +15% Chipflächen-Steigerung. Die Differenz zwischen 16nm- und 12nm-Fertigung spielt bei diesen Grafikchips augenscheinlich keine beachtbare Rolle, da die Menge an Transistoren pro mm² zwischen GP102 und GV102 ungefähr gleich ausfällt (ca. 25 Mill. Tr./mm²) – würde aber in jedem Fall sowieso nur eine noch etwas kleinere Chipfläche beim GV102-Chip ergeben.

| Hardware-Einheiten | Chipfläche | Fertigung | Packdichte | |

|---|---|---|---|---|

| Pascal GP102 | 3840 SE @ 384 Bit GDDR5X | 471mm² | 16nm | 25,1 Mio Tr./mm² |

| (hypothetischer) "GP101" | 4608 SE @ 384 Bit GDDR6 | ~542mm² | rein hypothetisches Modell | |

| Turing GV102 | 4608 SE @ 384 Bit GDDR6 + Tensor + RT | 754mm² | 12nm | 24,7 Mio Tr./mm² |

Einen (hypothetischen) "GP101"-Chip, hochgepumpt von 3840 auf 4608 Shader-Einheiten und mit GDDR6- anstatt GDDR5X-Speicherinterface, aber ohne RayTracing-Funktionalität, hätte nVidia also für ~542mm² auflegen können. Da der reale GV102-Chip nun aber 754mm² wiegt, geht der "Rest" für RayTracing-Funktionalität drauf, sprich Tensor-Cores und den RT-Core (samt größerem Level2-Cache). Dies sind immerhin ~212mm² oder ~28% der Chipfläche, was zwischen einem Drittel und einem Viertel der Chipfläche rangiert (die grobe Angabe "ein Drittel" ist demzufolge etwas zu hoch gegriffen). Selbst wenn man sich hierbei noch etwas verspekuliert, kommt wahrscheinlichst mindestens eine Größe von 25% aka einem Viertel der Chipfläche für die RayTracing-Funktionalität heraus. Selbige Angabe ist sogar noch vergleichsweise handzahm, in nVidias (natürlich nur schematischen) Schaubildern nehmen Tensor-Cores und RT-Core gern gleich die Hälfte der Chipfläche ein. Die von uns aufgestellte Angabe zur Chipfläche des "kleineren" GV104 ergibt sich dann im übrigen aus einer einfachen Rückrechnung: Zwischen GP104 und GP102 existiert der Faktor 1,5 bei der Chipfläche – bezogen auf GV104 und GV102 ergibt dies dann grob ~500mm² beim GV104-Chip. Die Symetrie der Hardware-Einheiten ist zwischen beiden Vergleichs-Paarungen jeweils identisch, so das es kaum wirklich weniger sein kann – nVidia geht also tatsächlich mit derartigen Monster-Chips auch ins normale Gaming-Segment.

In jedem Fall sorgt die RayTracing-Funktionalität für ein gewisses Oha-Erlebnis unter den Hardware-Enthusiasten, denn selbige war in der dargebotenen Breite nicht erwartet worden – was nachfolgend natürlich ausführliche Diskussionen darüber nach sich zieht, inwieweit das ganze demnächst real nutzbar sein wird. Teilweise wird RayTracing dabei mit der Einführung entscheidener früherer Grafikchip-Features verglichen – welche am Anfang auch nur mehr Chipfläche belegt, aber keine zusätzliche Performance gebracht haben. Mittels dieser früheren Innovationen wissen wir allerdings, das diese Pionier-Arbeit manchmal einfach notwendig ist, um überhaupt den Boden für ein neues Feature oder eine neue Technologie zu bereiten – ganz egal, ob die initiale Generation sich dann als eigentlich zu langsam für deren breitflächigen Einsatz herausstellt. Gerade bei RayTracing und dessen enormen Hardware-Anforderungen dürfte es sicherlich passieren, das man in späteren Grafikchip-Generationen über die RayTracing-Power von Turing nur noch müde lächeln kann, man einstmals mit dramatisch höheren Werten operieren muß, um echtes RayTracing zu ermöglichen. Turing stellt halt "nur" den Einstieg dar – und ist aus Gamer-Sicht nicht mehr als ein oben drauf gelegtes Feature, welches kaum etwas zur Grundperformance in heutigen Spielen beiträgt.

nVidia leistet sich dies halt, weil man die Entwicklung des Grafik-Renderings vorantreiben will – und natürlich auch, weil die Situation derzeit günstig ist, da AMD seine Kräfte in den letzten Jahren in die CPU-Entwicklung gesteckt hatte und derzeit keine entscheidende Gegenwehr liefern kann. Hätte man derzeit einen eher ausgeglichenen Grafikchip-Markt, könnte es sich hingegen kein Anbieter leisten, ein Viertel der Chipfläche für nicht umgehend Performance-relevante Features zu opfern. nVidia nutzt hier die Gunst der Stunde und geht technologisch voran zu einem Zeitpunkt, wo der Wettbewerb schwach ist – und kann dann, wenn der Wettbewerb eines Tages wieder erstarken sollte, möglicherweise schon die Früchte dieser technologischen Entwicklung in Form eines Feature-Vorsprungs ernten. Wobei bei RayTracing komplette Eigenwege eher auszuschließen sind, da alles letztlich in DirectX 12 übernommen werden soll. Vermutlich erreicht nVidia keinen wirklich großen technologischen Vorsprung – sondern eher nur einen verkaufspsychologischen, weil man nun für Medienschaffende (Quadro RTX) und Gamer (GeForce RTX) das Thema "RayTracing" optisch als erster anpackt.

Ausgehend von einer Meldung in unserem Forum hat man sich bei Golem die Problematik der Spiele-Performance des Ryzen Threadripper 2990WX nochmals angesehen – diesesmal nicht auf einer der ansonsten zumeist genutzten nVidia-Grafikkarten, sondern auf einer Radeon RX Vega 64. Und auf selbiger hatte der 32-Kern-Prozessor unter CPU-limitierten Settings wesentlich seltener mit schwachen Frameraten unter Spielen zu kämpfen, im genauen gab es satte +38% mehr Performance auf der Radeon RX Vega 64 gegenüber der nominell klar stärkeren GeForce GTX 1080 Ti. Anders formuliert hat nVidia hier augenscheinlich ein gehöriges Treiber-Problem bei Verwendung so vieler CPU-Kerne bzw. CPU-Threads. Und da fast alle der Launchreviews zum Threadripper-2000-Launch mit nVidia-Grafikkarten getestet haben, sind die dabei entstandenen Benchmark-Ergebnisse zumindest im Fall des 32-Kerners Ryzen Threadripper 2990WX wohl zumeist ziemlich umsonst gewesen. Hier sollte man zu entsprechenden Nachtests schreiten, sobald nVidia das hierbei vorliegende Treiberproblem gelöst hat. Laut dem initialen Forenposting betrifft das Problem im übrigen nicht nur AMD-Prozessoren, sondern auch Intel-Prozessoren bei 64 CPU-Threads, ist damit also nicht Threadripper-spezifisch.

Da es beim letzten Mal möglicherweise noch nicht eindeutig genug war, hat Intel auf Twitter nun nochmals die kommenden Intel-Grafikchips für das Jahr 2020 angeteasert – diesesmal sogar in Form einer (symbolischen) Grafikkarte. Dies muß natürlich nicht bedeuten, das Intel schon im Jahr 2020 seine (seit zwei Dekaden) ersten dedizierten Grafikchips sofort auf extra Grafikkarten packt – aber zumindest wird klar, das man mit diesen Grafikchips keineswegs nur im Segment der mobilen Lösungen bleiben will, welche dann allein die Notebook-Hersteller kaufen und verbauen. Dies wird sicherlich ein dankbarer Einstieg für Intel, schließlich hat man diese Geschäftsbeziehung mit den Notebook-Herstellern bereits – aber die gezeigte Grafikkarte deutet klar darauf hin, das man mehr will, das es auch um extra Grafikkarten gehen soll. Wieviel man sich hierbei anfänglich zutraut, wird noch herauszufinden sein, derzeit deutet ja alles eher auf Mainstream-Beschleuniger hin – was jetzt auch nicht schlimm wäre, aller Anfang wird schwer und mit dem ersten Produkt dürfte man sicherlich kaum bereits alles richtig machen können bzw. alle Teilsegmente abdecken. Interessant wird noch werden, mit welchen Grafikkarten-Herstellern Intel diesbezüglich zusammenarbeiten will – vermutlich kommen alle Hersteller in Frage, die jetzt schon AMD-Grafikkarten anbieten, während die reinen nVidia-Hersteller wahrscheinlich zugunsten der Geschäftsbeziehung mit nVidia "freiwillig" verzichten dürften.