Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 15./16. Juli 2017

Der TechSpot hat einen umfangreichen Benchmark-Vergleich der beiden "kleinen" Midrange-Lösungen Radeon RX 570 4GB vs. GeForce GTX 1060 3GB aufgelegt. Normalerweise sollten beide Grafikkarten im selben Preisfeld bei knapp unter 200 Euro spielen – bei der Radeon RX 570 läuft dies allerdings derzeit eher denn auf "Trockenschwimmen" hinaus, da jene Karte momentan nur zu Mondpreisen erhältlich ist (und auch die nVidia-Lösung beachtbar teurer kommt als noch im Mai). Bezüglich der Performance beider Karten ist man beim TechSpot leicht der AMD-Lösung zugeneigt, bei allerdings einer minimalen (durchschnittlichen) Differenz zwischen beiden Karten. Deutliche Ausschläge, welche auf die geringere Speicherausrüstung der nVidia-Karte zurückzuführen sind, waren erstaunlich eher selten zu beobachten (unter FullHD in 1 von 29 Tests, unter WQHD in 3 von 29 Tests), da hatten anderen Testberichte schon schlimmere Ergebnisse vorzuweisen. Trotzdem ist natürlich immer in Frage zu stellen, eine schwache Speicherbestückung einzukaufen, wenn selbiger schon zu deren Releasezeitpunkt eine gewisse Grenzwertigkeit nachzuweisen war. Zwar kann keiner sagen, das der Hunger nach mehr Grafikkartenspeicher jetzt unbedingt so rasant weitergehen wird – aber das sich die Spieleentwickler bedenkenslos auf den heutigen Speichermengen ab 4 GB (und nicht ab 3 GB) einrichten werden, das darf man durchaus annehmen.

Nachzutragen wäre noch zur GeForce GT 1030 der gar nicht einmal so unwichtige Punkt, das jene (im Mai vorgestellte) LowCost-Lösung von nVidia nicht über G-Sync (und damit ein vergleichsweise wichtiges nVidia-Feature) verfügt. Sicherlich kann man seitens nVidia damit argumentieren, das Nutzer der GeForce GT 1030 kaum den Mehrpreis für G-Sync-Monitore berappen werden – das jene aber überhaupt einen wesentlichen Mehrpreis haben, ist das Problem und die Verantwortung von nVidia höchstselbst. Technisch gesehen wäre schließlich auch eine Unterstützung des offiziellen Standards "Adaptive Sync" oder aber von AMDs freiem Standard "FreeSync" (technische Basis von "Adaptive Sync") bei der GeForce GT 1030 machbar. So hat die nVidia-Lösung nun einen erheblichen Nachteil gegenüber AMDs im gleichen Preis- und Performancefeld spielender Radeon RX 550, welche natürlich AMDs FreeSync-Lösung unterstützt und damit auch Zugriff auf die kostengünstigeren FreeSync-Monitoren (im Gegensatz zu den teureren G-Sync-Monitoren) hat. Ob ein solches Feature auch für LowCost-Grafikkarten Sinn macht, darf sicherlich diskutiert werden – aber der einen These, das dies bei LowEnd-Gaming nicht zwingend sein muß, steht die andere These gegenüber, das G-Sync & FreeSync gerade bei den niedrigen von LowCost-Grafikkarten erzeugte Frameraten für einen flüssigeren Bildeindruck sorgen sollten.

Ein weiterer Diskussionsbeitrag zur Frage, wie sinnvoll 10-Kern-Prozessoren fürs Gaming sind, kommt von PCGamer: In deren Spieletests lag selbst unter der FullHD-Auflösung mit einer GeForce GTX 1080 Ti ein Core i9-7900X nur ein einem von 16 Tests (!) vor einem Core i7-7740K – und dies nur um einen geringen Vorteil. In der Summe der Tests liegen Core i7-7740K wie auch Core i7-7700K ein kleines bißchen vor dem Core i9-7900X – welcher wie bekannt fast das Dreifache kostet. Selbst ein Core i5-7600K, welcher durch das Verzicht auf HyperThreading technisch wirklich beschnitten ist, kommt im Durchschnitt der Frameraten auf immerhin 95% des Niveaus des Core i9-7900X. Die hierfür angestellten Benchmarks auf der FullHD-Auflösung mit einer GeForce GTX 1080 Ti stellen natürlich nur einen Ansatz der CPU-Performanceermittlung unter Spielen dar – ergeben allerdings durchaus eine wichtige Aussage, gerade für den Massenmarkt: Wenn es einfach nur um eine effiziente Spiele-Beschleunigung geht und kein größeres Interesse an tieferliegenden Details existiert, dann sind in der Tat die schnellsten Consumer-Modelle die sinnvolleren Gaming-CPUs. Für Skylake-X etc. im Gaming-Einsatz braucht man schon eine ausgefeilte Begründung – allein die höhere Anzahl an CPU-Kernen ist hierbei nicht zielführend. (Foren-Diskussion zum Thema)

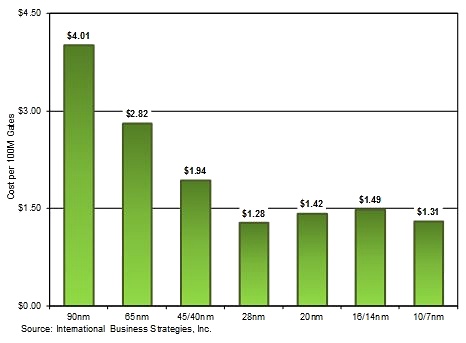

Eine in unserem Forum gezeigte und von der Consulting-Firma IBS Inc. stammende Grafik weist auf die stark steigenden Halbleiter-Kosten für neue Chipprojekte hin. In der Grafik selber schaut dieser Fakt deutlich freundlicher aus – aber letztlich bedeutet das Fehlen einer erheblichen Kostenreduktion pro Gate nach der 28nm-Fertigung, das neue Chipprojekte mit höherer Transistorenanzahl auch entsprechend mehr kosten. Zu gleicher Kostenlage würden sich nur Projekte realisieren lassen, welcher ohne höhere Transistorenanzahl daherkommen – für diese benötigt man die neue Fertigung allerdings auch wieder nicht. Denn was sich in älteren Fertigungsverfahren gut herstellen läßt, dies braucht man nicht zwingend (kostet ja auch wieder Geld) auf ein neues Verfahren transportieren (Ausnahmen, wenn man damit niedrigere Verlustleistung & höhere Taktraten erreichen kann, bestätigen die Regel). Sobald man allerdings – wie die Hersteller von CPUs & Grafikchips – bedeutsam mehr Transistoren verbauen will, stört diese Entwicklung ungemein, wird alles sehr erheblich teurer in der Fertigung. Denn gerade bei den Grafikchip-Entwicklern wird regelmäßig eine grobe Verdopplung der Transistoren-Anzahl bei der jeweils nächsten Grafikchip-Generation angestrebt.

Aufgrund der puren Größe sowie der Verlustleistung der entstehenden Chips wäre eine Fertigung in einem "alten" Prozeßnode hierbei allerdings gar nicht mehr möglich, muß also zwingend die neueste Fertigungstechnologie herangezogen werden. Trotz Kostenreduktionen an anderen Fronten (Baukasten-System zugunsten einfacherer Chipdesigns) sowie des vergleichsweise kleinen Anteils der reinen Fertigungskosten am Abgabepreis (mittels welchem natürlich auch alle vorhergehenden Forschungs- und Entwicklungskosten abgegolten werden müssen) zwingt diese Entwicklung die Grafikchip-Entwickler letztlich zum Anziehen der Grafikchip-Preise – und dies nicht in geringfügigem Maßstab, wie man mit den Preisen der ersten 14/16nm-Grafikkarten letztes Jahr schon ganz gut sehen konnte. Problematisch ist vor allem, das dies kein Einmaleffekt gewesen sein dürfte, sondern eine Zukunftsprognose basierend auf dieser Grafik genau dieselben Preissteigerung nunmehr mit jedem neuen Fertigungsverfahren ergibt. Möglicherweise deswegen legt nVidia seine Pascal-Generation in der 12nm- anstatt der 10nm-Fertigung auf: Unter der 10nm-Fertigung würde das ganze (trotz kleinerer Chipfläche) gar nicht einmal günstiger kommen, sondern wäre terminlich kritischer und damit sogar riskanter.