Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 21./22. August 2018

Die PC Games Hardware hat sich in mehreren Videos den ersten RayTracing-unterstützenden Spielen gewidmet: Shadow of the Tomb Raider, Metro: Exodus und Assetto Corsa Competizione. Dabei handelt es sich allerdings "nur" um abgefilmte Messeaufnahmen – und in jedem Fall um Spieletitel, deren RayTracing-Funktionalität noch lange nicht in einem Veröffentlichungs-Zustand ist. Demzufolge kann man auf die zu sehende Performance, welche unter RayTracing-Einsatz augenscheinlich eher mittelprächtig bis schwach ist, derzeit noch nicht viel geben. In jedem Fall wird hiermit jedoch deutlich, daß das ganze kein Selbstläufer wird – RayTracing gibt es nicht für umsonst, dies gilt viel stärker als bei jeglichen früheren Grafik-Innovationen. Bezüglich Battlefield V hat die PCGH dies dann noch einmal genauer erklärt – wobei auch der Sonderfall zur Sprache kam, das RayTracing im Fall von Spiegelungen die bisher notwendigen, recht aufwendigen und trotzdem nur zu einer durchschnittlichen Optik führenden Tricks und Kniffe der Spieleentwickler deutlich vereinfachen kann (Performance kostet es allerdigs trotzdem). Bezüglich des RayTracing-Einsatzes dürfte die kommende Turing-Generation sicherlich noch etwas zu schwach sein – das ganze dient eher dazu, das die Spieleentwickler jetzt schon etwas zum Anfassen und Ausprobieren haben, damit die Übernahme in echte Spiele mit späteren RayTraing-Beschleunigern schneller und breiter erfolgen kann.

Videocardz weisen auf das Detail hin, das die GeForce RTX 2070 über keinen NVLink-Anschluß verfügt, womit bei dieser Karte auch kein SLI-Feature zur Verfügung steht (nVidia löst die SLI-Verbindung in der Turing-Generation über NVLink). Technisch gesehen würde zwar auch eine SLI-Verbindung über PCI Express funktionieren, aber dies ist deutlich langsamer und wird eigentlich nicht mehr gern verwendet, bei der GeForce RTX 2070 dann womöglich per Treiber auch gar nicht zur Verfügung stehen. Damit wird SLI rein praktisch ins Segment der echten HighEnd- und Enthusiasten-Lösungen verschoben – unterhalb von GeForce RTX 2080 gibt es somit wohl kein SLI. Dabei ist SLI eigentlich derzeit faktisch "tot" – aber mittels RayTracing könnte selbiges eines Tages durchaus wieder zurückkommen, unter einem echten RayTracing-Renderer besteht ja kein Problem mit einer größtmöglichen Parallelisierung der Rechenkraft mehr. Ob das ganze auch einen technischen Hintergrund in Form eines anderen Grafikchips hat, oder einfach nur eine Sparmaßnahme speziell bei der GeForce RTX 2070 darstellt, ist noch etwas umstritten. Gemäß früherer Gerüchte, welche bis jetzt vergleichsweise (aber nicht 100%ig) treffsicher waren, soll die GeForce RTX 2070 auf einem eigenen TU106-Chip basieren – was wir allerdings nach wie vor bezweifeln.

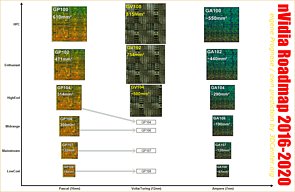

Schließlich hat die GeForce RTX 2070 mit 2304 Shader-Einheiten glatt 75% des Vollausbaus des TU104-Chips (3072 Shader-Einheiten) aktiv. Dies sind dieselben 75% wie bei der vorhergehenden GeForce GTX 1070 (1920 von 2560 Shader-Einheiten) – und vor allem gilt, das für diese geringe Differenz üblicherweise niemand einen extra Grafikchip auflegt. Die normalen Abstände lauten auf dem Doppelten der Recheneinheiten, nur bei absoluten Spitzenchips (wie zwischen TU104 und TU102) geht dies mal auf nur +50% zurück. Von 2304 zu 3072 sind es aber nur +33%, was als klar zu wenig für einen extra Grafikchip erscheint. Im übrigen dürfte genau an dieser Stelle vermutlich die "Bruchstelle" der früheren Turing-Gerüchte seitens AdoredTV liegen, welche wie gesagt bis jetzt vergleichsweise treffsicher waren: Es lagen dort aller Vermutung nach authentische Informationen zu GeForce RTX 2080 & 2080 Ti sowie Teilinformationen zur GeForce RTX 2070 vor. Leider wurde der Rest der Turing-Generation dann freischaffend und vor allem ohne echten Hinweis auf diese Eigenkreation selber hinzugetragen – und stellt sich vermutlich als Nonsens heraus. Denn derzeit läuft alles eher darauf hinaus, das die Turing-Generation nur aus den beiden großen Grafikchips TU104 & TU102 besteht, und das nVidia darunter dann schlicht weiterhin die bekannten Pascal-Grafikkarten im Angebot behält. Aufgrund der hohen Turing-Preise kann nVidia sogar alles bis zur GeForce GTX 1070 Ti problemlos weiterführen, muß das Pascal-Portfolio weder preisgesenkt noch wirklich ersetzt werden.

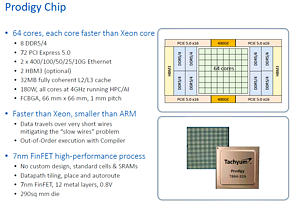

Golem und Heise thematisieren die Ankündigung der Prodigy-CPU von Tachyum auf der Hot Chips 2018, bei AnandTech findet man einen Live-Blog von der abgelaufenen Präsentation, bei Fefe eine harsche Kritik zu Vorstellung und Medienecho. Dabei verspricht das Startup Tachyum richtig großes: Man will Intels Xeon und (teilweise) nVidias Tesla mit einem 64-Kern-Prozessor im Datacenter-Einsatz abhängen können. Das Tape-Out des 290mm² großen Chips soll nächstes Jahr in der 7nm-Fertigung von TSMC erfolgen, voraussichtlicher Marktstart wäre dann das Jahr 2020. Das Leistungsversprechen bezieht sich wohl primär auf die hohe Anzahl an CPU-Kerne auf immerhin 4 GHz Takt zu einer TDP von 180 Watt, hinzu kommen großvolumige Anbindungen an die Außenwelt: Es gibt ein Achtkanal-Speicherinterface für DDR4 und GDDR5, ein (derart angegeben) "optionales" Zweikanal-Speicherinterface für HBM3 (bedeutet wohl ein 2048 Bit Interface wie bei Vega 10) sowie satte 72 PCI Express 5.0 Lanes. Chip-intern verfügen die Pipelines jeder der CPU-Kerne über drei Integer-Recheneinheiten sowie fünf Vector-Recheneinheiten, dabei werden bis zu 512 Bit breite Instruktionen verarbeitet.

Der eigentlich bemerkenswerte Punkt liegt jedoch darin, das es sich hierbei um ein In-Order-Design auf Basis eines eigenen Befehlssatzes handelt, x86- oder ARM-Code läuft hierauf nur (angeblich zur Laufzeit) emuliert. Das Tachyum damit (trotz on-the-fly-Emulation) eine höhere Pro-Kern-Performance als Intels Xeon anpeilt (und in den Ruhephasen mal nebenbei AI-Beschleunigungen durchführen will), geht dann sicherlich schon in Richtung "unglaubwürdig", denn: In-Order ist ja nun generell viel langsamer als Out-of-Order, und Emulation anderer CPU-Befehlssätze war noch nie für eine wirklich herausragende Performance bekannt. Der letzte Prozessor, welcher selbiges versucht hat, war im übrigen Intels Itanium – welche nach Jahren der Entwicklung wie Weiterentwicklung und Milliarden Dollar an Kosten letztlich doch eingestellt wurde, weil jener nie zu einem sinnvollen Ergebnis gefunden hat. Das Tachyum dies alles besser machen und gleich mit dem allerersten Wurf Intel schlagen können will, ist reichlich hoch gegriffen (andere würden sagen "vermessen"). Es ist zwar sicherlich nichts gänzlich unmöglich, aber bei solcherart Versprechen von Neueinsteigern gilt generell: Jene müssen ihr Versprechen am fertigen Chip demonstrieren, vorher zählt das nur als PR-Luftblase.