Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 30. Juli 2020

Auf Twitter hat Kopite7kimi mal wieder eine seiner Wasserstandsmeldungen zu nVidias Gaming-Ampere von sich gegeben – welche sich augenscheinlich immer auf aktuelle Testsamples und deren Hardware-Spezifikationen beziehen. Weil nVidia hierbei sicherlich noch in die eine oder andere Richtung hin testet, ergeben sich ab und zu (leicht) abweichende Spezifikationen, weswegen hieraus noch nicht der finale Stand abgeleitet werden kann – wie vom Twitterer aber auch regelmäßig angemerkt. Die aktuelle Entwicklung scheint nunmehr in diese Richtung zu gehen, dass die ganz hohen Speichertaktungen oberhalb 20 Gbbps nicht mehr im Plan stehen – die GeForce RTX 3090 wird mit 19,5 Gbps und die GeForce RTX 3080 mit 19 Gbps gemeldet. Dies erscheint als wesentlich plausibler als höhere Taktraten oder aber ein größerer Taktraten-Unterschied zwischen beiden Karten, welche ja sowieso schon ein erheblicher Unterschied bei der Breite des Speicherinterfaces trennt (384 Bit zu 320 Bit). Basierend auf diesen Daten wird die GeForce RTX 3090 eine um +23% höhere Speicherbandbreite gegenüber der GeForce RTX 3080 aufweisen – was gut zur Differenz bei der Anzahl der Shader-Cluster passt (82 zu 68, +21%).

Maybe,

3090 19.5Gbps 384bits 936G

3080 19Gbps 320bits 760G

Quelle: Kopite7kimi @ Twitter am 29. Juli 2020

Möglicherweise anhand dieser Spezifikations-Aussagen ergab sich anschließend ein kurzer Wortwechsel der Twitterer KatCorgi und Kopite7kimi bezüglich der zu erwartenden Performance von Gaming-Ampere bzw. in diesem Fall der GeForce RTX 3090 als dem augenscheinlichen Top-Modell außerhalb etwaiger Titan-Karten (nach wie vor scheint die Namenswahl zwischen "GeForce RTX 3080 Ti" und "GeForce RTX 3090" nicht klar zu sein). Ersterer fragte bezüglich einer (bis zu) 50%igen Performance-Steigerung unter dem 3DMark13 TimeSpy Extreme (gegenüber der GeForce RTX 2080 Ti), zweiterer antwortete darauf mit einer klaren Bestätigung ("It's true.") sowie der Angabe, dass es nahezu 10.000 Punkte sein sollen. Und selbiges zeigt dann in der Tat auf ein sehr kräftiges Performance-Plus hin, denn eine GeForce RTX 2080 Ti FE rangiert laut der Testberichte von Hardwareluxx und Overclock3D bei ca. 6300-6350 Punkten. Selbst bei angenommen "nur" 9500 Punkten für die GeForce RTX 3090 wäre damit die initiale Performance-Vorhersage von +50% schon erreicht, potentiell könnte es auch leicht mehr werden.

RTX 3090 may up tp 50% PERFORMANCE INCREASE in TimeSpy Extreme ?????

Quelle: KatCorgi @ Twitter am 30. Juli 2020

It's true. Almost 10000pts.

Quelle: Kopite7kimi @ Twitter am 30. Juli 2020

Eine Aussage zur generellen Mehrperformance der GeForce RTX 3090 ist daraus aber schwerlich abzuleiten, da die 3DMarks üblicherweise oberhalb des allgemeinen Gaming-Schnitts skalieren, speziell wenn man den reinen Graphics-Score ansetzt (welcher Wert mit der Benchmark-Angabe gemeint ist, wurde nicht genauer ausgeführt). Gut möglich also, dass es sich hierbei eher um einen Bestcase handelt und die durchschnittliche Mehrperformance der GeForce RTX 3090 etwas darunter liegt – defensiv gedacht bei +40-45%. Dies wäre angesichts der Hardware-Ansetzung (nur +17% mehr Shader-Cluster zwischen GA102 und TU102, gleiches Speicherinterface) dann durchaus kein schlechtes Ergebnis. Andererseits sind auch eventuelle Jubelstürme ob der potentiell +50% Mehrperformance nicht wirklich angebracht, denn für einen kompletten Fullnode-Sprung (12nm auf 8nm, sprich Derivat von 16nm auf Derivat von 10nm) wäre der Performance-Gewinn nicht herausragend und weit unterhalb dessen, was man "früher" für einen solchen Fullnode-Sprung bekommen hat. Um AMD bei "Big Navi" eine schwere Nuß zu geben, dürfte es allerdings vermutlich ausreichend sein – wenngleich diese ziemlich ungenaue und vor allem vollkommen unbelegte Benchmark-Aussage eigentlich keine ganz großen Erörtungen wert ist.

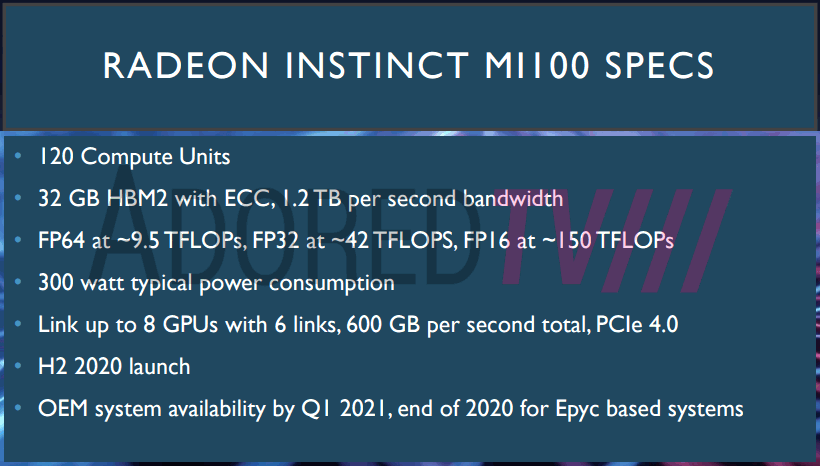

Bei AdoredTV hat man einen kürzlichen Leak mit Rohleistungs-Daten zu "Radeon Instinct MI100" HPC-Lösung auf Basis von AMDs "Arcturus"-Chip mittels weiterer Präsentationsfolien nochmals besser zu belegen versucht. Jener zusätzliche Beleg ist wohl notwendig, denn nach wie vor werden die Angaben zur Rohleistung nicht geglaubt, klingen jene teilweise einfach zu unglaubwürdig (die grundsätzlichen Hardware-Spezifikationen von "Arcturus" sind hingegen seit längerem bekannt). Die neuen Präsentationsfolien werden teilweise aber auch wieder in Frage gestellt – das ganze bleibt also ein Streithema. Dabei klingen 9,5 TFlops FP64 zu 42 TFlops FP32 zu 150 TFlops FP16 bei bekannt 120 Shader-Clustern tatsächlich "uneinheitlich", ergäbe dies bei konventioneller Chip-Ausführung und einem DP/SP-Verhältnis von 1:2 eine Taktrate von 1237 MHz unter FP64 sowie aber gleich 2734 MHz unter FP32. Auflösbar wäre dies eventuell über eine ALU-Verdopplung unter FP32 und dann wiederum ein höheres DP/SP-Verhältnis von 1:4.

Allerdings passen so oder so die genannten Rechenleistungen nicht gänzlich zusammen, denn jene sollten normalerweise untereinander glatte Vielfache ergeben – weichen davon jedoch bemerkbar ab. In dieser Form können diese Rohleistungs-Angaben also entweder nicht stimmen – oder es fehlt noch eine sehr entscheidende Information über die ziemliche Hardware-Besonderheit von "Arcturus". Jener lange in Entwicklung befindliche HPC-Chip wird wie bekannt teilweise ohne für eine Grafikausgabe zwingend benötigte Hardware-Elemente aufgelegt, womit jener Chip dann auch tatsächlich nur noch im HPC- und GPGPU-Einsatz benutzt werden kann – im Gegensatz zu nVidias GA100-Chip, welchem bis auf die RT-Kerne eigentlich nichts fehlt, um nicht auch als 3D-Grafikkarte verwendet zu werden (absehen vom zu hohen Kostenpunkt). Mittels den Navi-Chips auf der einen Seite und Arcturus auf der anderen Seite trennt AMD diese Entwicklung sehr gründlich auf, resultierend auch in zwei GPU-Architekturen (RDNA und CDNA) bzw. jeweils eigenständigen Roadmaps.