Hauptlinks

Suchen

News des 11. Juli 2022

VideoCardz zeigen einen ersten 3DMark-Wert zur Arc A770M, welche dort im FireStrike-Extreme-Test immerhin ziemlich exakt das Performance-Niveau einer GeForce RTX 3070 Laptop erzielte. Allerdings ist nicht klar, ob jener Benchmark-Wert mittels "APO" erzielt wurde – einer Treiber-Optimierung, welche von 3DMark als "illegitim" eingeordnet wird. Daneben ist auch unklar, wie groß der APO-Unterschied beim FireStrike Extreme ist, bei TimeSpy sind es +18% Mehrperformance, bei Port Royal allerdings nur +4%. Der wichtigste Punkt liegt aber sowieso darin, dass das Performance-Niveau der Arc-Grafikkarten starke Unterschiede in den drei Disziplinen FireStrike, TimeSpy und reale Spiele aufweist, wie anhand bekannter Performance-Werte zur Arc A380 (APO-Effekt schon rausgerechnet) zu sehen:

| 6400 vs A380 | 3070L vs A770M | |

|---|---|---|

| 3DMark13 FireStrike | A380 vs. 5-10% langsamer | grob gleich |

| 3DMark13 TimeSpy | A380 ca. 20% schneller | vermutlich A770M beachtbar schneller |

| reale Spiele | A380 ca. 10-20% langsamer | vermutlich A770M etwas langsamer |

| grobe Abschätzung basierend auf den (wenigen) bekannten Benchmarks | ||

Davon ausgehend kann man grob schätzen, dass auch die Arc A770M – trotz des gutklassigen FireStrike-Ergebnisses – unter realen Spielen doch etwas unterhalb der GeForce RTX 3070 Laptop herauskommen sollte. Als Clou oben drauf kommt noch der Punkt, dass die GeForce RTX 3070 Laptop im Desktop eher einer GeForce RTX 3060 Ti entspricht. Von der Desktop-Paarung Arc A770 gegen GeForce RTX 3060 Ti wäre also letztlich ein ähnliches Performance-Ergebnis wie von Arc A770M gegen GeForce RTX 3070 Laptop im Mobile-Bereich zu erwarten. Aber natürlich wird dies dann zu viel Abschätzung mit immer größer werdenden Quotienten auf mögliche Fehlschätzungen – sprich, dies alles müsste mal solide ausgetestet werden. Die Chance, dass Intel mit seinem Arc-Spitzenmodell im Desktop die GeForce RTX 3070 erreicht, ist mit dieser Ausgangslage jedoch nicht vorhanden, diesbezüglich sollte man sich nicht von diesen FireStrike-Benchmarks verwirren lassen.

Sicherlich eine große Frage anhand dieser wenigen, aber teilweise eindeutigen Benchmark-Ergebnisse ist, wieso die Intel-Performance gerade unter dem 3DMark so viel deutlich besser ausfällt als unter realen Spielen. Bei der Arc A380 kann man hierbei auf ein Delta von ca. +40% hochrechnen, wie diese Intel-Karte unter dem TimeSpy (ohne APO) besser läuft als unter realen Spielen. Dies ist schon wirklich drastisch und dürfte nicht nur an schlecht auf Spiele optimierten Intel-Treibern liegen, sondern eventuell auch einem massiv nur auf den 3DMark optimierten Treiber. Dies passt durchaus zu Intels bisherigen integrierten Grafik-Lösungen, welche meist nur mittels 3DMark-Werten verglichen wurden und wo nur extrem selten die Spiele-Performance ernsthaft nachgeprüft wurde. Augenscheinlich wurde damit der Schwerpunkt der Treiber-Arbeit bei Intel in den letzten Jahren auf ein Feld gesetzt, welches für die aktuellen Produkte weitgehend nutzlos ist.

Trotzdem verwundert der riesige Unterschied, weil Intel schließlich über seine integrierten Grafik-Lösungen schon viele Jahre hinweg Grafik-Treiber entwickelt. Als These sein hiermit in den Raum gestellt, dass Intel aktuell wohl seine Schwierigkeiten mit dem Speicher-Subsystem haben dürfte. Denn dies ist der einzige Punkt, welcher mit den aktuellen dGPUs von Intel wirklich abweichend von den bisherigen iGPUs liegt (welche nur das gesharte Speicherinterface der CPU benutzen). Gleichzeitig sind die 3DMark-Tests dafür bekannt, nicht besonders viel Speicherbandbreite und Grafikkartenspeicher zu benötigen. Deswegen könnte Intels Treiber-Team womöglich wenig Erfahrung genau in diesen Dingen aufgebaut haben, was sich nun rächt, wo man dickere dGPUs mit entsprechend größeren Speicherinterfaces hat. Das ganze ist natürlich nur eine These, eventuell gibt es hierzu irgendwann mal eine Aufklärung.

Laut VideoCardz erleben die Grafikkarten-Preise in China einen heftigen Einbruch, jene liegen derzeit im Rahmen von 15-30% unter dem chinesischen Listenpreis. Die Preis-Entwicklung in China dürfte sicherlich viel stärker als in westlichen Breiten über die Flutung des Gebrauchtmarktes mit ehemaligen Cryptomining-Beschleuniger vorangetrieben werden. Gleichfalls gilt allerdings auch einzuschränken, dass die Preise allein gegenüber den chinesischen Listenpreisen gut aussehen. Jene sind allerdings üblicherweise 15-20% höher als die US-Listenpreise – womit sich der Effekt nahezu ausgleicht, derzeit in China also auch "nur" das Preisniveau der US-Listenpreise erreicht ist. Für China ist dies dennoch bemerkenswert, denn jener übliche Preis-Offset von 15-20% dürfte regulatorische (staatliche) Hintergründe haben, geht also kaum in die Taschen von Hersteller & Händler.

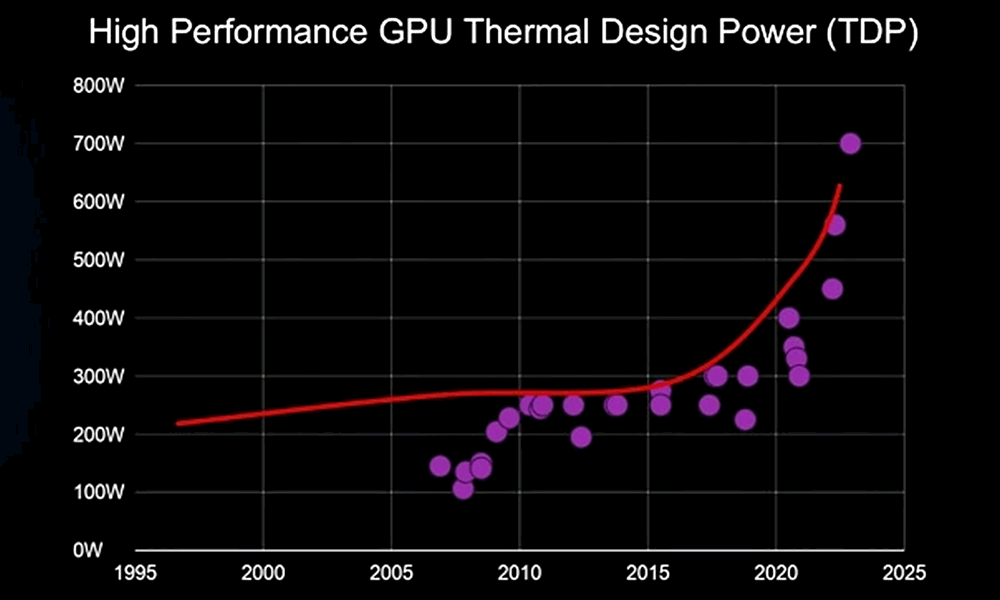

Bei TweakTown hat man eine interessante AMD-Folie ausgegraben, welche die Entwicklung der TDP-Höchstwerte von Spitzen-Grafikkarten sowohl beschreibt als auch für die nächsten Jahre prognostiziert. Was hierbei genau abgebildet wird, ist allerdings etwas unklar – sprich, ob auch nVidia-Grafikkarten sowie eventuell auch HPC-Lösungen einbezogen werden. In jedem Fall prognostiziert auch AMD einen klar und sogar heftig ansteigenden Stromverbrauch der nächsten Spitzen-Grafikkarten. Sofern die zeitliche Einordnung in der Grafik halbwegs korrekt ist, sollte dies sogar schon für die kommende Grafikkarten-Generation zutreffen, denn der höchste eingezeichnete Datenpunkt liegt bei 700W ungefähr im Jahr 2023.

Dies ist dann eine deutliche Änderung gegenüber der letzten Dekade, welche eine eher maßvolle Steigerungen in dieser Frage sah, gerade einmal von 250 auf 300 Watt über eine Zeitspanne von 10 Jahren. Normalerweise geht eine Entwicklung eher konstant vor sich, aber hier zeigen sich zwei deutlich voneinander abweichende Entwicklungs-Geschwindigkeiten: Einmal vor 2020 – und einmal nach 2020. Aller Vermutung nach ergibt sich hier nach 2020 allerdings auch nur ein vergleichsweise kurzer Entwicklungsschub – denn wirklich langfristig wird sich diese steil nach oben gehende Watt-Kurve nicht halten lassen. Jene könnte in ihrer finalen Ausprägung auch zu regelrechten Markt- und Segment-Veränderungen führen, denn Grafikkarten oberhalb 400 Watt sind dann nur noch etwas für eine kleine Minderheit.