Hauptlinks

Suchen

News des 9. September 2025

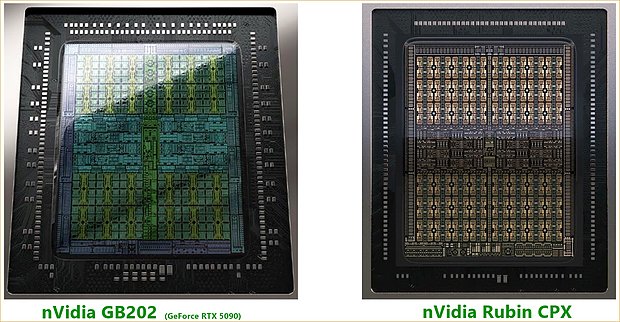

nVidia hat etwas überraschend (angesichts des Auslieferungstermins erst Ende nächsten Jahres) "Rubin CPX" vorgestellt, einen extra Inference-Beschleuniger im "Rubin"-Universum, welcher zusätzlich zur eigentlichen Rubin-GPU operiert. Hiermit werden die Aufgaben stärker aufgeteilt bzw. behalten die Chips ihre eigentlichen Stärken: "Rubin" als Machine-Learning-Chip, "Rubin CPX" als reiner Inferencing-Chip. In letzterer Frage sollen die Instinct-Chips von AMD ihre Stärke haben, nVidia geht dies somit mit einem expliziten Konkurrenz-Produkt an. Interessant ist "Rubin CPX" aber vor allem deswegen, weil das ganze laut dem von WCCF-Tech-Mitarbeiter Hassan Mujtaba @ X gezeigten Die-Shot eigentlich wie ein gewöhnlicher Grafikchip aussieht – und dann eben noch mit GDDR7-Speicher anstatt der für HPC/AI-Chips inzwischen normalen HBM-Speicher arbeitet. So sind die Chip-Elemente auch im Detail symetrischer gegenüber dem HPC/AI-Chip "GB100" angeordnet, zugleich ist die Chipmitte mit GPCs und anderen Verwaltungseinheiten deutlich dicker ausgelegt – wie bei nVidias Consumer-Chip GB202.

Hieraus könnte man die (wilde) Hypothese spinnen, bei "Rubin CPX" könnte es sich eventuell um einen DualUse-Chip handeln, welcher also auch ins Consumer-Segment entlassen werden könnte. Die technischen Daten (gerade das GDDR7-Speicherinterface) passen hierzu, maßgeblich dagegen spricht, dass nVidia es sich im HPC/AI-Segment locker leisten kann, selbst für nebensächliche Aufgaben extra Chips aufzulegen – man braucht dort keine Zweitverwendung von Consumer-Chips, das HPC/AI-Segment macht überaus genügend Kohle, um lieber alles explizit auf die konkrete Aufgabenstellung zuzuschneiden. Im übrigen zeigt "Rubin CPX" dieselben 48 gleichartigen Recheneinheiten-Blöcke wie GB202, könnte somit dieselben Anzahl an Shader-Clustern (192) tragen. Auch das Speicherinterface ist mit augenscheinlich 8x 64 Bit (= 512 Bit) gleich groß, die hohe Speichermenge von 128 GB GDDR7 wird somit augenscheinlich über 4-GByte-Speicherchips (im Clamshell-Verfahren) erreicht. Jene sind derzeit noch nicht in Produktion, aber dies wird sich bis Ende 2026 somit noch ändern – und dies ist dann ein Punkt, welcher auf jeden Fall eines Tages im Consumer-Segment wirksam werden wird.

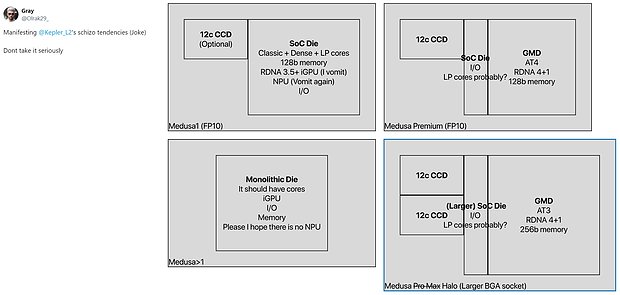

Twitterer Gray zeigt auf Basis der Ausführungen von 'Kepler_L2' mögliche Chiplet-Gestaltungen von AMDs Medusa-APUs. Die Betonung liegt hier in der Tat auf "möglich", denn bislang ist dies alles noch stark im Nebel der Gerüchteküche unterwegs. Interessant hieran ist vor allem, dass die Tendenz in dieselbe Richtung zu gehen scheint wie im GPU-Feld, wo kürzlich an dieser Stelle mögliche Chiplet-Kombinationen aufgezeigt wurden: Chiplets weniger in Richtung einer besseren Skalierbarkeit (mit der Ausnahme der Prozessoren-CCDs), sondern um die verschiedenen Aufgaben auf verschiedene Chiplets aufzuteilen. Zwar ergibt sich auch damit hier und da eine Zweitverwendungsmöglichkeit (ein Chiplet für verschiedene Produkte), der hauptsächliche Sinn dieser Maßnahme dürfte aber eher darin liegen, die Chipflächen der einzelnen Chiplets halbwegs klein zu halten. Denkbarerweise offenbart sich damit der Antriebspunkt hinter speziell diesem Chiplet-Aufbau: Die Mitnahme einer besseren Fertigungsausbeute, welche kleinere Chips nun einmal haben – forciert durch die hohen Fertigungskosten bei den neuen Halbleiter-Nodes. Grundsätzlich gestützt werden diese Chiplet-Ansätze zudem durch Hinweise eines AMD-Mitarbeiters, welche Tom's Hardware ausgegraben haben.

Shortcuts: Heise berichten über einen erfolgreichen Phising-Angriff auf einen Maintainer von wichtigen NPM-Pakete des JavaScript-Ökosystems. In Folge dessen wurden in dessen betreuten NPM-Paketen Malwarecode eingebettet, welcher versucht, Krypto-Transaktionen umzuleiten. Jene NPM-Pakete erreichen zusammen Milliarden Downloads pro Woche, sind ergo weit verbreitet. Leider hat keiner der hierzu gelesenen Berichte genauer ausgeführt, wie daraus dann exakt die Bedrohung für den Normalnutzer entsteht – oder ob am Ende nur die Systeme von Software-Entwicklern selber in Gefahr sind. Nochmals Heise schreiben über den weiteren Umbau von Intel, bei welchem u.a. die Leiterin der Produktsparte Michelle Johnston Holthaus das Unternehmen verläßt. Interessanter ist aber vielleicht sogar der Punkt, dass Intel ein eigenes SemiCustom-Team im Rahmen der neuen Central Engineering Group (CEG) aufstellen wird – womit Intel dann auch einen Chipentwicklungs-Service für andere Unternehmen anbieten kann. Jene Sparte soll sich allerdings nicht nur um SemiCustom kümmern, sondern für Intel auch "spartenübergreifende Hardware-Funktionen" entwickeln.

Passend hierzu notiert Twitterer Sravan Kundojjala Intel-eigene Aussagen, wonach "14A" eigentlich der erste Intel-Node sein soll, welcher tatsächlich von Anfang an für die Nutzung anderer Chipentwickler konzipiert wurde. Vorher hatte Intel somit 20A und 18A zwar für andere Chipentwickler freigegeben, die Nodes waren aber eher nur auf Intel-Chips angepasst – was den bisherigen Mißerfolg der Intel-Foundry bei der Aquirierung von Auftragsarbeiten erklärt. Und letztlich berichten Golem nochmals zum Fall der durch ein Windows-Update angeblich in Gefahr befindlichen SSDs: Denn inzwischen konnte nunmehr Controller-Hersteller Phison den Bug tatsächlich reproduzieren, wenngleich jener wirklich nur auf SSDs mit (nicht auf Retail-Ware vorhandener) Vorab-Firmware passiert. Zugleich kommt von Microsoft die Kunde, dass dies eventuell auch mit den Eigenheiten japanischer PC-Systeme zusammenhängt. So oder so scheint es damit in diese Richtung zu gehen, dass der normale westliche Nutzer davon grundsätzlich verschont sein sollte – was auch erklärt, wieso dieser Bug generell selten und dann aber eher nur bei japanischen PCs aufgetreten ist.