Hauptlinks

Suchen

nVidia will mit "G-Sync" alle Vsync-Probleme lösen

Auf seinem Montreal-Event hat nVidia die "G-Sync" Technologie vorgestellt, mittels welcher nVidia sich aller Vsync-Problematiken in grundsätzlicher Art und Weise annehmen will. Wie bekannt, verhindert Vsync Tearing-Effekte, dafür kann man sich allerdings (bei üblichen 60-Hz-Monitoren) Framedrops einhandeln, unter TripleBuffering dann eine erhöhte Latenz. Nachdem Software-Lösung wie nVidias Adaptive Vsync nicht richtig zünden wollten, sind in letzter Zeit viele Gamer zur Minderung dieser Problematik auf Monitore mit hohen Bildwiederholraten von 120 bis 144 Hz umgestiegen – die eigentliche Lösung wären allerdings schlicht Monitore mit einer dynamischen Bildwiederholrate. Mittels jener kann der Monitor auf von der Grafikkarten fertiggestellte Frames warten und muß nicht mehr nach einem starren Schema neue Bilder pro Vsync-Zyklus anzeigen. Alle die üblichen Vsync-Probleme lassen sich auf diese Weise elegant umgehen.

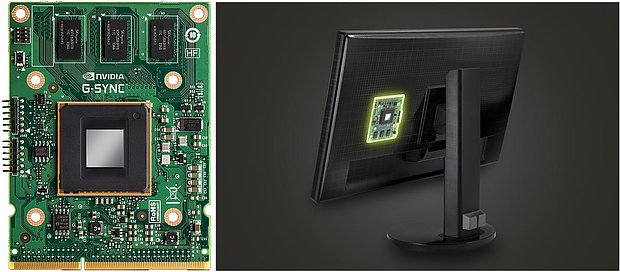

Ironischerweise wurde selbige erst vor einer Woche bei uns im Forum diskutiert – und schon seinerzeit konnte man die technische Lösung für diese Problematik erahnen: Möglich ist dies nur mittels einer extra Elektronik unter Verwendung des Displayport-Protokolls, weil nur jenes solcherart dynamische Veränderungen der Monitor-Refreshrate unterstützt. Und genau selbiges hat nVidia nun vorgestellt: Eine extra Platine, welche im Monitor verbaut wird und dort die dynamische Ansteuerung der Monitor-Bildwiederholrate in Zusammenarbeit mit einer nVidia-Grafikkarte erledigt. Bedingung hierfür ist die Monitor-Befeuerung über Displayport, wobei man hierbei allerdings ein etwaiges Audio-Signal verlieren würde.

Weitere Einschränkungen ist der Betrieb nur unter Windows 7 aufwärts und mit einer nVidia-Grafikkarte der Kepler-Serie ab der GeForce GTX 650 Ti "Boost" aufwärts. Und natürlich benötigt man einen passenden G-Sync-fähigen Monitor, welcher überhaupt auf diesen Umbau vorbereitet ist – derzeit ist dies nur der Asus VG248QE. Weitere G-Sync-fähige Monitore von Asus, BenQ, Philips und ViewSonic sollen im ersten Quartal 2014 folgen, wobei noch nicht klar ist, ob jene bereits voll ausgerüstet erscheinen oder aber nur einen Einbauplatz für die G-Sync-Platine von nVidia bieten werden. Selbige will nVidia schon zum Jahresende als DIY-Kit ausliefern, preislich soll der Kit für unter 100 Dollar antreten.

Das ganze hört sich aus Nichtgamer-Perspektive vielleicht nur nach irgendeinem weiteren Feature an, aus Gamer-Pespektive ist es jedoch nahezu der "Heilige Gral" der Vsync-Problematik. Wenn es so funktioniert, wie von nVidia beschrieben und auch von einigen Live-Beobachtern von nVidias Präsentation eingeschätzt (AnandTech), erschlägt nVidia das Vsync-Thema ein für alle mal und liefert eine Technologie, die in ein paar Jahren absoluter Standard bei Gamern sein dürfte. Einziger Haken ist, daß das ganze natürlich proprietär zugunsten von nVidia ist – im Sinne des Wettbewerbs immer schlecht, da wir schließlich nur noch zwei Entwickler von Grafikchips haben. Eventuell kann AMD ja ähnliches entwickeln – besser wäre aber natürlich ein freier Standard, welchen die Monitor-Hersteller dann befolgen können.

Nachtrag vom 27. Oktober 2013

Die ComputerBase bringt erste Eindrücke zu nVidias G-Sync Technologie – welche sich in der Praxis wohl ziemlich gut anfühlt: Man konnte im eigenen Test mit Tomb Raider und Metro: Last Light keinerlei Tearing oder Bildstottern durch schwankende Frameraten mehr vernehmen. nVidias Vsync scheint exakt das zu liefern, was nVidia verspricht – nämlich hohe Bildruhe ohne Tearing und ohne Inputlag. Allerdings ist der gefühlte Vorteil gegenüber Vsync-on im realen Spieleeinsatz wohl bei weitem nicht so groß wie bei nVidias Techdemos – es kommt damit also darauf an, wie stark man subjektiv auf die üblichen Vsync-Probleme reagiert. Als Bremsklotz gilt zudem der 100 Dollar Mehrpreis für die G-Sync-Platine, welche sich anfänglich sicher nur ein Teil der Gamer leisten werden.

Verwandte News

- Die Grafikchip- und Grafikkarten-Marktanteile im zweiten Quartal 2024

- Gerüchteküche: Erste Spezifikationen zu GeForce RTX 5080 & 5090

- Grafikkarten-Verkaufsstatistik Mindfactory Q2/2024

- Gerüchteküche: GeForce RTX 5080 soll 400W TDP und GeForce RTX 5090 gar 600W TDP erhalten

- nVidia kündigt "GeForce RTX 4070 GDDR6" mit langsamerem Speicher, angeblich gleicher Performance und gleichem Preis an

- Neuer Artikel: Die Systemanforderungen für die Spiele-Generation 2023/24

- Gerüchteküche: Performance-Angaben zur GeForce RTX 50 Serie - inklusive einer "Titan AI"

- Gerüchteküche: Die Hardware-Daten der Consumer-Chips von nVidias "Blackwell"

- Clevo-Roadmap bestätigt die (unveränderte) Speicherinterface-Breite der kleineren Blackwell-Chips

- Micron gibt einen Ausblick auf die mögliche Performance der GeForce RTX 5090