Launch-Analyse nVidia GeForce GTX 1080

Immerhin gut viereinhalb Jahre nach dem Launch der ersten 28nm-Beschleuniger (AMDs Radeon HD 7970 im Dezember 2011 [2]) kommt mit der GeForce GTX 1080 eine erste Grafikkarte basierend auf einer moderneren Fertigungstechnologie in den Markt. Dies ist ein selbst in Zeiten geringer werdender Fortschritte in der Chipfertigung vergleichsweise langer Zeitraum – welcher verbunden war mit einer langen Zeit des Wartens auf die 14/16nm-Generation, nun aber Hoffnung darauf macht, das sich diese lange Wartezeit jetzt in Form kräftiger Performanceschübe bezahlt macht. Ob die GeForce GTX 1080 diesen hohen Erwartungen gerecht werden kann, werden wir nachfolgend im Rahmen dieser Launch-Analyse herauszuarbeiten versuchen, welche wie immer als primären Punkt eine Zusammenfassung bzw. Zusammenrechnung möglichst vieler der Benchmark-Ergebnisse der Launchreviews bieten wird.

Der der GeForce GTX 1080 zugrundeliegende GP104-Chip ist wie bekannt nur nVidias zweithöchste Lösung im Pascal-Portfolio, im Enthusiasten-Segment werden hier später noch GP100- oder GP102-basierte Grafikkarten unter wahrscheinlich dem Titan-Brand antreten. Als zweithöchster Chip besteht zwar im Rahmen einer neuen Chipgeneration trotzdem die Zielsetzung, den allerbesten Chip der zuvorgehenden Chipgeneration (GM200-Chip von GeForce GTX 980 Ti & Titan X) zu schlagen – primär wird damit aber natürlich der zweitbeste Chip der zuvorgehenden Chipgeneration ersetzt, sprich der GM204-Chip von GeForce GTX 970 & 980. Jener trat wie bekannt mit 2048 Shader-Einheiten an einem 256 Bit GDDR5-Speicherinterface an, der GP104-Chip bringt stattdessen 2560 Shader-Einheiten an einem 256 Bit GDDR5X-Speicherinterface daher. Nominell ist dies – gerade für ein neues Fertigungsverfahren – ein sehr kleiner Hardware-Sprung, welcher dann aber gut ausgeglichen wird durch die in der Pascal-Generation deutlich steigenden Chiptaktraten.

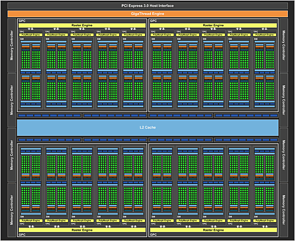

[5] [5]nVidia GP104 Blockdiagramm [6] |

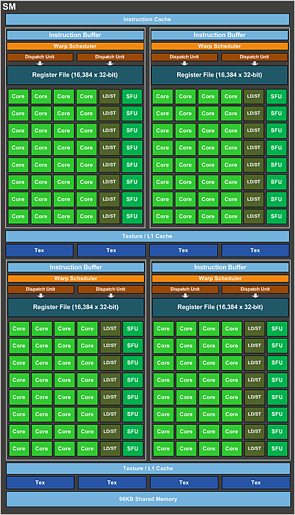

[7] [7]nVidia GP104 Shader-Cluster [8] |

Chip-intern hat sich hingegen kaum etwas getan, ganz grob kann man daher die GP104-Architektur als "Maxwell in 16nm" betrachten. In dieser Frage ist der GP104-Chip allerdings auch klar abweichend vom womöglich nur für HPC-Aufgaben eingesetzten GP100-Chip [9], welche einen deutlichen Umbau der Shader-Cluster mit sich bringt – welchen nVidia für den GP104-Chip wieder zurückgenommen hat. Die Zielsetzung beim GP100-Chip war aber wegen der HPC-Ausrichtung auch eine völlig andere, für die Gaming-Ausrichtung des GP104-Chips erscheint nVidia die Zusammenstellung der Shader-Cluster gemäß des Maxwell-Vorbilds wohl auch weiterhin als passend anzusehen.

| Kepler | Maxwell 2 | Pascal – GP104 | Pascal – GP100 | |

|---|---|---|---|---|

| DirectX 12 Feature-Level | 11_0 | 12_1 | 12_1 | 12_1 |

| Durchsatz pro Raster-Engine | 8 Pixel/Takt 1 Triangle/Takt |

16 Pixel/Takt 1 Triangle/Takt |

16 Pixel/Takt 1 Triangle/Takt |

16 Pixel/Takt 1 Triangle/Takt |

| Aufbau der Shader-Cluster | 192 Shader-Einheiten, 16 Textureneinheiten, 32 Load/Store-Einheiten, 32 SFUs, 8 FP64-Einheiten, 1x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), 64 kByte Level1-Cache, 48 kByte Texturen-Cache (GK110: 64 anstatt 8 FP64-Einheiten) |

128 Shader-Einheiten, 8 Textureneinheiten, 32 Load/Store-Einheiten, 32 SFUs, 4 FP64-Einheiten, 4x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), 96 kByte Level1-Cache, 48 kByte Texturen-Cache | 128 Shader-Einheiten, 8 Textureneinheiten, 32 Load/Store-Einheiten, 32 SFUs, 4 FP64-Einheiten, 4x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), 96 kByte Level1-Cache, 48 kByte Texturen-Cache | 64 Shader-Einheiten, 4 Textureneinheiten, 16 Load/Store-Einheiten, 16 SFUs, 32 FP64-Einheiten, 4x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), ? kByte Level1-Cache, ? kByte Texturen-Cache |

| TMU/SE-Verhältnis | 1:12 | 1:16 | 1:16 | 1:16 |

| DP/SP-Verhältnis | 1/24 (GK110: 1/3) | 1/32 | 1/32 | 1/2 |

| SP/HP-Verhältnis | - | - | - | 1/2 |

| wichtige Fortschritte | - | doppelter Pixel-Durchsatz der Raster-Engines, kleinere Shader-Cluster, deutlich mehr Kontrolllogik pro Shader-Einheit, größere Caches pro Shader-Einheit | faktisch keine | grundsätzlich halbierte Shader-Cluster, deutlich mehr Kontrolllogik und deutlich größere Caches pro Shader-Einheit, massiv mehr FP64-Einheiten, HalfPrecision-Modus |

Daneben hat nVidia dann natürlich dennoch einige kleinere und mittlere Verbesserungen mit dem GP104-Chip zu bieten – welche sich in dieser oder besserer Form dann auch in den nachfolgenden weiteren Pascal-Chips und den darauf basierenden GeForce 1000 Grafikkarten wiederfinden werden. Bis vielleicht auf den (anständigen) Support von "Asynchronous Compute" fehlen hierbei sicherlich die großen Innovationen – allerdings waren die vorhergehenden Maxwell-Grafikkarten durchaus schon sehr runde Pakete, bleibt da nicht mehr viel Platz für große Sprünge, sondern sind vielmehr kleinere Verbesserungen der normale Lauf der Welt. Pascal ist für nVidia sowieso eine zwischengeschobene Architektur-Stufe, die nur deswegen aus der Taufe gehoben wurde, weil die 14/16nm-Fertigung für die zuvorgehende Maxwell-Generation noch nicht zur Verfügung stand (bzw. die 20nm-Fertigung komplett ausgelassen wurde). Die nächste "echte" neue nVidia-Architektur wird der Pascal-Nachfolger "Volta" [10] sein, von diesem sind dann eventuell größere Innovationen zu erwarten.

|

Launch-Analyse nVidia GeForce GTX 1080 (Seite 2)

Die GeForce GTX 1080 als erste Grafikkarte basierend auf dem GP104-Chip benutzt dann den Vollausbau dieses Grafikchips und tritt für den Augenblick nur in dem zu "Founders Edition" umbenannten Referenzdesign an. Jenes wird am 27. Mai 2016 für einen Listenpreis von 699 Dollar (USA) bzw. 789 Euro (Deutschland) in den Handel gehen. Mit dem neuen Referenzdesign will nVidia eine vergleichsweise hochwertige Grafikkarte schaffen, welche auch über den kompletten Lebenszyklus des GP104-Grafikchips im Angebot bleiben soll – für daran interessierte Abnehmer bedeutet dies also eine hohe Liefersicherheit des vollkommen identischen Produkts. Die Founders Edition wird dabei nicht nur von den einzelnen Grafikkarten-Herstellern angeboten werden, sondern ist auch direkt von nVidia (über nVidia.com [18]) beziehbar, selbst für deutsche Grafikkarten-Käufer.

Für zwei Wochen nach dem Verkaufsstart der Founders Edition verspricht nVidia das Auftauchen erster Herstellerdesigns, welche nVidia für einen US-Preis von ab 599 Dollar im Handel erwartet. Ob dieser Preispunkt erreicht werden kann bzw. wie schnell dies passiert, ist noch einen der großen offenen Fragen zur GeForce GTX 1080. Zum einen gilt hierbei, das es sicherlich nicht so einfach ist, an einer Grafikkarte umgehend Sparpotentiale von 100 Dollar/Euro zu entdecken – zum anderen könnten die Grafikkarten-Hersteller jene Einsparpotentiale auch eher gemächlich im ständigen Wettbewerb heruntertreiben, nicht aber gleich am ersten Tag mit um 100 Dollar/Euro günstigeren Karten antreten. An dieser Stelle liegt sicherlich einer der Problempunkte der GeForce GTX 1080: Niemand kann derzeit sagen, ob die nVidia-Versprechung von 599 Dollar für die Herstellerdesigns wirklich (zeitnah zum Launch) eingehalten werden kann.

| Radeon R9 Fury X | GeForce GTX 980 Ti | GeForce GTX Titan X | GeForce GTX 1080 | |

|---|---|---|---|---|

| Chipbasis | AMD Fiji, 8,9 Mrd. Transist. in 28nm auf 596mm² Chipfläche | nVidia GM200, 8 Mrd. Transist. in 28nm auf 601mm² Chipfläche | nVidia GP104, 7,2 Mrd. Transist. in 16nm auf 314mm² Chipfläche | |

| Architektur | GCN 1.2, DirectX 12 Feature-Level 12_0 | Maxwell 2, DirectX 12 Feature-Level 12_1 | Pascal, DirectX 12 Feature-Level 12_1 | |

| Features | Mantle, Vulkan, Asynchonous Compute, VSR, CrossFire, FreeSync, TrueAudio | Vulkan, DSR, SLI, G-Sync, PhysX | Vulkan, Asynchonous Compute, DSR, SLI, G-Sync, PhysX | |

| Technik | 4 Raster-Engines, 4096 Shader-Einheiten, 256 TMUs, 64 ROPs, 4096 Bit DDR HBM1-Interface, 2 MB Level2-Cache | 6 Raster-Engines, 2816 Shader-Einheiten, 176 TMUs, 96 ROPs, 384 Bit GDDR5-Interface, 3 MB Level2-Cache | 6 Raster-Engines, 3072 Shader-Einheiten, 192 TMUs, 96 ROPs, 384 Bit GDDR5-Interface, 3 MB Level2-Cache | 4 Raster-Engines, 2560 Shader-Einheiten, 160 TMUs, 64 ROPs, 256 Bit GDDR5X-Interface, 2 MB Level2-Cache |

| Taktraten | ≤1050/500 MHz (Ø-Chiptakt: 1050 MHz) |

1000/1075/3500 MHz (Ø-Chiptakt: 1114 MHz) |

1000/1075/3500 MHz (Ø-Chiptakt: 1067 MHz) |

1607/1733/2500 MHz (Ø-Chiptakt: 1694 MHz) |

| Speicherausbau | 4 GB HBM1 | 6 GB GDDR5 | 12 GB GDDR5 | 8 GB GDDR5X |

| Layout | DualSlot, AiO-Wakü | DualSlot | DualSlot | DualSlot |

| Kartenlänge | 19,7cm | 27,0cm | 27,0cm | 27,0cm |

| Ref./Herst./OC | ✓/✗/✗ | ✓/✓/✓ | ✓/✓/✓ | ✓/✓/✓ |

| Stromstecker | 2x 8pol. | 1x 6pol. + 1x 8pol. | 1x 6pol. + 1x 8pol. | 1x 8pol. |

| TDP | 275W (TBP) | 250W (GCP) | 250W (GCP) | 180W (GCP) |

| Idle-Verbrauch [19] | 21W | 13W | 13W | 7W |

| Spiele-Verbrauch [19] | 289W | 236W | 240W | 171W |

| Ausgänge | HDMI 1.4a (kein HDCP 2.2), 3x DisplayPort 1.2 | DualLink DVI-I, HDMI 2.0 (kein HDCP 2.2), 3x DisplayPort 1.2 | DualLink DVI-I, HDMI 2.0 (kein HDCP 2.2), 3x DisplayPort 1.2 | DualLink DVI-D, HDMI 2.0b, 3x DisplayPort 1.2 (DP1.4-ready) |

| FullHD Perf.Index [20] | 670% | 730% | 760% | 960% |

| 4K Perf.Index [21] | 100% | 100% | 104% | 132% |

| Listenpreis | 649$ | 649$ | 999$ | 699$ (Herstellerdesigns ab 599$) |

| Straßenpreis | 580-620€ | 600-640€ | 1000-1100€ | Verkaufsstart 27. Mai |

| Release | 24. Juni 2015 [22] | 31. Mai 2015 [23] | 17. März 2015 [24] | 17. Mai 2016 |

Bei den heutigen nVidia-Karten ist aufgrund des mehr oder weniger freischaffend wirkenden Chipboosts natürlich der real anliegende Chiptakt eine wichtigere Größe als die nominellen Taktraten. In dieser Frage wurden zur GeForce GTX 1080 vorab ziemliche Wunderdinge versprochen – die Realität sieht dann leicht anders aus: Trotz eines von nVidia so angegebenen durchschnittlichen Boost-Takts von 1733 MHz kommt die Karte im Test der ComputerBase [25] nur auf einen durchschnittlichen Chiptakt von 1667 MHz (gemessen nach 20 Minuten Gameplay), hält den offiziellen Boost-Takt also deutlich nicht ein. Bei der PC Games Hardware [26] sind es dagegen im Schnitt 1722 MHz Chiptakt (gemessen nach 10 Minuten Gameplay), hier liegt die Karte viel näher an ihrem offiziellen Boost-Takt. Dabei läuft die GeForce GTX 1080 (in der aktuellen Founders Edition) nicht einmal in ihr Power-Limit, sondern erstaunlicherweise fast ausschließlich in ihr Temperatur-Limit – ein bei nVidia-Grafikkarten in der letzten Zeit eher selten gesehenes Verhalten. Hier bietet sich für die kommenden Herstellerdesigns also noch einiger Verbesserungsspielraum, welcher dann auch der Overclocking-Eignung zugute kommen sollte.

| GeForce GTX 980 Ti | GeForce GTX Titan X | GeForce GTX 1080 | |

|---|---|---|---|

| nominelle Taktraten | 1000/1075/3500 MHz | 1000/1075/3500 MHz | 1607/1733/2500 MHz |

| Power-Limit | 250W (+10% möglich) | 250W (+10% möglich) | 180W (+20% möglich) |

| Temperatur-Limit | 83°C (+10% möglich) | 83°C (+10% möglich) | 83°C (+10% möglich) |

| maximaler Boost-Takt | 1240 MHz [27] 1215 MHz [28] |

1202 MHz [27] 1190 MHz [28] |

1886 MHz [29] |

| durchschn. realer Takt | 1114 MHz [30] | 1067 MHz [30] | 1667 MHz [25] 1722 MHz [26] |

| reale Rechenleistung (SE * realer Takt) |

6,27 TFlops | 6,55 TFlops | 8,67 TFlops |

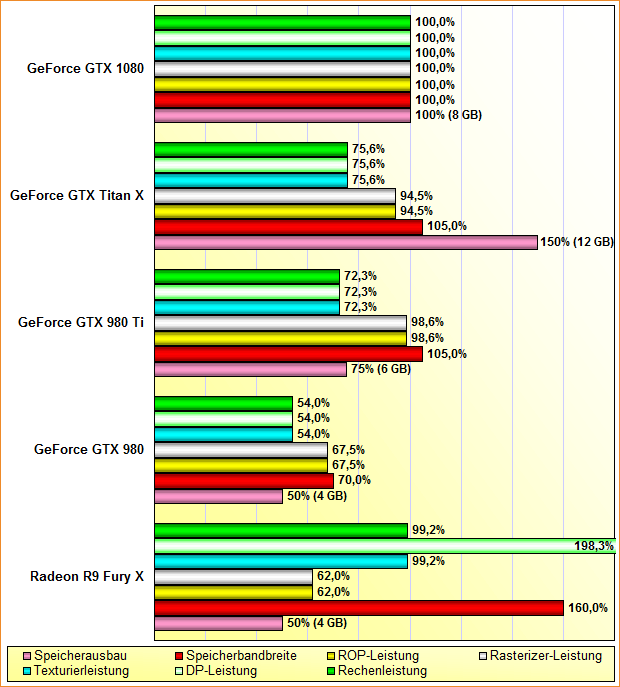

Basierend auf diesen realen Taktraten (von im Schnitt 1694 MHz anliegendem Chiptakt) lassen sich dann auch exakte Rohleistungs-Berechnungen anstellen, in diesem Fall normiert auf die GeForce GTX 1080 auf 100% – womit man besser sehen kann, um wieviel die anderen Grafikkarten jeweils zurückliegen. GeForce GTX 980 Ti & Titan X haben primär einen 28%igen bzw. ~24%igen Rückstand bei der Rechen- und Texturierleistung zu verdauen, bei Rasterizer- und ROP-Leistung sowie der Speicherbandbreite liegen alle drei nVidia-Lösungen dagegen nahezu gleichauf. Damit ist auch schon eine gewisse Schwierigkeit für die GeForce GTX 1080 zu sehen, welche zwar deutlich mehr Rechenleistung anbietet, jedoch ohne mehr Speicherbandbreite daherkommt – und damit in der einen oder anderen Situation durch diesen Punkt ausgebremst werden könnte.

Andererseits dürfte dies seitens nVidia durchaus so geplant sein, denn somit wird die GeForce GTX 1080 unter der speicherbandbreite-fressenden UltraHD-Auflösung nicht ihr komplettes Potential ausspielen können – was dann mehr Platz für die nachfolgenden GP100/GP102-Lösungen bieten wird, sich genau dort bestmöglich zu präsentieren. Die GeForce GTX 1080 ist eben primär der Ersatz für die GeForce GTX 980 gedacht – und bietet gegenüber dieser ~85% mehr Rechen- und Texturierleistung zu ~43% mehr Speicherbandbreite. Hiermit wird auch der anfangs erwähnte geringe Hardware-Unterschied (nur 2048 zu 2560 Shader-Einheiten) wieder egalisiert – die viel höheren Taktraten der GeForce GTX 1080 führen jene trotzdem zu einer nahezu Verdopplung der (theoretischen) Rechenleistung.

Das die GeForce GTX 1080 dann die Karte einer neuen Fertigungsgeneration ist, kann man perfekt an den Stromverbrauchswerten sehen – wobei wir uns wie üblich allein an Quellen bedienen, welche diesbezüglich die reinen Grafikkarten ausmessen. Als Karte mit der höchsten nominellen Rechenleistung im Testfeld (minimal höher sogar als bei der Radeon R9 Fury X, deutlich mehr als bei der GeForce GTX Titan X) reichen der GeForce GTX 1080 dennoch gemittelt nur 171 Watt im Spielebetrieb aus, im Idle-Betrieb gar nur 7 Watt. Dies ist dann am Ende noch nicht mehr einmal mehr als bei der GeForce GTX 980, welche auf einen Stromverbrauch im Idle-Betrieb von 12 Watt und im Spiele-Betrieb von 174 Watt kommt (trotz TDP von eigentlich nur 165 Watt). Hier zeigt sich nebenbei am besten, wo die GeForce GTX 1080 in nVidias Pascal-Portfolio (bei dessen Vollendung) einzuordnen sein wird – als HighEnd-Lösung in direkter Ablösung der GeForce GTX 980, mit sicherlich noch ein oder gar zwei nochmals schnelleren Pascal-Grafikkarten oben drauf.

| HW.fr | Heise | HT4U | PCGH | TPU | Tom's | TweakPC | Ø | Perf./TDP | |

|---|---|---|---|---|---|---|---|---|---|

| GeForce GTX 1080 | 8W 154W [32] |

6W 178W [33] |

9,5W 175W [34] |

7W 166W [35] |

7W 173W [36] |

7W 171W |

960% 180W |

||

| GeForce GTX Titan X [24] | 15W 228W [37] |

11,8W 250,0W [38] |

18W 242W [39] |

11W 223W [40] |

9W 224W [41] |

13W 240W |

760% 250W |

||

| GeForce GTX 980 Ti [23] | 15W 226W [42] |

13W 244W [43] |

12,8W 250,0W [44] |

15W 236W [45] |

11W 211W [46] |

10,4W 233,5W [47] |

10,9W 213W [48] |

13W 236W |

730% 250W |

| GeForce GTX 980 [49] | 12W 155W [50] |

? 173W [51] |

11,2W 180,0W [52] |

11,5W 160W [53] |

8W 156W [54] |

15W 185W [55] |

12W 174W |

600% 165W |

|

| Radeon R9 Fury X [22] | 22,5W 293,5W [56] |

20W 273W [57] |

20,0W 311,0W [58] |

21W 329W [59] |

20W 246W [60] |

22,0W 220,7W [61] |

21W 289W |

670% 275W |

Bezüglich der Geräuschemissionen bekommt die GeForce GTX 1080 gutklassige Noten, gerade für ein Referenzdesign – aber noch keine Bestnoten. Bemängelt wurde insbesondere das Fehlen eines lüfterlosen Idle-Modus, was heutzutage von vielen Herstellerdesigns auch bei großen Grafikchips geboten wird. Generell wird den Herstellerdesigns diesbezüglich noch einiges an Verbesserungspotential zugesprochen – was etwas konträr der nVidia-Aussage läuft, bei der Founders Edition handle es sich um eine besonders hochwertige Referenz-Karte. Zumindest aber den Punkt des Spulenfiepens hat die Founders Edition dann im Griff, im Test der PC Games Hardware [34] wurde selbiges nur bei hohen dreistelligen Frameraten festgestellt. Hierbei werden sich wiederum die Herstellerdesigns strecken müssen – wo es in der Vergangenheit durchaus vorkam, das selbst wirklich hochwertige Herstellerdesigns plötzlich durch Spulenfiepen (negativ) auffielen.

| Idle-Betrieb | Spiele-Betrieb | |

|---|---|---|

| ComputerBase [62] | Der Radiallüfter der GeForce GTX 1080 Founders Edition arbeitet unter Windows 10 mit rund 1.000 Umdrehungen in der Minute, was man auch aus einem geschlossenen Gehäuse beim genauen Hinhören durchaus mitbekommt. Der Geräuschpegel ist zwar verhältnismäßig niedrig, doch erledigen Partnerkarten mit stillstehendem Lüfter diesen Job besser. | In Anno 2205 kommt die GeForce GTX 1080 bei der Lautstärkemessung auf 42,5 Dezibel bei 2.300 Umdrehungen in der Minute. Damit bleibt die Grafikkarte 1,4 Dezibel leiser als das Referenzdesign der GeForce GTX 980 und fünf Dezibel leiser als das der GeForce GTX 980 Ti. Für eine Referenzkarte ein gutes Ergebnis, das nVidias Versprechen, eine bessere Referenzversion abzuliefern, stützt. Wirklich leise ist die Founders Edition damit aber nicht – es bleibt noch viel Verbesserungspotenzial für die Partnerkarten. |

| Hardwareluxx [63] | Den ersten Lichtblick setzte die GeForce GTX 1080 bei der Messung der Idle-Lautstärke. Mit einem Wert von 39,2 dB(A) ist die erste Pascal-Karte sogar leiser als beispielweise eine GeForce GTX 980 und wird eigentlich nur von den Custom-Modellen der GeForce GTX 980 Ti sowie der Radeon R9 Nano geschlagen. | Das zweite Plus sammelt die GeForce GTX 1080 bei der Last-Lautstärke und damit macht nVidia das Versprechen war, dass man beim Kühler noch einmal Verbesserungen vorgenommen hat. 42,6 dB(A) sind ein mehr als ausgezeichneter Wert, wenn man sich die Konkurrenz in unserem Diagramm einmal genauer anschaut. |

| PC Games Hardware [34] | - | Die maximale Lautheit der GTX 1080 in unserem Spieleparcours beträgt 4,2 Sone. Die automatische Lüftersteuerung setzt in diesem Fall 62 Prozent PWM-Impuls, was beinahe 2.500 U/min entspricht. In vielen anderen Fällen beträgt die Drehzahl rund 2.200 (54-56% PWM), resultierend in einer Lautheit von 4,0 Sone. Das ist zwar deutlich hörbar, das tiefe Rauschen des nVidia-Referenzkühlers ist subjektiv jedoch ertragbar. Gegen das (unter Last) leise Betriebsgeräusch der flüssiggekühlten Radeon R9 Fury X kommt das GTX-1080-Kühldesign jedoch nicht an. |

| Tom's Hardware [64] | - | Mit den gemessenen 41,6 dB(A) liegt die DHE-Karte noch recht gut im Rennen, wenn wir dieses Ergebnis mit preiswerteren Custom-Designs der GeForce GTX 980 vergleichen. Außerdem schafft man im direkten Vergleich zur GeForce GTX 980 im Referenz-Design immerhin einen um zwei Dezibel niedrigeren Geräuschpegel. Das entstehende, nach oben hin sehr breitbandige Lüftergeräusch ist angenehm, weil es ein fast reines Rauschen ist und man den Motor des Lüfters nie einzeln heraushören kann. Im Gegensatz zu den brummigen und sehr billigen Axiallüftern der ehemaligen AMD-Referenzkarten und dem, was manche Board-Partner verbauen, ist der Geräuschteppich durchaus erträglich und tolerierbar. |

Launch-Analyse nVidia GeForce GTX 1080 (Seite 3)

Bleibt die Ermittlung der Spiele-Performance zur GeForce GTX 1080 gegen deren preisliche Kontrahenten Radeon R9 Fury X, GeForce GTX 980 Ti und Titan X sowie natürlich im Vergleich zum direkten Vorgänger GeForce GTX 980. Hierbei haben wir wie üblich möglichst viele Benchmark-Werte der Launchreviews zusammengetragen, um durch die Verrechnung möglichst vieler Zahlen einen guten Schnitt des Launch-Ergebnisses zu erhalten – und nicht alle Performance-Aussagen von einem einzigen (fehlbaren) Testbericht abhängig zu machen. Etwas fehlend in der Performancebetrachtung sind allerdings VR-Benchmarks – hier gibt es augenscheinlich noch keine allgemein üblichen Testverfahren für echte VR-Spiele, sondern nur theoretische VR-Tests. Spiele-Benchmarks ohne VR-Einsatz sind für diesen Zweck jedoch kaum übertragbar, da unter VR diverse VR-spezifische Rendering-Optimierungen greifen, welche je nach Grafikchip unterschiedlich stark ausgeprägt sind. Dies muß dann die Zukunft ergeben, für den Augenblick gibt es erst einmal nur die übliche Performance-Zusammenfassung unter den drei üblichen Auflösungen FullHD, WQHD und UltraHD:

| FullHD MSAA/FXAA/SMAA | Fury X | 980 | 980 Ti | Titan X | 1080 |

|---|---|---|---|---|---|

| ComputerBase [66] (21 Tests) | 70,7% | 62,6% | 78,0% | - | 100% |

| PC Games Hardware [34] (10 Tests) | 68,0% | 63,6% | 76,2% | 79,6% | 100% |

| Guru3D [67] (12 Tests) | 65,4% | 61,7% | 77,1% | 80,6% | 100% |

| PCGamer [68] (15 Tests) | 72,6% | 63,9% | 77,7% | 78,1% | 100% |

| TechPowerUp [69] (16 Tests) | 70% | 64% | 76% | 79% | 100% |

| PurePC [70] (8 Tests) | 68,2% | 61,9% | 77,9% | 79,6% | 100% |

| SweClockers [71] (11 Tests) | 69,8% | 63,3% | 78,7% | 81,1% | 100% |

| Hardware.info [72] (9 Tests) | 61,8% | 57,3% | 70,6% | - | 100% |

| WQHD MSAA/FXAA/SMAA | Fury X | 980 | 980 Ti | Titan X | 1080 |

|---|---|---|---|---|---|

| ComputerBase [66] (21 Tests) | 73,3% | 61,4% | 77,9% | - | 100% |

| PC Games Hardware [34] (10 Tests) | 70,6% | 60,8% | 76,1% | 79,1% | 100% |

| Tom's Hardware [73] (7 Tests) | 67,4% | 60,5% | 75,8% | 77,3% | 100% |

| Guru3D [67] (12 Tests) | 66,5% | 59,1% | 76,1% | 79,4% | 100% |

| Hardware Canucks [74] (10 Tests) | 74,9% | 56,4% | 75,6% | - | 100% |

| PC Perspective [75] (7 Tests) | 72,1% | 60,7% | 79,3% | - | 100% |

| PCGamer [68] (15 Tests) | 74,4% | 60,4% | 74,5% | 75,2% | 100% |

| TechPowerUp [69] (16 Tests) | 73% | 60% | 73% | 76% | 100% |

| TechSpot [76] (10 Tests) | 74,8% | 62,5% | 78,4% | 81,7% | 100% |

| PurePC [70] (8 Tests) | 71,4% | 61,5% | 78,1% | 80,0% | 100% |

| SweClockers [71] (11 Tests) | 72,1% | 60,6% | 77,6% | 80,0% | 100% |

| Hardware.info [72] (9 Tests) | 65,1% | 57,2% | 71,5% | - | 100% |

| Hardware.fr [77] (17 Tests) | 72,1% | 59,7% | 77,5% | - | 100% |

| UltraHD MSAA/FXAA/SMAA | Fury X | 980 | 980 Ti | Titan X | 1080 |

|---|---|---|---|---|---|

| ComputerBase [66] (21 Tests) | 79,6% | 61,1% | 76,9% | - | 100% |

| PC Games Hardware [34] (10 Tests) | 71,9% | 58,8% | 75,7% | 79,2% | 100% |

| Tom's Hardware [73] (8 Tests) | 69,8% | 57,3% | 74,3% | 76,2% | 100% |

| Guru3D [67] (12 Tests) | 70,8% | 56,4% | 75,5% | 79,0% | 100% |

| Hardware Canucks [74] (9 Tests) | 77,6% | 56,7% | 74,2% | - | 100% |

| PC Perspective [75] (7 Tests) | 73,8% | 58,3% | 77,3% | - | 100% |

| PCGamer [68] (15 Tests) | 79,1% | 59,9% | 74,8% | 76,0% | 100% |

| TechPowerUp [69] (16 Tests) | 75% | 59% | 73% | 76% | 100% |

| TechSpot [76] (10 Tests) | 77,8% | 62,1% | 79,6% | 83,8% | 100% |

| PurePC [70] (5 Tests) | 76,9% | - | 79,9% | - | 100% |

| SweClockers [71] (11 Tests) | 75,0% | 58,8% | 77,5% | 81,3% | 100% |

| Hardware.info [72] (9 Tests) | 65,6% | 53,9% | 71,4% | - | 100% |

Der erhebliche Vorteil der GeForce GTX 1080 ist schon auf den ersten Blick gut zu erkennen, im Detail beeindruckte vor allem die absolute Ergebniskonstanz: Kein einziger Benchmark (unter den hier ausgewerteten 388 Benchmark-Sets) ging für die Karte verloren, sie liegt in allen Benchmark-Sets unter den SingleChip-Lösungen an der absoluten Spitze. Interessant im übrigen der Verlauf des üblichen Zweikampfs zwischen Radeon R9 Fury X und GeForce GTX 980 Ti unter der UltraHD-Auflösung, wo beide Karten den exakt selben Punkt im 4K Performance-Index [21] besetzen: Kaum ein Test kam hierbei auf einen Gleichstand, meist wurde recht deutlich die eine oder andere Karte vorn gesehen. Dabei sahen mehr Tests die nVidia-Lösung vorn – schaut man jedoch nach der Menge der jeweiligen Testtitel, gleicht sich dies wieder aus, da die AMD-Lösung alle Tests gewinnen konnte, wo mindestens 15 Testtitel angesetzt wurden.

Das ganze darf als guter Hinweis darauf verstanden werden, wie stark sich einzelne Hardware-Tests "irren" können bzw. wie wichtig es ist, mit möglichst großen Testsets zu arbeiten, um die sich aus einzelnen Ausreißern ergebende Fehlerquote möglichst gering zu halten. Es besteht schließlich dann doch schon ein Unterschied darin, ob man eine GeForce GTX 980 Ti mit 8,8% schneller als eine Radeon R9 Fury X wertet (wie beim Guru3D [72]) – oder ob man im Gegenteil einen Vorteil der AMD-Karte von 5,7% notiert (wie bei PCGamer [68]), dies ist eine Abweichung beider Benchmark-Ergebnisse um immerhin 14,5%. Demzufolge scheint es auch weiterhin nicht ohne unsere Verrechnung aller hier vorliegenden und ausgewerteten Benchmark-Ergebnisse zu gehen, vorgenommen mit gewisser Gewichtung zugunsten derjenigen Artikeln mit besonders vielen Testtiteln.

Den Sieg und damit die Einnahme des absoluten Performance-Throns der SingleChip-Lösungen durch die GeForce GTX 1080 stellt natürlich niemand in Frage, es geht hierbei allein um die Höhe der exakten Abstände. Jene sind mit +27% gegenüber der GeForce GTX Titan X sogar etwas höher als was nVidia vorab selber prognostiziert hatte (+22% zur GeForce GTX Titan X [78]) – eine bemerkenswerte Abweichung, denn normalerweise laufen Hersteller-eigene Benchmarks immer etwas übertrieben zugunsten des jeweils herauszustellenden Produkts ab, nicht aber in diesem Fall. Die von uns letztlich gebildenden Performance-Index-Werte sind damit sogar leicht höher als bei unseren vorherigen Prognosen [79] (von ~900-950% bzw. ~125%): Die GeForce GTX 1080 erreicht gleich 960% im FullHD Performance-Index [20] sowie gleich 132% im 4K Performance-Index [21].

| Fury X | 980 | 980 Ti | Titan X | 1080 | |

|---|---|---|---|---|---|

| gemittelte FullHD-Performance | 69,1% | 62,8% | 76,8% | 79,2% | 100% |

| gemittelte WQHD-Performance | 71,9% | 60,0% | 75,9% | 78,4% | 100% |

| gemittelte UltraHD-Performance | 75,1% | 58,9% | 75,6% | 78,6% | 100% |

| FullHD Perf.Gewinn der GTX 1080 | +45% | +59% | +30% | +26% | - |

| WQHD Perf.Gewinn der GTX 1080 | +39% | +67% | +32% | +28% | - |

| UltraHD Perf.Gewinn der GTX 1080 | +33% | +70% | +32% | +27% | - |

| 3DCenter FullHD Performance-Index [20] | 670% | 600% | 730% | 760% | 960% |

| 3DCenter 4K Performance-Index [21] | 100% | 77% | 100% | 104% | 132% |

| Straßenpreis | 580-620€ | 440-480€ | 600-640€ | 1000-1100€ | angekündigt für 789 Euro |

| Mehrpreis der GTX 1080 | +33% | +74% | +29% | günstiger | - |

Dies ist eine beeindruckende Stärke für eine Grafikkarte basierend auf dem zweithöchsten Chip der jeweiligen Generation – und reicht trotzdem nicht dafür aus, sich ausreichend deutlich von den bisherigen Enthusiasten-Lösungen abzusetzen, um jene damit wirklich aufs Abstellgleis zu schicken. Schließlich kann man gerade aus GeForce GTX 980 Ti & Titan X noch sehr viel herausholen, hat nVidia den GM200-Chip bei diesen Grafikkarten nicht wirklich ausgereizt. Die beliebten stark ab Werk übertakteten GeForce GTX 980 Ti Grafikkarten können gemäß dieser Performance-Ergebnisse bis auf ca. 10% an die GeForce GTX 1080 herankommen, drastische Eigen-Übertakungen von GeForce GTX 980 Ti & Titan X können der GeForce GTX 1080 dabei sogar den Rang ablaufen: Im Test der PC Games Hardware [26] erreicht eine auf 1500/4200 MHz laufenden GeForce GTX Titan X ein Performanceplus von immerhin 10,6% gegenüber einer (unübertakteten) GeForce GTX 1080.

Natürlich kann man auch die GeForce GTX 1080 selber noch übertakten: Taktspielräume sind augenscheinlich vorhanden, auf dauerhaft über 1800 MHz Chiptakt und zeitweise über 2000 MHz Chiptakt sind diese Karten schon zu bringen. Hier limitieren zuerst Power- und Temperatur-Limit des Grafikkarten-BIOS, bei gutklassiger Übertaktung sind aber dennoch auch für die GeForce GTX 1080 noch ca. 10-15% Performancegewinn drin. Unter Übertaktung sinkt damit aber das Performanceplus gegenüber GeForce GTX 980 Ti und Titan X deutlich ab, da sich die Founders Edition der GeForce GTX 1080 prozentual bei weitem nicht so gut übertalten läßt wie diese genannten GM200-Karten. Die Herstellerdesigns zur GeForce GTX 1080 sollten dann höhere Übertaktungsspielräume ermöglichen, da der GP104-Grafikchip augenscheinlich noch mehr hergibt – was man mit besserer Kühlung sowie großzügigeren Power- und Temperatur-Limits herauskitzeln dürfte. Unter starker Übertaktung verliert die Karte natürlich ihre exzellente Energieeffizienz, sind dann also auch Stromverbrauchswerte von ~210 Watt mit der Founders Edition und potentiell in Richtung 250 Watt mit den kommenden Herstellerdesigns einzukalkulieren.

Damit bleiben noch einige Fragen offen, welche sich dann aber erst mit dem Auftauchen der Herstellerdesigns zufriedenstellend beantworten lassen. Dazu gehört auch die allerwichtigste Frage – diejenige nach dem Preis/Leistungs-Verhältnis. Eine Antwort hierauf kann derzeit nur sehr eingeschränkt gegeben werden, da die Herstellerdesigns fehlen sowie zum Referenzdesign der Founders Edition nur Listenpreise vorliegen, aber noch keine echten Straßenpreise. Davon ausgehend, das sich die nVidia-Vorgabe von 789 Euro tatsächlich so im deutschen Einzelhandel zeigt (der US-Listenpreis würde direkt umgerechnet eigentlich eher ~735 Euro ergeben), kostet die Karte gegenüber Radeon R9 Fury X und GeForce GTX 980 Ti ziemlich exakt so viel mehr, wie viel sie auch mehr an Performance erbringt. Dies ist oberflächlich in Ordnung, normalerweise bezahlt man für Spitzenperformance gern auch einmal klar mehr als was es an Leistungsschub gibt.

Für eine Grafikkarte einer neuen Generation basierend auf einem neuen Fertigungsverfahren ist dies jedoch eine eher schwache Vorstellung – aus dieser Ansetzung heraus darf man erwarten, das man zum alten Preispunkt ein kräftiges Performanceplus faktisch kostenlos bekommt. Genau diesen Punkt, welchen in der Vergangenheit eigentlich alle neuen Grafikkarten-Generationen geboten haben, kann die GeForce GTX 1080 derzeit und zu diesen voraussichtlichen Preislagen der Founders Edition nicht bieten. Natürlich bleibt abzuwarten, wie sich die Preise der Herstellerdesigns entwickeln, schon mit deren 100 Dollar/Euro weniger würde die Sache deutlich freundlicher aussehen. Zudem ist zu erwarten, das der Preis der GeForce GTX 1080 im Laufe des Lebenszyklus der Karte zielich klar absinken wird. Es handelt sich hierbei um eine typische 500-Dollar-Lösung wie sie auch die GeForce GTX 980 war, daher wird dieser Preis auch eines Tages zu erreichen sein.

Allerdings hat die Erfahrung früherer Generations-Wechsel gezeigt, das dieses "normale" Preisniveau frühestens zur Mitte des Lebenszyklus einer Grafikkarten-Generation erreicht wird, die lange Monate der Anfangszeit von überhöhten Preislagen bzw. faktischen Early-Adopter-Preisaufschlägen gekennzeichnet waren. Im Fall der 14/16nm-Grafikkarten kann man eventuell sogar eine besonders lange Zeitspanne erwarten, ehe dieser Punkt des "normalen" Preisniveaus erreicht ist – dafür müssen zumindest einmal die echten Enthusiasten-Lösungen von AMD Vega 11 bis nVidia GP100/GP102 im Markt stehen, was durchaus noch bis Mitte 2017 dauern kann. Bis dahin dürften vermutlich alle 14/16nm-Beschleuniger mit dem Problem der Early-Adopter-Preisaufschläge zu kämpfen haben – es sei denn, AMD hält sich hierzu bei Polaris 10 deutlich zurück, dies dürfte sich in Bälde ergeben.

Abschließend muß klar gesagt werden, das dieser Launch der GeForce GTX 1080 durch das Fehlen einer ernsthaften Preislage ziemlich in der Luft hängt. Der etwas spätere Auslieferungstermin (27. Mai 2016) ist noch verschmerzbar, aber ohne klare Preislage ist die Karte kaum solide zu bewerten – gerade wenn dann für die später erscheinenden Herstellerdesigns ein klar nach unten hin abweichender Preispunkt gemacht werden soll. Wahrscheinlich muß zu gegebener Zeit an dieser Stelle ein gewisser Nachtrag erscheinen, welcher die GeForce GTX 1080 unter dem Eindruck von dann verfügbaren Herstellerdesigns und echter Straßenpreise noch einmal neu betrachtet.