Launch-Analyse nVidia GeForce GTX 1080

Hauptlinks

Suchen

Launch-Analyse nVidia GeForce GTX 1080

Immerhin gut viereinhalb Jahre nach dem Launch der ersten 28nm-Beschleuniger (AMDs Radeon HD 7970 im Dezember 2011) kommt mit der GeForce GTX 1080 eine erste Grafikkarte basierend auf einer moderneren Fertigungstechnologie in den Markt. Dies ist ein selbst in Zeiten geringer werdender Fortschritte in der Chipfertigung vergleichsweise langer Zeitraum – welcher verbunden war mit einer langen Zeit des Wartens auf die 14/16nm-Generation, nun aber Hoffnung darauf macht, das sich diese lange Wartezeit jetzt in Form kräftiger Performanceschübe bezahlt macht. Ob die GeForce GTX 1080 diesen hohen Erwartungen gerecht werden kann, werden wir nachfolgend im Rahmen dieser Launch-Analyse herauszuarbeiten versuchen, welche wie immer als primären Punkt eine Zusammenfassung bzw. Zusammenrechnung möglichst vieler der Benchmark-Ergebnisse der Launchreviews bieten wird.

Der der GeForce GTX 1080 zugrundeliegende GP104-Chip ist wie bekannt nur nVidias zweithöchste Lösung im Pascal-Portfolio, im Enthusiasten-Segment werden hier später noch GP100- oder GP102-basierte Grafikkarten unter wahrscheinlich dem Titan-Brand antreten. Als zweithöchster Chip besteht zwar im Rahmen einer neuen Chipgeneration trotzdem die Zielsetzung, den allerbesten Chip der zuvorgehenden Chipgeneration (GM200-Chip von GeForce GTX 980 Ti & Titan X) zu schlagen – primär wird damit aber natürlich der zweitbeste Chip der zuvorgehenden Chipgeneration ersetzt, sprich der GM204-Chip von GeForce GTX 970 & 980. Jener trat wie bekannt mit 2048 Shader-Einheiten an einem 256 Bit GDDR5-Speicherinterface an, der GP104-Chip bringt stattdessen 2560 Shader-Einheiten an einem 256 Bit GDDR5X-Speicherinterface daher. Nominell ist dies – gerade für ein neues Fertigungsverfahren – ein sehr kleiner Hardware-Sprung, welcher dann aber gut ausgeglichen wird durch die in der Pascal-Generation deutlich steigenden Chiptaktraten.

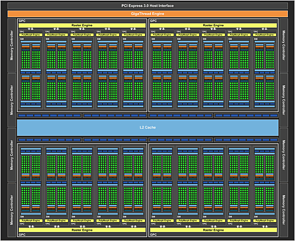

nVidia GP104 Blockdiagramm |

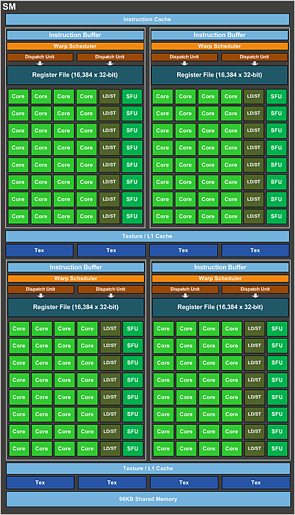

nVidia GP104 Shader-Cluster |

Chip-intern hat sich hingegen kaum etwas getan, ganz grob kann man daher die GP104-Architektur als "Maxwell in 16nm" betrachten. In dieser Frage ist der GP104-Chip allerdings auch klar abweichend vom womöglich nur für HPC-Aufgaben eingesetzten GP100-Chip, welche einen deutlichen Umbau der Shader-Cluster mit sich bringt – welchen nVidia für den GP104-Chip wieder zurückgenommen hat. Die Zielsetzung beim GP100-Chip war aber wegen der HPC-Ausrichtung auch eine völlig andere, für die Gaming-Ausrichtung des GP104-Chips erscheint nVidia die Zusammenstellung der Shader-Cluster gemäß des Maxwell-Vorbilds wohl auch weiterhin als passend anzusehen.

| Kepler | Maxwell 2 | Pascal – GP104 | Pascal – GP100 | |

|---|---|---|---|---|

| DirectX 12 Feature-Level | 11_0 | 12_1 | 12_1 | 12_1 |

| Durchsatz pro Raster-Engine | 8 Pixel/Takt 1 Triangle/Takt |

16 Pixel/Takt 1 Triangle/Takt |

16 Pixel/Takt 1 Triangle/Takt |

16 Pixel/Takt 1 Triangle/Takt |

| Aufbau der Shader-Cluster | 192 Shader-Einheiten, 16 Textureneinheiten, 32 Load/Store-Einheiten, 32 SFUs, 8 FP64-Einheiten, 1x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), 64 kByte Level1-Cache, 48 kByte Texturen-Cache (GK110: 64 anstatt 8 FP64-Einheiten) |

128 Shader-Einheiten, 8 Textureneinheiten, 32 Load/Store-Einheiten, 32 SFUs, 4 FP64-Einheiten, 4x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), 96 kByte Level1-Cache, 48 kByte Texturen-Cache | 128 Shader-Einheiten, 8 Textureneinheiten, 32 Load/Store-Einheiten, 32 SFUs, 4 FP64-Einheiten, 4x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), 96 kByte Level1-Cache, 48 kByte Texturen-Cache | 64 Shader-Einheiten, 4 Textureneinheiten, 16 Load/Store-Einheiten, 16 SFUs, 32 FP64-Einheiten, 4x Kontrolllogik, 65536 x 32-bit Register File (256 kByte), ? kByte Level1-Cache, ? kByte Texturen-Cache |

| TMU/SE-Verhältnis | 1:12 | 1:16 | 1:16 | 1:16 |

| DP/SP-Verhältnis | 1/24 (GK110: 1/3) | 1/32 | 1/32 | 1/2 |

| SP/HP-Verhältnis | - | - | - | 1/2 |

| wichtige Fortschritte | - | doppelter Pixel-Durchsatz der Raster-Engines, kleinere Shader-Cluster, deutlich mehr Kontrolllogik pro Shader-Einheit, größere Caches pro Shader-Einheit | faktisch keine | grundsätzlich halbierte Shader-Cluster, deutlich mehr Kontrolllogik und deutlich größere Caches pro Shader-Einheit, massiv mehr FP64-Einheiten, HalfPrecision-Modus |

Daneben hat nVidia dann natürlich dennoch einige kleinere und mittlere Verbesserungen mit dem GP104-Chip zu bieten – welche sich in dieser oder besserer Form dann auch in den nachfolgenden weiteren Pascal-Chips und den darauf basierenden GeForce 1000 Grafikkarten wiederfinden werden. Bis vielleicht auf den (anständigen) Support von "Asynchronous Compute" fehlen hierbei sicherlich die großen Innovationen – allerdings waren die vorhergehenden Maxwell-Grafikkarten durchaus schon sehr runde Pakete, bleibt da nicht mehr viel Platz für große Sprünge, sondern sind vielmehr kleinere Verbesserungen der normale Lauf der Welt. Pascal ist für nVidia sowieso eine zwischengeschobene Architektur-Stufe, die nur deswegen aus der Taufe gehoben wurde, weil die 14/16nm-Fertigung für die zuvorgehende Maxwell-Generation noch nicht zur Verfügung stand (bzw. die 20nm-Fertigung komplett ausgelassen wurde). Die nächste "echte" neue nVidia-Architektur wird der Pascal-Nachfolger "Volta" sein, von diesem sind dann eventuell größere Innovationen zu erwarten.

|