Launch-Analyse: nVidia GeForce GTX Titan X

Hauptlinks

Suchen

Launch-Analyse: nVidia GeForce GTX Titan X

Nach dem Mainstream/Performance-Chip GM206 sowie dem HighEnd-Chip GM204 bringt nVidia mit dem GM200-Chip nun auch noch seinen Enthusiasten-Chip der Maxwell-Generation in Form der GeForce GTX Titan X Grafikkarte in den Markt. Dabei soll wieder kompromißlose Leistung am oberen Ende der Leistungsskala und natürlich auch die schnellste derzeitige SingleChip-Lösung geboten werden – was angesichts der fehlenden Konkurrenz natürlich gelingt, dies ist auch nicht die Frage. Die eigentlichen Fragen zur GeForce GTX Titan X sind eher, wie deren Eignung speziell für für die 4K-Auflösung ist, was für reale Taktraten, Stromverbrauch und Geräuschentwicklung die Karte hat, und was man vor allem unter Entfesselung aller Möglichkeiten noch aus der Karte herausholen kann – Fragen, denen wir uns nachfolgend in Auswertung der vorliegenden Testberichte zur GeForce GTX Titan X widmen wollen.

Für die GeForce GTX Titan X benutzt nVidia den GM200-Chip im Vollausbau, welcher 6 Raster-Engines, 24 Shader-Cluster mit 3072 Shader-Einheiten und 192 Textureneinheiten an einem 384 Bit DDR Speicherinterface mit 96 Raster Operation Unit aufweist. Aufgrund der leicht höheren Anzahl an Shader-Einheiten zum vorherigen Enthusiasten-Chips GK110 (2880 -> 3072 Shader-Einheiten) sowie des etwas größeren Platzbedarfs von Maxwell-basierten Shader-Einheiten steigt die Transistoren-Menge zwischen GK110- und GM200-Chip von 7,1 auf 8 Milliarden Transistoren, der Platzbedarf des Grafikchips geht von 551mm² auf stolze 601mm² hinauf. Gefertigt wird der GM200-Chip wie üblich in der 28nm-Fertigung von TSMC, da andere Fertigungsverfahren derzeit wohl noch keine so großen Chips backen können – die 20nm-Fertigung ist hierfür grundsätzlich schlecht geeignet, die 14/16nm-Fertigung noch (lange) nicht spruchreif für so große Chips.

Technologisch ist der GM200-Chips den vorhergehenden GM206- und GM204-Chips sehr nahe: Alle diese Grafikchips der Maxwell-2-Architektur benutzen denselben Aufbau der Shader-Cluster (mit jeweils 128 Shader- und 8 Texturen-Einheiten) und haben dasselbe Feature-Set sowie DirectX-Level. Was die Maxwell-2-Architektur an neuen Features mitbringt, wurde bereits beim Launch von GeForce GTX 970 & 980 notiert – einzig abweichend davon ist das DirectX-Level, welches gemäß neueren Informationen nunmehr auf "DirectX 12.1" bei allen Grafikkarten der Maxwell-2-Architektur – und damit auch bei der GeForce GTX Titan X – lautet. Irgendwelche abweichenden Features zu GeForce GTX 970 & 980 hat die GeForce GTX Titan X also nicht – sie ist schlicht wie eine GeForce GTX 980 mit durchgehend um 50% stärkerer Hardware.

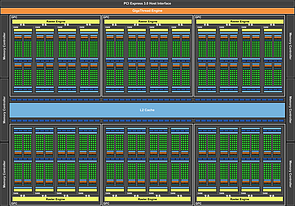

nVidia GeForce GTX Titan X Block-Diagramm |

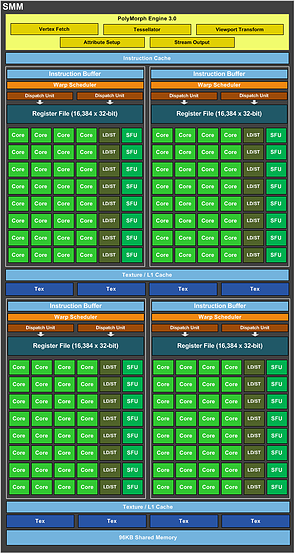

nVidia GM200-Chip Shader-Cluster (SMM) |

Ebenfalls gleichlautend zu den bisherigen Maxwell-basierten Grafikchips, aber abweichend von den früheren Enthusiasten-Grafikchips von nVidia (wie dem GK110) verfügt der GM200-Chip allerdings nicht über besondere DoublePrecision-Fähigkeiten, sondern muß eine schwache DP-Rate von nur 1/32 hinnehmen (GK110: 1/3). Diese Funktionalität hat wohl schlicht nicht mehr in die zur Verfügung stehende Chipfläche gepasst (oberhalb von 600mm² wird es schnell unwirtschaftlich), dies wäre nur bei einer neuen Fertigungsstufe möglich gewesen. Da selbige noch nicht verfügbar ist, musste nVidia gewisse Abstriche hinnehmen – welche aus Gamer-Sicht aber eher glücklich sind, denn die DoublePrecision-Fähigkeiten werden im Spiele-Einsatz überhaupt nicht benötigt, haben aber bei früheren Enthusiasten-Lösungen nutzlos Chipfläche belegt und sogar hier und da teilweise an eventuell möglichem Chiptakt gekostet.

| Radeon R9 290X | GeForce GTX 780 Ti | GeForce GTX 980 | GeForce GTX Titan X | |

|---|---|---|---|---|

| Chipbasis | AMD Hawaii, 6,2 Mrd. Transistoren in 28nm auf 438mm² Chipfläche | nVidia GK110, 7,1 Mrd. Transistoren in 28nm auf 551mm² Chipfläche | nVidia GM204, 5,2 Mrd. Transistoren in 28nm auf 398mm² Chipfläche | nVidia GM200, 8 Mrd. Transistoren in 28nm auf 601mm² Chipfläche |

| Architektur | GCN-Architektur 1.1, DirectX 12.0, Mantle & TrueAudio | Kepler-Architektur, DirectX 11.0 & PhysX | Maxwell-Architektur 2.0, DirectX 12.1 & PhysX | |

| Technik | 4 Raster-Engines, 2816 Shader-Einheiten, 176 TMUs, 64 ROPs, 512 Bit DDR Interface, 1 MB Level2-Cache | 5 Raster-Engines, 2880 Shader-Einheiten, 240 TMUs, 48 ROPs, 384 Bit DDR Interface, 1,5 MB Level2-Cache | 4 Raster-Engines (mit verdoppelter Raster-Power), 2048 Shader-Einheiten, 128 TMUs, 64 ROPs, 256 Bit DDR Interface, 2 MB Level2-Cache | 6 Raster-Engines (mit verdoppelter Raster-Power), 3072 Shader-Einheiten, 192 TMUs, 96 ROPs, 384 Bit DDR Interface, 3 MB Level2-Cache |

| Taktraten | ≤1000/2500 MHz (Ø-Chiptakt: 851/1000 MHz *) |

875/928/3500 MHz (Ø-Chiptakt: 952 MHz) |

1126/1216/3500 MHz (Ø-Chiptakt: 1144 MHz) |

1002/1075/3500 MHz (Ø-Chiptakt: 1067 MHz) |

| Speicherausbau | 4 GB GDDR5 (8 GB gegen Aufpreis) |

3 GB GDDR5 | 4 GB GDDR5 | 12 GB GDDR5 |

| Layout | DualSlot | DualSlot | DualSlot | DualSlot |

| Kartenlänge | 27,5cm | 27,0cm | 27,0cm | 27,0cm |

| Stromstecker | 1x 6pol. + 1x 8pol. | 1x 6pol. + 1x 8pol. | 2x 6pol. | 1x 6pol. + 1x 8pol. |

| TDP | 250W | 250W | 165W | 250W |

| Idle-Verbrauch | 20W | 14W | 12W | 14W |

| Spiele-Verbrauch | 239/279W * | 251W | 174W | 242W |

| Ausgänge | 2x DualLink DVD-D, HDMI 1.4a, DisplayPort 1.2 | DualLink DVD-D, DualLink DVI-I, HDMI 1.4a, DisplayPort 1.2 | DualLink DVI-I, HDMI 2.0 (kein HDCP 2.2), 3x DisplayPort 1.2 | DualLink DVI-I, HDMI 2.0 (kein HDCP 2.2), 3x DisplayPort 1.2 |

| Perf.Index | 480/520% * | 530% | 570% | 750% |

| Listenpreis | 549$ | 699$ | 549$ | 999$ |

| Straßenpreis | 320-360€ | ausgelaufen | 500-540€ | erwartet für ~1100€ |

| Release | 24. Oktober 2013 | 7. November 2013 | 19. September 2014 | 17. März 2015 |

| * Die zwei differierenden Angaben beziehen sich auf den Quiet/Uber-Modus der Radeon R9 290X. Zu beachten wäre hierbei, das gutklassige Herstellerdesigns dieser Karte die Performance & Leistungsaufnahme des Uber-Modus' auch schon per default erreichen. | ||||

Die GM200-basierte GeForce GTX Titan X kommt hingegen mit 1002 MHz nominellem Chiptakt, 1075 MHz nominellem Boost-Takt und bei der ComputerBase ermittelten 1067 MHz real anliegendem Chiptakt auf recht hohen Chip-Taktraten für einen derart großen Chip daher, auch wenn das Niveau anderer Maxwell-basierter Grafiklösungen damit noch nicht ganz erreicht wird. Hier spielen auch die von nVidia gesetzten Limits für die Chip-Temperatur von 83°C sowie für den Stromverbrauch von 250 Watt mit hinein, welche die Karte doch etwas ausbremsen. Leider sind diese Limits per Treiber nicht großartig weiter beeinflußbar: Bei der Temperatur kann man maximal 91°C erreichen, beim Stromverbrauch maximal 275 Watt (jeweils +10%). Mittels BIOS-Mods oder freigeschalteten Hersteller-Karten sollte hier noch mehr möglich sein – was sich lohnen dürfte, die GeForce GTX Titan X erscheint jetzt schon als recht taktfreudig in Richtung von 1300 MHz real anliegendem Takt.

Dabei scheint in aller Regel nicht zuerst das Power-Limit, sondern zuerst das Temperatur-Limit erreicht zu werden – und selbst im Overclocking-Betrieb keine exorbitanten Stromverbrauchswerte herauszukommen. Dafür aber liegt die GeForce GTX Titan X in der Praxis mit einem realen Spiele-Stromverbrauch von 242 Watt knapp an der Grenze zu ihrer TDP von 250 Watt – aber immer noch besser als GeForce GTX 970 & 980, deren realer Stromverbrauch ihre jeweiligen TDP-Werte klar überbietet (was so eigentlich nicht sein darf, weil sich nVidia somit ungerechtfertigte Vorteile auf dem Papier holt). Geringfügig ist der Stromverbrauch der GeForce GTX Titan X natürlich trotzdem nicht – es werden halt nur keine neuen Stromverbrauchs-Rekorde aufgestellt:

| Hardware.fr | Heise | HT4U | PCGH | TechPowerUp | Tom's HW | Ø | Perf./TDP | |

|---|---|---|---|---|---|---|---|---|

| GeForce GTX Titan X | 15W 255W |

18W 242W |

11W 223W |

9W 224W |

14W 242W |

750% 250W |

||

| GeForce GTX 980 | 12W 155W |

? 173W |

11,2W 180,0W |

11,5W 160W |

8W 156W |

15W 185W |

12W 174W |

570% 165W |

| GeForce GTX 780 Ti | 15W 220W |

? 243W |

12,9W 260,0W |

16W 248W |

10W 229W |

10W 244W |

13W 245W |

530% 250W |

| GeForce GTX Titan Black | 13,3W 243,0W |

11W 226W |

~13W ~230W |

500% 250W |

||||

| GeForce GTX Titan | 13W 180W |

11,9W 198,1W |

13W 214W |

10W 208W |

11W 233W |

12W 206W |

480% 250W |

|

| Radeon R9 290X (Quiet) | 21W 219W |

? 266W |

20,0W 231,1W |

21W 249W |

16W 236W |

16W 248W |

19W 241W |

480% 250W |

| Radeon R9 290X (Uber) | 22W 278W |

20,0W 306,9W |

21W 269W |

17W 246W |

16W 242W |

19W 276W |

520% 250W |

|

| Der obere Wert einer Zelle ist immer der Idle-Stromverbrauch, der untere Wert einer Zelle immer der Spiele-Stromverbrauch. In der Durchschnitts-Spalte ("Ø") fettgedruckte Werte basieren auf Berechnungen, die nicht fettgedruckte Werte sind Schätzungen. Die letzte Spalte enthält Angaben zum 3DCenter Performance-Index (oben) sowie zur offiziellen TDP (unten). | ||||||||