Hauptlinks

Suchen

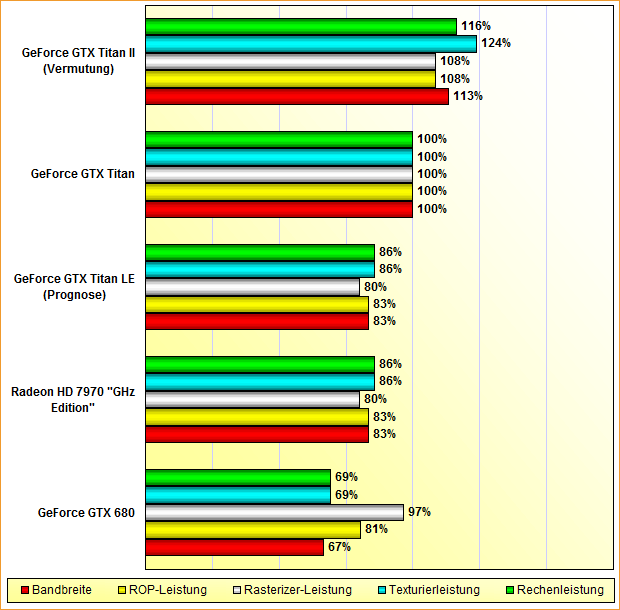

Wie eine "GeForce GTX Titan II" aussehen könnte

Die GeForce GTX Titan führt derzeit – trotz der Widersprüche ob des exorbitanten Preispunkts – alle Charts zur Performance von SingleChip-Beschleunigern klar an, eine abgespeckte Variante ist zudem in Form der GeForce GTX Titan LE bereits auf dem Weg. Dabei ist selbst die originale GeForce GTX Titan bereits eine (kleine) Abspeckung – die Karte bietet bekannterweise nicht alle Hardware-Einheiten des zugrundeliegenden GK110-Chips auf. Dies hängt natürlich damit zusammen, daß ein offiziell wohl 561mm² großer Grafikchip nicht wirklich einfach und vor allem nicht ohne gewisse Ausschussquote hergestellt werden kann. Mittels der bei der originalen GeForce GTX Titan freigeschalteten nur 2688 von orginal 2880 Shader-Einheiten ist man nicht auf gänzlich perfekte Chips aus der GK110-Fertigung angewiesen, was gerade anfänglich enorm weiterhelfen dürfte.

Mit der Zeit wird die GK110-Fertigung aber automatisch besser werden, wird die Aussschussquote weiter zurückgehen – und sich somit auch eine gewisse Anzahl an GK110-Chips ansammeln, welche absolut perfekt gefertigt sind. Diese perfekt gefertigten GK110-Chips kann man dann sicherlich bei der Produktion der originalen GeForce GTX Titan verbraten – oder aber man legt eine neue, höhere Titan-Variante auf, von uns nachfolgend schlicht einmal "GeForce GTX Titan II" genannt. Diese Karte würde dann den Vollausbau des GK110-Chips zuzüglich eventuell noch höherer Taktraten bieten und könnte sich daher im Rahmen (je nach gewählter Taktraten) von 10 bis 15 Prozent Performance von der originalen GeForce GTX Titan absetzen.

| GeForce GTX Titan LE | GeForce GTX Titan | GeForce GTX Titan II | |

|---|---|---|---|

| Chipbasis | nVidia GK110, 7,1 Mrd. Transistoren in 28nm auf 561mm² Chipfläche | ||

| Architektur | Kepler, DirectX 11.0 | ||

| Technik | wahrscheinlich 4-5 Raster Engines, 2496 (1D) Shader-Einheiten, 208 TMUs, 40 ROPs, 320 Bit DDR Speicherinterface | 5 Raster Engines, 2688 (1D) Shader-Einheiten, 224 TMUs, 48 ROPs, 384 Bit DDR Speicherinterface | wahrscheinlich 5 Raster Engines, 2880 (1D) Shader-Einheiten, 240 TMUs, 48 ROPs, 384 Bit DDR Speicherinterface |

| Taktraten | 837/876/3000 MHz | 837/876/3000 MHz | angenommen ~950/3400 MHz |

| Speicherausbau | 5 GB GDDR5 | 6 GB GDDR5 | 6 GB GDDR5 |

| Spieleverbrauch | geschätzt 180-190W | 206W | geschätzt 220-230W |

| 3DC Perf.Index (1920x1080 4xAA) |

geschätzt 410-430% | 480% | geschätzt 530-550% |

| Preislage | angenommen 600-700 Euro | 940-980€ | wahrscheinlich Einstiegspreis 1000 Euro bei gleichzeitiger Preissenkung der bisherigen Titan-Karten |

| Release | wahrscheinlich Sommer 2013 | 21. Februar 2013 | wahrscheinlich Jahreswechsel 2013/2014 |

Bis jetzt ist dies natürlich nur eine (theoretisch) zur Verfügung stehende Möglichkeit – interessant wird dies erst dann, wenn nVidia auch etwas mit dieser Möglichekeit anfangen kann. Dies hängt von den mittelfristigen Planungen bei nVidia ab, welche im Gegensatz zu AMD noch deutlich unsicher sind. Angenommen jedoch den Punkt, die nächste (echte) Grafikkarten-Generation bei nVidia kommt gleichlautend zu den AMD-Planungen bei der Radeon HD 8000 Serie erst zum Jahreswechsel 2013/2014, könnte eine "GeForce GTX Titan II" für die GeForce 700 Serie den gleichen Part übernehmen wie jetzt für die GeForce 600 Serie – als eine Top-Karte klar über dem Leistungsniveau der nachfolgenden Beschleuniger.

Dies wäre um so wichtiger, als daß wir die Topmodelle der Radeon HD 8000 Serie schon nahe an der originalen GeForce GTX Titan einschätzen. Um wieder einen ordentlichen Performanceabstand zur Radeon HD 8970 hinzulegen, benötigt nVidia einfach eine etwas schnellere Titan-Karte als jetzt geboten wird. Sollten also Radeon HD 8000 & GeForce 700 Serien (für Desktop-Belange) wirklich erst zum Jahresende erscheinen, wäre eine solche "GeForce GTX Titan II" ideal für nVidia, um den aktuell zu beobachtenden Zustand von der Titan als klar über allem thronenden Performance-Sieger erneut herzustellen. Die technologischen Möglichkeiten dazu hat man, da mit der orginalen GeForce GTX Titan die Möglichkeiten des GK110-Chips wie gesagt noch nicht ausgereizt sind.

Mit einem Vollausbau des GK110-Chips und etwas gesteigerten Taktraten sind durchaus interessante Dinge möglich: Auf angenommen 950 MHz Takt – was angesichts der Overclocking-Ergebnisse der aktuellen GeForce GTX Titan als sehr gut erreichbar erscheint – würde man auf 16,2% mehr Rechen- und Texturierleistung kommen. Angenommen eines etwas gesteigerten Speichertakts – beispielsweise auf 3400 MHz, was 13,3% mehr Speicherbandbreite ergibt – würde diese höhere Rechenkraft auch gut in Mehrperformance unwandelbar sein. In diesem (derzeit nur theoretischen) Modell wären sicherlich knapp 15% Mehrleistung gegenüber der originalen GeForce GTX Titan erzielbar.

Hierbei sind natürlich auch andere Taktraten für die "GeForce GTX Titan II" denkbar, was dann auch in anderen Performance-Resultaten resultieren würde. Gemäß der Overclocking-Ergebnisse zur originalen GeForce GTX Titan ist diese Karte jetzt schon durchaus mit über 1000 MHz belastbar – die GK110-Fertigung in einem dreiviertel Jahr dürfte dann sogar noch bessere Ergebnisse abwerfen. Auf einem Takt von 1000 MHz würde eine "GeForce GTX Titan II" dann schon 22,3% mehr Rechen- und Texturierleistung gegenüber der originalen GeForce GTX Titan aufweisen, was die Performance-Prognose auf grob +20% gegenüber der originalen GeForce GTX Titan verschieben würde.

Letztlich kann nVidia noch einiges aus dem GK110-Chip herausholen, sofern dieser über einen längeren Zeitraum produziert werden wird – wonach es derzeit mit den sich ankündigenden Schwierigkeiten bei der 20nm-Fertigung von TSMC absolut aussieht. Probleme mit einer zu großen Stromaufnahme wird eine "GeForce GTX Titan II" in jedem Fall nicht haben, die originale GeForce GTX Titan ist erstaunlich genügsam gemessen an ihrer Performance. Ob nVidia die vorhandenen Möglichkeiten allerdings auch ausnutzen wird (und damit eine "GeForce GTX Titan II" auch wirklich auflegt), dürfte maßgeblich davon abhängen, was AMD bringt und ob nVidia damit zu einer Gegenreaktion herausgefordert wird.

In dieser Beziehung denken wir derzeit, daß AMD und nVidia dieses Jahr nur noch Programmergänzungen bringen werden (sowie daß sich die kürzliche Meldung über einer GeForce 700 Serie schon zur Computex nicht auf neue Desktop-Lösungen beziehen wird), und daß die echte neue Grafikkarten-Generation beiderseits erst zum Jahreswechsel 2013/2014 antreten wird. Dann wird AMD mit der Radeon HD 8000 Serie wahrscheinlich zwischen 20% und 30% oben drauf legen, nVidia dürfte mit der GeForce 700 Serie nachziehen. Jener Performance-Boost mittels der Radeon HD 8000 Serie dürfte an der absoluten Leistungsspitze dazu führen, daß AMDs neues Top-Modell Radeon HD 8970 der originalen GeForce GTX Titan wohl zu nahe kommt, womit nVidia jene eben durch die "GeForce GTX Titan II" ersetzen wird.

| AMD 2013 | Perf.Index | nVidia 2013 |

|---|---|---|

| 480% | GeForce GTX Titan | |

| ~410-430% | GeForce GTX Titan LE | |

| Radeon HD 7970 "GHz Edition" | 390% | |

| 360% | GeForce GTX 680 |

Jene dürften dann den jetzigen Preis der originalen GeForce GTX Titan übernehmen und versuchen, ein ähnliches "Über-Angebot" darzustellen. Ob dies gelingt, hängt auch vom konkreten Leistungsplus AMDs beim Top-Modell der Radeon HD 8000 Serie ab – wenn jenes stärker an die "GeForce GTX Titan II" heranrückt als derzeit die Radeon HD 7970 "GHz Edition" zur originalen GeForce GTX Titan zurückliegt, wird der 1000-Dollar-Preis der "GeForce GTX Titan II" schwerer zu realisieren sein. Aber dies ist für eine mittelfristige Prognose schon viel zu spezifisch, derzeit kann man eher nur eine grobe Richtung für die Grafik-Beschleuniger des Jahres 2014 vorzeichnen:

| AMD 2014 | Perf.Index | nVidia 2014 |

|---|---|---|

| ~530-550% | GeForce GTX Titan II | |

| 480% | GeForce GTX Titan | |

| Radeon HD 8970 | ~450-470% | |

| ~410-430% | GeForce GTX Titan LE | |

| Radeon HD 7970 "GHz Edition" | 390% | |

| 360% | GeForce GTX 680 |

Ja nachdem wie stark die GeForce 700 Serie ausfällt, könnte es durchaus sein, daß mit dem Aufkommen der "GeForce GTX Titan II" die bisherigen zwei Titan-Lösungen aus dem Markt gehen – oder aber daß nVidia eine neue Variante der GeForce GTX Titan LE auflegt, um auch weiterhin die Produktionsausbeute an GK110-Chips hoch zu halten. Dies hängt an den exakten Abständen der einzelnen Grafikkarten untereinander sowie deren Preispunkten – was man jetzt besser noch nicht so genau versuchen sollte abzuschätzen.

Denn am Ende hängt diese komplette Prognose wie schon erwähnt an dem Punkt, daß nVidia seine echte GeForce 700 Serie erst zum Jahreswechsel 2013/2014 bringt – und daß damit etwaige Vorstellungen zum Computex entweder Rebrandings, reine OEM-Varianten oder eben Mobile-Lösungen sind, nicht aber für den Retail-Markt bestimmte Desktop-Grafikkarten basierend auf neuen Grafikchips. Daß nVidia wirklich mit einer GeForce 700 Serie für den Desktop schon zur Jahresmitte anrückt, ist vor dem Beweis eines Gegenteils einfach unglaubwürdig – ansonsten hätte AMD niemals die in Teilen nachweislich spruchreife Radeon HD 8000 Serie auf das Jahresende verschoben.

Vorstehend dargelegte Prognose stellt damit aber in jedem Fall nur eines von mehreren möglichen Zukunftsmodellen dar – sicherlich das aus unserer Sicht derzeit wahrscheinlichste, aber diesbezüglich kann man immer auf dem falschen Fuß erwischt werden. Schon zur Computex Anfang Juni wird man allerdings sehen können, ob sich die (angenommenen) nVidia-Pläne geändert haben oder ob diese Prognose doch real werden könnte. Sobald nVidia jedenfalls mit der echten GeForce 700 Serie für den Desktop erst zum Jahreswechsel 2013/2014 plant, ergibt sich eine sehr hohe Chance auf eine "GeForce GTX Titan II" als nVidias Desktop-Topmodell für das Jahr 2014 (bzw. vor dem Erscheinen erster 20nm-Beschleuniger) – da nVidia zum einen die technische Möglichkeit zur Verfügung steht und zum anderen durch die Radeon HD 8970 ein gewisser Druck existieren wird, mehr als mit der originalen GeForce GTX Titan vorhanden zu bieten.

Nachtrag vom 23. April 2013

Unsere Prognose zu einer möglichen GeForce GTX Titan II wurde durchaus von einigen Webseiten aufgegriffen und kommentiert – wobei man interessanterweise mit "GeForce GTX Titan Ultra" eine abweichende Namenswahl für diese schnellere Titan-Grafikkarte ins Spiel brachte. Und in der Tat zieht dieser Name wohl besser als die schlichte "II" im Namen – jene zeigt zwar eher auf eine neue Generation (auch wenn dies im konkreten Fall nicht gegeben wäre), allerdings hat das "Ultra" eine gewisse nVidia-Tradition und dürfte daher gerade im Bereich der absoluten Enthusiasten für mehr Interesse sorgen. Es kann natürlich noch nicht sicher gesagt werden, ob nVidia eine solche Karte bringen wird – möglich und damit nicht unwahrscheinlich wäre eine solche "GeForce GTX Titan Ultra" jedoch allemal.