Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 11. Dezember 2018

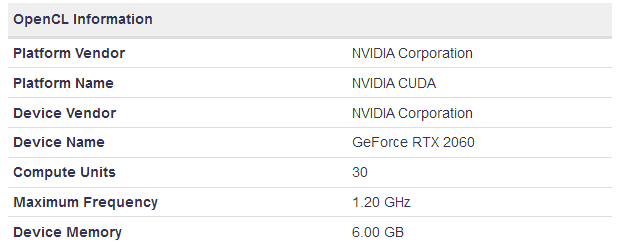

Die seitens Videocardz zur GeForce RTX 2060 gezeigte Spezifikations-Tabelle stammt (wie schon vermutet) von einem Notebook, wie der passende Eintrag in der Geekbench-Datenbank nahelegt. Damit gibt es keine 100%ige Gewißheit, inwiefern diese Daten einer Mobile-Ausführung der GeForce RTX 2060 auch wirklich 1:1 auf deren Desktop-Ausführung zu übertragen sind. Normalerweise hat sich nVidia allerdings in letzter Zeit (mit einer kleinen Ausnahme) allerdings bei den Mobile-Beschleunigern an die Hardware-Daten der jeweiligen Desktop-Lösungen gehalten, es gab im Mobile-Bereich allein etwas niedrigere Taktraten (speziell bei den MaxQ-Ausführungen). Da Videocardz letztlich auch das Foto einer Desktop-Variante der GeForce RTX 2060 (seitens Gigabyte) gezeigt haben, ist zumindest klar, das es diese Grafikkarten geben wird und das es sich bei der "GeForce RTX 2060" nicht rein nur um Mobile-Lösungen handelt wird (was ansonsten auch denkbar gewesen wäre).

Nach wie vor ist die Auflösung, das jene GeForce RTX 2060 (wie die GeForce RTX 2070) auf dem TU106-Chip basiert und dessen Salvage-Lösung darstellt, die wahrscheinlichste (was natürlich nicht bedeutet, das diese Auslegung zwingend korrekt wäre). Als weiteres Argument hierfür kann man das Detail der Raster-Engines ansehen, welches bei einem angenommenen extra Grafikchip für die GeForce RTX 2060 zwischen zwei ungünstigen Extremen schwanken würde: Entweder es sind die 3 Raster-Engines wie beim TU106-Chip, dann spart der potentielle TU107-Chip allerdings sehr wenig ein (zwischen TU104 und TU106 liegt immerhin eine Halbierung der Anzahl der Raster-Engines). Oder aber es sind nur 2 Raster-Engines, dann würde allerdings das Verhältnis von Raster-Engines zu Shader-Clustern auf den ungewöhnlich hohen und damit nicht wirklich wahrscheinlichen Wert von 1:15 hinaufgehen. Innerhalb der Turing-Generation ist ein Verhältnis von 1:12 augenscheinlich üblich, nur der TU104-Chip weicht davon mit 1:8 ab – allerdings eben nach oben hin und nicht nach unten hin. Gemäß dieser These sollte der nächstkleinere anzunehmende Turing-Chip dann im übrigen mit 24 Shader-Clustern (aka 1536 Shader-Einheiten) ausgerüstet sein – dies ergibt bei 2 Raster-Engines wiederum das anscheinend ideale Verhältnis von 1:12.

| nVidia TU106 | nVidia TU104 | nVidia TU102 | |

|---|---|---|---|

| Raster-Engines | 3 | 6 | 6 |

| Shader-Cluster | 36 | 48 | 72 |

| Verhältnis Raster-Engines zu Shader-Cluster | 1:12 | 1:8 | 1:12 |

Hardwareluxx bieten das Foto eines auf Intels "2018 Architecture Day" ausgestellten und lauffähigen Ice-Lake-Systems auf – welches neben dem Bild bzw. der Demonstration der Lauffähigkeit auch auf weitere Architektur-Verbesserungen innerhalb der Ice-Lake-Generation hinweist. So sollen neue CPU-Befehlssatzerweiterungen bis zu 75% Mehrperformance unter 7-Zip mit sich bringen, daneben verspricht Intel Beschleunigungen im Bereich von Crypto-Algorithmen (augenscheinlich nicht fürs Minen, sondern für Kryptographie-Tasks in normaler Anwendungs-Software). Frühere Meldungen sprachen schon von einer Verdopplung des Level2-Caches sowie einer (viel) breiteren integrierten Grafiklösung bei Ice Lake. Die Demonstration der Lauffähigkeit von Ice Lake weist zudem darauf hin, das Intel bei diesem Prozessor sicherlich kein Problem mit der Architektur hat – sondern das es tatsächlich die geringe Ausbeute in der 10nm-Fertigung ist, welche dessen Launch immer weiter nach hinten verlegt haben. Derzeit ist Ice Lake sogar erneut wieder in der Schwebe, denn wenn in der zweiten Jahreshälfte 2019 seitens Intel mittels "Comet Lake" tatsächlich noch eine weitere 14nm-Generation eingeschoben wird, dann bietet sich ein Ice-Lake-Launch noch im Jahr 2019 (zumindest im Desktop-Segment) eigentlich nicht mehr an.

Zur Erfüllung der eigenen Versprechungen würde Intel schließlich auch ein reiner Mobile-Start im Jahr 2019 ausreichen – womit die Desktop-Modelle von Ice Lake sich dann allerdings auf das Jahr 2020 verschieben würden (genauso wie der Server-Part von Ice Lake sowieso erst für das Jahr 2020 angesetzt war). Um die Probleme von Intels 10nm-Fertigung in den Griff zu bekommen, sollte dies dann allerdings wirklich genug Zeit sein. Aufgrund der ewigen Verzögerung speziell von Ice Lake ist im übrigen durchaus vorstellbar, das Intel diese Prozessoren-Generation speziell für den Desktop-Einsatz inzwischen schon umdesignen muß – weil die einstmals angedachte Anzahl an CPU-Kernen mit der kommenden Zen-2-Generation nicht mehr konkurrenzfähig ist. Denn ganz ohne die neue AMD-Konkurrenz gedacht, dürfte Ice Lake seitens Intel einstmals wohl eher als Achtkerner konzipiert worden sein – etwas, was man nunmehr sicherlich überdenken muß. Es besteht also durchaus die Seitenchance darauf, das Intel die Ice-Lake-Generationen für den Desktop-Einsatz inzwischen umbauen hat müssen – und das sich ein Teil der zu sehenden Verschiebung im Desktop-Segment auch daraus erklären läßt. Zu erwähnen wäre noch, das Intel in Widerlegung einiger zu vorfreudiger Meldungen auf diesem "2018 Architecture Day" nicht wirklich etwas zu den kommenden Intel-Grafikchips (oder deren GPU-Architektur) gesagt hat.