Hauptlinks

Suchen

Intel spricht sich gegen den Cinebench aus und fordert mehr realitätsnahe CPU-Benchmarks

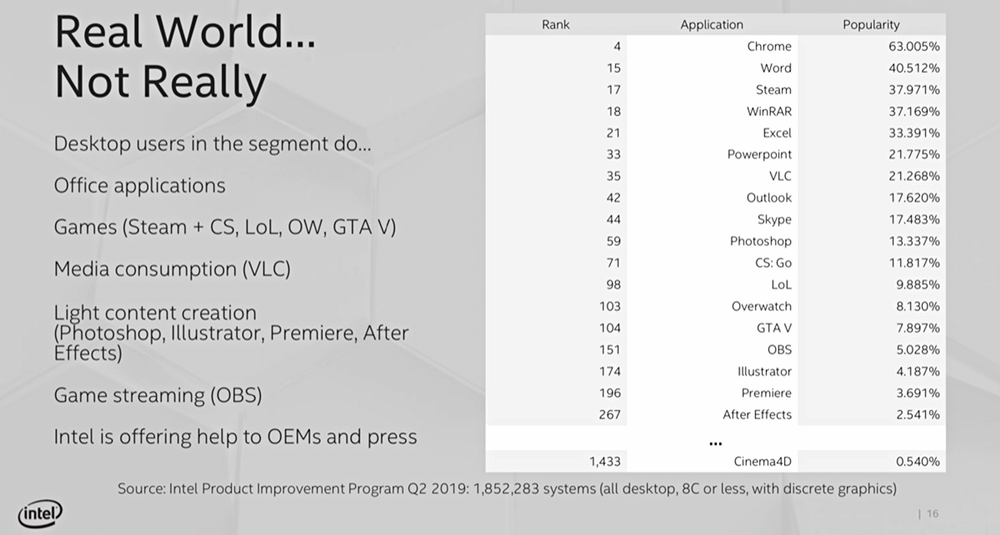

Auf einem Pre-Computex-Event hat sich Intel gemäß der ComputerBase für mehr realitätsnahe CPU-Benchmarks und dabei insbesondere gegen die Verwendung des Cinebench als Defacto-Referenz ausgesprochen. Als Hauptproblem sieht Intel hierbei dessen Praxisrelevanz, da sich das zugrundeliegende Anwendungs-Programm "Cinema4D" nur auf 0,54% von 1,8 Millionen hierfür analysierten PCs finden lies – im Gegensatz zu Chrome mit 63,0%, Word mit 40,5% und Steam mit 38,0% Verbreitungsgrad. Diese Argumentation ist sicherlich nicht von der Hand zu weisen, kann aber dennoch nicht der Weisheit letzter Schluß sein: Denn Chrome & Word dominieren primär deswegen die Verbreitungs-Charts, weil es in deren Software-Segment vergleichsweise wenig Wettbewerb und damit nur wenige Anbieter gibt. Bei Render-Software wie Cinema4D ist das Feld dagegen sehr viel breiter – und es somit absolut logisch, das die einzelnen Anbieter mit geringeren Prozentanteilen daherkommen. Zudem kann man generell nicht erwarten, das Spezial-Software wie eben Renderer auf einer Vielzahl von PCs installiert ist – dies sind Profi-Tools, jene werden immer nur von einer Minderheit an PC-Nutzern verwendet werden. Der reine Verbreitungsgrad kann sicherlich nicht der alleinige Maßstab sein – denn wenn doch, sollte sich Intel auf Prozessoren zur Beschleunigung von Chrome & Word konzentrieren und nachfolgend seine gesamte HEDT-Linie samt aller Prozessoren oberhalb von vier CPU-Kernen einstampfen.

Umgedreht täuscht schließlich auch die hohe Nutzerzahl von Word & Excel über deren wirkliche Bedeutung: Die allermeisten Office-Nutzer sind keine Profis, die hunderte Megabyte große Office-Dokumente mit mitlaufenden automatischen Scripten stemmen – und nur für letztere lohnt es sich überhaupt, nach der Office-Performance von heutigen PC-Prozessoren zu schauen. Der Normalnutzer zieht keinen praktischen Vorteil daraus, ob Prozessor #1 laut Benchmarks vielleicht sogar 100% schneller in Office ist als Prozessor #2 – einfach weil Office für den Normalnutzer kaum Szenarien bieten, wo mal wirklich CPU-Leistung abgefragt wird (die Schnelligkeit beim Programm-Einladen geht eher auf das Konto der benutzten Festplatte bzw. SSD). Schaut man sich manche Office-Benchmarks genauer an, bieten sich eher jene für den Rausschmiß aus dem Benchmark-Portfolio an, wie wenn das Einladen von übergroßen Excel-Tabellen simuliert wird. Jener Fall tritt beim Normalanwender eigentlich niemals auf, wird gleichzeitig aber auch durch die Benchmark-Resultate selber disqualifiziert, wenn dann Differenzen von 0,35 Sekunden gegenüber 0,25 Sekunden gemessen werden (ein Performance-Vorteil von satten +40%!), die für die Praxis (eine Zehntelsekunde Zeitgewinn) von glatter Irrelevanz sind.

Intels Initiative zugunsten von mehr realitätsnahen CPU-Benchmarks ist damit sicherlich nicht verkehrt, springt jedoch mit der dargebrachten Argumentationslage deutlich zu kurz. Insbesondere die Konzentration auf den Cinebench hat dabei durchaus ein "Geschmäckle", wenn Intel diesen Benchmark nun gerade dann angreift, wenn man derzeit selber in diesem vergleichsweise schlecht dasteht – im Gegensatz zu Bulldozer-Zeiten, wo Intel den Cinebench selber intensiv als Referenz benutzt hat (und selbst letztes Jahr noch noch bei der Demonstration eines 28-Kerners übertaktet auf 5 GHz). Nichtsdestotrotz kann man durchaus sagen, das der Cinebench als Referenz vielleicht eher schlecht gewählt ist – immerhin wird hierbei primär Fließkomma-Code verwendet und liegen somit die Integer-Einheiten der Prozessoren mehr oder weniger brach. Ein guter Referenz-Benchmark sollte normalerweise eher schönen Mix an verschiedenartigem Code beinhalten. Allerdings ergeben sich Referenz-Benchmarks auch eher durch die reine Anwenderpraxis – sprich dann, wenn ein Benchmark kostenfrei verfügbar ist, einfach zu benutzen ist, solide Ergebnisse mit wenig Varianz auswirft und letztlich so breit benutzt wird, das sehr viele Vergleichsresultate zur Verfügung stehen.

Ob sich also auf die schnelle eine neue Benchmark-Referenz im CPU-Bereich finden läßt, wäre somit zu bezweifeln. Wichtiger als ein einzelner Referenz-Benchmark ist aber sowieso das Drängen auf möglichst solide Benchmark-Sets in den Vergleichstests der bekannten Hardwaretest-Webseiten. Hier kann man durchaus darüber nachdenken, zielgerichtet mehr realitätsnahe und vor allem praxisrelevante Benchmarks herauszusuchen. Dabei tritt die Frage, wie häufig ein Anwendungs-Programm benutzt wird, etwas (nicht vollständig) in den Hintergrund – schon allein deswegen, weil ein ordentliches Benchmark-Set im CPU-Bereich eigentlich 20 Benchmarks aufwärts umfassen sollte, damit also immer ein Platz für den Cinebench existieren sollte. Eher Streichkandidaten aus unserer Sicht sind hierbei dann Benchmarks, welche für die Praxis keine Relevanz haben (vorbeschriebenes Einladen übergroßer Excel-Tabellen), wo die herauskommenden Unterschiede nur akademischer Natur sind (Benchmarks, die insgesamt nur noch Sekundenbruchteile benötigen) oder aber wo schlechte Programmierung ausgemessen wird (Benchmarks, die nicht mit mehr als zwei Threads skalieren können). Gute Benchmark-Sets im CPU-Bereich sollten sich demzufolge eher an folgenden Prämissen ausrichten:

- einheitliches Standard-Set aus Windows-, Office-, Browser- und ZIP-Benchmarks samt einzelner Profi-Tests

- bei HEDT/Workstation-Prozessoren zusätzlich noch mehr Profi-Tests

- Vorsicht vor einseitiger Tendenz der Benchmarks wegen zu vieler oder zu weniger Tests aus demselben Anwendungsbereich

- Vorsicht vor Benchmarks, die viele Einzelergebnisse und kein Gesamtergebnis produzieren – dies verfälscht durch eine unnatürliche Gewichtung den Gesamtschnitt (Adobe Suite)

- Ausschluß von Benchmarks, deren Ergebnisvarianz viel zu hoch ist, um systemübergreifend vergleichen zu können

- Ausschluß von kaum skalierenden Benchmarks, welche nicht die CPU, sondern das Gesamtsystem bewerten (PCMark)

- Ausschluß von Benchmarks, welche keine Kern-Skalierung oberhalb von 2 Kernen bieten (Ausnahme: Software von hohem Verbreitungsgrad)

- Tendenz logischerweise zugunsten von Software mit hohem Verbreitungsgrad – wobei diese Prämisse umso weniger wichtiger wird, je mehr es ins Profi-Segment hineingeht

- wichtiger als der Verbreitungsgrad ist allerdings die Realitätsnähe: Ist das, was gemessen wird, auch wirklich praxisrelevant?

- daher Ausschluß von Benchmarks, deren Performance-Differenzen in der Praxis keine realen Auswirkungen ergeben

- insgesamt nicht unter 10 Benchmarks, eher in Richtung 20 Benchmarks (Pflicht bei HEDT/Workstation-Prozessoren)

- Index-Bildung nicht vergessen – weil sowohl der Schnitt aller Messungen wichtig ist, als auch die Einzel-Benchmarks teilweise falsche Tendenzen gegenüber dem Gesamtbild suggerieren können

- die Index-Bildung darf nicht die Ergebnisse von reinen Singlecore/Singlethread-Tests sowie von Theorie-Benchmarks, welche nur einzelne Funktionseinheiten ausmessen (Sandra), beinhalten

Die ebenfalls von Intel angeschnittene Frage der zu den jeweiligen CPU-Klassen (Ultramobile, Mobile, Desktop, HEDT) jeweils passenden Benchmarks beantwortet sich damit ganz automatisch: Ein gutes Benchmark-Set besteht für jeden Prozessor aus typischen Anwendungs-Benchmarks, eingemixt sicherlich der eine oder andere semi-professionelle Test, aber zuerst mit Augenmerk auf Windows-, Office-, Browser- und ZIP-Performance. Dies kann man auch Ultramobile-Prozessoren zumuten, selbst wenn jene dabei logischerweise nicht überragend abschneiden werden – ist aber allein zum Erlangen von durchgehenden Vergleichswerten über viele CPU-Klassen hinweg notwendig. Für Tests von HEDT- und Workstation-Prozessoren wäre dann das Benchmark-Feld auf die entsprechende Profi-Software zu erweitern, wobei die vorgenannten Standard-Tests trotzdem ausgeführt werden sollten – eben wegen der Vergleichswerte. Dies wird von gutklassigen Hardwaretests eigentlich bereits heutzutage derart durchgeführt, insbesondere im deutschsprachigen Raum.

Beherzigt man dabei eine gute Größe der Benchmark-Auswahl, spielen einzelne Tests, welche in die eine oder andere Richtung neigen, in der Gesamtrechnung keine übergewichtige Rolle mehr – sondern sind sogar willkommen, um Stärken und Schwächen der jeweiligen CPU-Ansätze klarer herauszustellen. Der relevante Punkt hierbei ist es, auf ein ausgewogenes Testfeld zu achten, in welchem keine Benchmark-Klasse dominiert – und sei es dadurch, das diverse Benchmarks sehr viele Einzelergebnisse und kein Insgeamt-Ergebnis auswerfen und sich somit optisch mehr Platz einnehmen, als jenen eigentlich zusteht. Das ideale Benchmark-Set kommt mit einer für jeder Benchmark-Klasse bewußt ausgewählten Anzahl an Tests daher, um damit ein möglichst breites Benchmark-Spektrum abzubilden, sowohl einzelne Ausreißer verdauen zu können als auch keinem Einzel-Benchmark und keiner Benchmark-Klasse übermäßig Bedeutung einzuräumen. Man kann natürlich auch einfach nur mit besonders vielen Benchmarks in den Ring steigen, bei 20 Tests aufwärts relativieren sich Einzelergebnisse sehr zuverlässig im Durchschnitt aller Ergebnisse.

Verwandte News

- Umfrage-Auswertung: Wieviele Rechenkerne hat der eingesetzte Prozessor (2024)?

- Neuer Artikel: Die Systemanforderungen für die Spiele-Generation 2023/24

- Die Marktanteile für x86-Prozessoren im zweiten Quartal 2024

- Die Marktanteile für x86-Prozessoren im ersten Quartal 2024

- Umfrage-Auswertung: Wie interessant sind APUs tatsächlich?

- Chinesische Regierungs-Computer zukünftig ohne AMD, Intel & Microsoft

- Umfrage-Auswertung: Welche neue Hardware wird im Jahr 2024 am meisten erwartet?

- Die Marktanteile für x86-Prozessoren im vierten Quartal 2023

- Neuer Artikel: Das Hardware-Jahr 2024 in der Vorschau

- Die Prozessoren-Verkaufszahlen bei Amazon USA im November 2023