Launch-Analyse: nVidia GeForce GTX 680

Hauptlinks

Suchen

Launch-Analyse: nVidia GeForce GTX 680 (Nachträge)

Nachtrag vom 1. April 2012

Wie bei jeder HighEnd-Grafikkarte interessiert natürlich auch bei der GeForce GTX 680 das Thema der Übertaktungseignung – ergo haben wir aus den Artikeln der letzten zwei Wochen die entsprechenden Übertaktungsergebnisse extrahiert. Dabei scheint die Übertaktung der GeForce GTX 680 durch das Wirken von GPU Boost komplizierter zu sein als üblich – in der Praxis ist es dies aber nicht, da GPU Boost unauffällig im Hintergrund arbeitet und man einfach nur die default-Taktrate ("Base Clock") der GeForce GTX 680 anheben muß, bis sich eben Artefakte einstellen. Daß die Karte dann im Spieleeinsatz teilweise (oder meistens) wegen GPU Boost überhalb des Base Clocks operiert, ist vollkommen normal und schließlich auch ohne Übertaktung der Fall.

Zur Ausgangslage: Die GeForce GTX 680 als die größte Grafikkarten-Variante basierend auf dem GK104-Chip taktet per default mit 1006/3000 MHz, wobei der Chiptakt dynamisch per GPU Boost nach oben oder unten gesetzt wird, immer ausgerichtet an der regulären TDP von 195 Watt. nVidia "garantiert" dabei eine Boost-Taktrate von 1058 MHz, in der Praxis wurden aber eher Boost-Taktraten von 70 bis 110 MHz Aufschlag auf den default-Takt festgestellt. Die Chipspannung wird ebenfalls dynamisch von GPU Boost geregelt und liegt beim Base Clock auf nur 0,987V, geht im Boost-Modus ohne Übertaktung durch den Anwender bis auf 1,15V hinauf, mit Übertaktung bis auf 1,17V. Weiterführende Möglichkeiten zur Spannungsanhebung sind derzeit noch nicht verfügbar.

Alle Übertaktungen der GeForce GTX 680 wurden derzeit mit den Tools EVGA Precision, Asus GPU Tweak oder MSI Afterburner durchgeführt, welche sich im Funktionsumfang (bezüglich des Übertaktens) ungefähr gleichen. So ist eine maximale Chipübertaktung um 549 MHz und eine maximale Speicherübertaktung um 1000 MHz vorgesehen, was aufgrund der hohen Grenzwerte derzeit keinerlei limitierenden Einfluß hat. Zum Übertakten der GeForce GTX 680 muß jedoch in erster Linie die Option "Power Target" auf ihr Maximum von +32% gebracht werden: Damit wird das TDP-Limit der Karte entsprechend angehoben und etwaige Übertaktungen nicht (durch GPU Boost) wegen der originalen TDP-Grenze von 195 Watt heruntergeregelt.

| Overclocking-Ergebnisse der GeForce GTX 680 (default = 1006/3000 MHz) | |||

|---|---|---|---|

| PC Games Hardware | 1180/3557 MHz (nVidia-Referenz) | Hartware | 1130/3556 MHz (Zotac GTX680) |

| Hardwareluxx | 1183/3276 MHz (nVidia-Referenz) | OCaholic | 1206/3304 MHz (Asus GTX680) |

| ComputerBase | 1153/3506 MHz (nVidia-Referenz) | VR-Zone | 1137/3600 MHz (Asus GTX680) |

| Hardware Canucks | 1153/3528 MHz (nVidia-Referenz) | Fudzilla | 1139/3544 MHz (Gainward GTX680) |

| Hot Hardware | 1189/- MHz (nVidia-Referenz) | ||

| TechPowerUp | 1159/3566 MHz (nVidia-Referenz) | ||

| BSN | 1212/- MHz (nVidia-Referenz) | ||

| Hardware.fr | 1106/3600 MHz (nVidia-Referenz) | Neoseeker | 1177/3285 MHz (nVidia-Referenz) |

| Guru3D | 1264/3317 MHz (nVidia-Referenz) | Legit Reviews | 1171/3160 MHz (nVidia-Referenz) |

| Overclock3D | 1215/3055 MHz (nVidia-Referenz) | Overclockers Club | 1186/3254 MHz (nVidia-Referenz) |

| PC Perspective | 1156/- MHz (nVidia-Referenz) | X-bit Labs | 1186/3564 MHz (nVidia-Referenz) |

Das durchschnittliche Übertaktungsergebnis der GeForce GTX 680 ohne (manueller) Spannungszugabe und bezogen auf den Base Clock liegt damit bei 1173/3417 MHz, was +17 Prozent beim Chiptakt und +14 Prozent beim Speichertakt bedeuten. Dies ergibt eine vernünftige Übertaktung der GeForce GTX 680 mit einem Performance-Potential von knapp unter 15 Prozent Performanceplus. Der große Übertakter ist die GeForce GTX 680 damit natürlich nicht – aber dies ist aufgrund des sowieso schon hochgeprügelten Designs auch nicht zu erwarten gewesen.

Zudem bliebe abzuwarten, wie sich die Sache nach echten Spannungsmodifikationen und einem eventuell noch höherem "Power Target" Limit gestaltet – erst dann wird der GK104-Chip zeigen können, was wirklich in ihm steckt. Zudem muß derzeit ebenfalls noch die Frage offenbleiben, inwiefern GPU Boost einen maximalen Übertaktungserfolg verhindert. Unter Umständen kann es für HighEnd-Übertaktungen sinnvoller sein, alle Boost-Taktstufen zu deaktivieren (wofür natürlich erst einmal ein entsprechendes Tool geschrieben werden müsste) und dann ganz konventiell hochzutakten. All dies wird sich im Laufe der Zeit sicherlich ergeben, dafür müssen nur genügend GeForce GTX 680 Karten in Umlauf und damit zu den echten Enthusiasten und Hardcore-Übertaktern gelangen.

Nachtrag vom 19. April 2012

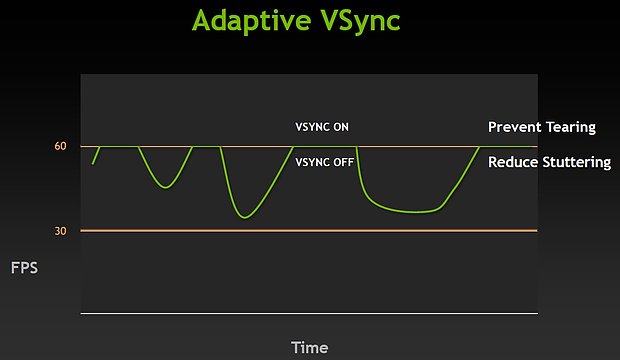

HardOCP haben sich in einem Artikel speziell mit nVidias "Adaptive VSync Technology" beschäftigt und werfen damit dieses beim Launch der GeForce GTX 680 vielleicht etwas zu kurz geratene Thema erneut auf. Mittels Adaptive VSync wird schlicht die Vsync-Funktionalität dynamisch deaktiviert, sobald sowieso keine Frameraten in der Nähe des Vsync-Limits (in aller Regel 60 fps) erreicht werden. Erreichen die Frameraten dagegen das Vsync-Limit, wird Vsync automatisch wieder aktiv, so daß das obligatorische Tearing (auf dem Monitor werden gleichzeitig versetzte Teile von zwei Frames ausgegeben, man sieht also irgendwo einen leichten "Bruch" im Bild) vermieden wird.

Vsync ist im Spiele-Alltag ein generell sinnvolles Features und wird gewöhnlich nur zum Benchmarken deaktiviert, da man natürlich nicht die Vsync-Marke des jeweils eingesetzten Monitors testen will, sondern die Leistungsfähigkeit der Grafikkarte. In der Praxis ergibt sich allerdings das Problem mit "springenden" Frameraten unter dem Einsatz von Vsync: Denn Vsync kann systembedingt nicht die exakte von der Grafikkarte erzeugte Framerate ausgeben, sondern nur gewisse Frameraten-Werte, welche auf ganzzahligen Teilern der Refreshrate basieren – bei 60 Hertz sind demzufolge real angezeigte Frameraten von 12, 15, 20, 30, 60 fps möglich (Hintergrund-Artikel Vsync). Dies kann allerdings insbesondere bei den größeren Sprüngen – wie von 30 fps auf 60 fps – dem geübten Auge unangenehm als Stuttering-Effekt auffallen.

Daneben vernichtet Vsync auch noch gehörig an erzeugter Framerate: In einem Beispiel haben HardOCP ohne Vsync – also unter Benchmark-Bedingungen – 48,7 fps ausgemessen, derselbe Test mit Vsync ergab allerdings nur 33,5 fps. Hier wurde augenscheinlich sehr oft die von der Grafikkarte erzeugte Framerate zwischen 30 und 60 fps durch Vsync weggekappt auf nur noch 30 fps, die dann letztlich auf dem Monitor ankamen. Weil es diese wenig beachtete Nebenproblematik so gut demonstriert, erlauben wir uns ausnahmesweise einmal die Kopie eines der Benchmark-Diagramme von HardOCP:

nVidias Adaptive VSync kann diesen beiden Problemen wie gesagt hervorragend entgegenwirken: Zum einen ist Vsync dort aktiv, wo es wegen des störenden Tearings interessant ist und verhindert damit dieses. Dafür ist Vsync dann dort, wo es die Framerate behindert, inaktiv und sorgt somit sogar für real höhere Frameraten: Im Beispiel von HardOCP gab es mit Vsync wie gesagt 33,5 fps und ohne Vsync waren es 48,7 fps – mit Adaptive VSync waren es 47,2 fps, was nahezu dem Wert von ohne Vsync entspricht.

Hier wurden also zwei Fliegen mit einer Klappe geschlagen – eine hervorragende Arbeit seitens nVidia, noch dazu wo dieses Feature mit den letzten 301er Treibern auch für frühere nVidia-Grafikkarten zur Verfügung steht. Normalerweise müssten die AMD-Treiberingenieure derzeit Überstunden ohne Ende abreißen, bis AMD etwas ähnliches präsentieren kann. Natürlich ist es subjektiv, ob man dieses Feature schätzt oder nicht (womit das Thema der nächsten Umfrage gefunden wäre) – aber wenn man dieses Feature als nutzvoll anerkennt, dann ist dies ein heftiger Pluspunkt zugunsten von nVidia in der ewigen Streitfrage AMD vs. nVidia. An diesem Punkt kann der eiserne AMD-User sogar wirklich ins Grübeln geraten – um so dringender sollte sich AMD diesem Thema widmen.

Nachtrag vom 21. April 2012

Die vorstehende Meldung hat einen entscheidenden Fehler – sie geht nicht auf TripleBuffering ein. Mittels TripleBuffering geht man das Problem der springenden bzw. niedrigeren Frameraten unter aktiven Vsync ebenfalls an, einziger Nachteil ist ein zusätzlicher Inputlag, da die Grafikkarte nun schließlich immer ein weiteres fertiges Bild vorhalten muß, ehe dies am Monitor ausgegeben wird. Bisher war TripleBuffering allerdings immer nur eine Behelfsmöglichkeit, da es die wenigsten Spiele direkt unterstützen. nVidia hat dies allerdings schon vor einiger Zeit geändert und forciert nunmehr mittels des Treibers automatisch TripleBuffering. Dies funktioniert zwar nicht unter jedem Spiel, allerdings kann man bei den Problemfällen diese Funktionalität über diverse TweakTools dann doch noch aktivieren.

Letztere Möglichkeit funktioniert im übrigen auch für die AMD-User, selbst wenn der AMD-Treiber von Haus aus keine Forcierung von TripleBuffering unter DirectX zuläßt. Insofern ist die Diskussion zu dieser Meldung mehrheitlich auf dem Standpunkt, daß TripleBuffering eine völlig ausreichende bzw. sogar bessere Lösung für diese Problematik darstellt und Adaptive VSync im eigentlichen nicht benötigt werden würde. Allenfalls könnten AMD & nVidia es noch perfekt machen und TripleBuffering ohne jede Problemfälle oder/und notwendige Usereingriffe unter wirklich jedem Spiel erzwingbar machen. So gesehen erscheint Adaptive VSync allerhöchstens als weitere Lösung für ein bestehendes Problem, der Anspruch der alleinigen Problemlösung entfällt allerdings. Abschließend greifen wir das Thema Adaptive VSync oder TripleBuffering auch noch mit einer Umfrage auf.

Nachtrag vom 8. Mai 2012

Im nachgereichten GeForce GTX 680 Testbericht von HT4U (dieser einen Monat nach Launch erschienene Artikel zeigt deutlich auf, wie gut eine Arbeit sein kann, wenn man sich dafür entsprechend Zeit nimmt) gibt es einen wunderbaren Abschnitt über das GPU-Boost-Feature der Kepler-Grafikchips. Dieser Abschnitt zeigt erst einmal auf, daß GPU-Boost ganz klar als Leistungsaufnahme-Limiter operiert und daß nVidia das "Power Target" bei der GeForce GTX 680 offensichtlich auf 170 Watt festgesetzt hat. Alle Boost-Taktraten und die dafür anliegenden Spannungen orientieren sich immer daran, jene 170 Watt nicht zu überschreiten. Gleichfalls versucht GPU Boost aber auch, durch automatisches Hochtakten jene 170 Watt zu erreichen, die GeForce GTX 680 läuft im Spieleeinsatz also durchgehend mit 170 Watt Verbrauch.

Für Benchmarks bringt GPU Boost allerdings neue Probleme mit sich – und damit ist nicht der Punkt gemeint, daß verschiedene Grafikkarten andere praktische Boost-Eigenschaften je nach Produktionsklasse des jeweils verbauten Grafikchips aufweisen können, was aber natürlich auch der Fall ist. Das eigentliche Benchmark-Problem ergibt sich aus dem Umstand, daß GPU-Boost auf die anliegenden Chiptemperaturen reagiert und daß damit der Taktraten-Boost nach längerem Gaming geringer ausfällt als direkt nach dem Start eines Spiels, wo der Grafikchip noch unbelastet und daher nicht auf Temperatur ist. Gebenchmarkt wird aber üblicherweise direkt nach dem Start eines Spiels – im eigentlichen reicht oftmals allein der (üblicherweise wenig belastende) Ladebildschirm aus, um den Grafikchip wieder herunterzukühlen und damit nachfolgend kurzfristig höhere Boost-Taktraten zu ermöglichen. HT4U haben diesen Punkt in einer einfachen Gegenüberstellung der Boost-Taktraten zum einen in den ersten 10 Sekunden eines Spiels und zum anderen nach ca. 3 Minuten Gaming aufgezeigt:

| Boost in den ersten 10 Sekunden | Boost nach zirka 3 Minuten | |

|---|---|---|

| EVGA GeForce GTX 680 | Ø 1098,4 MHz (+9,2%) | Ø 1073,4 MHz (+6,7%) |

| Zotac GeForce GTX 680 | Ø 1083,1 MHz (+7,7%) | Ø 1060,4 MHz (+5,4%) |

Wie bei beiden getesteten Herstellerkarten zu sehen, ist die real anliegende Taktrate im echten Spieleinsatz um 2,1 bis 2,3 Prozent höher als zu diesem Zeitpunkt, wo üblicherweise ein Benchmark abläuft. Dies bedeutet natürlich noch nicht direkt eine Verfälschung von Benchmark-Ergebnissen in dieser Höhe: Dies hängt dann maßgeblich davon ab, wie lange und wie fordernd ein Benchmark ist. Bringt ein Benchmark den Grafikchip möglichst umgehend auf Touren und läuft der Benchmark danach noch verhältnismäßig lange, kann der Effekt dann weitaus niedriger ausfallen. HT4U haben dies nachfolgend zu simulieren versucht und einfach die Benchmarks immer erst etwas später gestartet, sich das Spiel also vorher etwas "aufheizen" lassen. In der Summe aller Messungen mit Anti-Aliasing kam dabei eine Differenz von 0,9 Prozentpunkten heraus – viele Benchmarks reagierten dabei gar nicht, bei Reaktion lagen die normalen Differenzen im Rahmen von 1 bis 3 Prozent, mit einem Peak von immerhin 5,8 Prozent (Skyrim 2560x1440 8xAA).

Angesichts dieser geringen Differenz steht natürlich die Frage im Raum, ob man GPU-Boost wirklich als "Benchmark-Verfälschung" ansehen kann. Andererseits handelt es sich so oder so bei diesen 0,9 Prozent um eine Performance, welche im Spieleeinsatz nicht vorhanden ist – sondern eben nur unter Benchmarks und nur bei der GeForce GTX 680. Insofern ist dies egal der Höhe der Differenz immer eine gewisse Verfälschung – so daß man einen Prozentpunkt Performance bei der GeForce GTX 680 und zukünftig weiteren Kepler-basierten Grafikkarten immer herausrechnen sollte. Mittels einer Zunahme des Boost-Faktors beispielsweise bei der GeForce GTX 670 kann der Effekt zukünftig sogar größer ausfallen als eben nur auf einem Prozentpunkt. Mit der Differenz verschiedener GeForce GTX 680 Karten unter GPU Boost (die von HT4U getesteten Karten von EVGA und Zotac weichen wegen des unterschiedlich wirkenden GPU Boosts um 0,7% Endperformance voneinander ab) hat dies im übrigen nichts zu tun – dieser Effekt macht vergleichende Benchmarks zwar schwieriger, zeigt aber weiterhin ein Ergebnis auf, welches der Spielepraxis entspricht.

Allerdings muß angesichts dieser Erkenntnisse auch die Frage aufgestellt werden, ob AMDs PowerTune nicht vielleicht einen ganz ähnlichen Effekt aufweisen könnte. Denn auch PowerTune regelt schließlich den Grafikchip herunter, wenn gewisse Grenzwerte erreicht sind – und daß solche Grenzwerte unter der Dauerbelastung eines Spiels eher ereicht werden als kurz nach dem Ladebildschirm, trifft schließlich universal zu. Der bei nVidia zu beobachtende Effekt kann daher prinzipiell gesehen auch bei AMD auftreten, dies müsste man durch gleichartige Messungen (Benchmark nicht sofort starten, sondern sich das Spiel erst einmal "aufheizen" lassen) belegen oder eben wiederlegen. Ganz generell betrachtet macht es wohl Sinn, sich für zukünftige Grafikkarten-Tests eine Strategie zur optimalen Aufheizung der Grafikkarten vor dem eigenen Benchmark-Beginn zurecht zu legen: Ob mittels späteren Benchmark-Starts oder eines vor dem Benchmark laufenden zusätzlichen Belastungstests. Die Benchmark-Welt wird sich jedenfalls dem Fakt stellen müssen, daß zukünftig gerade kurze Benchmarks direkt nach Idle-Phasen eine gewisse Benchmark-Verfälschung mit sich bringen können und erst ein richtig aufgeheizter Grafikchip seine exakte Performance offenbart.