Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 6. November 2019

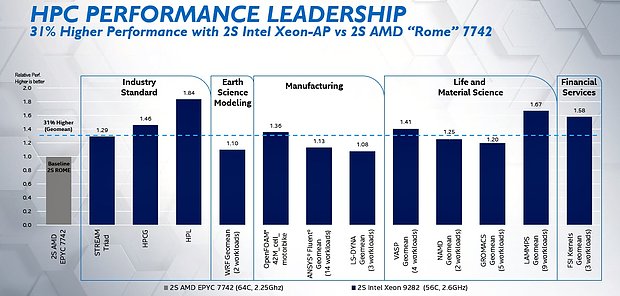

Die PC Games Hardware sowie Serve the Home berichten über aufkommende Kritik an Intel-Benchmarks, in welchen sich Intel sehr augenscheinlich gegenüber AMD-Prozessoren schön-gebencht hat. Ausgangspunkt ist ein Intel-Blogpost mit vergleichenden Benchmarks im Server-Bereich – wobei jener "Vergleich" mit 2x Xeon Platinum 9282 gegen 2x Epyc 7742 angetreten wurde und damit schon augenscheinlich Nonsens ist. Denn weder bei Preispunkt noch Wattage gibt es hierbei einen Ansatz zur Vergleichbarkeit dieser Paarung – allenfalls die Kern-Anzahl ist mit 112 zu 128 physikalischen CPU-Kernen ähnlich. Dies spielt allerdings im Server-Segment kaum eine Rolle, da interessieren Preispunkt (bei Intel unbekannt, aber augenscheinlich drastisch mehr als bei AMD) und Wattage, wobei Intel in letztgenannter Disziplin belegbar stark zurückliegt – 800 Watt gegen 450 Watt TDP (zugunsten von AMD). Im Endeffekt stellt Intel hierbei sein teures Sonder-Produkt "Cascade Lake AP" mit zwei Prozessoren-Dies auf einem Package (nur erhältlich als komplettes Compute-Modul) gegen einen regulären Epyc-Prozessor – damit kann man zwar technisch aufholen, erkauft sich dies aber über einen wesentlich höheren Preis samt nahezu der doppelten Verlustleistung.

Dies ist aus technischer Sicht durchaus interessant, weil es bedeutet, das Intel pro CPU-Kern (aber ohne Berücksichtigung der Verlustleistung) eine vergleichbare oder bessere CPU-Performance (im Server-Bereich) liefern kann. Aus wirtschaftlicher Sicht bringt der Vergleich aber natürlich nichts, weil niemand im Business-Bereich grob die dreifache Geldsumme samt grob den doppelten Energiekosten ausgibt, um in einem BestCase von durch Intel ausgesuchten Benchmarks +31% mehr Performance zu erzielen. Es gibt daneben sogar Kritik an dieser reinen Performance-Bewertung – jenen bezieht sich allerdings nur auf einen Teil-Benchmark und dürfte daher den Insgesamt-Wert kaum verändern können. Das Intel Kern-normiert deutlich vorn liegt, ist zwar gegenüber den bekannten Ergebnissen im Desktop-Umfeld etwas überraschend, dort haben die Prozessoren allerdigs auch ähnliche TDPs und kann Intel nicht plötzlich mit knapp der doppelten Verlustleistung daherkommen. Es ist daneben schade, das man diesen "Vergleich" gerade beim Preispunkt nicht besser quantifizieren kann, da Intel seine Cascade Lake AP Xeon-Modelle nicht in die offizielle Preisliste aufnimmt. Bezogen auf die regulären Cascade Lake SP Modelle kosten 112 CPU-Kerne bei Intel allerdings ca. 40'000 Dollar – während die 128 CPU-Kerne bei AMD mit ca. 14'000 Dollar zu haben sind.

Nicht ganz unpassend hierzu kommt von Tom's Hardware ein feiner Artikel zur Frage, wer die sichersten CPUs herstellt – AMD oder Intel? Hierzu hat man sich nicht nur (eingehend) mit der Frage der verschiedenen CPU-Lücken von Meltdown bis MDS beschäftigt, sondern auch weitere Punkte mit einfließen lassen. Das ganze ist also durchaus eine General-Abrechnung in der Frage der Sicherheit aktueller x86-Prozessoren, wobei die abschließende Tabelle (nachfolgend übersetzt wiedergegeben) durchaus allen Einkäufern von Office- und Server-PCs direkt an die Stirn getackert werden sollte. Dass AMD basierend auf dieser Ausgangslage nicht wirtschaftlich deutlich mehr von Meltdown, Spectre & Co. hat profitieren können, wird man rückblickend wohl mal als großes Mysterium ansehen – denn wäre AMD so etwas passiert, würde das Unternehmen wahrscheinlich schon in der Pleite stecken. Für den Desktop-Käufer ist die Relevanz des ganzen natürlich nicht ganz so hoch, möglicherweise liegt hier auch die Grund dafür, dass dies so geringe geschäftliche Auswirkungen hatte – das Skandalisierungs-Potential ist halt deutlich geringer, wenn es in erster Linie "nur" professionelle Anwender trifft. Natürlich kann man sich auch privat fragen, wieso man die ganzen Sicherheitslücken auf Intel-CPUs (inklusive eventuell noch kommender Nachzügler) wirklich erdulden muß, wenn ein Gegenangebot mit (mindestens) gleichwertiger Performance & Preislagen existiert.

| Wer stellt die sichersten CPUs her? | Intel | AMD |

|---|---|---|

| (kleinerer) Angriffs-Winkel | ✓ | |

| (geringerer) Performance-Einfluß der Patches | ✓ | |

| (mehr) Hardware-Absicherungen | ✓ | |

| (weniger) andere CPU-Sicherheitsprobleme | ✓ | ✓ |

| bessere Sicherheits-Features | ✓ | |

| insgesamt | 1 Pluspunkt | 5 Pluspunkte |

| direkt übersetzt von Tom's Hardware | ||

Die über die koreanische Webseite Quasarzone verbreiteten (und von dort vielzitierten) angeblichen Produkt-Spezifikationen & Händlerpreise zum Ryzen Threadripper 3960X & 3970X basieren augenscheinlich auf Platzhalter- bzw. Fantasie-Daten, sind daher also nicht ernstzunehmen. Original stammen diese Daten von Händlerlistungen aus Südafrika, sind dort aber inzwischen schon nicht mehr verfügbar. Klar wird der Fanatasie-Gehalt der Daten u.a. an den für beide Prozessoren genanntem Level2-Cache von jeweils 32 MB – was nicht möglich ist, denn der Level2-Cache richtet sich immer nach der Anzahl der aktiven CPU-Kerne und liegt daher bei einem 24-Kerner von Zen 2 bei 12 MB sowie bei einem 32-Kernen dann bei 16 MB. Insofern kann man leider auch die gemeldeten Taktraten von 3.5/4.7 GHz für den Threadripper 3960X sowie 3.0/4.2 für den Threadripper 3970X derzeit noch nicht ernst nehmen – wobei dies für den 24-Kerner wohl auch ein wenig zu viel wäre, dies entspräche den Taktraten des Ryzen 9 3950X. Die Threadripper-Garde hat zwar mehr TDP zur Verfügung, dürfte aber dennoch Schwierigkeiten haben, ganz hohe Taktraten zu erreichen – vielleicht nominell, aber in der Praxis dann eher nicht. Vermutlich gilt es aber schon im Laufe des 7. November offizielle Daten hierzu – die Launchreviews mit Performance-, Takt- und Overclocking-Messungen wie bekannt aber erst am 25. November.

Von ComputerBase, GameGPU und TechPowerUp kommen Grafikkarten-Benchmarks zu "The Outer World", dem durchaus an die Fallout-Serie angelehnten Action-RPG von "Obsidian Entertainment". Dessen offizielle Systemanforderungen sind noch vergleichsweise harmlos, die Realität sieht dann deutlich anders aus: Das Spiel verfrühstückt Hardware insbesondere mit steigenden Auflösungen und mit dem höchsten Bildqualitäts-Preset "Ultra". Die offiziellen Systemanforderungen gelten offenbar nur für das dritthöchste Bildqualitäts-Preset "Hoch" auf ca. 40-50 fps – dann ist man wirklich mit einer Radeon RX 470 dabei (alternativ auch einer Radeon R9 290), wobei die hierzu offiziell ebenfalls genannte GeForce 1060 6GB auch durch GeForce GTX 1060 3GB oder die viel kleineren GeForce GTX 960 4GB samt GeForce GTX 1650 ersetzt werden können. Grundlage hierfür ist der Punkt, das nVidia-Hardware in dem Spiel gravierend besser wegkommt – beispielsweise schafft eine GeForce RTX 2060 Super noch das "Ultra"-Preset unter WQHD auf 60 fps, die regulär schnelleren Radeon VII und Radeon RX 5700 XT hingegen nicht mehr.

| Grafikkarten-Empfehlung für "The Outer Worlds" | ||

|---|---|---|

| "Hoch"-Preset @ 40 fps | "Ultra"-Preset @ 60 fps | |

| FullHD | ab GeForce GTX 960 4GB, GeForce GTX 1060 3GB, GeForce GTX 1650 oder Radeon R9 290, Radeon RX 470 | ab GeForce GTX 980 Ti, GeForce GTX 1070, GeForce GTX 1660 Super oder Radeon RX Vega 64, Radeon RX 5700 |

| WQHD | ab GeForce GTX 970, GeForce GTX 1060 3GB, GeForce GTX 1660, oder Radeon R9 Fury X, Radeon RX 590 | ab GeForce GTX 1080 Ti, GeForce RTX 2060 Super |

| UltraHD | ab GeForce GTX 1070 Ti, GeForce RTX 2060 oder Radeon VII, Radeon RX 5700 XT | GeForce RTX 2080 Ti @ ca. 50 fps |

| interpoliert gemäß der Benchmarks von ComputerBase, GameGPU und TechPowerUp | ||

Alternativ kann man es auch gut an der (eigenen) Grafikkarten-Empfehlung für FullHD auf "Ultra" mit 60 fps sehen: Für nVidia stehen hierbei GeForce GTX 980 Ti (Perf.Index 750%), GeForce GTX 1070 (Perf.Index 780%) oder GeForce GTX 1660 Super (Perf.Index 770%) an, für AMD allerdings die viel potenteren Radeon RX Vega 64 (Perf.Index 930%) oder Radeon RX 5700 (Perf.Index 980%) – dies ergibt gut ein Viertel mehr Nominal-Power, welche man auf AMD-Seite investieren muß. Dafür scheinen wenigstens die Grafikkartenspeicher-Anforderungen nicht übermäßig, da laut den TechPowerUp-Tests die GeForce GTX 1060 3GB noch bis zur WQHD-Auflösung gut mitkommt – unter UltraHD fehlt der Karte dann die Rechenpower, um den Speicher-Unterschied zur 6-GB-Ausführung sinnvoll bewerten zu können. Alles in allem ist das Spiel aus technischer Sicht augenscheinlich ziemlich unoptimiert, wenn AMD-Grafikkarten so schnell die Puste ausgeht und die Auflösungs-Skalierung derart krass ausfällt. Da stand bei dieser Mittelklasse-Entwicklung wohl kein Geld für diese Aufgabe zur Verfügung – was letztlich aber sogar verzeihlich ist, wenn der Titel zuerst spielerisch zu überzeugen weiß und der Hardware-Ansatz nicht gerade so hoch ausfällt, das überhaupt keine heute verfügbare Hardware mehr mitkommen könnte (was nicht der Fall ist).