Hauptlinks

Suchen

News des 12. Juni 2025

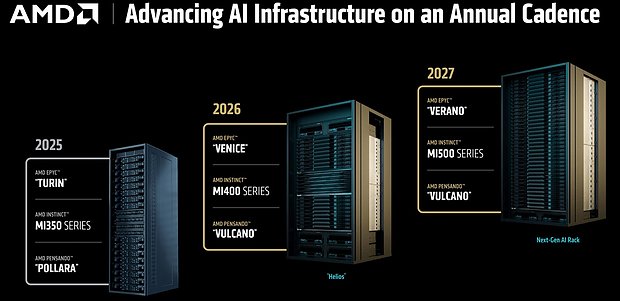

AMD hat auf seinem "Advancing AI 2025" Event (anzuschauen auf YouTube) einen umfangreichen Ausblick auf kommende HPC/AI-Gerätschaften geliefert, darunter interessanterweise auch eine indirekte Nennung von "Zen 7" im Jahr 2027. So enthält eine der gezeigten Roadmaps die Codenamen der jeweiligen Server-Varianten der Zen-Iterationen: "Turin" gehört zu "Zen 5", "Venice" bekannterweise zu "Zen 6" und "Verano" allerhöchstwahrscheinlich zu "Zen 7". Dabei könnte hier sogar noch ein Schreibfehler mit im Spiel sein, die vorherige Gerüchteküche sprach in dieser Frage eher von "Verona" – wobei beide Codenamen italienische Städte ergeben, somit beide nominell passen würden. Die zugrundeliegende Architektur "Zen 7" erwähnt AMD zwar nirgendwo, allerdings ist es augenscheinlich, dass hiermit eben bereits der Zen6-Nachfolger gemeint ist. Jenen ordnet AMD somit schon für das Jahr 2027 ein – was etwas früher als bislang erwartet ist, aber natürlich auch nur eher grob gemeint sein muß.

Eine Aussage, wann diese Server-Prozessoren konkret zur Verfügung stehen und vor allem, wann auf Zen 7 basierende Consumer-Prozessoren im Markt antreten werden, ist dies schließlich nicht. Leider hat AMD seit einiger Zeit aufgegeben, langfristige Roadmaps zur Verfügung zu stellen, so dass dies alles nunmehr das (irrbare) Werk der Gerüchteküche ist. Daneben erwähnt eine weitere AMD-Folie "Venice" mit der 1,7fachen Performance zum Vorgänger "Turin". Wie von HXL @ X richtig angemerkt, handelt es sich hierbei aber natürlich um den Vergleich von 192 CPU-Kerne von Zen 5 gegen 256 CPU-Kerne von Zen 6, +33% des Performancegewinns gehen allein auf diese Kappe. Übrig bleiben ca. +28%, welche man grob über +15% mehr IPC samt +10% mehr Taktrate erreichen könnte (oder andere Kombinationen dieser beiden Effekte). Eine belastbare Aussage zum Performance-Gewinn von Zen 6 für Consumer-Prozessoren ist hieraus genauso wenig abzuleiten – schon allein deswegen, weil im Consumer-Segment die teilweise perfekt skalierenden Benchmarks des Server-Segments keine Relevanz haben. Update: Zur Frage des Zen-7-Termins beachte man bitte unbedingt die Korrektur zu dieser Meldung vom nächsten Tag.

Die PC Games Hardware hat sich mit dem reinen Architektur-Gewinn zwischen RDNA3 & RDNA4 anhand des Vergleichs Radeon RX 7600 XT vs Radeon RX 9060 XT 16GB beschäftigt. Jene Karten sind für diesen Vergleich ideal, da dieselbe Grund-Hardware vorhanden ist und somit nur die Taktraten-Differenz überbrückt werden muß. Die PCGH hat beide Karten auf 3 GHz laufen lassen, der Speichertakt ist auch nahezu identisch, womit die Rohleistungen prinzipiell gleich ausfallen. Damit kommt die RDNA4-Karte unter FullHD Raster-Rendering schon auf +16,6% Mehrperformance, unter RayTracing sind es sogar +47,8%. In beiden Fällen hat RDNA4 also richtig gut zugelegt, wobei die verbesserte Raster-Performance nunmehr dazu führt, dass man Shader-Cluster-normiert nahezu genauso schnell wie nVidia ist. Bei RayTracing liegt man bekannterweise noch etwas zurück, aber die Differenz ist verkraftbar klein: Die Radeon RX 9060 XT 16GB liegt gemäß deren Launch-Analyse unter FullHD RayTracing gegenüber der GeForce RTX 5060 Ti 16GB mit –11,8% zurück, wo es unter Raster-Rendering –3,7% sind, die relative Differenz der Ergebnisse von Raster- zu RayTracing-Performance steht also bei nur ca. 8%.

| Technik | Raster FHD | RayTr. FHD | |

|---|---|---|---|

| Radeon RX 9060 XT 16GB @ 3 GHz | RDNA4, 32 CU @ 128-bit, 32MB IF$, 25.6 TFlops & ~320 GB/sec | 116,6% | 147,8% |

| Radeon RX 7600 XT @ 3 GHz | RDNA3, 32 CU @ 128-bit, 32MB IF$, 25.6 TFlops & ~310 GB/sec | 100% | 100% |

| gemäß den Benchmarks der PC Games Hardware unter 5 Raster- und 6 RayTracing-Tests | |||

Wenn man hier mit einrechnet, dass speziell Radeon RX 9060 XT 16GB und Radeon RX 9070 dies alles zu einer vollkommen mit nVidia vergleichbaren Energieeffizienz liefern (die Radeon RX 9070 XT fällt diesbezüglich etwas ab, weil TDP-mäßig doch sehr nach oben gezogen), ist es nochmals mehr schade, dass AMD für diese Generation keine größeren Grafikchips als Navi 48 angesetzt hat. Ironischerweise hat man ausgerechnet in der RDNA4-Generation nunmehr das gelöst, was bislang die Problemfelder von AMD bei ganz großen Grafikchips waren: Shader-Cluster-normiert selbe Performance und gleichwertige Energieeffizienz. Liegt man hier daneben, ist dies bei kleineren Grafikchips nur ein gewisser Nachteil, größere Grafikchips müssten hingegen zu groß und zu stromfressend werden, um mit der nVidia-Konkurrenz mithalten zu können. RDNA4 hat diese früheren AMD-Nachteile nun nicht mehr – und demzufolge wären hypothetische größere RDNA4-Chips denkbarerweise in der Lage, mit nVidias GB203 & GB202 mitzuhalten. Allerdings wird niemand mehr nachträglich größere RDNA4-Chips auflegen, dafür sind die Vorlaufzeiten zu lang und richtet sich der Blick der Grafikchip-Entwickler dann eher schon auf die nächste Chip-Generation.

Die ComputerBase berichtet über weiterhin stark steigende Wafer-Preise für zukünftige TSMC-Nodes beim taiwanesischen Auftragsfertiger: Während derzeit für die 5nm-Fertigung eine Preislage von 17'000 Dollar pro Wafer existieren soll, sollen es für 2nm-Chips dann 30'000 Dollar und für A14-Chips sogar 45'000 Dollar pro Wafer sein. Dies sind natürlich nur Voraussagen von Analysten, gleichfalls hat TSMC allerdings in der Tat die Tendenz, seine neuesten Fertigungsverfahren anfänglich sehr teuer anzusetzen. Was hier häufig nicht bedacht wird ist der Punkt, dass TSMC später auch die Preise senkt, wenn die Anfangsphase einer neuen Fertigung durch ist (aka ausreichend Kapazität aufgebaut wurde) und dann noch viel mehr, wenn an der technologischen Spitze ein neuer Node übernimmt. Selbiger Effekt gilt auch für die durchschnittlichen Design-Kosten, welche für einen 3nm-Chip dann eine Milliarde Dollar erreichen sollen. Auch dies dürfte (in ganz starkem Maßstab) nur anfänglich gelten, was dann aber nur noch selten kommuniziert wird.

Dennoch gilt: Die allerneuesten Fertigungen sind nur etwas für wirklich margenstarke Chips – was die meisten Consumer-Produkte außen vor läßt, Apples iPhone-SoCs ausgenommen. Im PC-Bereich dürfte man sich wohl ober übel daran gewöhnen, dass es zukünftig normal ist, nur noch die zweitbeste verfügbare TSMC-Fertigung abzubekommen. Dies wird gerade bei Zen 6 dann sehr augenscheinlich: Die Server-CCDs kommen unter der 2nm-Fertigung daher (mehrfach bestätigt durch AMD), die Consumer-CCDs aber wahrscheinlich nur unter der 3nm-Fertigung (noch nicht bestätigt). Aber auch bei der aktuellen PC-Hardware ist ja schon zu sehen, dass nichts auf eine bessere TSMC-Fertigung als N4 setzt – und dies obwohl die 3nm-Fertigung bei TSMC bereits seit einiger Zeit läuft und auch für die aktuelle iPhone-Generation zum Einsatz kommt. Der Schritt zurück auf die zweitbeste TSMC-Fertigung für Consumer-Hardware hat wenigstens den Vorteil, dass die Intel-Fertigung derzeit noch mitkommen kann bzw. dass Samsung seine Außenseiter-Chance behält. Würde Consumer-Hardware ebenfalls auf die jeweils beste TSMC-Fertigung gehen, wären Intel & Samsung hingegen chancenlos – wobei sich aus dieser Ausgangslage auch perfekt die (stark) hochgehende Preise für die zukünftigen TSMC-Nodes erklären lassen.

Shortcuts: WCCF Tech berichten über einen (angeblichen) kleinen Performance-Unterschied (von 1-2%) der Radeon RX 9070 XT unter Verwendung von Samsungs GDDR6-Speicher – und damit nicht dem ansonsten üblicherweise verbauten GDDR6-Speicher von SK Hynix. Die Basis dessen sind allerdings nur 3DMark-Tests von in Nutzerhand befindlichen Karten, sprich da bleibt die Chance offen auf Einflüsse von Werksübertaktungen. Wenn, dann müsste man dies auf demselben System mit gleichgetakteten Karten unter echten Spiele-Benchmarks nachstellen – was sicherlich noch passieren wird, sollten sich das ganze bestätigen. VideoCardz haben bei der PCI-SIG eine Arc B-Serien Grafikkarte mit dem vollen PCIe-Interface von 16 Lanes entdeckt. Da Arc B570 & B580 Chip-bedingt nur 8 Lanes bieten, sollte dies normalerweise ein weiterer Hinweis auf einen anderen Battlemage-Grafikchip sein – anzunehmenderweise den größeren BMG-G31. Wenn selbiger nunmehr schon bei der PCI-SIG eingetragen wird, kann dessen Release nicht mehr Ewigkeiten entfernt liegen, eventuell wird es ja im dritten Quartal wirklich etwas mit der Arc B700 Serie.