Hauptlinks

Suchen

News des 26. August 2025

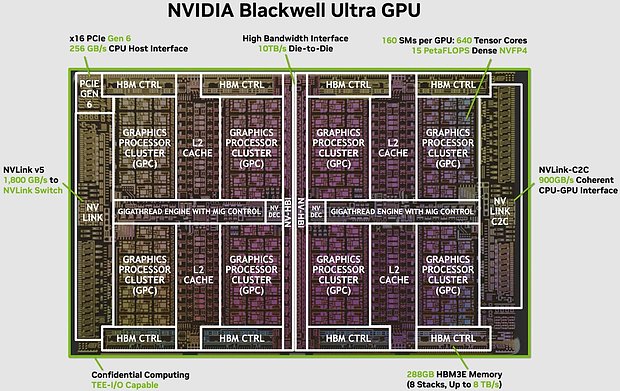

Viele Berichte widmen sich "Blackwell Ultra", der neuen HPC/AI-Lösung von nVidia, welche im Rahmen der "Hot Chips 2025" Konferenz genauer betrachtet wurde bzw. zu welcher nVidia in einem eigenen Blog-Eintrag einiges zu sagen hatte. Beim Thema selber gibt es allerdings kaum größere Veränderungen: Blackwell Ultra basiert auch weiterhin auf dem bekannten GB100-Chip, welcher nun einfach mehr Speicher mitbekommt und bei welchem PCI Express 6.0 sowie ein paar weitere Shader-Cluster freigeschaltet wurden. Einen wirklich neuen Chip hat nVidia hingegen nicht aufgelegt, Blackwell Ultra ist in dieser Frage ein klassischer Refresh bestehend auf vorhandener Chipbasis. Mit dabei waren bei nVidias Ausführungen aber auch erstmals genauere Angaben zur Leistungsfähigkeit und zu den Hardware-Innereien – etwas, was zur Vorstellung des originalen "Blackwell" AI-Chips im letzten März noch absolute Mangelware war. So bestätigen sich die seinerzeit schon in der Gerüchteküche genannten 160 Shader-Cluster (SM) für den Doppelchip (ergibt im übrigen 20'480 FP32-Einheiten). Ob dies der absolute Vollausbau ist, bleibt vorerst offen, wäre aber zumindest nicht undenkbar.

Vor allem aber wird nun endlich (indirekt über Blockschaltbild und weitere Ausführungen) bestätigt, dass die von nVidia genannten Angaben sich durchgehend auf den Doppelchip (inoffiziell "GB100") beziehen, nicht jedoch auf den Einzelchip (laut Gerüchteküche "GB102") oder die bekannten GB200-Produkte mit gleich zwei dieser Doppelchips. Das ganze ist aufgrund des großen Mischmaschs der Begriffe "Chip", "GPU" und "Produkt" fürwahr nicht einfach zu erfassen: Eigentlich sind nur GB102 & GB100 tatsächliche Chips, der Rest sind darauf basierende Produkte. nVidia verwendet dann den Begriff "GPU" immer für den Doppelchip "GB100" – sagt aber mittels Schaubildern und im Blogeintrag klar aus, dass die Server-Module "GB200" und "GB300" dann jeweils zwei dieser Doppelchips tragen (zuzüglich jeweils "Grace"-CPU und NVLink-Switch). Und dies bedeutet letztlich, dass sich für GB200 ("Blackwell Superchip") & GB300 ("Blackwell Ultra Superchip") die Hardware- und Performance-Angaben jeweils verdoppeln. Weil die Sache allerdings wirklich verwirrend ist, liefern viele Beobachter an dieser Stelle nur die einfachen, nicht verdoppelten Performance-Angaben: Sprich die Hardware- und Performance-Werte des Doppelchips GB100 in dessen Ultra-Variante – anstatt die Werte von GB300 mit zwei dieser Doppelchips.

| Chip | ➔ | Doppelchip | ➔ | Produkt | |

|---|---|---|---|---|---|

| Blackwell | GB102, 80 SM, 4096-bit HBM3e, 104 Mrd. Transistoren, ~800mm² Chipfläche | ➔ | GB100 (2x GB102), 160 SM, 8192-bit HBM3e, 208 Mrd. Transistoren, ~1600mm² Chipfläche | ➔ | GB200 (4x GB102), 288 SM, 16384-bit HBM3e, 416 Mrd. Transistoren, ~3200mm² Chipfläche (+ "Grace"-CPU & NVLink-Switch) |

| Blackwell Ultra | GB102, 80 SM, 4096-bit HBM3e, 104 Mrd. Transistoren, ~800mm² Chipfläche | ➔ | GB100U (2x GB102), 160 SM, 8192-bit HBM3e, 208 Mrd. Transistoren, ~1600mm² Chipfläche | ➔ | GB300 (4x GB102), 320 SM, 16384-bit HBM3e, 416 Mrd. Transistoren, ~3200mm² Chipfläche (+ "Grace"-CPU & NVLink-Switch) |

| nVidia-Naming | - | "one GPU" | "Superchip" |

nVidia selber hat es allerdings klar beschrieben: "Blackwell Ultra" (=GB200) macht 20 PetaFlops sparse NVFP4, während "Blackwell Ultra Superchip" (=GB300) dagegen 40 PetaFlops sparse NVFP4 liefert. In dieser Frage hat sich viele Berichterstattung im Netz in die Irre führen lassen, natürlich begünstigt dadurch, dass nVidia bislang extrem geizig mit exakten Angaben war und sich auch jetzt die Sache nur anhand von Indizien entblättert. Beispielsweise wird "GB300" nunmehr oftmals mit einer Transistorenmenge von 208 Mrd. sowie 160 Shader-Clustern beschrieben – was jedoch die Daten des zugrundeliegenden GB100-Chips sind, wovon die Produkte GB200 wie GB300 jeweils deren zwei tragen (im genauen: zwei Doppelchips). Die nachfolgende Tabelle versucht das ganze halbwegs zu erklären, wobei insbesondere auf die Unterscheidung von "Chip" und "Produkt" Wert gelegt wird – auch wenn Hersteller & "Fachpresse" bislang wenig darauf geben. Ironischerweise bedeutet dies auch, dass die Darstellung des HPC/AI-Chips "GB100" (als Doppelchip mit 2x 104 Mrd. Transistoren) durch 3DCenter zu dessen Vorstellung im letzten März bereits korrekt war – auch wenn es bei sicherlich >95% aller Quellen im Internet anders dargestellt wird.

| Klasse | Eigenname | Hardware | max. TDP | Anmerkungen | |

|---|---|---|---|---|---|

| GB102 | Chip | - | 4 GPC, 80 SM, 4096-bit HBM3e, PCIe 6.0 | - | 104 Mrd. Transistoren auf ~800mm² Chipfläche aus TSMCs 4nm-Fertigung |

| GB100 | Doppelchip (2x GB102) |

"Blackwell" | 8 GPC, 160 SM, 8192-bit HBM3e, PCIe 6.0, ≤192 GB, Die-to-Die-Interconnect | 1200W | 2x 104 Mrd. Transistoren auf 2x ~800mm² Chipfläche aus TSMCs 4nm-Fertigung |

| GB100U | Chip-Variante (2x GB102) |

"Blackwell Ultra" | 8 GPC, 160 SM, 8192-bit HBM3e, PCIe 6.0, ≤288 GB, Die-to-Die-Interconnect | 1400W | 2x 104 Mrd. Transistoren auf 2x ~800mm² Chipfläche aus TSMCs 4nm-Fertigung |

| B100 | Produkt (1x GB100) | - | unbekannt | 700W | SXM-Modul für HGX-Plattform |

| B200 | Produkt (1x GB100) | - | unbekannt | 1000W | SXM-Modul für HGX-Plattform |

| B300 | Produkt (1x GB100U) | - | unbekannt | 1200W | SXM-Modul für HGX-Plattform |

| GB200 | Produkt (2x GB100) | "Blackwell Superchip" | 16 GPC, 288 SM, 2x 8192-bit HBM3e, PCI 5.0, 2x 192 GB | 2700W | nVidia-eigenes Server-Modul mit 2x GB100, 1x "Grace" CPU und NVLink-Switch |

| GB300 | Produkt (2x GB100U) | "Blackwell Ultra Superchip" | 16 GPC, 320 SM, 2x 8192-bit HBM3e, PCI 6.0, 2x 288 GB | >3000W | nVidia-eigenes Server-Modul mit 2x GB100, 1x "Grace" CPU und NVLink-Switch |

| Hinweise: ob GB102 tatsächlich maximal 80 SM und GB100 tatsächlich maximal 160 SM tragen, ist bislang unbestätigt; "GB100U" ist ein inoffizieller Codename zur Abgrenzung der Ultra-Variante | |||||

Von TechEpiphany @ X kommen wieder die Prozessoren-Verkaufszahlen der Mindfactory, welche für die 34. Woche einmal mehr vernünftige Absatzzahlen zu den altbekannten Marktanteilen sehen. Im Prozessoren-Bereich scheint die Mindfactory ihre geschäftliche Schwächephase vom Frühjahr überwunden zu haben, die aktuellen Absatzzahlen sind zwar nicht so hoch wie zum Jahresanfang, allerdings verglichen mit dem selben Zeitraum im Jahr 2024 vollkommen normal. Beachtenswert ist diesesmal nur, dass Intels Arrow-Lake-Prozessoren erstmals seit Launch im Bereich eines (knapp) dreistelligen Wochenabsatz angekommen sind. Natürlich ist dieser "Erfolg" dennoch eher beschämend für Intel, wohl noch nie verkaufte sich eine neue Intel-Generation im DIY-Geschäft derart mies wie "Arrow Lake". Sicherlich werden die absoluten Verkaufszahlen mit der Zeit noch etwas besser werden, da schließlich die LGA1700-Prozessoren mit der Zeit aus dem Markt gehen und damit keine Intel-interne Konkurrenz mehr bilden werden. Wie Arrow Lake im DIY-Geschäft aber jemals auf einen grünen Zweig kommen will, ist derzeit nicht abzusehen, da dürfte sich auch mit dem kommenden Refresh nicht viel bewegen.

| Prozessoren-Verkäufe der Mindfactory im Jahr 2025 (AMD in rot, Intel in blau, durchgehend in dieser Reihenfolge) | ||||||

|---|---|---|---|---|---|---|

| Absatz | Anteile | Umsatz | Anteile | ASPs | AM4, AM5, 1700, 1851 | |

| 34. Woche 2025 | 3715 Stück | 91,4% 8,6% | 1,09M € | 92,9% 7,1% | 299€ 241€ | 590, 2805, 200, 120 |

| 33. Woche 2025 | 3450 Stück | 90,7% 9,3% | 1,06M € | 92,0% 8,0% | 312€ 264€ | 580, 2550, 240, 80 |

| 32. Woche 2025 | 3880 Stück | 92,0% 8,0% | 1,18M € | 94,3% 5,7% | 313€ 216€ | 590, 2980, 240, 70 |

| 31. Woche 2025 | 2365 Stück | 87,3% 12,7% | 0,69M € | 89,1% 10,9% | 298€ 252€ | 435, 1630, 210, 90 |

| 30. Woche 2025 | 2235 Stück | 93,3% 6,7% | 0,64M € | 95,1% 4,9% | 293€ 210€ | 445, 1640, 120, 30 |

| 29. Woche 2025 | 3320 Stück | 90,1% 9,9% | 1,02M € | 91,3% 8,7% | 310€ 268€ | 470, 2520, 240, 90 |

| 28. Woche 2025 | 1865 Stück | 92,5% 7,5% | 0,57M € | 93,8% 6,2% | 311€ 254€ | 420, 1305, 110, 20 |

| 27. Woche 2025 | 1420 Stück | 95,1% 4,9% | 0,45M € | 96,9% 3,1% | 320€ 196€ | 290, 1060, 40, 20 |

| 26. Woche 2025 | 2990 Stück | 93,3% 6,7% | 0,97M € | 95,1% 4,9% | 330€ 238€ | 360, 2430, 170, 30 |

| 21. Woche 2025 | 1765 Stück | 87,5% 12,5% | 0,51M € | 88,3% 11,7% | 293€ 273€ | 380, 1165, 150, 70 |

| 20. Woche 2025 | 1240 Stück | 91,1% 8,9% | 0,37M € | 93,1% 6,9% | 305€ 231€ | 290, 840, 110, 0 |

| 19. Woche 2025 | 2985 Stück | 89,8% 10,2% | 0,89M € | 91,5% 8,5% | 302€ 248€ | 700, 1980, 250, 55 |

| 18. Woche 2025 | 1465 Stück | 88,7% 11,3% | 0,45M € | 91,2% 8,8% | 317€ 240€ | 320, 980, 120, 35 |

| 17. Woche 2025 | 2025 Stück | 89,1% 10,9% | 0,55M € | 89,6% 10,4% | 274€ 260€ | 540, 1265, 180, 40 |

| 14. Woche 2025 | 740 Stück | 84,5% 15,5% | 0,20M € | 87,4% 12,6% | 275€ 216€ | 240, 385, 100, 15 |

| 8. Woche 2025 | 3920 Stück | 91,1% 8,9% | 1,22M € | 93,2% 6,8% | 319€ 239€ | 965, 2605, 325, 15 |

| 7. Woche 2025 | 4520 Stück | 89,8% 10,2% | 1,37M € | 91,6% 8,4% | 309€ 250€ | 940, 3120, 430, 30 |

| 5./6. Woche 2025 | 6377 Stück p.W. | 88,9% 11,1% | 1,92M € p.W. | 90,2% 9,8% | 305€ 266€ | 1650, 4022, 630, 65 p.W. |

| 4. Woche 2025 | 7040 Stück | 93,0% 7,0% | 2,55M € | 95,4% 4,6% | 388€ 250€ | 1145, 5405, 450, 35 |

| 3. Woche 2025 | 5285 Stück | 88,8% 11,2% | 1,47M € | 89,6% 10,4% | 280€ 258€ | 1580, 3115, 465, 90 |

| 2. Woche 2025 | 9255 Stück | 95,4% 4,6% | 3,95M € | 97,0% 3,0% | 434€ 275€ | 1480, 7350, 365, 20 |

| 1. Woche 2025 | 4595 Stück | 92,1% 7,9% | 1,29M € | 91,5% 8,5% | 280€ 302€ | 1460, 2770, 305, 50 |

| alle Daten basierend auf den Erhebungen von TechEpiphany auf Twitter; Wochenkonvention: Sonntag zu Samstag; "p.W." = per Woche | ||||||