Hauptlinks

Suchen

Hardware- und Nachrichten-Links des 27./28. März 2021

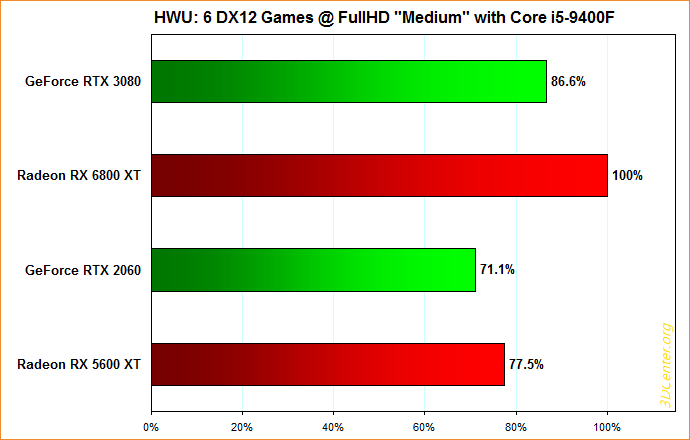

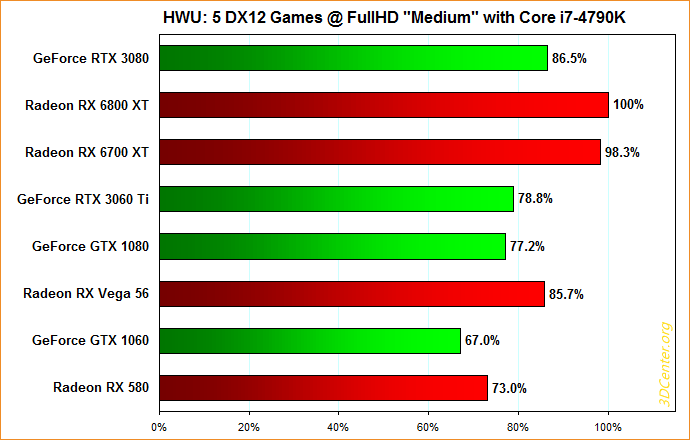

Die zuletzt bereits in Tabellen-Form gezeigten Aussagen des letzten HWU-Videos zur nVidia-Schwäche mit kleineren CPUs unter DirectX12 sind möglicherweise mittels der nachfolgenden Darstellung in Diagramm-Form nochmals besser zu erfassen: Benutzt wurden hierbei allein die Ergebnisse unter Core i5-9400F (mit DDR4/2666) sowie Core i7-4790K als wohl eher in der Praxis vorkommend als denn ein Ryzen 5 1400. Ausgangspunkt des ganzen ist grundsätzlich, dass beide Diagramme nach der nominellen FullHD-Performance sortiert sind, die Balkenlänge also von oben nach unten immer kleiner werden sollte (GeForce GTX 1060 und Radeon RX 580 dürfen gleich schnell sein). Wie auf den ersten Blick zu sehen, fallen hierbei die nVidia-Grafikkarten allesamt aus der Spur bzw. bieten weniger Performance, als von jenen normalerweise zu erwarten wäre. Über die Wahl der beiden Intel-Prozessoren entfällt auch die Frage, ob hierbei irgendein SAM/rBAR-Effekt im Spiel sein könnte – jenes Feature gibt es zumindest für den Core i7-4790K ganz gewiß nicht mehr.

Nochmals drastischer wird es, wenn man dies gegenüber der Nominal-Performance auf Basis des 3DC FullHD Performance-Index vergleicht: Dessen völlig andere (viel stärkere) Skalierung wäre dabei zu beachten, aber es reicht der Blick hin zu vollkommen eindeutigen Situationen im Stil von besser/schlechter. So sollte die GeForce RTX 3080 eigentlich oberhalb der Radeon RX 6800 XT herauskommen, nicht gerade unterhalb. Doch selbst wenn die allerneuesten Benchmark-Ergebnisse unter FullHD eher zugunsten von AMD ausfallen, darf hierbei keine derart große Differenz herauskommen. Nochmals eindeutiger wird es dann bei GeForce RTX 2060 gegen Radeon RX 5600 XT (nVidia-Karte sollte etwas vorn liegen), GeForce RTX 3060 Ti gegen Radeon RX 6700 XT (AMD-Karte sollte nur einen geringen Vorsprung haben), Radeon RX Vega 56 gegen GeForce RTX 3060 Ti und GeForce GTX 1080 (AMD-Karte sollte deutlich zurückliegen, gegenüber der 3060Ti sogar massiv) und Radeon RX 580 gegen GeForce GTX 1060 (sollten gleich schnell sein).

Insofern kann man durchaus von einer Problemlage für nVidia reden – welche speziell unter DirectX 12 existiert, die Ergebnisse unter Vulkan sind nicht ganz eindeutig (zu wenige Testspiele) und unter DirectX 11 ergeben sich eher umgekehrte Tendenzen. Klar muß allerdings auch sein, dass dieser nVidia-Nachteil an einer Stelle existiert, wo die CPU-Performance die Gesamt-Performance bereits dominiert. Auch die AMD-Karten skalieren in diesem Vergleich (logischerweise) schlecht, zwischen Radeon RX Vega 64 und 6800 XT gibt es gerade einmal +17% Mehrperformance – nominell sollte es mehr als das Doppelte sein. nVidias Problem liegt also nur dort, wo sich größere Grafikkarten sowieso nicht lohnen, egal ob von AMD oder nVidia kommend. Dass die Problematik genauso auch unter Situationen auftritt, wo normalerweise echte Differenzen zwischen (verschieden leistungsstarken) Grafikkarten existieren, wurde hingegen bislang nicht nachgewiesen (Einzelfälle sind kein "Nachweis"). Das Ausbleiben dieser Messungen deutet vielleicht sogar darauf hin, dass es da nichts zu holen gibt – dass sich also schon unter FullHD mit "High"-Bildqualität bereits wieder ein "normales" Bild zeigt.

Somit wäre dann allerdings darüber nachzudenken, ob in diesem Fall auch wirklich eine Praxisrelevanz existiert: Denn nVidia ist hierbei (nach bisherigem Wissen) allein schlechter unter Settings, wo wegen eines bestimmenden CPU-Limits sowieso nur noch sehr abgeschwächte Performance-Unterschiede zwischen den Grafikkarten existieren und sich somit nirgendwo wirklich schnelle Grafikkarten lohnen. Anstatt an dieser Stelle die Grafikkarte zu wechseln, wäre in einer solchen Situation viel eher ein CPU-Upgrade zu empfehlen, dies würde gravierend mehr bringen. Dies gilt natürlich nur insofern, als dass jemand tatsächlich FullHD mit (durchgehender) "Medium"-Bildqualität auf einem schwächeren Prozessor mit einer Grafikkarte á Radeon RX 580 oder GeForce GTX 1060 oder stärker benutzt. Jene Grafikkarten sind auch heutzutage zumeist zu einer "High"-Bildqualität unter FullHD in der Lage – was die Problematik in einer Grafikkarten-Limitierung verschwinden läßt und wie gesagt die Frage nach der Praxisrelevanz dieses Falls aufstellt.

Hardwareluxx notieren den Fall einer GeForce RTX 3090, wo sich bei der Montage eines anderen Kühlers der verbaute Ampere-Grafikchip erstaunlicherweise als "GA102-250" zeigte – anstatt "GA102-300", wie es regulärerweise sein sollte. Im konkreten wurde dabei die ursprüngliche Gravur "GA102-250" durchgestrichen und darunter eine neue Gravur "GA102-300" angesetzt, der Grafikchip somit nachträglich umgelabelt. Da es sich zudem um eine GeForce RTX 3090 in der Founders Edition handelt, ist eine Eigenmächtigkeit eines Grafikkarten-Hersteller ausgeschlossen und das ganze eindeutig im Namen nVidias passiert. Laut VideoCardz hängt dies wohl damit zusammen, dass alle Grafikchips, welche für die GeForce RTX 3080 Ti mit Chip-Unterbau "GA102-250" gedacht waren, nunmehr der GeForce RTX 3090 zugeschlagen werden – da die derzeit gehandelte GeForce RTX 3080 Ti nunmehr mit der neuen Chip-Variante "GA102-225" antreten soll.

Vermutlich dürfte es sich nur um eine kleine Charge an "GA102-250" handeln, welche somit von der GeForce RTX 3080 Ti zur GeForce RTX 3090 wechseln. Dabei dürfte nVidia regulärerweise auch eine neue Hardware-Prüfung durchführen müssen, denn für die GeForce RTX 3080 Ti wurden zwei weniger aktive Shader-Cluster sowie früher teilweise auch ein etwas kleineres Speicherinterface benötigt. Denkbar allerdings, dass nVidia diese allererste für die GeForce RTX 3080 Ti gedachte Chip-Charge sowie aus der Fertigung für die GeForce RTX 3090 entnommen hat, schließlich ist die Chip-Variante "GA102-250" Chip letztlich nie in die Massenfertigung gegangen. Besonders relevant ist diese Anekdote somit eigentlich nicht. Es läßt sich allerdings mitnehmen, dass die vorherigen Gerüchte über eine Chip-Variante "GA102-250" tatsächlich real waren, die Gerüchteküche hierzu also mitnichten heiße Luft verbreitet hat – trotz aller zwischenzeitlichen Hü- und-Hott-Änderungen an der GeForce RTX 3080 Ti.