Hauptlinks

Suchen

News des 28. Juni 2023

Viele Hardwaretester haben zur GeForce RTX 4060 einen (erstaunlicherweise) höheren Stromverbrauch festgestellt als nVidia mit 115 Watt TDP vorgibt. Dies gilt auch für Karten-Ausführungen, welche im BIOS tatsächlich ein Power-Limit von 115W vorschreiben – selbst jene verbrauchen im Gaming-Einsatz real zwischen 125-130 Watt. Dies ist jetzt kein großer Unterschied, aber vor allem gegenüber der Tendenz der bisherigen Ada-Lovelace-Beschleuniger mit unterhalb der TDP liegenden Realverbrauchswerten doch bemerkenswert. Gemäß Igor's Lab soll dieses Verhalten an einer anderen Ausführung der entsprechenden Meß-Schaltungen liegen, gemäß der ComputerBase in erster Linie ein Fehler sein, welchen nVidia noch fixen will. Daraus ergeben sich zwei Möglichkeiten zum Endresultat:

|

Was nVidia an dieser Stelle tut, ist noch nicht klar – ist jedoch bedeutsam zur der Bewertung der GeForce RTX 4060. Selbige ist derzeit somit etwas in der Schwebe, denn auch wenn es sich beiderseits (Stromverbrauch & Performance) nur um geringe Unterschiede handelt, werden für eine korrekte Einordnung der GeForce RTX 4060 ins große Gesamtbild natürlich die finalen Werte benötigt. Durch diesen Lapsus entwertet nVidia (leider) diesen Launch und auch die Arbeit der Hardwaretester, denn somit gilt das Warten auf den "Launch-Patch" – nun auch für Grafikkarten. Im Fall, dass sich nVidia für Lösung No.2 entscheidet, müssten dabei sogar die Bewertungen zur GeForce RTX 4060 teilweise umgeschrieben werden. Immerhin ist das Performance-Ergebnis gerade gegenüber der Radeon RX 7600 derart knapp, dass selbst ein geringer Offset jenes noch verändern würde.

Twitterer Xino, welcher schon früher Details zu dieser APU notierte, beschreibt die Chipfläche von AMDs Phoenix2-APU als mit ca. 133mm² groß. In den Kommentaren zu diesem Tweet findet sich auch der Hinweis auf eine AMD-offizielle Aussage von 137mm² zum Ryzen 3 7440U – wobei an dieser Stelle jedoch nicht klar ist, ob jene APU überhaupt zu "Phoenix2" gehört. Technisch passen die Details (4 CPU-Kerne und 4 RDNA3 Shader-Cluster) nicht ganz zu früheren Meldungen über "Phoenix2" (2 CPU-Kerne nach "Zen4", 4 CPU-Kerne nach "Zen4c" und 4 RDNA3 Shader-Cluster) – und es wäre auch sehr verwunderlich, wenn AMD diese erste Hybrid-APU ganz ohne großes Glockenläuten in den Markt gebracht hätte. Entweder besteht die Phoenix-APU-Familie somit aus drei verschiedenen Dies – oder aber "Phoenix2" verzichtet noch auf die kleineren Zen4c-Kerne und kommt konventiell mit vier großen Zen4-Kernen daher.

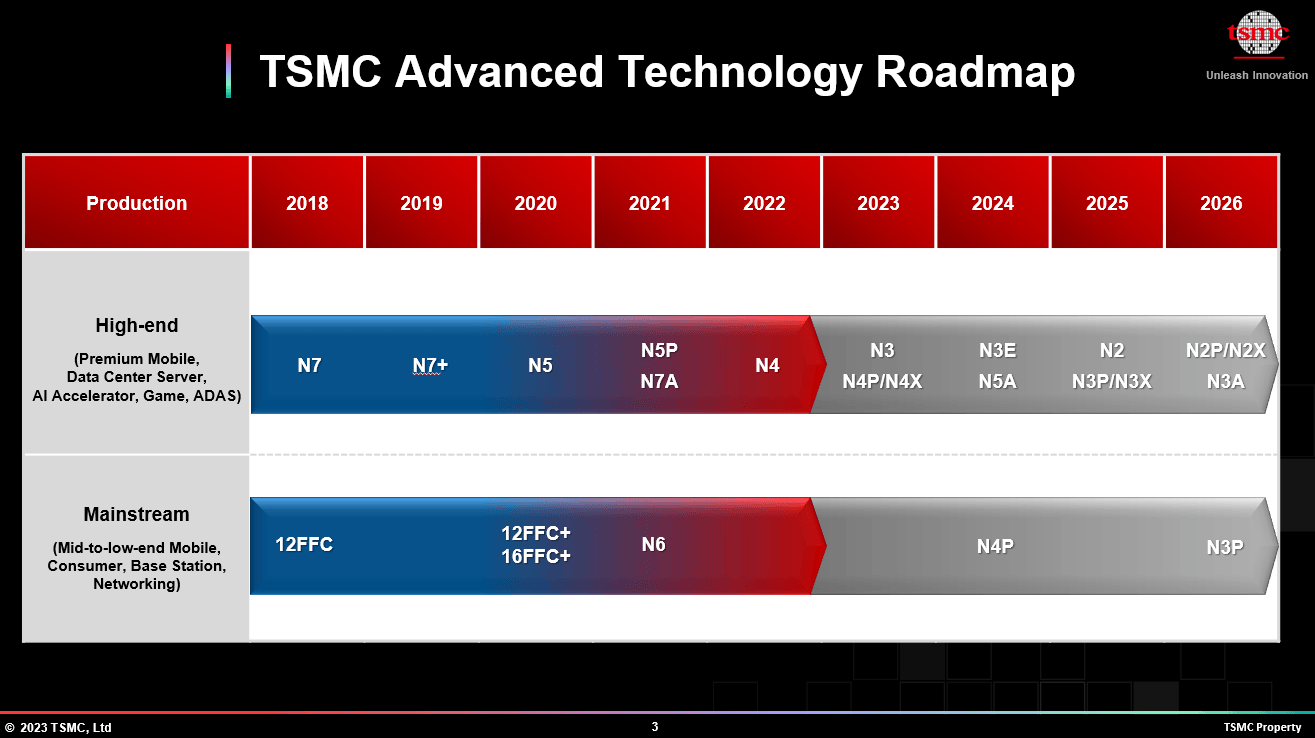

Die ComputerBase weist in ihrer Berichterstattung zu "Ada Lovelace Next" auf den gewichtigen Punkt hin, dass Chipfertiger TSMC seine verbesserten 3nm-Prozesse "N3P" und "N3X" sowieso erst im Jahr 2025 herausbringen will. Laut der hierzu passenden TSMC-Roadmap kommt "N3" zwar bereits 2023 sowie "N3E" dann 2024, die PC-Hersteller dürften aber eher die auf Leistung getrimmten Prozesse "N3P" und "N3X" bevorzugen. Dies erscheint insofern stimmig, als dass die mit einem neuen TSMC-Node typischerweise zuerst hergestellten Apple-SoCs auf die Leistungsaufnahme von Mobile-Geräten abgestimmt sind und PC-Grafikchips in der Spitze natürlich gänzlich andere Watt-Bereiche erreichen wie auch Chipflächen belegen. Eine beachtbare terminliche Differenz zwischen Apple-SoCs und PC-Chips unter einem neuem Fertigungsnode gab es schon immer, in diesem Fall würde sich jener Punkt dann mittels der jeweiligen Sub-Nodes noch klarer ausdrücken.

Mehr Ärger als Gewinn scheint sich AMD mit seiner exklusiven Partnerschaft mit Spieleentwickler "Bethesda" für das kommende "Starfield" an Land gezogen zu haben – denn dafür hagelt es Protest bis hin zu Boykott-Drohungen. Ob selbiges wirklich gerechtfertigt ist, bleibt offen, denn letztlich bedeutet die AMD-Unterstützung für "Starfield" nur, dass AMD-Features wie FSR garantiert an Bord sind. Eine reine Spiel-Optimierung zugunsten von AMD sowie gegen nVidia-Hardware ist schon aus diesem Grunde wenig vorstellbar, dass der Spieleentwickler letztlich damit rechnen muß, das 70-80% seiner Kunden mit GeForce-Grafikkarten anrücken. Denkbarerweise wird hier in die PR-Aussagen von AMD & Bethesda zu viel hineininterpretiert: AMD will hier einfach nur etwas vom Glanz des kommenden Spiele-Blockbusters abbekommen, womit man sich mit Segen von Bethesda medial so gut mit möglich darstellt.

Ob da auf technischer Sicht besonders viel passiert, ist nicht gesagt, der mehrheitliche Effekt solcher Aktionen liegt in der entsprechenden Pressemitteilung. Für beide Unternehmen ist dies leicht verdientes Geld: Bethesda hat ein paar zusätzlichen Einnahmen, wofür sich AMD an dessen Spitzenprodukt dranhängen darf. Unwahrscheinlich, dass man da besonders viel an der eigentlichen Technik tut (neben dem Einbau von FSR, was keine besondere Arbeit ist), da der Werbeeffekt eben wie gesagt primär auf medialer Ebene wirkt. Vor einem für nVidia-Hardware kaputtoptimierten Spiel muß man sich ergo nicht fürchten, dies kann sich der Spieleentwickler auf Basis der Kräfteverteilung zwischen der installierten Basis von AMD- und nVidia-Grafikkarten nicht leisten.

Ein tatsächlich valider Punkt ist allerdings, dass es mittels dieser exklusiven Partnerschaft kaum eine Chance auf DLSS-Support gibt (es sei denn durch Modder). In dieser Frage ist der nVidia-Nutzer sehr wohl zu verstehen, welcher schlicht sein besseres DLSS haben will – was technisch zur Verfügung steht und wegen dieser exklusiven Partnerschaft denkbarerweise nicht eingebaut wird. Sicherlich kann man sagen, dass allein nVidia diesen Wettstreit der konkurrierenden Upscaler angefangen hat – und jedes Spiel mit DLSS-Support ebenfalls kein DLSS für AMD-Hardware anbietet (im Gegensatz zu FSR, welches dies auch für nVidia-Hardware ermöglicht). Aber am Ende ist die Nutzer-freundlichste Lösung immer noch, schlicht alle Upscaler (inklusive Intels XeSS) ins Spiel einzubauen.

Und insofern AMD dies über eine "exklusive Partnerschaft" tatsächlich blockieren sollte, dann geht dies klar gegen den Willen der Konsumenten. Ob AMD dies nun wirlich blockiert, ist damit allerdings nicht erwiesen bzw. dürfte sich auf Basis üblicherweise geheim gehaltener Verträge auch nie beweisen lassen. Doch AMD sollte trotzdem durchaus einmal nachrechnen, ob der hiermit entstandende Ärger nicht am Ende ein Minusgeschäft ist – für welchen man noch dazu an Bethesda sicherlich auch noch etwas zu löhnen hatte. Besser wäre wohl eine Strategie für AMD gewesen, welche sowohl DLSS für "Starfield" zuläßt als sich komplett auf die eigenen Vorteile konzentriert: Und da könnte man nVidia stark durchaus zusetzen, wenn FSR beispielsweise auf einer GeForce GTX 1080 unter "Starfield" nutzbar ist – während nVidia dieser (eigenen) Karte hingegen kein DLSS zugesteht.