Hauptlinks

Suchen

News des 7. Juni 2024

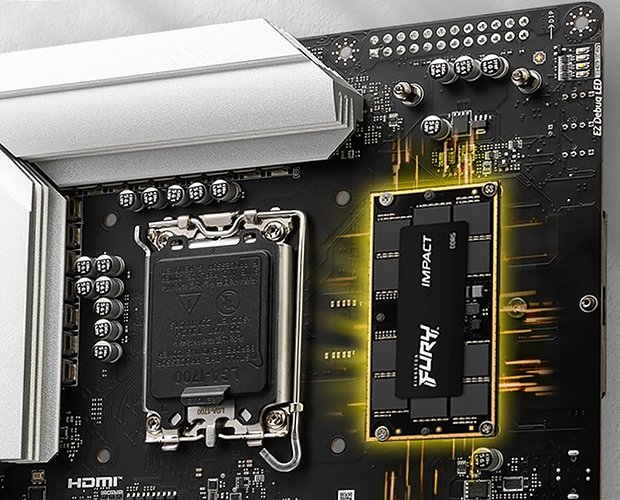

Golem, Hardwareluxx und die PC Games Hardware berichten über die Speicher-Innovationen von der Computex – namentlich CAMM2 und CUDIMM. CAMM2 ist das augenscheinlichere Projekt, da es bereits im Mobile-Segment adaptiert wird und nun eventuell auch noch zum Desktop kommt. Hierbei handelt es sich um eine (gänzlich) andere Bauform des Speichermoduls: Selbiges kommt als nur noch ein einziges Modul mit verdoppeltem Speicherinterface daher – womit keine weiteren Speichersteckplätze benötigt werden. Dies reduziert den baulichen Aufwand und verbessert gleichzeitig die Signalqualität. Nachteiligerweise gibt es damit aber auch keine spätere Aufrüstmöglichkeit über noch freie Speicher-Steckplätze mehr – weil CAMM2-Speicher immer nur einen Speicherplatz bietet. CAMM2-Speicher benutzt auch keinen Steckplatz, sondern wird ähnlich wie M.2-SSDs aufs Mainboard aufgeschraubt.

Dies ist für Module mit integrierter Kühllösung zudem recht praktisch, weil die Bauhöhe niedrig ist und die Befestigung wesentlich tragfähiger als mit gewöhnlichen DIMM-Steckplätzen ausfällt. Als Speicherchips werden bei CAMM2 im übrigen normale DDR5- und LPDDR5X-Speicher verbaut, CAMM2 ist nur eine andere Modul-Bauform, kein anderer Speichertyp. Dies ist bei CUDIMM nicht anders: Auch hier wird gewöhnlicher DDR5-Speicher verwendet, welcher zudem auf einem standardmäßigen DIMM-Modul sitzt. Jenes enthält allerdings einen extra CKD-Chip ("Client Clock Driver") zur Signal-Pufferung, welcher die Signalqualität des Speichermoduls verbessern soll. Praktisch handelt es sich um besonders stabile Speichermodule, die bessere Signalqualität kann natürlich auch für noch höhere Taktraten benutzt werden. CUDIMM passt auf normale DIMM-Steckplätze, womit die Nutzer regulärer Mainboards frei zwischen beiden Speicherarten entscheiden und wechseln können.

CAMM2 benötigt hingegen extra Mainboards, auf welchen dann nur (ein) CAMM2-Modul verbaut werden kann. Ob sich CAMM2 im Desktop durchsetzt, bleibt offen, bei Mobile-Gerätschaften scheint es hingegen auf dem Vormarsch zu sein. Erwähnt werden sollte zu CAMM2 noch, dass die Frage der gleichwertigen Bandbreite derzeit nicht bewiesen ist. Dadurch, dass nur noch ein Speichermodul existiert, bleibt den Speichermodul-Herstellern schließlich ein breiter Spielraum für "Optimierungen". Nur dass CPU-Z hier eine Interface-Bandbreite von 128 Bit anzeigt bzw. dass eine maximale Datentransferrate garantiert wird, bedeutet dies noch keineswegs, dass die verbauten Speichercontroller auf dem CAMM2-Modul in jeder Lage genauso leistungsfähig sind wie die Speichercontroller zweier gewöhnlicher DIMM-Module. Selbstverständlich kann dies alles voll in Ordnung bzw. gleichwertig sein – aber dies sollte wenigstens einmal durch Benchmarks nachgewiesen werden.

Bei Heise thematisiert man die starke AI-Ausrichtung nVidias, welche auch dazu geführt hat, dass es auf der Computex faktisch gar nichts für den Gamer bezüglich neuer nVidia-Hardware zu hören gab (außer Vertröstungen auf später). So korrekt dies alles im Grundsatz ist, so erstaunlich schwach bzw. sogar falsch sind einige der von Heise gebrachten Argumente, wieso nVidia derart handelt: Denn es ist eben nicht korrekt, dass sich nVidia bei der Chipfertigung zwischen Consumer-Chips und HPC/AI-Chips entscheiden müsste. Die aktuelle "Blackwell"-Generation kommt nur in TSMCs 4nm-Fertigung daher, wo es keinen "Kampf" mehr um Fertigungskapazitäten beim Chipfertiger gibt. Dies war vor 2-3 Jahren während Chip-Krise und Cryptomining-Hype der Fall, ist jedoch längst überwunden. Vielmehr garantiert die 4nm-Fertigung nVidia, dass die Chipfertigungs-Kapazitäten von TSMC eben gerade kein Problem sind. Was nVidia pro Jahr an 4nm-Wafern benötigt (~335'000 für 2025), fertigt TSMC grob in zwei Monaten (150'000/Monat bereits im Jahr 2022).

Die limitierenden Faktoren sind derzeit viel eher Advanced Packaging (benötigt für MultiChip- & HBM-Lösungen) sowie der HBM-Speicher selber (ausverkauft bis ins Jahr 2025). Beide Probleme konnte nVidia zuletzt aber gut begrenzen, so dass die von kurzem noch erheblichen Lieferzeiten für nVidias HPC/AI-Beschleuniger inzwischen wieder auf ein gewisses Normalmaß reduziert werden konnten. Die genannten limitiertenden Faktoren existieren zudem ausgerechnet bei Consumer-Grafikchips mitnichten – womit für nVidia auch keinerlei Limit besteht, mehr hiervon zu produzieren. Ein GB202-Chip im MCM-Verfahren, wie von Heise erwähnt, war zudem bestenfalls Teil früherer Gerüchte, ist inzwischen jedoch lange vom Tisch. Auch aufgrund der Limitationen von Advanced Packaging dürfte sich nVidia hüten, irgendeinen Consumer-Chip umgehend als MCM-Design zu bringen – zuerst muß noch eine (weitere) erhebliche Kapazitätsausweitung bei Advanced Packaging stattfinden.

In der Summe steht nVidia nirgendwo vor der Wahl, entweder Consumer-Chips oder HPC/AI-Chips herzustellen – man kann derzeit problemlos beides gleichzeitig herstellen. Der Grund für nVidias aktuelle Zurückhaltung bezüglich Consumer-Chips liegt eher darin, dass Consumer-Gerätschaften bei der HPC/AI-Firma nVidia (87% Anteil des HPC/AI-Segments am letzten Quartalsumsatz) inzwischen in die Nische gedrängt wurden und somit keine Fantasie der Börse bzw. der Analysten auslösen können. nVidia ist hier weder gezwungen noch bringt es bedeutsam etwas (im Sinne von Börse & Analysten), für gewöhnliche Consumer-Chips die große Werbetrommel zu schüren. Und da die Konsumenten erfahrungsgemäß letztlich doch nVidia kaufen, müssen jene auch nicht besonders bedacht werden – ganz besonders nicht, wenn das Projekt noch nicht einmal spruchreif ist. Denn das ist der eigentliche Grund der nVidia-Zurückhaltung zu "Gaming-Blackwell" auf der Computex: Ein Jahresendprojekt stellt man zeitnah vor – und nicht bereits im vorhergehenden Frühsommer.

Erstaunlich schnell hat Microsoft gegenüber den jüngst aufgetauchten Datenschutz-Problemen von "Recall" reagiert – und verspricht dies mittels Änderungen an Recall vor der eigentlichen Auslieferung am 18. Juni anzugehen. So sollen die von Recall erfassten & ausgewerteten Daten nunmehr verschlüsselt gespeichert werden, der Zugriff auf die Recall-Timeline sowie die Recall-Suche soll nur nach Anwesenheitsnachweis des Nutzers ("proof of presence") möglich sein – was wohl mittels "Windows Hello" realisiert werden dürfte. Denn jenes ist auch zur grundsätzlichen Aktivierung von Recall notwendig – ohne Windows Hello somit kein Recall (bedeutet auch: ohne Microsoft-Account kein Recall). Zudem soll die neue Standard-Einstellung bei der Recall-Einrichtung nunmehr auf "Snapshots off" lauten – sprich Desktop-Screenshots werden per default nicht mehr gespeichert.

|

Dies ist neben der Sicherheits-Härtung durch Verschlüsselung die für den Normalnutzer wichtigste Änderung, ohne dass man die Recall-Funktion wahrscheinlich gar nicht auf die Menschheit loslassen könnte. Denn der Normalnutzer wird nun einmal erfahrungsgemäß die Möglichkeit der Verhinderung von Snapshots diverser Programme mitnichten nutzen – und würde bei default-Aktivierung ein hohes Datensicherheits-Risiko eingehen. Nunmehr gibt es diese Snapshot-Funktion nur noch für Nutzer, welche sie auch wirklich selber einschalten. Pro Forma sieht dies alles gut aus und durchaus so gelöst, wie es sein sollte bzw. wie es Microsoft eigentlich von Anfang an hätte derart planen sollen. Mögliche Probleme können sich erst aus der praktischen Nutzung ergeben: Wie ob Malware nicht doch irgendwie auf die Recall-Funktionen zugreifen kann bzw. wie gut die von Microsoft hierzu angesetzte Verschlüsselung ist. Das Interesse von Sicherheitsforschern wie Cyberkriminellen dürfte Microsoft nunmehr sicher geweckt haben.

Gleichzeitig läßt sich angesichts dieser Entwicklung allerdings auch die Frage aufstellen, was denn nun mit dem groß angekündigten und zur Computex auch in aller Munde befindlichen KI-PC ist: Denn Recall ist die eindeutig wichtigste Funktionalität von "Copilot+" – und gleichzeitig dürften die nunmehr nur noch optionalen Snapshots der wichtige Teil der Datensammlung der Recall-Datenbank sein. Ohne die Snapshots kommen dort nur Tracking-Daten zu Programm-Nutzung, Suchmaschinen-Abfragen und Browser-Inhalten an, was teilweise hilfreich sein kann, insgesamt dem Feature jedoch enorm an Schlagkraft kosten wird. Ob mit deaktivierten Snapshots die verpflichtende NPU mit verpflichtend 40 TOPs eigener Rechenleistung technisch überhaupt noch gebraucht würde, darf genauso in Frage gestellt werden. Wahrscheinlich wird die NPU am ehesten für die Texterkennung der Snapshots eingesetzt, weniger denn für eine Suche durch die (schon aufbereitete) Recall-Datenbank.

Der KI-PC geht somit im eigentlichen gar nicht mehr als KI-PC ins Rennen, wenn die Snapshots per default inaktiv sind und Recall damit um seiner mächtigsten Datenquelle beraubt ist. Microsoft und die Hersteller dürften diese Schiene natürlich dennoch weiter reiten, weil die nun einmal hergestellten Geräte abgesetzt werden müssen bzw. nachkommende Hardware mit gleicher Featuritis (AMD Strix Point & Intel Lunar Lake) bereits in den Startlöchern steht. Aber mit "KI-PC" hat dies eigentlich nichts mehr zu tun, wenn man die Recall-Funktionalität im default-Zustand derart zusammenstreicht. Es wird durchaus interessant werden zu sehen, ob der Markt dies möglicherweise dennoch annimmt, weil die Marketing-Kraft von Microsoft und der Hersteller dies eventuell übertünchen kann. Denkbar aber natürlich auch, dass die meisten KI-PCs letztlich unbewußt gekauft werden, ohne also dass der PC-Käufer diese Funktionalität aktiv gefordert hätte. Es wird in Zukunft wohl nicht unerheblich darauf ankommen, auseinanderzuhalten was die Verkäufe von KI-PCs sind und was die tatsächliche Nutzung von Copilot+ bzw. Recall ist.