Hauptlinks

Suchen

Kommt nVidias GeForce GTX Titan mit Taktraten von 875/3000 MHz?

Über nVidias wohl am 18./19. Februar antretende HighEnd-Grafikkarte "GeForce GTX Titan" sind schon viele Details halbwegs sicher bekannt – die hochwichtige Information zu den Taktraten fehlte allerdings bisher noch. Nun findet sich in der GPU-Datenbank von TechPowerUp jedoch ein Eintrag zur GeForce GTX Titan, welcher von Taktraten von 875/3000 MHz für diese Karte spricht – mit auch dem Hinweis auf eine Hersteller-Karte in Form des Asus-Modells mit Taktraten von 915/3000 MHz. Insbesondere dieser Punkt läßt diese Taktraten-Angaben aus der GPU-Datenbank von TechPowerUp als "echt" erscheinen. Andere bei TechPowerUp zu findende neue Informationen betreffen die TDP von angeblich nur 235 Watt (erscheint uns allerdings als zu niedrig) sowie die exakte Größe des GK110-Chips von 521mm². Damit summieren sich die bisher bekannten Daten zur GeForce GTX Titan folgendermaßen auf:

nVidia GeForce GTX Titan

|

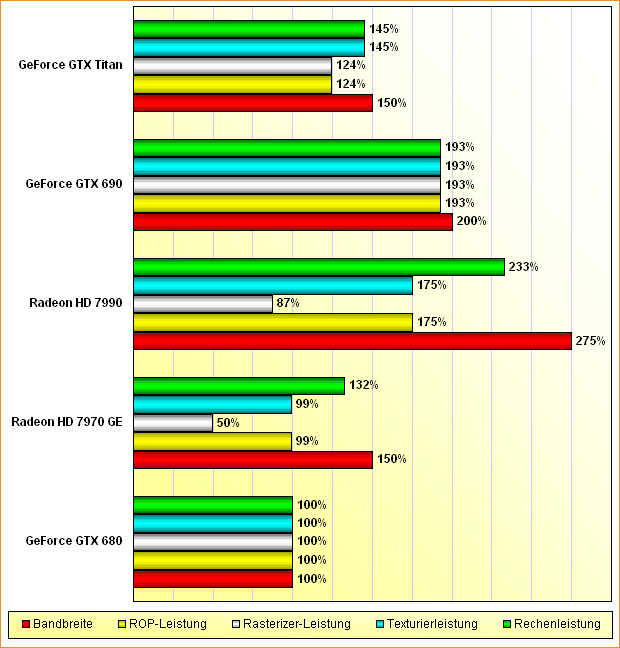

Damit würde die GeForce GTX Titan bei der Rechen- und Texturierleistung um 45 Prozent gegenüber einer GeForce GTX 680 zulegen, bei der Speicherbandbreite um immerhin 50 Prozent (die nur 24 Prozent höhere ROP- und Rasterizer-Leistung fallen hier nicht groß ist Gewicht). Dies hört sich durchaus vernünftig an, allerdings wird es damit nicht so einfach, eine GeForce GTX 680 um mehr als 50 Prozent in der Spiele-Performance zu überbieten. Ein paar Prozent könnte nVidia über kleinere Verbesserungen am GK110-Chip sowie über dessen deutlich größere Caches noch oben drauf legen – aber ob damit das Ziel einer Mehrperformance von 60 Prozent gegenüber der GeForce GTX 680 zu erreichen ist, bleibt eher fraglich.

Viel mehr als eine Mehrperformance von 50 Prozent gegenüber der GeForce GTX 680 sollte man sich von der GeForce GTX Titan zum derzeitigen Stand also nicht versprechen. Ab Werk übertaktete Ausführungen von GeForce GTX Titan – von Asus soll wie gesagt eine Karte mit Taktraten von 915/3000 MHz kommen – bieten dann noch eine gewisse Mehrperformance im Rahmen von vielleicht 5 Prozent und könnten damit eher in die Nähe der genannten 60-Prozent-Marke kommen.

Zu erwähnen wäre nochmals die erstaunlich niedrige TDP von angeblich nur 235 Watt für die default-Taktung von 875/3000 MHz. Dies erscheint uns als sehr wenig angesichts der TDP von ebenfalls 235 Watt für eine Tesla K20X Karte mit Taktraten von nur 735/2600 MHz. Andererseits gilt auch, daß nVidia im Bereich dieser Profi-Beschleuniger die TDPs nicht derart "kreativ" auslegen kann wie im Consumer-Bereich, sprich möglicherweise enthält die TDP der Tesla-Karte einigen Spielraum, welchen man dann bei der GeForce-Karte ausnutzt. Die letzten (echten) HighEnd-Boliden von nVidia hatten jedenfalls allesamt die Tendenz, ihre TDP selbst unter regulären Spielen zu erreichen bzw. teilweise sogar zu überbieten. Trotzdem würde es nicht verwundern, wenn diese TDP-Angabe am Ende noch auf einen Wert in Richtung 250 bis 270 Watt korrigiert werden würde.

Wie bekannt, soll die GeForce GTX Titan am 18. Februar offiziell vorgestellt werden, erste unabhängige Testberichte wird es dann ab dem 19. Februar geben. In den Handel soll die neue HighEnd-Grafikkarte dann ab der letzten Februar-Woche gehen – wobei weltweit angeblich nur knapp 10.000 Stück zur Verfügung stehen sollen. Für eine normale Grafikkarte ist dies sehr wenig, für ein solches HighEnd-Geschoß aber wohl sogar ausreichend – Sondermodelle wie die Mars- und Ares-Karten von Asus werden regelmäßig auch nur als limitierte Serie von sogar nur 1.000 Stück aufgelegt. Preislich ist die GeForce GTX Titan bei rund 800 Euro zu erwarten, sprich knapp unter dem Preis der (weiterhin etwas schnelleren) DualChip-Lösung GeForce GTX 690.

Nachtrag vom 14. Februar 2013

Diese Meldung über die Taktraten der GeForce GTX Titan (von 875/3000 MHz) bot eine kleine gedankliche Falle: Es wurde zum einen auf erste Benchmarks verlinkt, welche der GeForce GTX Titan einen Performance-Vorteil von ca. 60 Prozent gegenüber der GeForce GTX 680 einräumten – zum anderen ergab der Rohleistungs-Vergleich jedoch ganz klar, daß mehr als 50 Prozent Mehrperformance von der GeForce GTX Titan nicht zu erwarten sind. Beide Angaben beißen sich natürlich – und wir vermuten, daß eine der beiden dahinterliegenden Quellen letztlich Unrecht haben muß, damit dies wieder aufgeht. Sprich: Entweder sind die ersten Benchmarks doch nicht korrekt (möglicherweise mit einer ab Werk übertakteten Version vorgenommen?) oder aber die genannten Taktraten von 875/3000 MHz stimmen nicht (entweder ein höherer Chiptakt oder ist möglicherweise doch ein Boost-Modus anliegend?).

Es gibt allerdings einen kleinen Ausweg, bei welchem alle Quellen Recht behalten würden: Wenn der GK110-Chip deutlich effizienter ausfällt als die bisherigen Kepler-Chips, wäre es (theoretisch) möglich, mit nur 50% mehr Rohleistung auch 60% mehr Performance zu erzielen. Einen gewissen Ansatz bieten hierfür die deutlich größeren Caches des GK110-Chips – davon abgesehen dienen die meisten der zusätzlichen Schaltungen beim GK110-Chip allerdings vornehmlich professionellen Zwecken für den Tesla- und Quadro-Bereich und ist deren Nutzen im Spiele-Bereich gewöhnlich nicht vorhanden. Es würde also wirklich überraschen, wenn nVidia es schaffen würde, sogar noch entgegen des Gesetzes des abnehmenden Grenzertrags einen Chip aufzulegen, welcher mehr an Performance zulegt als jener an Rohleistung mehr hierfür aufbietet.

Verwandte News

- Spezifikations-Vergleich AMD FirePro W9100, Intel Xeon Phi 7120 & nVidia Tesla K40

- nVidia kündigt Pascal-Architektur für das Jahr 2016 an

- nVidia kündigt GK110-basierte DualChip-Lösung "GeForce GTX Titan Z" an

- nVidia stellt die GeForce 800M Mobile-Serie offiziell vor

- Umfrage-Auswertung: 28nm-Grafikkarten: Noch interessant - oder wird erst wieder bei 20nm gekauft?

- nVidia stellt neue Spielebundles für Desktop- und Mobile-Beschleuniger vor

- Die vorläufigen Hardware-Daten zur GeForce 800M Serie

- Umfrage-Auswertung: Wie ist der Ersteindruck zu GeForce GTX 750 & 750 Ti?

- Microsoft bringt DirectX 12

- Die Grafikkarten-Performance unter Thief