Hauptlinks

Suchen

nVidia verspricht +47% Mehrperformance zwischen GeForce GTX 1080 und GeForce RTX 2080

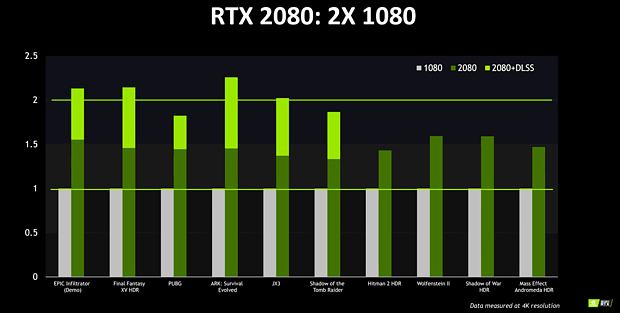

Auf einem "Editor's Day" am Mittwoch hat nVidia die Fachpresse noch etwas genauer bezüglich der kommenden Turing-Generation gebrieft. Hierbei sind dann endlich auch einmal ein paar Balken abgefallen – oft geschmäht und dennoch grundsätzlich benötigt, selbst wenn es sich nur um nVidia-eigene Performancemessungen handelt. nVidia hat hierbei auf 10 Spieletiteln unter der UltraHD-Auflösung zwischen Pascal-basierter GeForce GTX 1080 sowie Turing-basierter GeForce RTX 2080 die erreichten Frameraten verglichen, in 6 von 10 Spieletiteln kam zusätzlich noch eine Messung unter dem Turing-eigenem "Deep Learning Super-Sampling" (DLSS) hinzu. Bei selbiger ist natürlich nicht klar, welches andere Anti-Aliasing-Verfahren im jeweiligen Spiel hierfür deaktiviert wurde bzw. ob die Bild- und Aliasing-Qualität dann wirklich gleichwertig zu DLSS ist. Aber es liegt hiermit nun jedenfalls ein vernünftig breites Benchmark-Set unter ganz gewöhnlichen Spielen vor, welche ohne RayTracing liefen und somit die Normalperformance der GeForce RTX 2080 wiedergeben sollte.

| UltraHD | UltraHD mit DLSS | |

|---|---|---|

| GeForce RTX 2080 vs. GeForce GTX 1080 | +47% | +103% |

| Wertequelle | Schnitt aus 10 Spieletiteln | Schnitt aus 6 Spieletiteln |

| niedrigste/höchste Werte | minimal +34%, maximal +59% | minimal +82%, maximal +124% |

Und diesbezüglich stellt nVidia mit diesen Benchmarks schlicht die Behauptung auf, das die TU104-basierte GeForce RTX 2080 im Schnitt eine Mehrperformance von +47% gegenüber der GP104-basierten GeForce GTX 1080 auf die Waage bringt (pixelgenau gemäß der jeweiligen Balkenlängen von nVidias Performance-Diagramm ermittelt). Beide Karten basieren jeweils auf dem HighEnd-Chip jeder Generation und stellen jeweils dessen höchste angebotene Gaming-Ausführung dar, sind also gut miteinander vergleichbar, wenn es um die Frage des durch die Turing-Generation gebotenen Performancesprungs geht. Unter der Nutzung von DLSS soll es sogar auf +103% Mehrperformance hinaufgehen – aber dies ist eine Teildisziplin, welche man nur zusammen mit den genauen Benchmark-Bedingungen bzw. der jeweils erreichten Bildqualität sinnvoll betrachten kann. Es ergibt sich hierbei durchaus die Chance, das nVidia mittels DLSS einen absoluten Performance-Bringer in der Hinterhand hat, welcher gutklassige Kantenglättung zu sehr hoher Performance liefert. Aber derzeit ist dies eben nur eine Vermutung und wartet zukünftiger ernsthafter Betrachtung.

Die Mehrperformance unter normalen Bedingungen ist dagegen eine viel klare Sache: Jene sollte sich natürlich möglichst auch zu den kommenden Launchreviews unabhängig bestätigen lassen. Wenn jenes oder ein ähnliches Ergebnis herauskommt, hat nVidia gerade noch einmal die Kurve gekriegt, denn nach dem Fehlen jeglicher Performance-Angaben für den Normalzustand auf dem Gamescom-Event gab es schon Befürchtungen, das nVidia nicht umsonst in dieser Frage so "maulfaul" wäre. Zudem sprechen die reinen Rohdaten ja auch nicht unbedingt für Performancesprünge dieser Art: Es gibt auf jeder der Turing-Grafikkarten grob +20% mehr Shader-Einheiten sowie eine Rechenleistung samt Speicherbandbreite, welche jeweils grob +25% höher ausfallen. Natürlich war klar, das dies nur einen Teil der Wahrheit darstellen wird, denn die real anliegenden Taktraten könnten höher als die nominellen Angaben sein, gleichfalls könnten die Turing-Chips auch eine höhere Recheneffizienz aufweisen, also Rohpower-normiert mehr fps erzeugen. Wo genau die Grundlage für die erreichte Mehrperformance zwischen Pascal und Turing liegt bzw. ob diese nVidia-Angabe von +47% überhaupt der unabhängig gemessenen Realität entspricht, können dann aber nur die kommenden Launchreviews ergeben.

Selbige sind am 14. September 2018 zu erwarten, sprich exakt eine Woche vor dem Verkaufsstart. Vorher wird es maximal diverse Leaks geben können, erst ab diesem Zeitpunkt gibt es dann die ernsthaften Launchreviews. Jene enthalten aufgrund der ausreichend großen Zeitspanne hoffentlich eine erschöpfende Anzahl und Breite an Spiele-Benchmarks – sowie dort, wo es notwendig ist (DLSS & RayTracing), auch entsprechende Screenshot-Vergleiche zur Beurteilung der erreichten Bildqualität. So etwas hatten wir lange nicht mehr, das eine neue Grafik-Hardware auch anhand der mittels dieser möglichen höheren Bildqualität beurteilt werden musste – was aber nur positiv zu sehen ist, denn mehr Framerate ist über neue Hardware-Generationen schließlich garantiert bzw. gab es in mit den letzten Hardware-Generationen einfach zu oft. In der Anfangszeit der 3D-Grafik war dagegen die Beurteilung der Bildqualität und das gewichtete Urteil zwischen Bildqualität und Performance die hohe Schule der Grafikkarten-Tests, dies ist in letzter Zeit (leider, aber naturgemäß) ziemlich verloren gegangen.

Nachtrag vom 23. August 2018

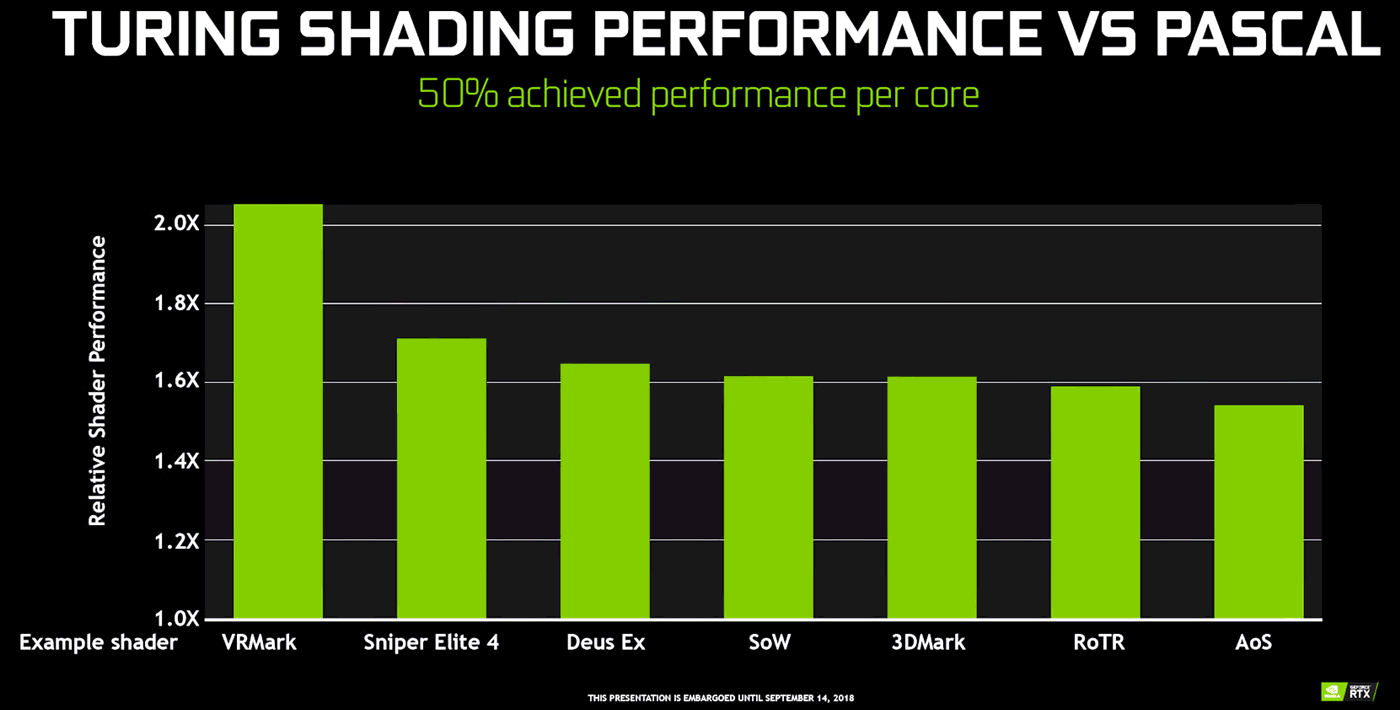

Videocardz zeigen in der Berichterstattung über nVidias Editor's Day noch eine weitere Performance-Folie, welche rein nur die Shading-Performance von Turing thematisiert. Hierbei wird ein Einheiten-normierter Performance-Vergleich geboten – ob es auch Takt-normiert ist, erschließt sich aus der Folie nicht, ist aber wegen der ähnlichen Taktraten zwischen Pascal und Turing vielleicht auch nicht ganz so wesentlich. In jedem Fall versprich nVidia hiermit eine grob +50% höhere Shading-Performance auf Basis derselben Anzahl an Shader-Einheiten zwischen Turing und Pascal – was letztlich bedeutet, das die Recheneffizienz zwischen Turing und Pascal in einem sehr erheblichen Maßstab zunimmt. Somit braucht nVidia auch nicht so sehr auf eine höhere Rohleistung zu schauen, die effizientere Grafikchip-Architektur ist hier der größere Performance-Bringer zugunsten von Turing. Dies gibt in jedem Fall Hoffnung darauf, das sich nVidias Performance-Versprechen trotz der nominell eher geringen Rohleistungs-Steigerung doch erfüllen läßt.

Zu den seitens nVidia präsentierten GeForce RTX 2080 Benchmarks bleibt derzeit offen, mit was für einer Grafikkarte nVidia jene (eigenen) Benchmarks angetreten hat – einer (standardmäßig werksübertakteten) Founders Edition oder einer Karte mit Referenztaktraten. Wenn man raten wollte, dann war es eine Founders Edition – erstens einmal verkauft nVidia selber nur diese und zweitens sieht man somit natürlich etwas besser aus. Wobei die eigentliche hierunter lauernde Frage ist, ob es überhaupt in beachtbarer Anzahl Turing-Karten zum Referenztakt geben wird. Denn dadurch, das nVidia nun gleich selber mit werksübertakteten Karten antritt, drängt man indirekt die Grafikkartenhersteller dazu, ähnliches zu tun – und somit die Taktraten der Founders Edition als eigentlichen Referenztakt zu übernehmen. Leider läßt sich noch nicht absehen, wie sich diese Situation in der Realität entwickeln wird, denn die Grafikkartenhersteller haben derzeit primär ihre Eigendesigns mit Werksübertaktung angekündigt – die Brot- und Butter-Ware wird dagegen sicherlich genauso entwickelt, aber weit weniger in den Vordergrund gestellt. Zudem gibt es derzeit von den wenigsten Grafikkartenherstellern bereits solide Taktraten-Angaben, selbst bei Händlern mit Vorbestellungs-Angeboten fehlen speziell diese Daten oftmals noch (Beispiel).

Angenommen, es würde keine beachtbare Anzahl an Turing-Grafikkarten mit Referenztakt geben, wäre die Situation ja klar – der Takt der Founders Edition würde zum neuen Referenztakt, wenn auch nur inoffiziell. Sobald allerdings eine beachtbare Anzahl an Turing-Grafikkarten mit Referenztakt am Markt aufschlägt, wird es letztlich zwei bedeutsame Taktraten geben (Referenztakt und Takt der Founders Edition) – und damit zwei Ansatzpunkte für Performance-Vergleiche. Normalerweise sollte das Pendel hier in Richtung des Referenztakts schwingen, aber da die meisten Hardwaretester zum eigentlichen Turing-Launch (14. September 2018) durch nVidia mit Founders-Edition-Karten beliefert werden dürften, könnte sich letztlich deren Taktrate bei der Performanceermittlung durchsetzen, egal ob dies (wegen der Werksübertaktung) eigentlich ungerechfertigt ist. Ist dann durch die Masse der Launchreviews einmal dieser Standard gesetzt, wird es auch schwer, sich dem noch zu entziehen – obwohl das ganze doppelt ungünstig dadurch wird, das es nicht nur nicht standardmäßig ist, sondern das sich nVidia hiermit auch einen (ungerechtfertigten) Optikvorteil gegenüber AMD sichert. Letzterer Punkt fällt derzeit nur nicht auf, weil AMD keinen Wettbewerb in diesem Performancesegment bietet, ist aber so oder so unfair gegenüber AMD.

Verwandte News

- nVidia stellt GeForce RTX 2070, 2080 & 2080 Ti für eine Auslieferung ab dem 20. September vor

- PNY leakt ausgesprochen handzahme Taktraten zu GeForce RTX 2080 & 2080 Ti

- Referenzplatine zur GeForce RTX 2080 zeigt ~540mm² großen TU104-Chip

- Erste wahrscheinlich authentische Spezifikationen zur GeForce 20 Serie sehen unveränderte Speichermengen

- Umfrage-Auswertung: Wieviel Mehrperformance muß nVidias Turing-Generation mindestens mitbringen?

- nVidia teasert die Turing-basierte "GeForce RTX 2080" für eine Vorstellung zur Gamescom an

- nVidia stellt mit Quadro RTX 5000, 6000 & 8000 die ersten Teile der Turing-Generation vor

- Gerüchteküche: Eine komplette GeForce-20-Serie tritt angeblich zwischen August und November 2018 an

- Umfrage-Auswertung: Wieviel Grafikkarten-Speicher ist derzeit verbaut (2018)?

- Neuer Artikel: Wie nVidias Turing-Generation aussehen könnte