Hauptlinks

Suchen

Sinken die Performance-Steigerungen pro nVidia-Generation?

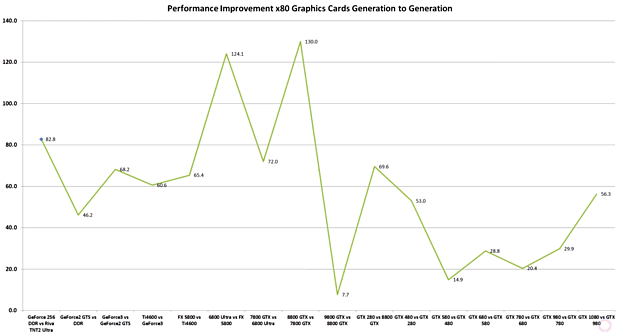

Ein Bericht seitens DSO Gaming über (angeblich) sinkende Performance-Steigerungen mit den neueren Grafikkarten-Generationen von nVidia (ab dem Jahr 2011) wird derzeit viel beachtet. Die dort besprochene Grafik zu der Performance-Entwicklung der einzelnen nVidia Grafikkarten-Generationen stammt aus einem Video von AdoredTV, welche mit diesem Video allerdings primär der Geschichte der nVidia-Grafikkarten nachgegangen sind – jene Performance-Betrachtung ist dabei eher denn ein Nebenpunkt. Leider wurde die Datenerhebung und vor allem das sinnvolle Zusamensetzen der vorliegenden Daten ziemlich oberflächlich ausgeführt – womit die ganze Diskussion unserer Meinung nach auf falscher Datenbasis stattfindet. Denn die von AdoredTV dargereichte Grafik krankt daran, sehr formelhaft zu vergleichen – so wurden stur die jeweiligen GTX xx80 Grafikkarten miteinander verglichen, egal ob nVidia zwischenzeitlich das Benennungsschema verändert hatte oder aber ob hier Refresh-Generationen auf Basis desselben Grafikchips im Spiel waren.

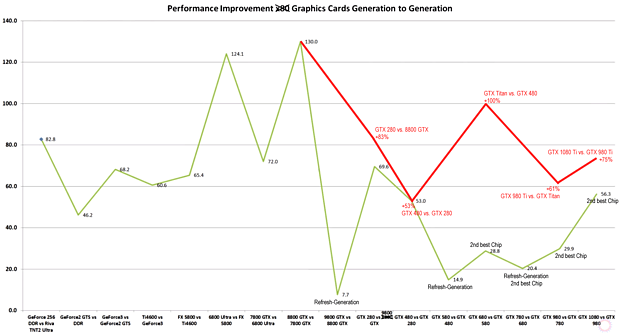

Rechnet man diese Effekte heraus, ergibt sich eine gänzlich andere Kurve bei allen neueren nVidia-Generationen – womit die ursprüngliche Aussage der (angeblich) sinkenden Performance-Steigerungen eigentlich nicht mehr haltbar ist. Für unsere editierte Grafik wurde konsequent gegen den jeweils höchsten nVidia-Chip verglichen – allerdings gemäß dem Stil der ursprünglichen Grafik gegen die allerersten Grafikkarten-Varianten auf Basis dieses höchsten nVidia-Chips. Später erschienene, nochmals leicht taktbessere Grafikkarten-Varianten wurden also nicht berücksichtigt – ob dies so korrekt ist, kann man sicherlich streiten, aber dies entspricht halt dem grundsätzlichen Stil der originalen Grafik von AdoredTV. Reine Refresh-Generationen wurden natürlich sowieso herausgelassen, jene können das entstehende Bild einigermaßen verwässern. Denn wenn die Performance-Steigerung zwischen zwei Haupt-Generationen auf eine zwischengeschobene Refresh-Generation aufgeteilt werden muß, dann fallen gleich Zahlen sehr niedrig aus.

Die editierte Grafik sieht dann wesentlich freundlicher für nVidia aus, zeigt aber natürlich auch weniger Grafikkarten-Generationen an. Denn genau hier liegt der Hund begraben: Es gab zuletzt bei nVidia nicht wirklich kleinere Performance-Steigerungen pro neuer Grafikchip-Generation – dafür kamen neue Chip-Generationen nicht mehr so häufig wie noch in den Anfangsjahren der 3D-Grafikkarten, wurde die Zwischenräume von nVidia gern mittels Refresh-Generationen überbrückt. Erst in jüngerer Zeit ist hier eine gegenteilige Entwicklung bei nVidia zu sehen – man läßt einer Grafikkarten-Generation wieder mehr Zeit und ersetzt jene dann lieber durch neue Grafikchips anstatt eines Refreshs basierend auf "alten" Chips. Damit kann man aber auch die Höhe der Performance-Steigerungen passabel aufrecht erhalten – nicht mit jeder neuen Generation, aber so doch meistens.

Auch wenn die originale Grafik somit aus unserer Sicht eine falsche Aussage darstellt, ist doch der Kerngedanke nicht gänzlich falsch: Die Performance-Steigerungen pro neuer Grafikchip-Generation (d.h. ausschließlich von Refresh-Generationen) müssen eigentlich irgendwann zurückgehen. Dies bedingt einfach die Fertigungstechnologie, welche zwar rein technologisch immer noch ganz gut voranschreitet, dafür aber immer teurer wird, was dann bei Consumer-Produkten irgendwann an seine Grenzen bezüglich der noch vermittelbaren Preispunkte stößt. Noch wird darüber natürlich mehr geredet, als daß dieser Zustand wirklich schon da wäre – aber dennoch, die Anzeichen für das Erreichen eines solchen Zustands der verlangsamten Entwicklung bedingt aus der Fertigungstechnologie sind schon da: Die Halbleiterfertiger brauchen vergleichsweise lange für echte neue Fullnodes, so das inzwischen das Ausnutzen von Halfnodes wieder populär wird (nVidia Volta in der 12nm-Fertigung von TSMC). Zugleich zeigt die Zunahme der Grafikkarten-Preise an, das die Chip-Fertigungskosten gerade in letzter Zeit erheblich gestiegen sein müssen – eine Entwicklung, die wie gesagt nicht ewig so weitergehen kann.

Selbst wenn vorstehende verlinkte Grafik nur den Preisanstieg der jeweiligen Spitzen-Grafikkarten dokumentiert, so ist doch auch aus der Praxis heraus klar, das Midrange-Lösungen zu Preispunkte nahe 300 Euro in jedem Fall teurer sind als vor einer Dekade – wo man für diese Preislagen regelmäßig die Salvage-Lösung des besten Grafikchips kaufen konnte. Die Grafikkarten-Preise sind einfach generell nach oben gegangen – nicht in einem unerträglichen Maßstab, aber eben beachtbar. Dies senkt vor allem das Potential zukünftig weiter steigender Endverbraucher-Preise, denn Midrange-Grafikkarten für 400-500 Euro wären einfach nicht mehr so gut absetzbar. Die Grafikchip-Entwickler müssen sich hierbei sicherlich der Entwicklung stellen, zukünftig eventuell sogar weniger Mehrperformance aufzubieten, als technisch möglich wäre – einfach, weil ein gewisser Preisrahmen eingehalten werden muß bzw. weitere Preissteigerungen nur noch in limitiertem Umfang als marktgängig anzusehen sind. Aber dies bleibt natürlich eine Zukunftsprognose, die konkret jetzt noch nicht eingesetzt hat.

Verwandte News

- Die Grafikchip- und Grafikkarten-Marktanteile im zweiten Quartal 2017

- Erste Grafikkarten-Benchmarks unter 8K zeigen enormen Performance-Hunger dieser Auflösung

- AMD mit "Champions Pack" für Quake Champions & nVidia legt "Destiny 2" Spielebundle neu auf

- PCI Express 4.0 wird noch 2017 finalisiert, aber kaum vor Ende 2018 nutzbar werden

- nVidias SLI und AMDs CrossFire sind faktisch Geschichte

- AMDs Polaris & Vega sowie nVidias Pascal unterstützen bereits das Shader Model 6

- Umfrage-Auswertung: Welche Auswirkungen hat der Mining-Boom auf den Grafikkarten-Kauf?

- SLI- und CrossFire-Eignung aktueller Spieletitel auf schwachem Niveau

- nVidia forscht an MCM-basierten Grafikchips

- Die Grafikchip- und Grafikkarten-Marktanteile im vierten Quartal 2016 sowie ersten Quartal 2017