Hauptlinks

Suchen

Aktuelle Treiber

- 32.0.101.8509

- 26.2.1

- 591.86

AMD Ryzen 7 9850X3D: Die Launch-Reviews gehen online

Mit dem Ryzen 7 9850X3D schickt AMD eine rein Taktraten-verbesserte Variante des bekannten Ryzen 7 9800X3D ins Rennen, während der ebenfalls erwartete Ryzen 9 9950X3D2 wohl erst einigermaßen später erscheinen wird. Damit fehlt diesem X3D-Refresh ein wenig der Schwung, die zwei neuen X3D-Modelle zusammen in nur einem Launch wären besser gewesen und würden mehr Aufmerksamkeit auf sich ziehen. Somit können sich die Hardwaretester heute nur dann auszeichnen, wenn ein möglichst breiter Vergleich zu anderen X3D-Prozessoren geboten wird, denn allein die paar Prozent Mehrperformance des neuen Ryzen 7 9850X3D gegenüber dem "alten" Ryzen 7 9800X3D locken natürlich niemanden hinter dem warmen Ofen hervor. Die gewichtige Frage nach dem Preisunterschied am Markt ist zudem heute sowieso noch nicht zu beantworten, jene läßt sich erst mit dem Marktstart am morgigen Tag auflösen. Insofern die vorliegenden Testberichte eine gewisse Qualität und Anzahl erreichen, wird zum Ryzen 7 9850X3D dann noch (in wenigen Tagen) die übliche Launch-Analyse seitens 3DCenter nachfolgen.

| AMD Zen 5 X3D | Kerne | L2+L3 | 3DVC | Takt | iGPU | OC | TDP/PPT | Listenpreis | Release |

|---|---|---|---|---|---|---|---|---|---|

| Ryzen 9 9950X3D2 | 16C/32T | 16+64 MB | 128 MB | 4.3/5.6 GHz | ✓ | ✓ | 200/?W | ? | unbekannt |

| Ryzen 9 9950X3D | 16C/32T | 16+64 MB | 64 MB | 4.3/5.7 GHz | ✓ | ✓ | 170/200W | $699 / 769€ | 12. März 2025 |

| Ryzen 9 9900X3D | 12C/24T | 12+64 MB | 64 MB | 4.4/5.5 GHz | ✓ | ✓ | 120/162W | $599 / 659€ | 12. März 2025 |

| Ryzen 7 9850X3D | 8C/16T | 8+32 MB | 64 MB | 4.7/5.6 GHz | ✓ | ✓ | 120/162W | $499 | 29. Jan. 2026 |

| Ryzen 7 9800X3D | 8C/16T | 8+32 MB | 64 MB | 4.7/5.2 GHz | ✓ | ✓ | 120/162W | $479 / 529€ | 7. Nov. 2024 |

| Ryzen 5 9600X3D | 6C/12T | 8+32 MB | 64 MB | ? | ? | ? | ? | ? | komplett unbestimmt |

| Hinweis: Angaben zu noch nicht offiziell vorgestellter Hardware basieren auf Gerüchten & Annahmen | |||||||||

News des 27. Januar 2026

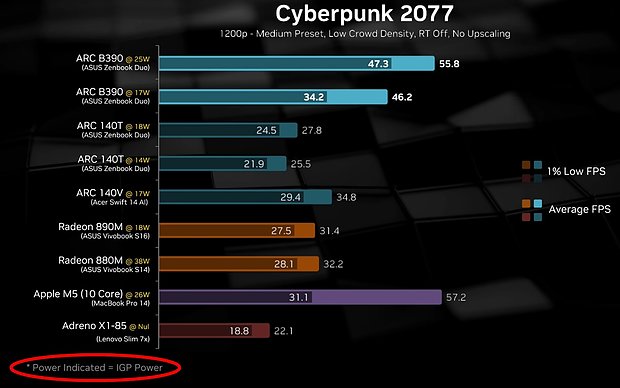

Der zweite Tag der Panther-Lake-Launchreviews war heftig enttäuschend, als dass eine eine kleine Handvoll an Testberichten mit Prozessoren abseits des Spitzenmodells Core Ultra X9 388H hinzugekommen ist – darunter keines, welches dem Leser die Ehre erwiesen hat, die für vergleichende Benchmarks nicht ganz unwichtige Information zu den konkret benutzten Powerlimits zu kredenzen. Von den gestern erwähnten Testberichten scheint es zudem nirgendwo einen zweiten Teil mit Benchmarks eben dieser kleineren Panther-Lake-Modelle zu geben, womit man wohl sagen kann: Intel-Marketing 1, Fachpresse 0. Denn somit hat es Intel über die Zweiteilung des Launchgeschehens hinbekommen, dass sich alle Welt an den gestrigen Performancedaten zum Core Ultra X9 388H orientiert (welches zudem im gestern getesteten Asus-Notebook mit klar höherem Powerlimit lief), obwohl dieses Prozessoren-Modell in der Praxis sicherlich weniger als 5% des Stückzahlen-Volumens ausmachen dürfte. Damit sind weiterhin Tests fehlend zu Panther Lake auf 25 Watt PBP/PL1 – und allein der gestrige iGPU-Test von Hardware Canucks @ YouTube liefert hierzu gewisse Aussagen: