Hauptlinks

Suchen

Aktuelle Treiber

- 26.1.1

- 32.0.101.8425

- 591.74

News des 24./25. Januar 2026

Für ein wenig Aufregung sorgt derzeit eine Nutzer-generierte iGPU-Roadmap zu AMD & Intel auf 'Weibo', welche HXL @ X für westliche Gefilde zeigt. Jene zeichnet bei AMD eine "endlose" Fortführung von RDNA3.5 bis ins Jahr 2028 ein, während Intel hingegen im iGPU-Bereich weiterhin ständig neue Architektur-Stufen bringen soll – gekrönt am Ende über die von nVidia übernommene Grafikarchitektur für Intel-Prozessoren, was natürlich auch erst in ein paar Jahren spruchreif werden wird. Primär drückt die Nutzer- bzw. KI-erstellte Roadmap somit also aus, dass AMD hier eine weitere Entwicklung vermissen läßt – im Gegensatz zu Intel. Dieser Grundaussage tritt der bekannte Twitterer Kepler allerdings klar entgegen, denn ganz so arm soll die weitere iGPU-Entwicklung bei AMD nicht ausfallen: Vielmehr soll bei AMD eine Aufteilung der iGPU-Entwicklug stattfinden, wo die Standard-iGPUs tatsächlich weiterhin bei RDNA3.5 bleiben, die Spitzen-APUs (Halo-Klasse) hingegen zu RDNA5 wechseln sollen. Dies passt nebenbei auch zu den Ausführungen von YouTuber 'Moore's Law Is Dead', wonach AMD ab der Zen6-APU "Medusa Halo" mit extra iGPU-Chiplets arbeiten soll, die zwischen Grafikchip-Bereich und iGPU-Bereich austauschbar sind.

AMD is dividing their APU roadmap into:

a) Products targeting lower end markets or markets that don't need good iGPU performance (i.e office laptops, and also laptops using high-end dGPUs). These will continue to use RDNA 3.5 until 2029.

b) "Premium" iGPU products with RDNA5.

Quelle: Kepler @ X am 24. Januar 2026

News des 23. Januar 2026

Richtig viel Aufregung und Berichterstattung gibt es derzeit über ein Video vom der8auer, welches von der Einstellung des OPP-Programms von nVidia berichtet – und damit dem Ende von nVidia-Grafikkarten zur UVP. Das "Open Price Program" diente nVidia augenscheinlich dazu, einen gewissen Anteil an UVP-Karten am Markt zu garantieren. Dies wurde wohl über den Weg eines Cashbacks zugunsten der Grafikkarten-Hersteller realisiert – jene haben nachträglich von nVidia Rabatte bekommen für ihre verkauften UVP-Modelle. Wieso nVidia diesen vergleichsweise komplizierten Weg gegangen ist, ist nicht vollständig zu klären. Denkbarerweise wollte nVidia einfach nur für tatsächlich zum UVP verkaufte Karten diesen Preisnachlaß geben und eben nicht generell – weil dann nicht mehr kontrollierbar wäre, an welchen Stellen die Grafikkarten-Hersteller sich diesen Rabatt in die eigene Tasche gesteckt und trotzdem am Markt höhere Preise verlangt hätten. Wie auch immer, das OPP-Programm hatte zumindest zu diesem (positiven) Effekt geführt, dass nachdem der Überbedarf zum Launchtermin etwas abgebaut war, die Listenpreise bzw. UVPs auch wirklich im Einzelhandel angekommen sind.

Deswegen gab es anscheinend "behind the scenes" ein sogenanntes OPP-Programm, um die Preise gerade von diesen UVP-Karten aktiv zu beeinflussen. Ich habe versucht über verschiedene Kontakte rauszufinden, was dieses OPP-Programm eigentlich heißt. Mir konnte keiner sagen, was genau das ist, aber ich habe es mir zumindest mal von zwei Quellen bestätigen lassen, dass es dieses OPP-Programm tatsächlich gab, bis vor ein paar Tagen. Man könnte das OPP als eine Art "Cashback-Programm" bezeichnen, mit dem nVidia versucht hat künstlich diesen Preis am Markt durchzusetzen. Also, dass es tatsächlich Karten am Markt gibt, die zu UVP verfügbar sind. Soweit ich weiß, waren noch alle großen Partner Teil davon, weil ansonsten wäre es technisch gar nicht möglich gewesen überhaupt solche Karten zu der UVP anzubieten, wie nVidia das haben wollte.

Quelle: der8auer @ YouTube am 23. Januar 2026

Die Intel-Geschäftsergebnisse im vierten Quartal sowie Gesamtjahr 2025

Chip-Entwickler Intel hat seine Geschäftszahlen für das vierte Quartal 2025 und somit auch das Gesamtjahr 2025 vorgelegt. Im letzten Jahresabschnitt hat Intel mit 13,674 Mrd. Dollar Quartalsumsatz knapp seine vorherige Prognose (12,8-13,6 Mrd. $) geschlagen, konnte damit aber auch nur um +0,2% gegenüber dem vorherigen Quartal zulegen, verlor sogar leicht um –4,1% gegenüber dem Umsatz des Vorjahreszeitraums. Ausgangspunkt hierfür dürfte sein, dass Intels neue Prozessoren-Generation "Panther Lake" vergleichsweise spät in den Markt kommt, nicht bereits mit dem Jahresschlußquartal, sondern erst im weiteren Verlauf des ersten Quartals 2026. Damit sieht man den Effekt der entsprechenden Vorproduktion noch nicht einmal an den Zahlen der Foundry-Sparte (Intels Eigenfertigung bei der Intel Foundry wird Konzern-intern fakturiert) – klar darauf hinweisend, dass im vierten Quartal 2025 noch so gut wie nichts an "Panther Lake" aus Intels eigener 18A-Fertigung gekommen sein kann. Auf der Gewinnseite brachte das vierte Quartal 2025 wieder einmal ein gewisses Minus beim nominellen Gewinn mit sich, wobei das Vorquartalsergebnis sowieso durch Sondereffekte deutlich aufgepumpt war. Der operative non-GAAP-Gewinn ging zwar auch zurück, bliebt aber grundsätzlich auf der Höhe vom Vorquartal – darauf hinweisend, dass es für Intel abseits der Sondereffekte vergleichsweise anständig läuft.

| Q4/2024 | Q1/2025 | Q2/2025 | Q3/2025 | Q4/2025 | |

|---|---|---|---|---|---|

| Umsatz | 14'260 Mio. $ | 12'667 Mio. $ | 12'859 Mio. $ | 13'653 Mio. $ | 13'674 Mio. $ |

| (nomineller) Gewinn | –153 Mio. $ | –887 Mio. $ | –3024 Mio. $ | 4270 Mio. $ | –333 Mio. $ |

| Bruttomarge | 39,2% | 36,9% | 27,5% | 38,2% | 36,1% |

| operativer non-GAAP-Gewinn | 1368 Mio. $ | 690 Mio. $ | –503 Mio. $ | 1524 Mio. $ | 1205 Mio. $ |

News des 22. Januar 2026

AMD hat auf X/Twitter den Launchtermin & Listenpreis zum Ryzen 7 9850X3D offiziell bekanntgegeben: Das neue stärkste Achtkern-Modell kommt am 29. Januar zu 499 Dollar in den Handel. Die Launchreviews sind laut der Gerüchteküche (und entsprechend übliche Gepflogenheiten) einen Tag vorher am 28. Januar zu erwarten. Der Listenpreis fällt um 20 Dollar teurer aus als beim Ryzen 7 9800X3D aus, was aber nicht den preislichen Hauptunterschied machen dürfte. Eher entscheidend ist, dass der Ryzen 7 9800X3D trotz eines Listenpreises von 479 Dollar (ergibt umgerechnet und mit MwSt ca. 485€) derzeit für Preislagen von 430-450 Euro real im deutschen Einzelhandel verfügbar ist. Der Ryzen 7 9850X3D dürfte vermutlich mit ca. 505 Euro in den Handel gehen, ergo mit einer realen Preisdifferenz von ca. 75 Euro – bei nur 20 Dollar Listenpreis-Differenz. Aufgrund des eher geringen Performance-Zugewinns von 9800X3D zu 9850X3D ist das neue Modelle aber sowieso nicht für direkte Umsteiger geeignet, sondern eher ein Angebot für Käufer, die jetzt erst auf Zen 5 aufrüsten.

| AMD Zen 5 X3D | Kerne | L2+L3 | 3DVC | Takt | iGPU | OC | TDP/PPT | Listenpreis | Release |

|---|---|---|---|---|---|---|---|---|---|

| Ryzen 9 9950X3D2 | 16C/32T | 16+64 MB | 128 MB | 4.3/5.6 GHz | ✓ | ✓ | 200/?W | ? | unbekannt |

| Ryzen 9 9950X3D | 16C/32T | 16+64 MB | 64 MB | 4.3/5.7 GHz | ✓ | ✓ | 170/200W | $699 / 769€ | 12. März 2025 |

| Ryzen 9 9900X3D | 12C/24T | 12+64 MB | 64 MB | 4.4/5.5 GHz | ✓ | ✓ | 120/162W | $599 / 659€ | 12. März 2025 |

| Ryzen 7 9850X3D | 8C/16T | 8+32 MB | 64 MB | 4.7/5.6 GHz | ✓ | ✓ | 120/?W | $499 | lt. AMD: 29. Jan. 2026 |

| Ryzen 7 9800X3D | 8C/16T | 8+32 MB | 64 MB | 4.7/5.2 GHz | ✓ | ✓ | 120/162W | $479 / 529€ | 7. Nov. 2024 |

| Ryzen 5 9600X3D | 6C/12T | 8+32 MB | 64 MB | ? | ? | ? | ? | ? | komplett unbestimmt |

| Hinweis: Angaben zu noch nicht offiziell vorgestellter Hardware basieren auf Gerüchten & Annahmen | |||||||||

News des 21. Januar 2026

Laut der Tippgeber Jaykihn @ X & Haze @ X soll es nun endlich mit Intels BMG-G31 Grafikchip über die Ziellinie gehen – wenngleich leider nur in Form der professionellen Lösungen Arc B70 Pro und Arc B65 Pro. Jene sollen "demnächst" offengelegt werden, wobei im Profi-Bereich eine Vorstellung natürlich nicht unbedingt das gleiche wie ein Marktstart sein muß. Aber immerhin würde der BMG-G31 Chip damit endlich einmal real genutzt werden, anstatt als Silizium-Zombie nur in Ladelisten und Treibereinträgen genannt zu werden. Eine wirkliche Sicherheit, dass Intel dann eines Tages hieraus noch die Arc B700 Serie für Consumer-Bedürfnisse kreiert, ergibt sich aus dieser Verwendung für Profi-Grafikkarten aber leider auch nicht. Selbigem steht derzeit die generelle GDDR-Knappheit entgegen, wo es nicht nur zu hohe Preise für Grafikkartenspeicher gibt, sondern vor allem regelrechte GDDR-Beschaffungsprobleme. Für Profi-Karten kann man dies über die viel höheren Preise dieses Marktsegments gut übertünchen, aber für ein Consumer-Projekt wird dies nicht so einfach – gerade wenn man als letzter ankommt und nun sogar noch größere Lieferungen von den Speicherchip-Herstellern anstrebt.

B70 Pro soon.

Quelle: Jaykihn @ X am 21. Januar 2026

B65 too

Quelle: Haze @ X am 21. Januar 2026

News des 20. Januar 2026

Widersprüchliche Terminangaben gibt es zum Releasezeitpunkt von nVidias N1X-Chip im Notebook-Feld: Laut Dan Nystedt @ X soll dies schon im ersten Quartal 2026 so weit sein, laut Pantone 7461C @ X allerdings erst im September, mit der kleineren Chip-Variante "N1" sogar erst einige Monate später. Das ist dann schon ein großer Terminunterschied und normalerweise hat Twitterer 'Dan Nystedt' die sicherlich größere Reputation. Allerdings widerspricht ein Start schon im ersten Quartal den letzten Vorhersagen von einem Sommer-Termin und passt auch wenig dazu, dass die N1-Serie auf der CES 2026 keine echte Erwähnung gefunden hat. Ehrlicherweise ist dies eine klare Geschichte: Würde N1X wirklich schon im Frühjahr herauskommen, hätte man jenen SoC auf der CES offiziell vorgestellt oder wenigstens breit angeteasert. Ein solcher Markting-Trommelwirbel ist einfach notwendig, denn trotz der nVidia-Mitarbeit werden diese SoCs letztlich von MediaTek in den Markt gebracht und sind somit klare Seiteneinsteiger ins PC-Geschäft – Qualcomm kann hiervon sein Lied singen.

Laptops made from Nvidia’s N1X chip platform will debut in the 1st quarter 2026, a high-end Windows-on-Arm laptop for consumers, media report, with 3 more N1 and N1X series laptops due in Q2. Nvidia also plans to follow with N2 and N2X series laptops in Q3 2027. An N2X desktop will debut in Q4 2027.

Quelle: Dan Nystedt @ X am 20. Januar 2026

Originally N1X was planned launch at CES but due to FW/BSP/OS not ready the launch postponed at least twice. The latest status is first wave products will be available at Q3'26, most likely the September.

Quelle: Pantone 7461C @ X am 20. Januar 2026

We may expect a Computex Launch event for it as the SoC part is cooperated with Mediatek.

N1 will come a bit months later.

Quelle: Pantone 7461C @ X am 20. Januar 2026

News des 19. Januar 2026

Vom koreanischen Marktplatz Danawa kommt eine Auswertung des Grafikkarten-Markts 2025 in Südkorea, welcher vor allem wegen der Verteilung der nVidia-Modelle untereinander interessant ist. Denn bei Danawa dominierte im Dezember 2025 die GeForce RTX 5060 das Verkaufsgeschehen klar mit immerhin 32,12% aller verkauften nVidia-Grafikkarten (extra Zahlen zu AMD gab es nicht, da AMD-Grafikkarten in Südkorea auf keine bedeutsamen Marktanteile kommen). Dieser hohe (nVidia-interne) Marktanteil der GeForce RTX 5060 ist vor allem deswegen bemerkenswert, weil dies augenscheinlich komplett abweichend vom deutschen Retailmarkt ist. Dort liegen zwar nur die Mindfactory-Zahlen vor, jene sehen für die 50. Woche 2025 die GeForce RTX 5060 jedoch auf nur 7,5% nVidia-Marktanteil – ein drastischer Unterschied zum koreanischen Markt. Auch generell scheinen in Deutschland viel mehr HighEnd-Modelle bevorzugt werden, hierzulande führen GeForce RTX 5070 Ti & 5080 die nVidia-Statistik an. Die nVidia-interne Marktverteilung beult sich also in Deutschland eher im HighEnd-Segment aus, in Südkorea hingegen klar im Mainstream-Segment.

Danawa  |

Mindfactory  |

|

|---|---|---|

| GeForce RTX 5090 | ? | 4,8% |

| GeForce RTX 5080 | ? | 24,1% |

| GeForce RTX 5070 Ti | 12,07% | 27,2% |

| GeForce RTX 5070 | 11,87% | 10,5% |

| GeForce RTX 5060 Ti | 15,61% | 18,0% |

| GeForce RTX 5060 | 32,12% | 7,5% |

| jeweilig rein nVidia-interner Marktanteil; Quellen: Danawa & TechEpiphany @ X | ||

News des 17./18. Januar 2026

Twitterer Vectral weist auf erste Modell-Daten zu den P-Core-only-Modellen von Bartlett Lake hin, VideoCardz liefern dann alle (bisher) bekannten Modell-Daten, inklusive auch der (schon releasten) Hybrid-Modelle von Bartlett Lake, welche schlicht die bekannten Alder-Lake- und Raptor-Lake-Dies bemühen. Das besonderes sind aber eben die reinen P-Kern-Modelle, da es deren Kernanzahl von 10 bzw. 12 P-Kernen bei Raptor Lake nicht gibt, sprich hierfür ein tatsächlich eigenständiges Stück Silizium im Einsatz ist. Nachfolgend sind die Modelldaten der reinen P-Kern-Modelle von Bartlett Lake aufgeführt, wobei sich die Modellnummern noch nach den üblichen TDPs von 65 Watt anhören. Die größten Modelle von Bartlett Lake sollen allerdings auch TDPs von 125 Watt erreichen, sogar unter dem K-Suffix – allerdings ohne Übertaktungsfähigkeit, dies wird im hiermit angepeilten Network/Edge-Segment auch nicht benötigt. Dies dürfte sich mit der Zeit noch alles klären, denn augenscheinlich biegt nun auch Bartlett Lake auf die Zielgerade ein, laut Twitterer Haze (wie bekannt) für einen Marktstart im März.

| BTL (P-Core-only) | Kerne | Takt | L2+L3 | iGPU | TDP |

|---|---|---|---|---|---|

| Core 9 273PQE | 12P/24T | ?/5.9 GHz | 24+36 MB | Xe-LP, 32 EU | ? |

| Core 9 273PE | 12P/24T | ?/5.7 GHz | 24+36 MB | Xe-LP, 32 EU | ? |

| Core 9 273PTE | 12P/24T | ?/5.5 GHz | 24+36 MB | Xe-LP, 32 EU | ? |

| Core 7 253PQE | 10P/20T | ?/5.7 GHz | 20+33 MB | Xe-LP, 32 EU | ? |

| Core 7 253PE | 10P/20T | ?/5.5 GHz | 20+33 MB | Xe-LP, 32 EU | ? |

| Core 7 253PTE | 10P/20T | ?/5.4 GHz | 20+33 MB | Xe-LP, 32 EU | ? |

| Hinweis: Angaben zu noch nicht offiziell vorgestellter Hardware basieren auf Gerüchten & Annahmen | |||||

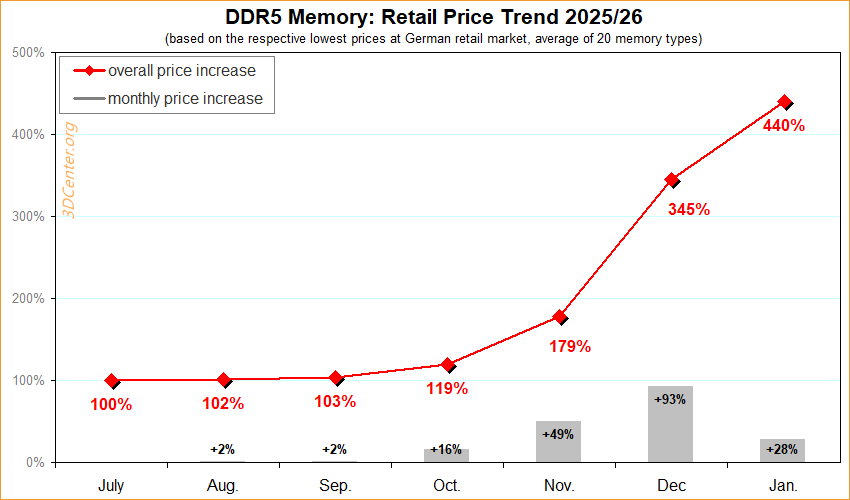

Neuer Artikel: Speicherkrise Preisindex Januar 2026

In Aktualisierung des Speicherkrisen-Preisindex vom Dezember 2025 soll nachfolgend wieder betrachtet wie auch dokumentiert werden, wie sich die Preise von DDR5, DDR3/4, SODIMM, internen SSDs, internen HDDs, externen Festplatten und Grafikkarten im deutschen Einzelhandel zuletzt entwickelt haben. Zielsetzung ist es, zu klaren Zahlenwerten zu kommen, welche die hierbei auftretenden Preisübertreibungen für alle genannten Produktgruppen quantifizieren. Zugleich werden monatliche Steigerungsraten für jede Produktgruppe ermittelt, womit sich Anziehen und Abflauen von Preissteigerungen (sowie hoffentlich eines Tages auch wieder Preissenkungen) belegen lassen. Abschließend wird auf Basis all dieser Daten der gesamte Verlauf der Preisveränderungen aller Produktgruppen noch zusammengefasst in Diagramm-Form dargeboten ... zum Artikel.

News des 16. Januar 2026

Twitterer X86 is dead&back hat einen ersten Benchmark-Wert zu einem 10-Kerner von Bartlett Lake erspäht – und damit gleichzeitig den ersten Beweis der tatsächlichen Existenz von Prozessoren mit mehr als 8 Performance-Kernen bei Intel geliefert. Denn hier dürfte das 12-Kern-Die von Bartlett Lake verbaut sein, welches allein 12 Performance-Kerne aufweist – und keinerlei Effizienz-Kerne. Bisherige Ausführungen von "Bartlett Lake" basierten noch auf dem bekannten Raptor-Lake-Die, hatten also immer Effizienz-Kerne mit an Bord, doch hiermit gibt es erstmals bei Intel mehr als 8 Performance-Kerne auf einem reinem K-Kern-Silizium. Der getestete "Core 7 253PE" hat hiervon augenscheinlich nur 10 P-Kerne freigeschaltet, kann sich damit aber gut gegenüber dem 10-Kerner Core i5-14400 sowie dem 14-Kerner Core i5-14500 behauptet: Ersterer wird bei der Multithread-Performance klar geschlagen (+26,0%)), das MT-Ergebnis des 14-Kerners von Raptor Lake kann der 10-Kerner von Bartlett Lake dann noch leicht überbieten (+2,2%).

| Core i5-14400 | Core i5-14500 | Core 7 253PE | |

|---|---|---|---|

| Architektur | Raptor Lake | Raptor Lake | Bartlett Lake |

| Kerne | 6P+4E/16T | 6P+8E/20T | 10P/20T |

| L2+L3 Cache | 9.5+20 MB | 11.5+20 MB | 20+33 MB |

| PassMark ST | 3749 | 3945 | 3647 |

| PassMark MT | 25'236 | 31'121 | 31'802 |

| gemäß der Ausführungen von X86 is dead&back @ X | |||

Translate

3DCenter unterstützen

Neueste Blogeinträge

Neue Forenbeiträge

- AsRock B850 Steel Legend WiFi - Wifi wird nicht erkannt...

- Wie oft habt Ihr auf Euren hauptsächlichen PCs das Betriebssystem (neu) installiert?

- Welchen Endlostest zur Analyse des Boostverhaltens der Laptop-GPU nutzen?

- Welchen Passwortmanager benutzt Ihr?

- Mißgeschick mit Gigabyte RTX 5080 und die Reaktion des Supports